近年来,人工智能行业发展迅速,在自动驾驶、金融、医疗、教育等行业广泛应用。尤其是ChatGPT发布以后更是掀起了生成式AI的热潮,国内各大互联网厂商也相继发布自己的AI大模型。这也造成了大量的AI人才缺口,同时促进了高校的AI专业建设,为社会培养AI人才。

当前高校在AI专业建设面临很多问题,其中AI开发训练平台和AI算力平台的建设因为缺乏高效的解决方案,已成为困扰很多学校的难题。本文将针对高校面临的问题和解决方案进行讨论。

1、 AI算力分布在不同学院或科研团队,资源独享,给学校算力建设和统一管理带来困难

AI算力的建设通常与相关项目同步建设,可能分散在不同的学院或科研团队,各学院/团队分散管理和使用,且建设方式多采用工作站或少量服务器的形式;造成各学院/团队资源相对独立,团队间无法共建共用,即使资源在闲置的情况下,也无法相互复用资源,造成资源严重浪费。

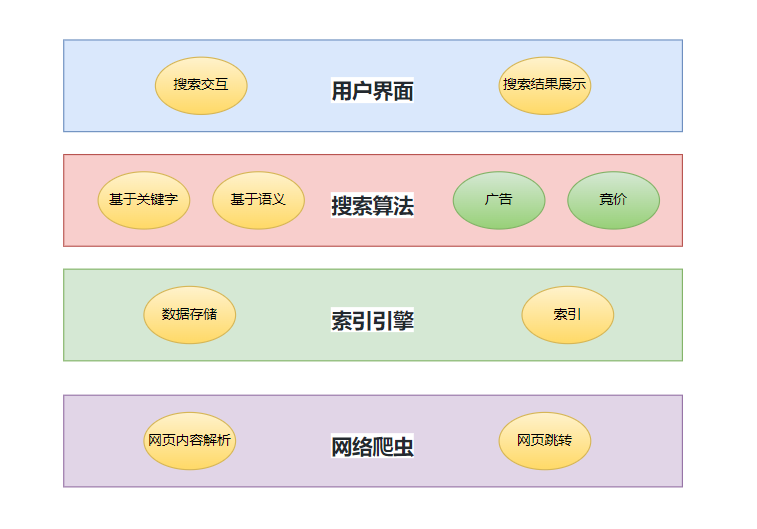

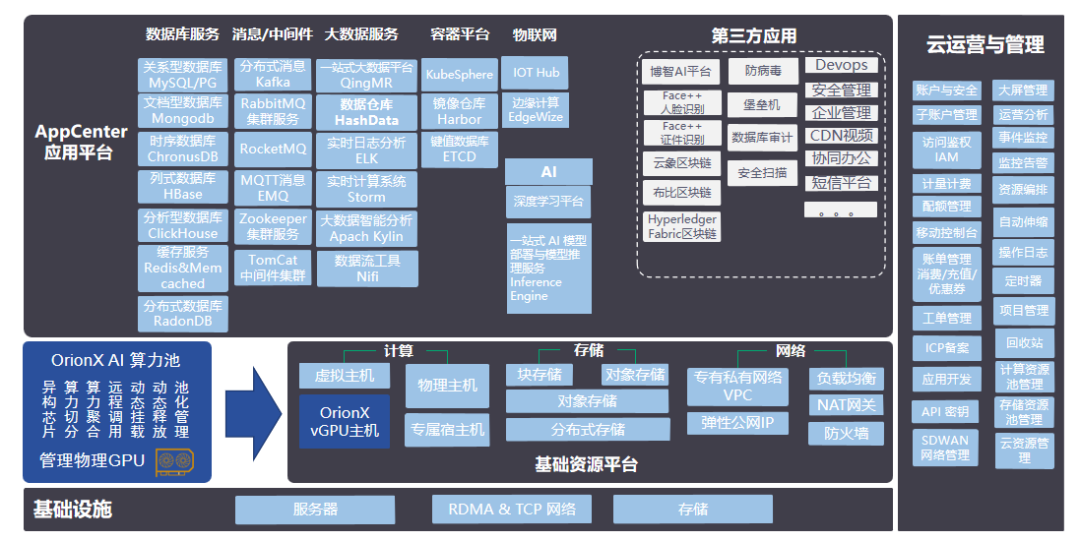

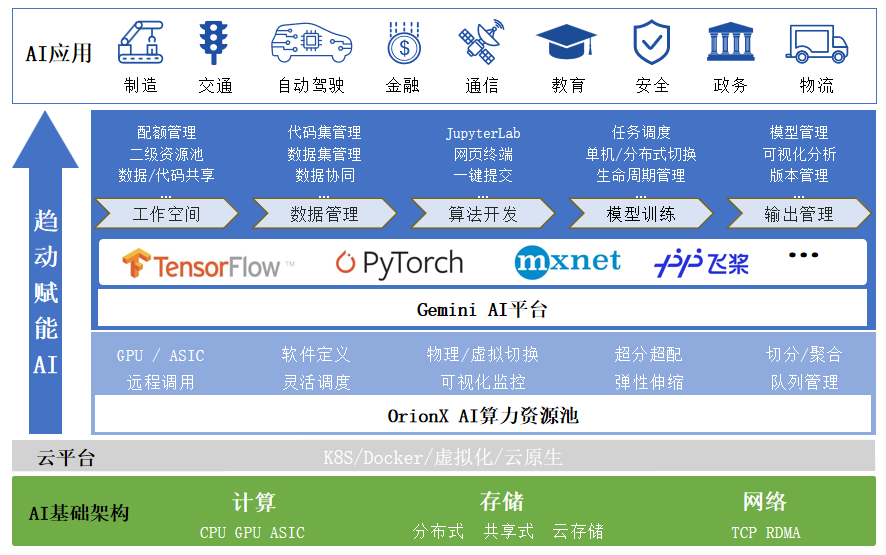

通过趋动科技的算力池化方案即可轻松解决上述问题。学校通过信息中心建设校级的算力中心,利用OrionX创建AI算力资源池,通过软件定义AI算力的形式改变传统以物理卡为单位的方式使用算力。能够实现AI算力资源的切分、远程调用、跨机聚合、算力超分、热迁移等功能。最终达到全校师生共享算力资源,提高资源利用率,减少算力资源总投资。

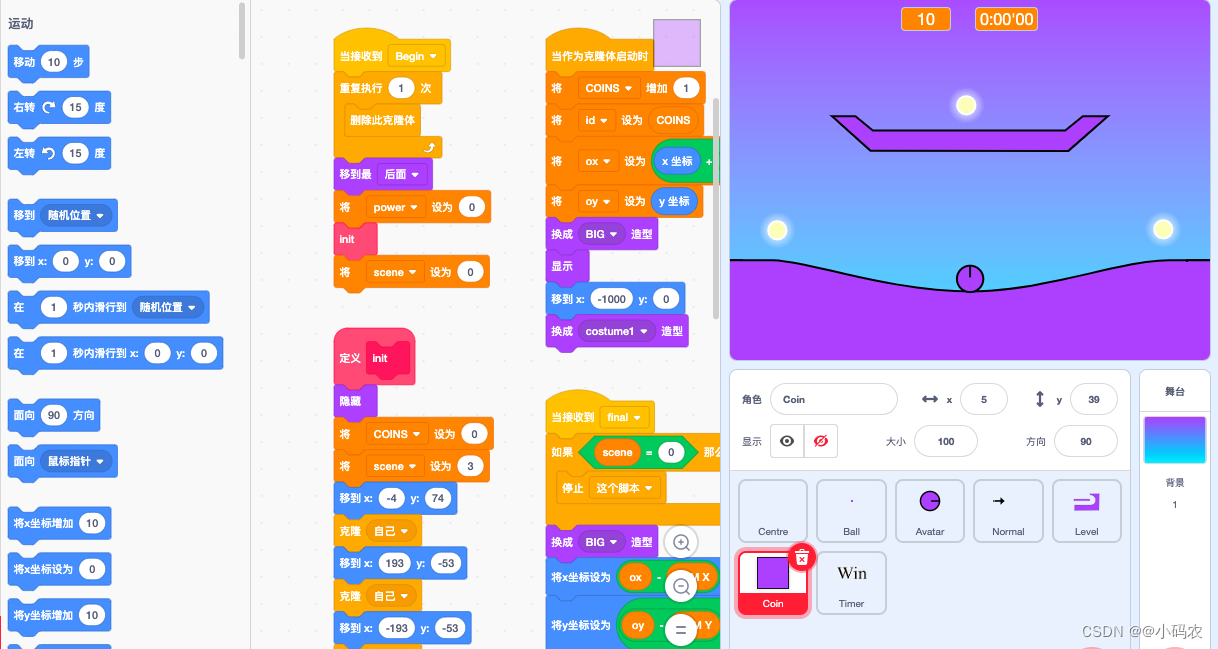

OrionX方案架构图

2、传统IaaS平台无法高效使用GPU资源

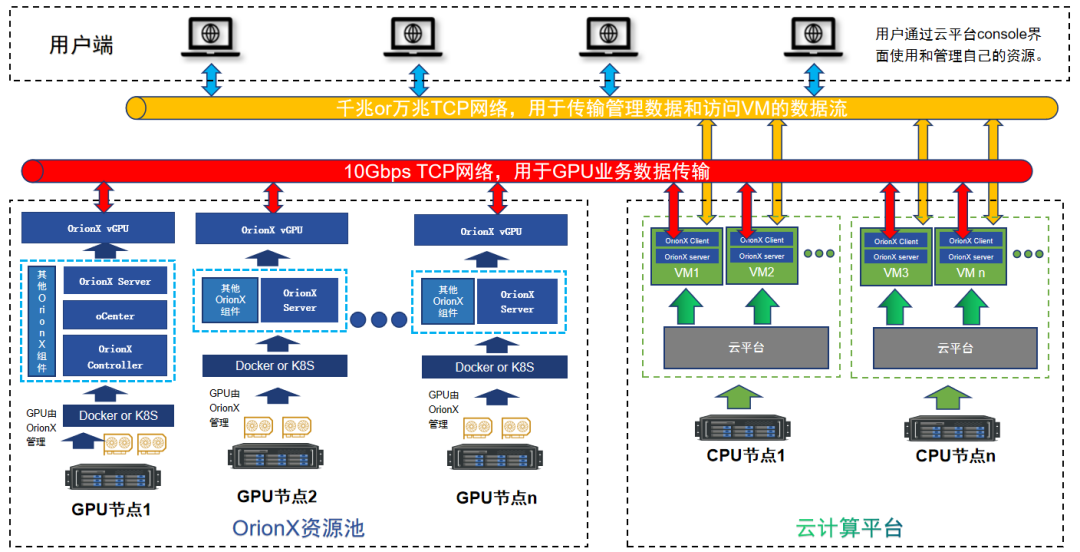

一些高校信息中心在做基础资源平台建设时,通常会采用增购硬件的方式来满足不断增长的算力需求。但随着硬件采购受限,且一般的IaaS平台对算力管理调度、尤其是异构算力的管理和使用能力有限,多以直通方式为主,现有的资源提供模式的弊端就会突显出来:AI算力不能在各个任务之间灵活切换,使资源使用率不理想,也增加了运维人员的工作量。

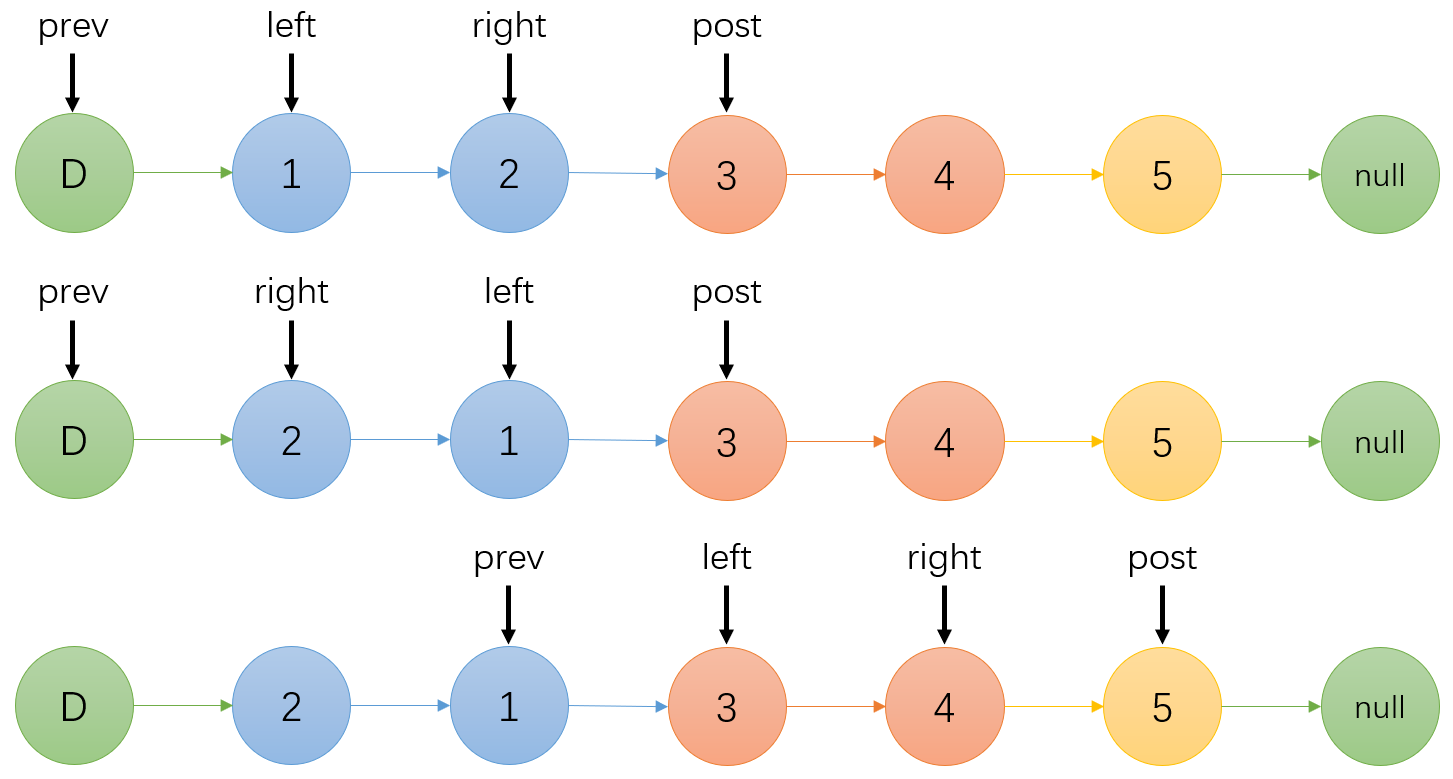

趋动科技的OrionX池化方案适应容器、K8S、KVM、物理机等各个场景,可以很好地解决资源使用的问题,云平台的虚拟机通过调用OrionX vGPU资源即可满足师生对算力的需求。

OrionX vGPU具备动态加载和释放的能力,当有AI任务执行时,才会占用GPU的算力资源,任务执行完毕GPU资源会立即释放,这样就能很好解决GPU在不同使用者之间切换的问题。

传统IaaS平台直通GPU的方式受到服务器GPU卡数量的限制,单一虚拟机最多能用到其所在物理节点的GPU数量,这样就不能满足一些大算力需求的场景。通过OrionX的跨机聚合能力,可以快速方便的提供多卡的运行环境,提升使用效率。

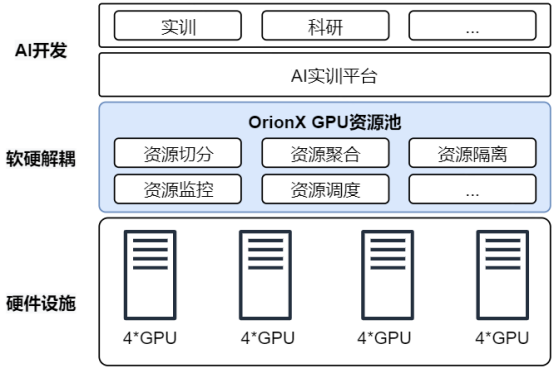

3、新设AI专业的高校,在AI实训平台建设时缺乏整体解决方案

一些刚开设AI相关专业的高校,在AI实训平台的建设方面还处在摸索阶段:在大量学生需要实验的场景下会通过配置PC机+低端GPU的方案来满足;在针对科研场景时,又会购买性能较好的GPU服务器来满足需求。这种方案导致GPU资源不能共享利用,增加建设成本,造成资源浪费。

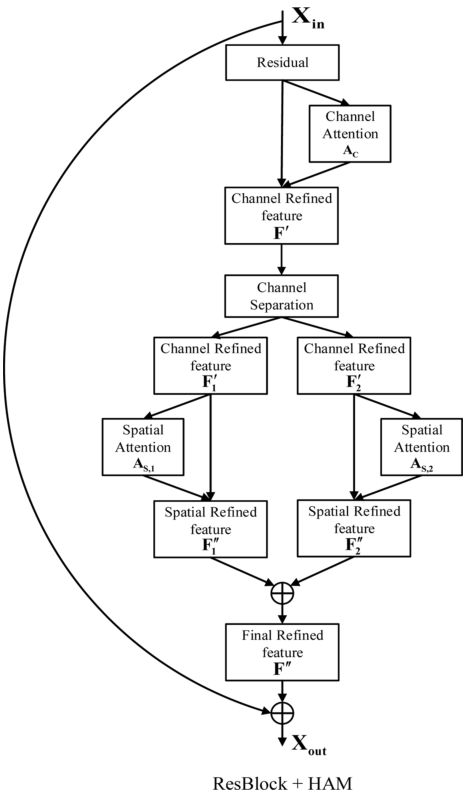

针对这种应用场景,趋动科技提供Gemini + OrionX的整体解决方案。Gemini提供AI开发训练的基础平台,包含租户管理、算法开发工具、数据管理、模型训练、输出管理等功能。OrionX做底层的算力管理,提供资源切分、资源聚合、资源超分等能力。

OrionX+Gemini方案

学校通过OrionX的资源切分能力结合Gemini AI开发训练平台,可以满足大量学生实训的场景;通过OrionX的资源聚合能力快速提供多卡环境给科研团队做算力支撑,结合Gemini任务训练能力,轻松完成分布式模型训练。

学校可以充分利用现有的终端设备和实验环境,连接AI开发训练平台即可完成各类AI学习和相关实验课程。无需采购大量含有GPU的终端设备,从而减少硬件投资,提高资源利用率,实现降本增效的目标。

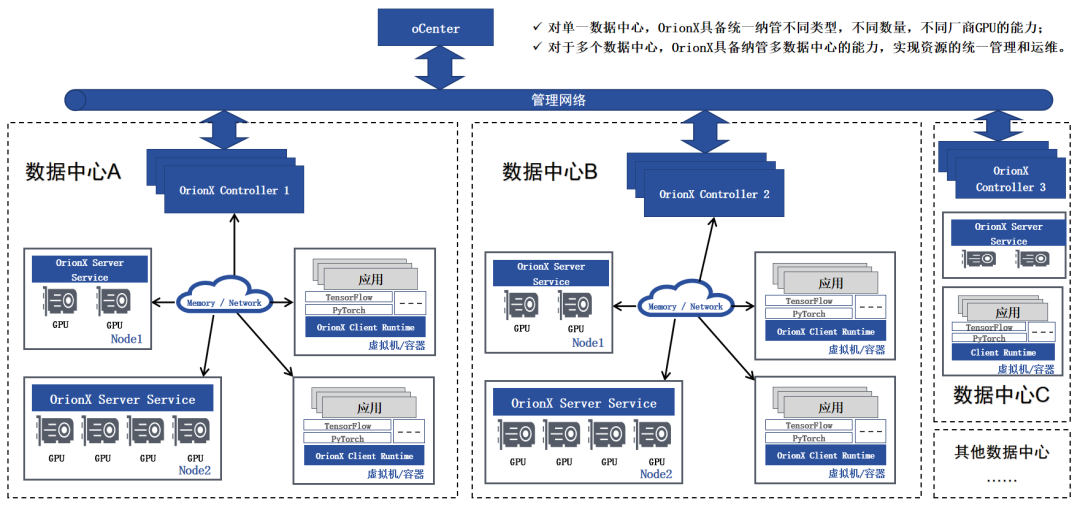

4、多校区带来的资源管理问题

很多高校都会有不同的校区,这些分散的校区对AI算力平台的建设带来了硬件资源分配、资源管理、运维监控等挑战;加之GPU采购又难度加大,还需要面对同时管理GPU集群和国产AI芯片集群的问题。

趋动科技的池化方案可以建设多个异构算力池进行,实现跨机房、多集群、国产AI芯片与GPU的统一管理,更灵活地满足学校的算力需求。

多数据中心管理

总结来看,趋动科技的Gemini+OrionX方案主要有如下优势:

01 利用率提升

将物理GPU切片为任意大小的虚拟GPU,1个GPU虚拟化成多个虚拟GPU,供多个学生同时使用,互不干扰,充分利用资源,节约成本。

02 场景灵活转换

统一资源池,同时支持教学和教研场景,瞬间转换,资源随时就绪;使用结束后立即释放,无回收之忧。

03 灵活的资源调度

自助式服务,简化管理,简化运维,师生只需关注自己专业,不用在意底层算力资源情况。

04 弹性伸缩

基于资源池的灵活扩展,按需分配,资源大小可以动态调节,无需重启。

05 资源监控

提供全局资源池性能监控,为运维人员提供直观的资源利用率等信息。

06 GPU资源统一管理

支持对多个数据中心的GPU设备,统一管理,灵活分配,充分保护学校投资。

案例分享

案例一:西安工业大学

痛点:

-

以物理卡直通到虚拟机的方式很难让GPU在不同用户之间切换,会导致资源长期被占用但是又没有任务运行的情况;

-

AI科研老师会自己采购一些GPU服务器来满足算力需求,课题研究完毕时,设备也会闲置,导致资源浪费。

解决方案:

学校在新建云平台的项目中,采用了OrionX的池化方案与云平台集成的整体方案,满足师生对GPU的需求。

将GPU服务器从云平台中剥离出来,部署OrionX的池化组件,统一管理GPU资源;在云平台中创建师生常用的系统,安装OrionX的Client相关组件,通过远程调用的方式获取到GPU资源;测试正常后,制作成新的系统镜像,共享给整个云平台用户。这样全校师生就能通过云平台方便的创建和使用含有OrionX vGPU资源的虚拟机。整个租户和计费的管理都由云平台负责,保留了用户的使用习惯。

解决方案示意图

客户收益:

-

解耦GPU与VM的绑定关系。通过OrionX的动态加载与释放的能力,避免了VM长期占用GPU但没有实际任务运行的情况;

-

实现了GPU资源的共享,避免重复建设,减少机房、电力、运维等多方便的投入,实现绿色发展;

-

通过OrionX的横向扩展能力和异构管理能力,在未来多种AI算力并存的场景下,保持一致的管理能力和使用体验。

案例分享

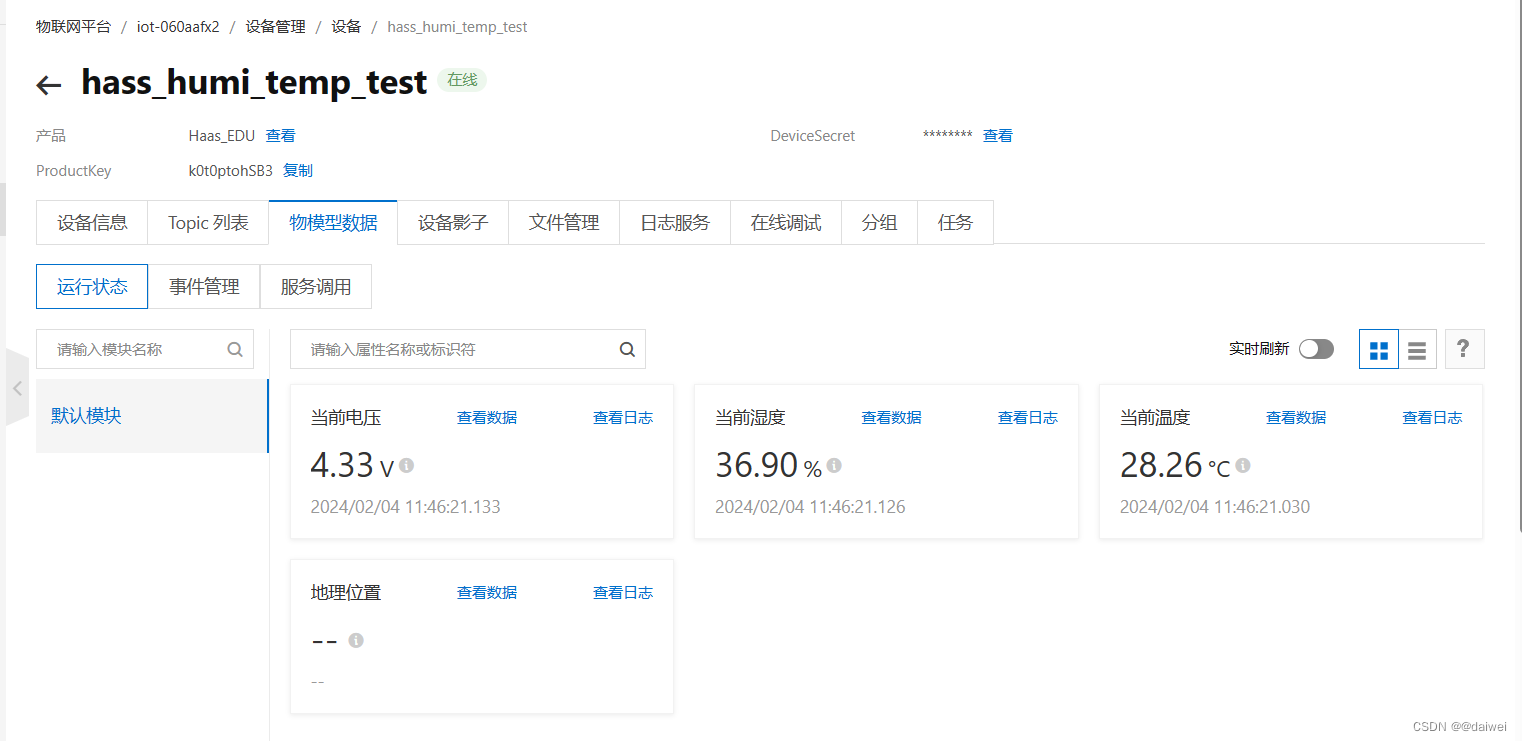

案例二:西南民族大学

痛点:

-

西南民族大学前期已经使用基于VMware平台的AI开发训练平台,该平台底层采用Nvidia vGPU实现物理GPU资源固定切分,GPU资源使用不灵活,无法按照需求灵活切分GPU资源;

-

当在不同场景下使用GPU资源时,需要有专人对GPU资源进行切分管理和维护,人力成本一直居高不下;

-

管理效果不理想,无法同时满足学生、老师的实训要求和科研要求。

解决方案:

通过OrionX创建AI算力资源池,替代Nvidia vGPU方案,实现GPU资源集中管理和 GPU 资源自动调度,满足实训、科研、以及学生毕业设计时的场景需求。

能够自动根据学生或老师的需求切分GPU资源,并自动调度到合适的GPU资源。平台上线后,能够最大限度保持学生、老师的使用习惯,不增加新的学习成本和时间成本。

解决方案示意图

客户收益:

-

能够不断降低高校的硬件购置成本,减少GPU硬件采购规模,提升GPU资源利用率,使资源利用更加合理、科学;

-

构建基于OrionX可弹性伸缩的GPU资源池,既能满足实训需求,又能满足科研需要,缩短AI模型的开发、训练周期;

-

资源按需索取,简化业务上线流程,原来需要花费数天的GPU资源申请流程,仅需要几秒钟即可完成;

-

利用OrionX的GPU自动池化调度替代传统的人工管理方式,大大降低了运维复杂度和运维管理成本。

除上述高校外,还有核心信息交叉学院、天津大学、上海工程大学、南京农业大学等高校也正通OrionX AI算力池化方案解决AI算力使用中面临的各种问题。