文章目录

- 1.1 网络爬虫简介

- 1.1.1 重点基础知识讲解

- 1.1.2 重点案例:社交媒体数据分析

- 1.1.3 拓展案例1:电商网站价格监控

- 1.1.4 拓展案例2:新闻聚合服务

- 1.2 网络爬虫的工作原理

- 1.2.1 重点基础知识讲解

- 1.2.2 重点案例:股票市场数据采集

- 1.2.3 拓展案例 1:博客文章抓取

- 1.2.4 拓展案例 2:酒店价格监控

- 1.3 网络爬虫的法律与道德考量

- 1.3.1 重点基础知识讲解

- 1.3.2 重点案例:社交媒体数据抓取

- 1.3.3 拓展案例 1:网站内容聚合

- 1.3.4 拓展案例 2:在线商店价格监控

1.1 网络爬虫简介

1.1.1 重点基础知识讲解

网络爬虫,也称为网页蜘蛛或网页机器人,是一种自动化的网络程序,设计用来从万维网上下载网页,提取出有用的信息或者资源。想要精通网络爬虫,首先得了解几个基础概念:

- HTML & CSS: 网页的骨架和皮肤。HTML 定义了网页的结构,而 CSS 则负责外观。掌握它们,你才能让爬虫知道去哪儿找数据。

- JavaScript: 许多现代网站利用 JavaScript 动态加载内容。了解基础的 JavaScript 及其如何影响网页内容的加载,对爬取动态内容至关重要。

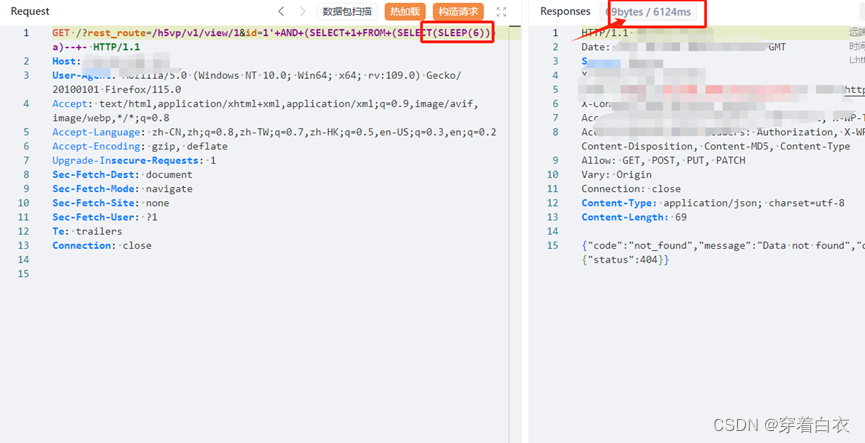

- HTTP/HTTPS 协议: 这是爬虫与网站交流的语言。理解请求(Request)和响应(Response)的基本原理,能帮你更好地设计爬虫。

- APIs: 许多网站提供 APIs 来让开发者合法地访问数据。利用 APIs 能够是一个更高效、更稳定的数据抓取方式。

接下来,让我们通过几个案例,深入探索网络爬虫在实际生产中的应用。

1.1.2 重点案例:社交媒体数据分析

假设你是一个数据分析师,需要从 Twitter 抓取关于特定话题的推文,进行情感分析。使用 Python 的 Tweepy 库,可以方便地接入Twitter API,抓取数据。这个案例不仅实用,而且非常贴近现实生产,社交媒体数据分析在市场研究、公共舆论监控等领域有广泛应用。

import tweepy

# 初始化API

auth = tweepy.OAuthHandler('YOUR_CONSUMER_KEY', 'YOUR_CONSUMER_SECRET')

auth.set_access_token('YOUR_ACCESS_TOKEN', 'YOUR_ACCESS_TOKEN_SECRET')

api = tweepy.API(auth)

# 抓取特定话题的推文

for tweet in tweepy.Cursor(api.search, q="#特定话题", lang="en").items(100):

print(tweet.text)

1.1.3 拓展案例1:电商网站价格监控

想象你是一个电商企业的竞争情报分析师,需要监控竞争对手的产品价格。使用 Python 的 BeautifulSoup 库可以解析 HTML 页面,抓取产品价格信息。这个案例在电子商务竞争分析中非常常见。

import requests

from bs4 import BeautifulSoup

# 请求网页

response = requests.get('http://example.com/product')

soup = BeautifulSoup(response.text, 'html.parser')

# 解析价格信息

price = soup.find('span', class_='product-price').text

print(f"产品价格: {price}")

1.1.4 拓展案例2:新闻聚合服务

假设你正在开发一个新闻聚合服务,需要从多个新闻网站抓取最新的新闻标题和链接。使用 Python 的 Requests 库来发送HTTP请求,搭配 BeautifulSoup 进行内容解析。这个案例在信息聚合和内容提供服务中极为常见。

import requests

from bs4 import BeautifulSoup

# 请求新闻网页

response = requests.get('http://news.example.com')

soup = BeautifulSoup(response.text, 'html.parser')

# 抓取新闻标题和链接

for news_item in soup.find_all('div', class_='news-item'):

title = news_item.find('h2').text

link = news_item.find('a')['href']

print(f"标题: {title}, 链接: {link}")

通过这三个案例,我们不仅能看到 Python 在网络爬虫应用中的强大能力,还能体会到网络爬虫技术在不同行业中的广泛应用。这些案例涵盖了从社交媒体分析、价格监控到新闻聚合的多种实用场景,展示了网络爬虫技术如何帮助我们从大量网页中提取有价值的信息。

1.2 网络爬虫的工作原理

1.2.1 重点基础知识讲解

要掌握网络爬虫的工作原理,我们首先需要理解几个关键概念:

- 请求 (Request):这是网络爬虫向服务器发出的“请给我数据”的呼唤。通常分为 GET 请求(请求数据)和 POST 请求(提交数据)。

- 响应 (Response):当服务器接收到请求后,它回送的数据就是响应。响应中包含了许多有用的信息,包括请求的网页数据。

- 解析 (Parsing):获取响应后,爬虫需要从中提取有用的信息,这个过程称为解析。常用的解析工具包括 BeautifulSoup 和 lxml 。

- 数据存储 (Data Storage):爬虫从网页中提取的数据需要被存储起来,以便进一步的处理或分析。存储方式有很多种,包括但不限于数据库、文件或内存中。

接下来,我们将通过几个实际案例来深入探讨网络爬虫的工作原理。

1.2.2 重点案例:股票市场数据采集

假设你是一名金融分析师,需要实时追踪特定股票的价格变动。使用 Python 的 requests 库可以轻松地实现这一目标。通过发送 GET 请求到股票信息网站,然后解析响应数据获取股价信息。这个案例在金融分析和市场监控中非常实用。

import requests

from bs4 import BeautifulSoup

# 发送 GET 请求

url = "http://example.com/stock/AAPL"

response = requests.get(url)

# 解析响应内容

soup = BeautifulSoup(response.content, 'html.parser')

price = soup.find('div', class_='stock-price').text

print(f"苹果股价: {price}")

1.2.3 拓展案例 1:博客文章抓取

想象你正在构建一个个人项目,需要从你最喜欢的技术博客中抓取最新文章的标题和链接,以便快速浏览。这时,你可以使用 Python 的 requests 和 BeautifulSoup 来完成这项任务。这个案例对于内容聚合器或个人学习资源库的构建非常有帮助。

import requests

from bs4 import BeautifulSoup

# 请求博客首页

response = requests.get('https://techblog.example.com')

soup = BeautifulSoup(response.text, 'html.parser')

# 抓取文章标题和链接

articles = []

for article in soup.find_all('article'):

title = article.find('h2').text

link = article.find('a')['href']

articles.append({'title': title, 'link': link})

for article in articles:

print(f"标题: {article['title']}, 链接: {article['link']}")

1.2.4 拓展案例 2:酒店价格监控

假设你是一名旅行爱好者,希望监控某旅游网站上目的地酒店的价格,以便在价格最低时预订。通过 Python 的 requests 库发送请求,并利用 BeautifulSoup 解析响应内容中的酒店价格信息。这个案例对于预算有限的旅行者来说非常实用。

import requests

from bs4 import BeautifulSoup

# 发送请求到酒店列表页面

response = requests.get('http://travel.example.com/hotels?destination=paris')

soup = BeautifulSoup(response.text, 'html.parser')

# 解析酒店价格

hotels = []

for hotel in soup.find_all('div', class_='hotel-item'):

name = hotel.find('h2').text

price = hotel.find('span', class_='price').text

hotels.append({'name': name, 'price': price})

for hotel in hotels:

print(f"

酒店: {hotel['name']}, 价格: {hotel['price']}")

通过这些案例,我们不仅理解了网络爬虫的基本工作原理,还学习了如何在实际生产中应用这些原理来解决实际问题。无论是金融市场的数据采集,个人兴趣的内容聚合,还是生活中的价格监控,网络爬虫技术都能提供强大的支持。

1.3 网络爬虫的法律与道德考量

1.3.1 重点基础知识讲解

在开发和部署网络爬虫时,法律和道德考量是不可或缺的一部分。违反这些准则可能导致法律后果,包括被禁止访问目标网站、面临诉讼甚至罚款。理解以下几个关键点是至关重要的:

- robots.txt 协议:这是网站告知网络爬虫哪些部分可被爬取、哪些部分禁止爬取的标准。遵守 robots.txt 是网络爬虫开发的基本礼仪。

- 版权法:网页上的内容,如文本、图片和视频,通常受版权法保护。未经授权擅自抓取和使用这些内容可能会侵犯版权。

- 隐私法:在处理个人数据(如社交媒体帖子、论坛评论等)时,必须遵守适用的隐私法律和规定,如 GDPR 或 CCPA。

- 访问频率和负载:过度请求网站可能会对其正常运营造成干扰,这不仅是一个道德问题,也可能引起法律问题。

1.3.2 重点案例:社交媒体数据抓取

假设你是一家营销公司的数据分析师,需要分析特定话题在社交媒体上的讨论趋势。使用 Python 来抓取 Twitter 上的相关帖子是一个常见的做法。在这个过程中,确保遵循 Twitter 的使用条款和访问频率限制至关重要。

import tweepy

# 初始化 Tweepy API

auth = tweepy.OAuthHandler('YOUR_CONSUMER_KEY', 'YOUR_CONSUMER_SECRET')

auth.set_access_token('YOUR_ACCESS_TOKEN', 'YOUR_ACCESS_TOKEN_SECRET')

api = tweepy.API(auth, wait_on_rate_limit=True)

# 搜索帖子

for tweet in tweepy.Cursor(api.search, q="#特定话题", lang="en", tweet_mode='extended').items(100):

print(tweet.full_text)

1.3.3 拓展案例 1:网站内容聚合

你正在开发一个聚合多个新闻源内容的网站。在抓取新闻文章并展示在你的网站上之前,确保你有权使用这些内容,或者只展示文章的标题和一小段摘要,并链接回原始文章,以避免侵犯版权。

import requests

from bs4 import BeautifulSoup

# 请求新闻网站

response = requests.get('https://news.example.com')

soup = BeautifulSoup(response.text, 'html.parser')

# 解析并展示新闻标题和链接

for news_item in soup.select('.news-title'):

title = news_item.text

link = news_item.find('a')['href']

print(f"标题: {title}, 链接: {link}")

1.3.4 拓展案例 2:在线商店价格监控

你为一家价格比较网站工作,负责监控不同在线商店的产品价格。在编写爬虫抓取这些信息时,重要的是要控制请求的频率,避免因为发送过多请求而对商店的网站造成负担。

import time

import requests

from bs4 import BeautifulSoup

product_urls = ['http://onlinestore.example.com/product1', 'http://onlinestore.example.com/product2']

for url in product_urls:

# 发送请求

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 解析产品价格

price = soup.find('span', class_='price').text

print(f"产品价格: {price}")

# 间隔时间,避免过快请求

time.sleep(10)

通过以上案例,我们看到,在实际工作中使用网络爬虫时,遵守法律规定和道德标准是非常重要的。这不仅有助于保护你的项目免受法律风险,也是对其他网站运营者的尊重和负责任的表现。

![【数据结构]排序算法之插入排序、希尔排序和选择排序](https://img-blog.csdnimg.cn/direct/f6a1c78415ac48e2bec8e8a2e3f7356f.png)