大数据基础平台搭建-(四)HBbase集群HA+Zookeeper搭建

大数据平台系列文章:

1、大数据基础平台搭建-(一)基础环境准备

2、大数据基础平台搭建-(二)Hadoop集群搭建

3、大数据基础平台搭建-(三)Hadoop集群HA+Zookeeper搭建

4、大数据基础平台搭建-(四)HBase集群HA+Zookeeper搭建

大数据平台是基于Apache Hadoop_3.3.4搭建的;

HBase集群部署采用HA高可用+完全分布式集群方式搭建

目录

- 大数据基础平台搭建-(四)HBbase集群HA+Zookeeper搭建

- 一、部署架构

- 二、HBase集群节点分布情况

- 三、HBase集群搭建前准备

- 1、Hadoop集群搭建完成

- 2、Zookeeper集群搭建完成

- 3、各组件版本说明

- 四、HBase集群搭建

- 1、在hnode1上部署HBase-HMaster(主)

- 1).解压安装包

- 2).配置环境变量

- 3).修改HBase的环境变量

- 4).修改hbase-site.xml

- 5).修改regionservers

- 6).复制hadoop下的配置文件

- 2、在hnode2上部署HBase-HMaster(备)

- 1).从hnode1上复制hbase安装目录

- 2).配置环境变量

- 3、在hnode3上部署HBase-HRegionServer

- 1).从hnode1上复制hbase安装目录

- 2).配置环境变量

- 4、在hnode4上部署HBase-HRegionServer

- 1).从hnode1上复制hbase安装目录

- 2).配置环境变量

- 5、在hnode5上部署HBase-HRegionServer

- 1).从hnode1上复制hbase安装目录

- 2).配置环境变量

- 6、在hnode1上配置HBase HA

- 7、在hnode1上启动HBase HA集群

- 8、一键启动、停止Zookeeper集群+Hadoop集群+HBase集群

- 9、验证

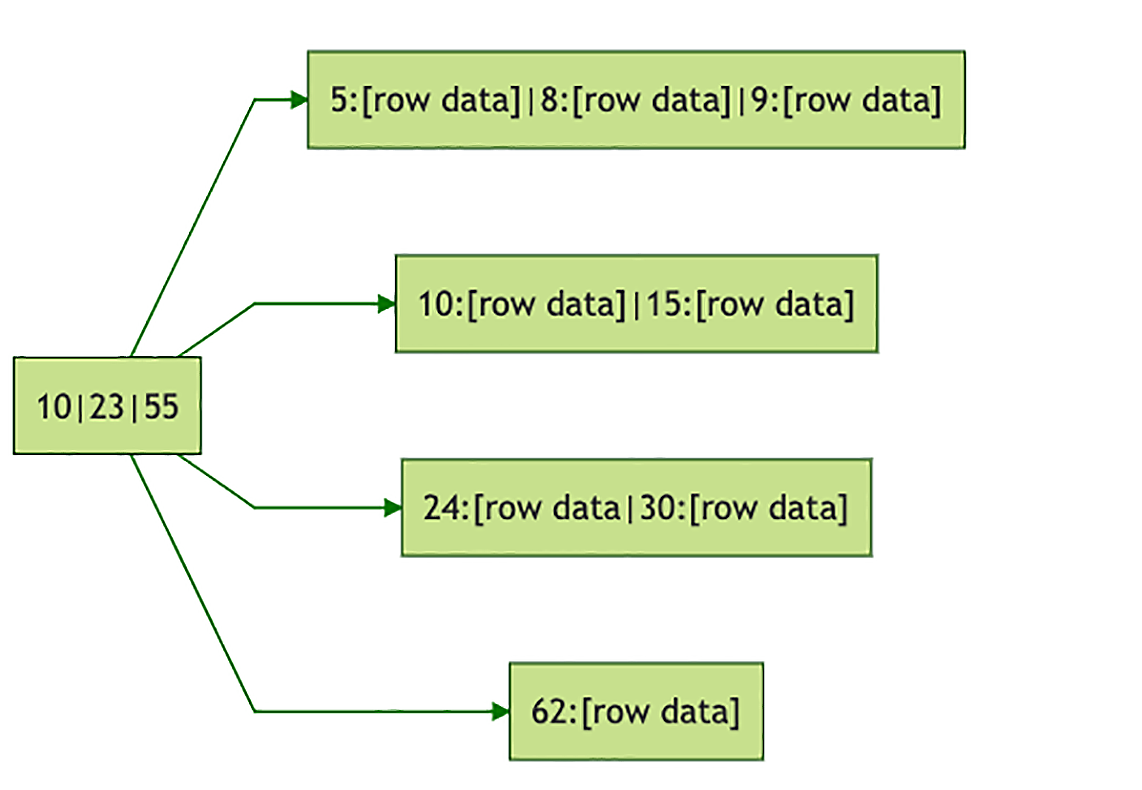

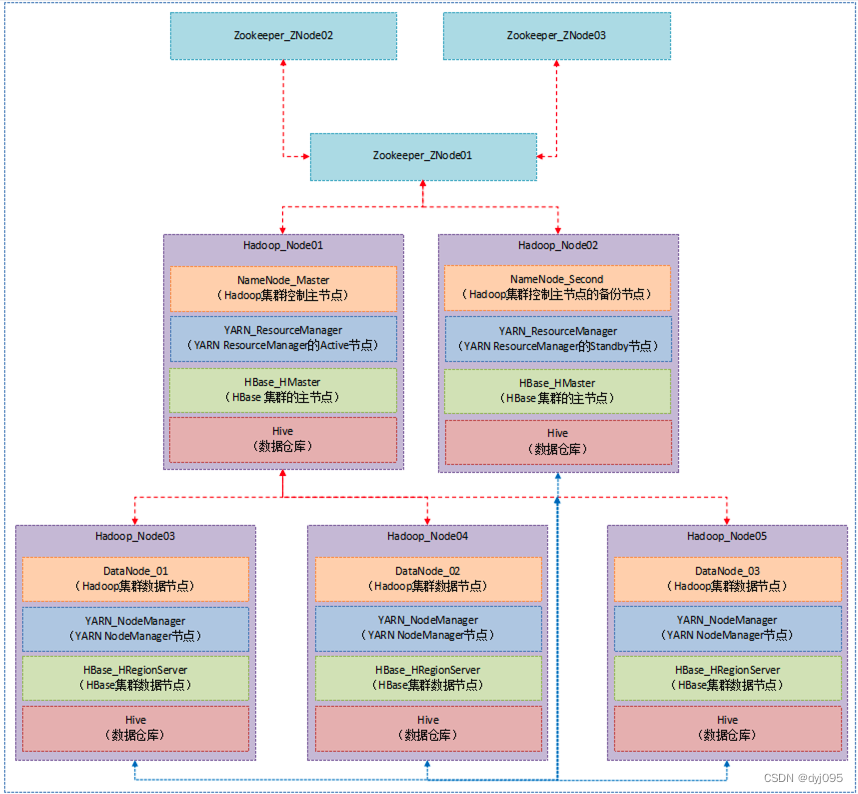

一、部署架构

二、HBase集群节点分布情况

| 序号 | 服务节点 | NameNode节点 | Zookeeper节点 | HMaster节点 | HRegionServer节点 |

|---|---|---|---|---|---|

| 1 | hNode1 | √ (主) | √ | √ (主) | - |

| 2 | hNode2 | √ (备) | √ | √ (备) | - |

| 3 | hNode3 | - | √ | - | √ |

| 4 | hNode4 | - | - | - | √ |

| 5 | hNode5 | - | - | - | √ |

三、HBase集群搭建前准备

1、Hadoop集群搭建完成

参见大数据基础平台搭建-(三)Hadoop集群HA+Zookeeper搭建

2、Zookeeper集群搭建完成

参见大数据基础平台搭建-(三)Hadoop集群HA+Zookeeper搭建中的**【三、搭建Zookeeper集群】**部分

3、各组件版本说明

| 序号 | 软件名称 | 版本 | 说明 |

|---|---|---|---|

| 1 | JDK | 1.8 | |

| 2 | Hadoop | 3.3.4 | |

| 3 | HBase | 3.8.0 | 列式数据库 |

| 4 | Zookeeper | 2.4.15 |

四、HBase集群搭建

1、在hnode1上部署HBase-HMaster(主)

1).解压安装包

[root@hnode1 ~]# cd /opt/hadoop

[root@hnode1 hadoop]# tar -xzvf ./hbase-2.4.15-bin.tar.gz

2).配置环境变量

[root@hnode1 hadoop]# vim /etc/profile

#HBase

export HBASE_HOME=/opt/hadoop/hbase-2.4.15

export PATH=$HBASE_HOME/bin:$PATH

[root@hnode1 hadoop]# source /etc/profile

3).修改HBase的环境变量

[root@hnode1 hadoop]# cd /opt/hadoop/hbase-2.4.15/conf

[root@hnode1 conf]# vim hbase-env.sh

export JAVA_HOME=/usr/java/jdk1.8.0_271

#true表示用自带的zookeeper,false表示用外部Zookeeper服务

export HBASE_MANAGES_ZK=false

export HBASE_CLASSPATH=/opt/hadoop/hbase-2.4.15/conf

4).修改hbase-site.xml

[root@hnode1 hadoop]# vim /opt/hadoop/hbase-2.4.15/conf/hbase-site.xml

<configuration>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/opt/hadoop/data/hbase</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>hdfs://cluster/hbase</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>hnode1:2181,hnode2:2181,hnode3:2181</value>

</property>

</configuration>

5).修改regionservers

[root@hnode1 hadoop]# vim /opt/hadoop/hbase-2.4.15/conf/regionservers

hnode3

hnode4

hnode5

6).复制hadoop下的配置文件

需要将hadoop下的core-site.xml、hdfs-site.xml配置文件复制到hbase服务的conf目录下,否则通过hdfs://cluster/hbase连接hdfs服务时会报无法解析cluster主机

[root@hnode1 hadoop]# cd /opt/hadoop/hbase-2.4.15/conf/

[root@hnode1 conf]# cp /opt/hadoop/hadoop-3.3.4/etc/hadoop/core-site.xml ./

[root@hnode1 conf]# cp /opt/hadoop/hadoop-3.3.4/etc/hadoop/hdfs-site.xml ./

2、在hnode2上部署HBase-HMaster(备)

1).从hnode1上复制hbase安装目录

[root@hnode2 ~]# cd /opt/hadoop

[root@hnode2 hadoop]# scp -r root@hnode1:/opt/hadoop/hbase-2.4.15 ./

2).配置环境变量

[root@hnode2 hadoop]# vim /etc/profile

#HBase

export HBASE_HOME=/opt/hadoop/hbase-2.4.15

export PATH=$HBASE_HOME/bin:$PATH

[root@hnode2 hadoop]# source /etc/profile

3、在hnode3上部署HBase-HRegionServer

1).从hnode1上复制hbase安装目录

[root@hnode3 ~]# cd /opt/hadoop

[root@hnode3 hadoop]# scp -r root@hnode1:/opt/hadoop/hbase-2.4.15 ./

2).配置环境变量

[root@hnode3 hadoop]# vim /etc/profile

#HBase

export HBASE_HOME=/opt/hadoop/hbase-2.4.15

export PATH=$HBASE_HOME/bin:$PATH

[root@hnode3 hadoop]# source /etc/profile

4、在hnode4上部署HBase-HRegionServer

1).从hnode1上复制hbase安装目录

[root@hnode4 ~]# cd /opt/hadoop

[root@hnode4 hadoop]# scp -r root@hnode1:/opt/hadoop/hbase-2.4.15 ./

2).配置环境变量

[root@hnode4 hadoop]# vim /etc/profile

#HBase

export HBASE_HOME=/opt/hadoop/hbase-2.4.15

export PATH=$HBASE_HOME/bin:$PATH

[root@hnode4 hadoop]# source /etc/profile

5、在hnode5上部署HBase-HRegionServer

1).从hnode1上复制hbase安装目录

[root@hnode5 ~]# cd /opt/hadoop

[root@hnode5 hadoop]# scp -r root@hnode1:/opt/hadoop/hbase-2.4.15 ./

2).配置环境变量

[root@hnode5 hadoop]# vim /etc/profile

#HBase

export HBASE_HOME=/opt/hadoop/hbase-2.4.15

export PATH=$HBASE_HOME/bin:$PATH

[root@hnode5 hadoop]# source /etc/profile

6、在hnode1上配置HBase HA

在/opt/hadoop/hbase-2.4.15/conf目录下新增文件backup-masters,在文件中添加hnode2为备机

[root@hnode1 conf]# vim backup-masters

backup-masters配置文件中的内容

hnode2

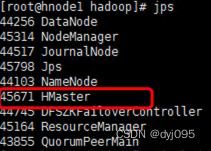

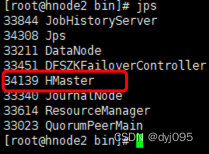

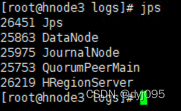

7、在hnode1上启动HBase HA集群

前提是已正常Zookeeper集群和Hadoop集群

[root@hnode1 hadoop]# start-hbase.sh

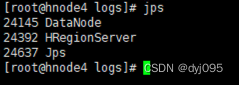

通过在每个节点服务器上运行jps命令,在hnode1和hnode2上启动了HMaster服务,hnode3、hnode4、hnode5是HRegionServer服务则说明HBase集群启动成功

hnode1->HMaster (主)

hnode2->HMaster (备)

hnode3->HRegionServer

hnode4->HRegionServer

hnode5->HRegionServer

8、一键启动、停止Zookeeper集群+Hadoop集群+HBase集群

[root@hnode1 hadoop]# vim hadoop.sh

#!/bin/bash

if [ $# -lt 1 ]

then

echo "缺少参数..."

exit ;

fi

case $1 in

"start")

echo " ===================| 启动 Hadoop集群 | ==================="

echo " -------------------| 启动 Zookeeper集群 | ---------------"

ssh hnode1 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh start"

ssh hnode2 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh start"

ssh hnode3 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh start"

echo " -------------------| 启动 HDFS | ---------------"

ssh hnode1 "/opt/hadoop/hadoop-3.3.4/sbin/start-dfs.sh"

echo " -------------------| 启动 YARN | ---------------"

ssh hnode1 "/opt/hadoop/hadoop-3.3.4/sbin/start-yarn.sh"

echo " -------------------| 启动 HistoryServer |---------------"

ssh hnode2 "/opt/hadoop/hadoop-3.3.4/bin/mapred --daemon start historyserver"

echo " -------------------| 启动 HBase集群 |---------------"

ssh hnode1 "/opt/hadoop/hbase-2.4.15/bin/start-hbase.sh"

;;

"stop")

echo " ===================| 关闭 Hadoop集群 |==================="

echo " -------------------| 关闭 HBase集群 |---------------"

ssh hnode1 "/opt/hadoop/hbase-2.4.15/bin/hbase-daemon.sh stop master"

ssh hnode2 "/opt/hadoop/hbase-2.4.15/bin/hbase-daemon.sh stop master"

ssh hnode1 "/opt/hadoop/hbase-2.4.15/bin/stop-hbase.sh"

echo " -------------------| 关闭 HistoryServer |---------------"

ssh hnode2 "/opt/hadoop/hadoop-3.3.4/bin/mapred --daemon stop historyserver"

echo " -------------------| 关闭 YARN | ---------------"

ssh hnode1 "/opt/hadoop/hadoop-3.3.4/sbin/stop-yarn.sh"

echo " -------------------| 关闭 HDFS | ---------------"

ssh hnode1 "/opt/hadoop/hadoop-3.3.4/sbin/stop-dfs.sh"

echo " -------------------| 关闭 Zookeeper集群 | ---------------"

ssh hnode1 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh stop"

ssh hnode2 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh stop"

ssh hnode3 "/opt/zk/apache-zookeeper-3.8.0-bin/bin/zkServer.sh stop"

;;

*)

echo "输入的参数错误..."

;;

esac

# 启动集群

[root@hnode1 hadoop]# ./hadoop.sh start

# 停止集群

[root@hnode1 hadoop]# ./hadoop.sh stop

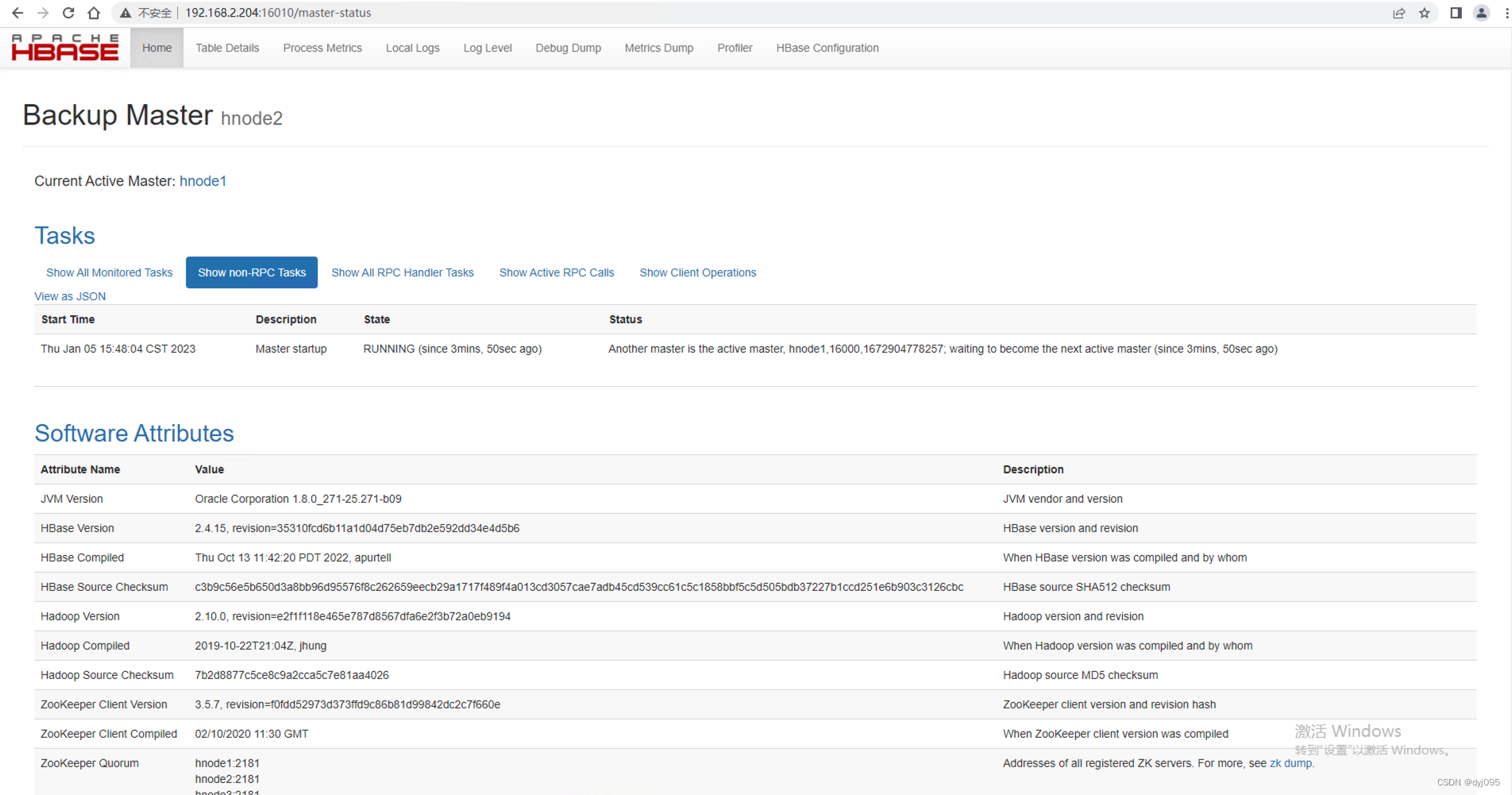

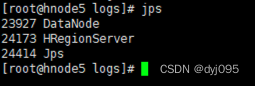

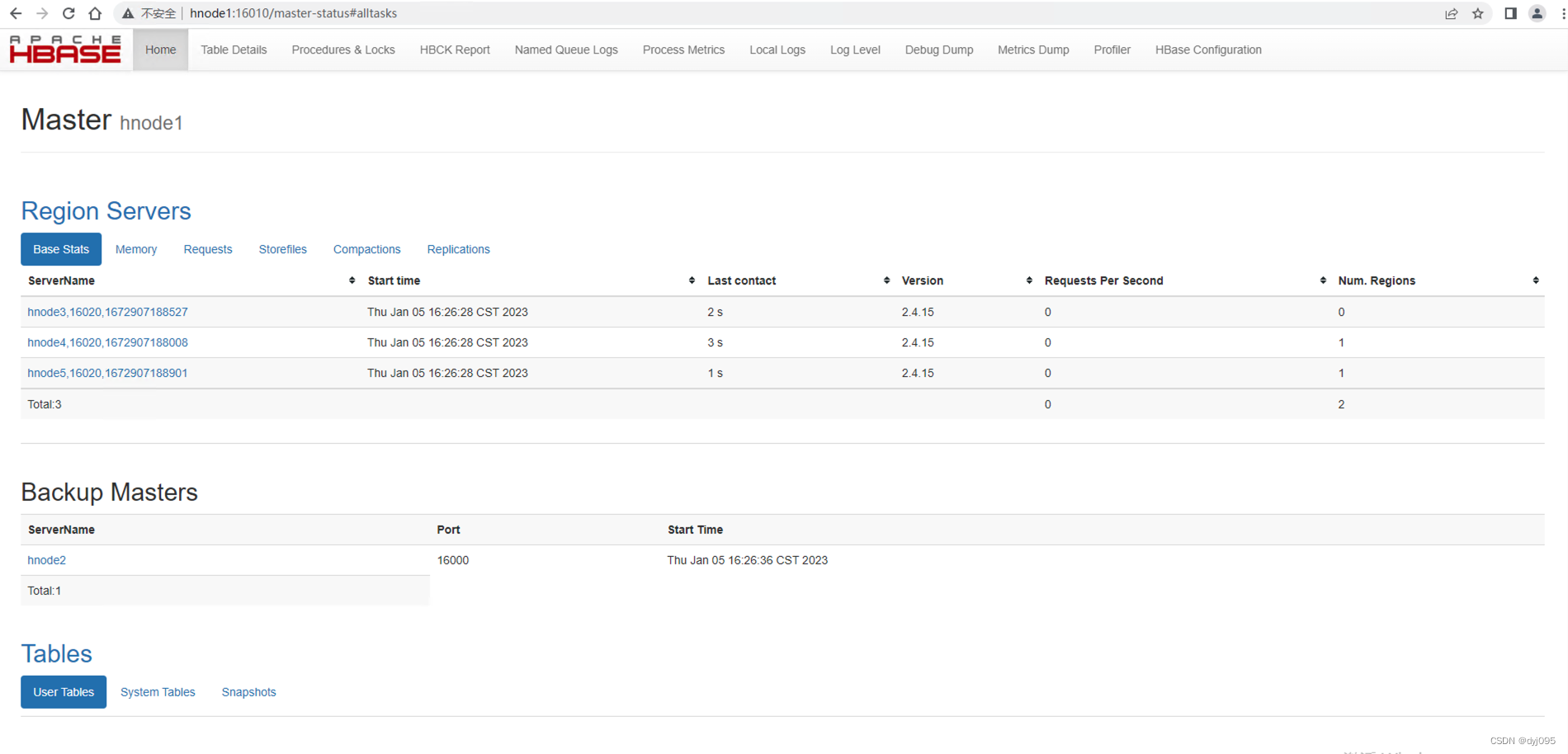

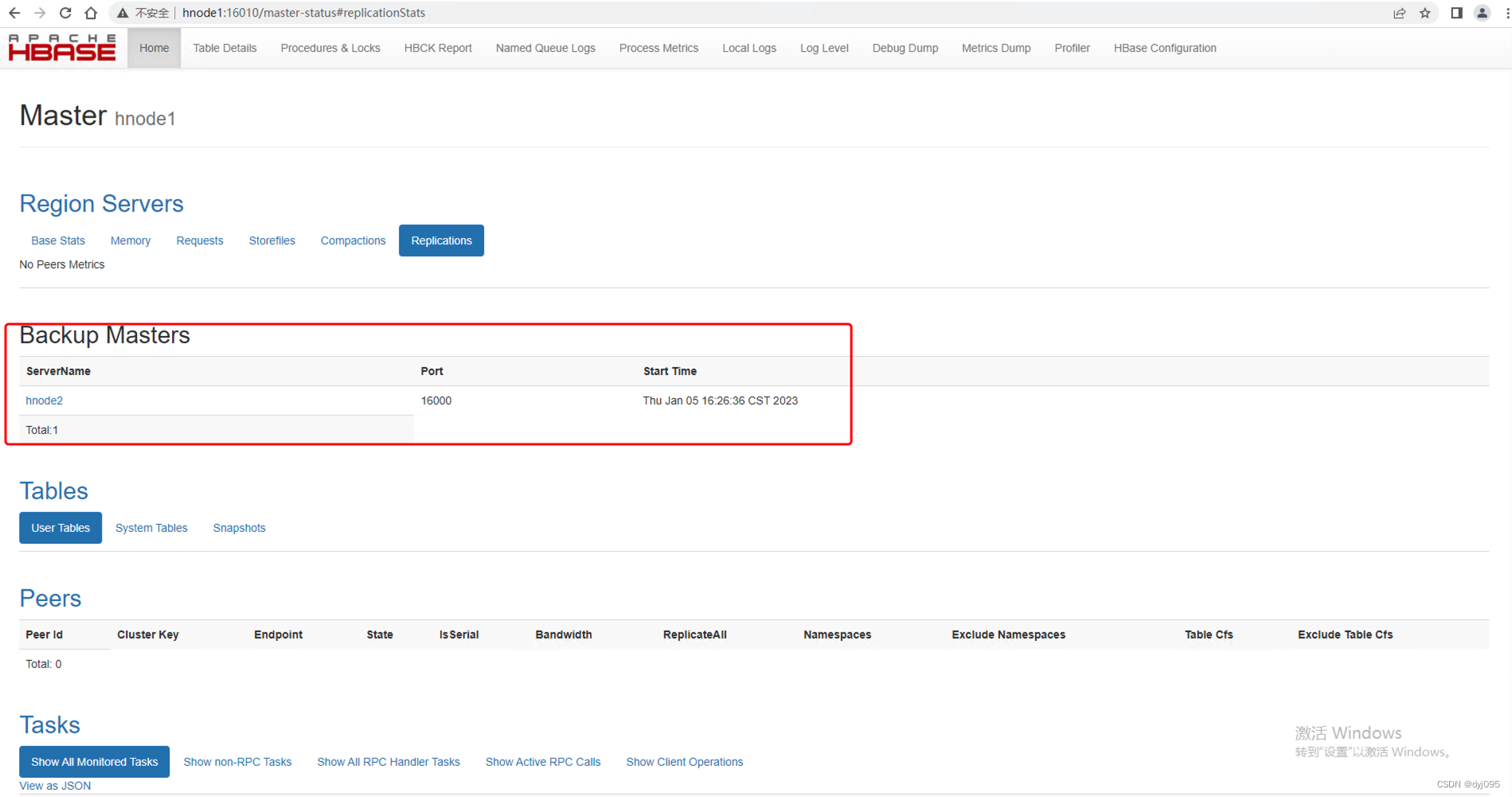

9、验证

http://hnode1:16010和 http://hnode2:16010

HMaster(主)的状态信息

HMaster(备)的状态信息