论文题目:Pixel Aligned Language Models

论文链接:https://arxiv.org/abs/2312.09237

项目主页:Pixel Aligned Language Models

近一段时间以来,大型语言模型(LLM)在计算机视觉领域中也取得了巨大的成功,并且衍生出了一系列视觉语言模型,例如LLaVA、VisualChatGPT等,这些模型也可以以对话的方式来理解和回答用户提出的一些视觉任务,或者对图像进行复杂的推理。但这些模型仍然不具备执行一些细粒度视觉任务的能力,例如对图像进行word grounding(单词定位)或 referring localization(指代定位)等。

本文介绍一篇来自谷歌研究院和加利福尼亚大学圣迭戈分校合作完成的论文,本文的研究团队深入探索了LLM在视觉嵌入空间的运行机制,并提出了一种可以将位置信息(例如一组点或框)作为输入或输出的视觉语言模型,称为PixelLLM(像素大模型)。当将位置作为输入时,PixelLLM会执行位置条件字幕生成任务(location-conditioned captioning),对用户给定的感兴趣区域生成对应的文字描述。而当模型将生成的位置信息作为输出时,PixelLLM会对每个输出单词的像素坐标进行回归,以达到密集word grounding的效果。作者通过大量的实验表明,PixelLLM目前在RefCOCO 和 Visual Genome 等视觉定位数据集上达到了SOTA性能。

01. 引言

先前的视觉语言模型,大多是在额外加入视觉信息之后,对大规模的LLM进行指令微调,使其适应到各种视觉任务中,例如对图像或者视频数据生成描述或生成对话。但这种方式需要将整张图像或整段视频作为LLM的输入,并且产生的输出全部都是文本格式。从实际操作角度来看,这种方式缺乏灵活性,生成的输出结果也缺乏直观性,人们往往更想知道,大模型给出的回答到底与图中的哪些目标或哪些区域有关。因此本文作者提出:LLM能否在视觉世界中实现空间的理解和推理?即将模型推理的重心放在对特定区域和物体位置的理解上,而不是像传统LLM一样仅在语言空间中进行计算。

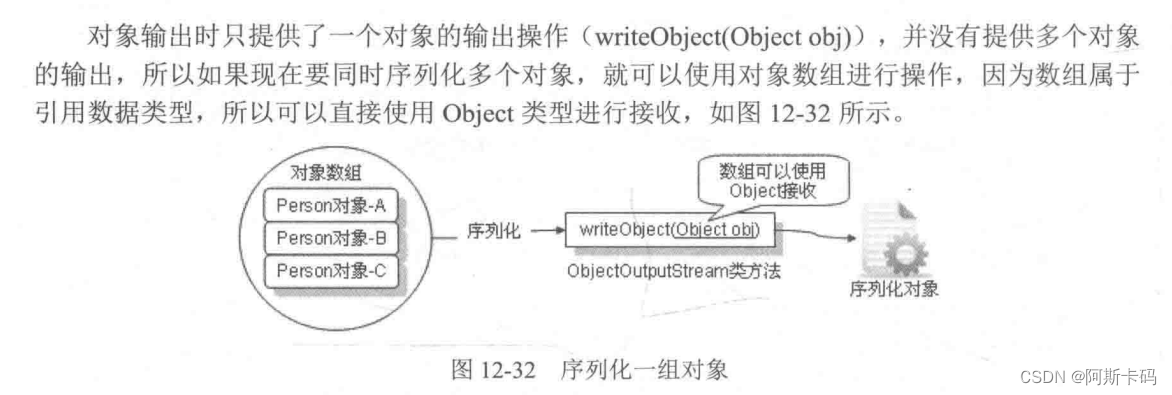

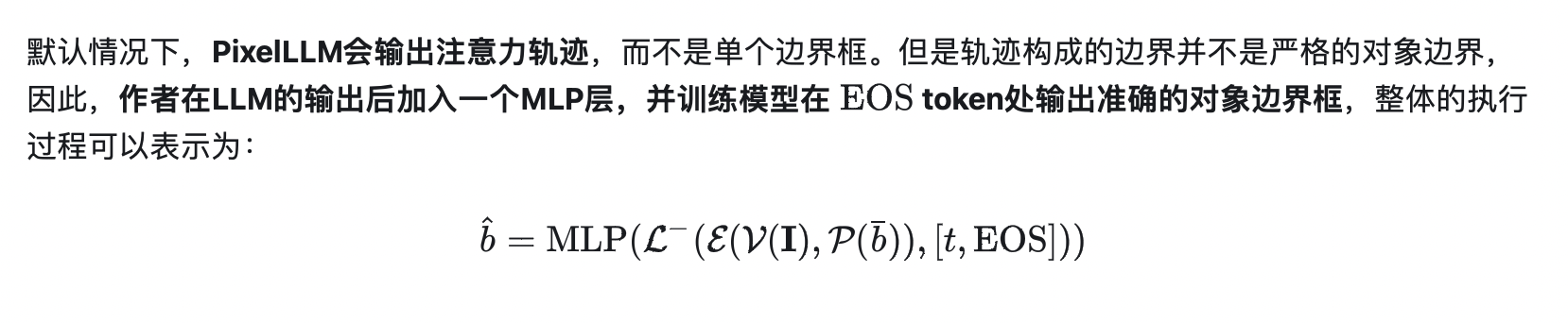

为此,本文提出了一种PixelLLM模型,PixelLLM通过将每个输出单词密集对齐到像素位置,实现了细粒度的视觉理解能力。模型的实现也非常简单,作者仅在LLM输出的单词特征之后加入了一个轻量级的MLP,同时冻结LLM的权重参数,随后通过低秩微调(LoRA)方式对该MLP层进行更新。

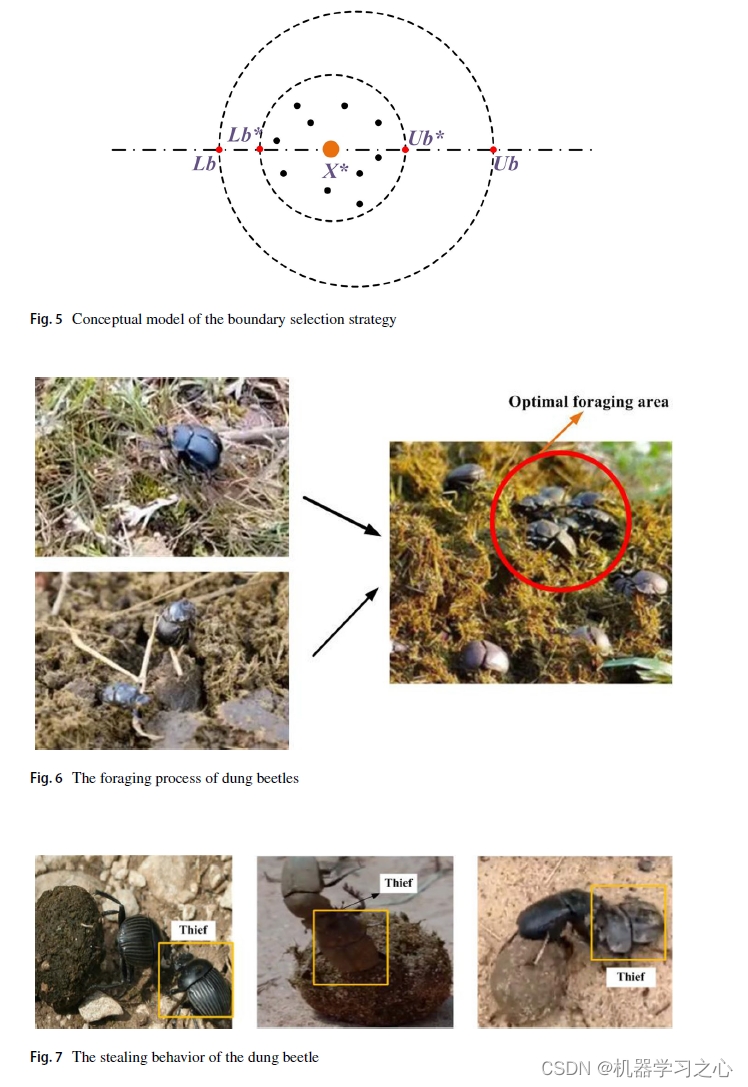

上图展示了PixelLLM可以执行多种细粒度的视觉理解和推理任务,主要分为三个任务:

(1)Pixel-aligned Image Captioning:像素级图像字幕生成仍然以单张图像作为模型输入,但PixelLLM会对输出的每一个单词在原图的位置坐标进行回归,如上图右侧蓝色框线中,每个单词都使用彩色在原图中进行了标注。

(2)Referring Localization:指代定位任务则同时将图像和文本作为模型输入,PixelLLM会直接输出当前文本所指代的图像区域。

(3)Location-conditioned Captioning:位置条件字幕生成任务将图像和一组位置信息作为输入,PixelLLM会根据该位置信息在图中的感兴趣区域进行视觉理解,来生成细粒度的文本描述。

为了实现上述惊艳的视觉推理效果,作者使用像素级对齐的数据集Localized Narrative[1]进行训练,该数据集不仅包含对图像的详细描述,同时还保留了标注员在标注过程中注意力的鼠标轨迹,这对于训练模型的像素级对齐能力至关重要。

02. 本文方法

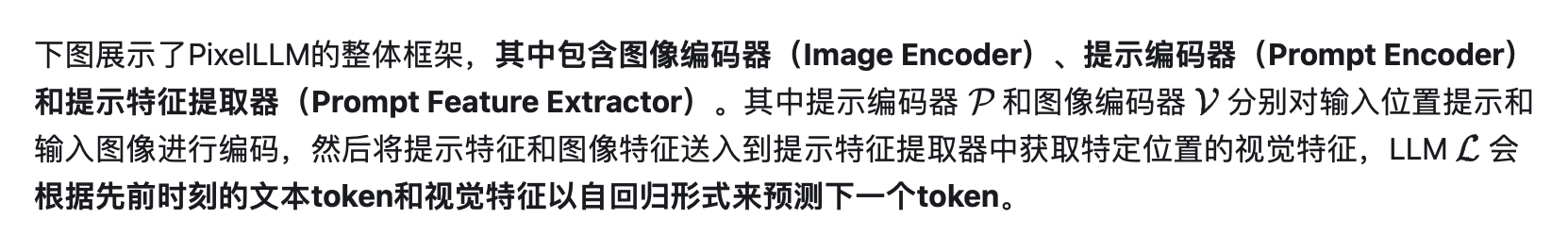

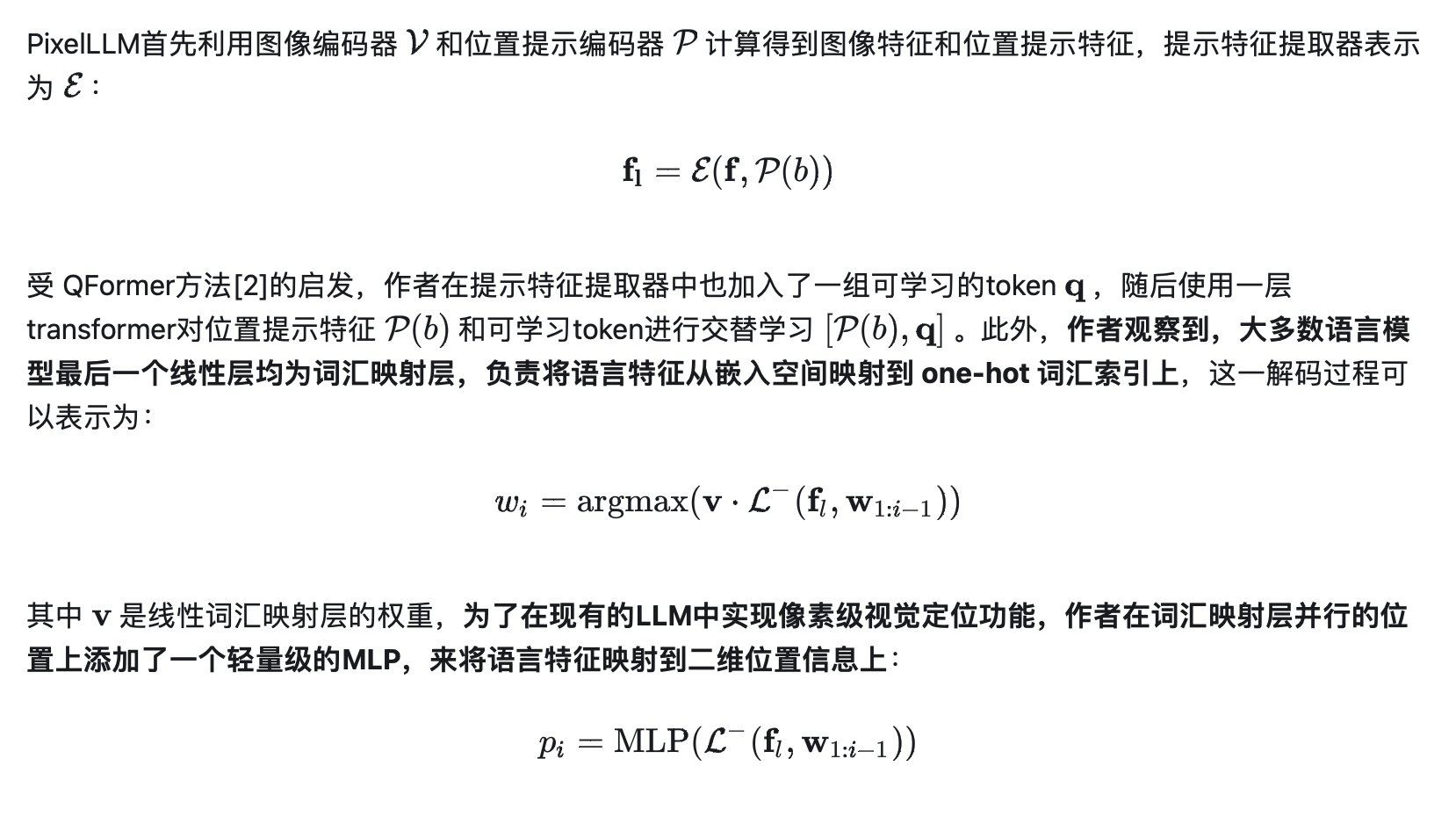

2.1 PixelLLM的整体框架

在视觉社区中,模型的定位能力有多种形式,例如目标检测(根据预定义的类别来定位目标),指代定位(根据一段文本描述来定位目标)和实体定位(根据句子中的每个单词来定位目标)。本文提出的PixelLLM则探索了一种全新的定位方式,即对句子中的每个单词进行像素级对齐。

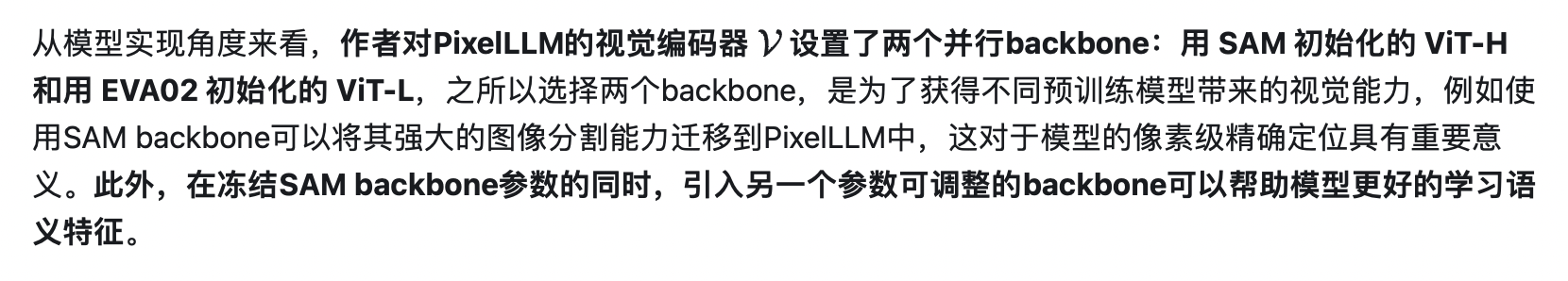

2.2 在LLM中加入视觉定位能力

2.3 PixelLLM如何适应到下游任务中

对于条件位置字幕生成(location-conditioned captioning)和密集对象字幕生成任务(dense object captioning),作者为PixelLLM加入了一个目标检测头(Proposal Head)来获得图像中的感兴趣目标,并将得到的边界框信息作为LLM的输入条件进行生成,整体过程如下图所示。

03. 实验效果

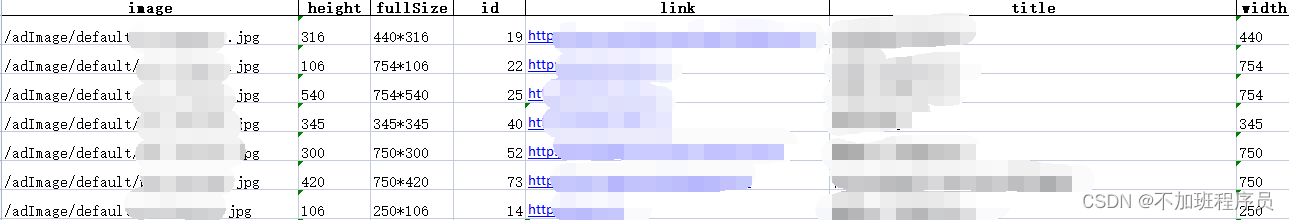

本文的实验主要在RefCOCO、Visual Genome等视觉定位基准上进行,对于指代定位和分割任务,作者采用了RefCOCO数据集的标准评价指标P@0.5和分割cIoU。下表展示了PixelLLM在RefCOCO、RefCOCO+ 和 RefCOCOg三个数据集上的性能对比效果,PixelLLM在绝大多数数据集子集上均超越了先前的方法。

对于条件位置字幕生成任务,作者在RefCOCOg 和 Visual Genome 数据集上进行了评估,模型的输入是真实的边界框,输出是与指示区域相对应的文本字幕,性能评估指标是每个框的 METEOR 和 CIDEr。下表展示了详细的实验对比,本文的方法在Visual Genome的条件文本生成精度为 19.9CIDEr。

此外,作者还对PixelLLM在Localized Narrative的测试集上进行了可视化实验,下图展示了本文方法生成的单词注意力回归轨迹,模型生成的跟踪轨迹在语义上与生成的文本字幕可以很好的对应,PixelLLM准确的描述出了图像中的一些关键目标,例如一个带着帽子的人,拿着一根棍子等等,同时对于背景的草地,模型的注意力轨迹也都定位的较为准确。

04. 总结

本文引入了一种全新的视觉模型定位机制,即在大型语言模型的基础上,对视觉内容进行空间交互理解,并生成文本字幕描述,然后对文本字幕中的每个句子进行像素级对齐。这种模式可以建立在目前常见的LLM之上,因而被称为PixelLLM,PixelLLM可以将图像以及目标位置信息或文本的任意组合作为输入或输出,具有较高的灵活性。此外,作者在PixelLLM中引入了轻量化的微调模块,可以在不破坏原有LLM参数的情况下训练像素级对齐,这使得模型可以轻松的迁移到各种细粒度的下游视觉理解任务中。

参考

[1] Jordi Pont-Tuset, Jasper Uijlings, Soravit Changpinyo, RaduSoricut, and Vittorio Ferrari. Connecting vision and language with localized narratives. In ECCV, 2020. 1, 2, 4, 6, 8, 11

[2] Junnan Li, Dongxu Li, Silvio Savarese, and Steven Hoi. Blip-2: Bootstrapping language-image pre-training with frozen image encoders and large language models. In ICML, 2023.

关于TechBeat人工智能社区

▼

TechBeat(www.techbeat.net)隶属于将门创投,是一个荟聚全球华人AI精英的成长社区。

我们希望为AI人才打造更专业的服务和体验,加速并陪伴其学习成长。

期待这里可以成为你学习AI前沿知识的高地,分享自己最新工作的沃土,在AI进阶之路上的升级打怪的根据地!

更多详细介绍>>TechBeat,一个荟聚全球华人AI精英的学习成长社区

![[Python图像处理] 使用OpenCV创建深度图](https://img-blog.csdnimg.cn/9760aa8ef2ca480b8a169f897a1e3f4e.png)