机器学习算法基础原理:

https://codeknight.blog.csdn.net/article/details/135632808![]() https://codeknight.blog.csdn.net/article/details/135632808

https://codeknight.blog.csdn.net/article/details/135632808

https://codeknight.blog.csdn.net/article/details/135639843![]() https://codeknight.blog.csdn.net/article/details/135639843

https://codeknight.blog.csdn.net/article/details/135639843

机器学习算法模型应用:

(3)【Python数据分析进阶】Machine-Learning模型与算法应用-线性回归与逻辑回归-CSDN博客文章浏览阅读1.5k次,点赞21次,收藏18次。sklearn,全称scikit-learn,是一个基于Python的开源机器学习工具包。它提供了各种分类、回归和聚类算法,包括但不限于支持向量机、随机森林、梯度提升、k均值和DBSCAN等。此外,它还包含了许多常用的机器学习算法、预处理技术、模型选择和评估工具等,可以方便地进行数据挖掘。这个库通过集成NumPy, SciPy和Matplotlib等Python数值计算的库实现了高效的算法应用。可以说,sklearn是机器学习中一个非常常用且功能强大的Python第三方模块。https://blog.csdn.net/qq_51701007/article/details/135693621?spm=1001.2014.3001.5501

目录

1、一元一次线性回归公式与解析

2、多元一次线性回归公式与解析

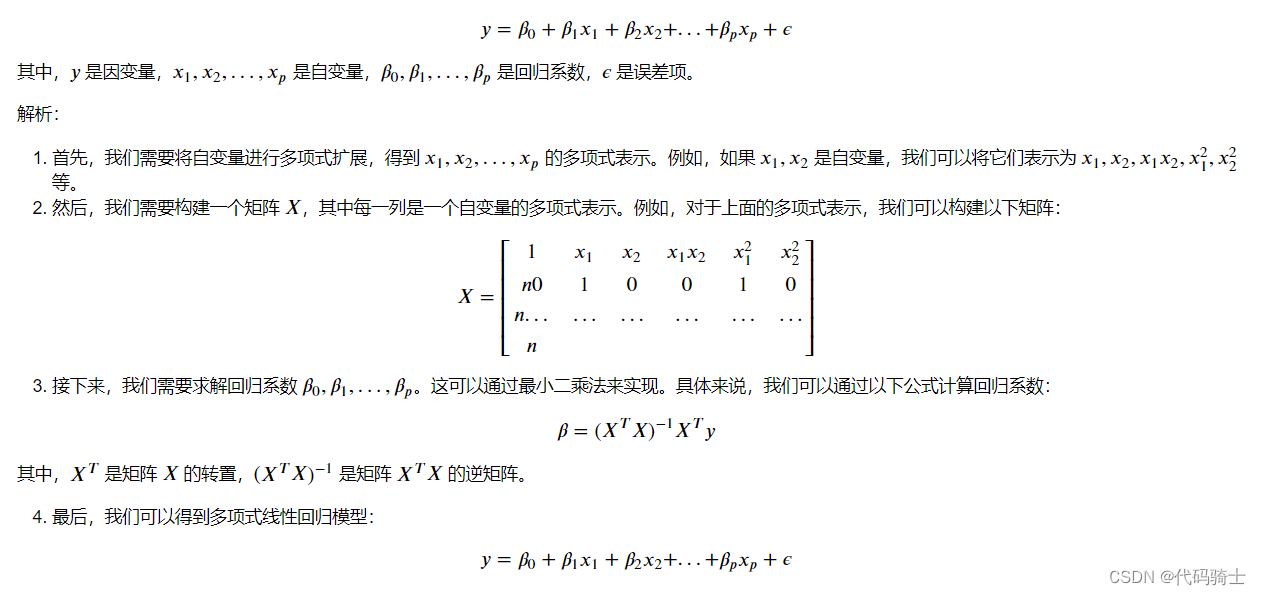

3、多项式线性回归公式与解析

4、VIF(Variance Inflation Factor,方差膨胀因子)公式与解析

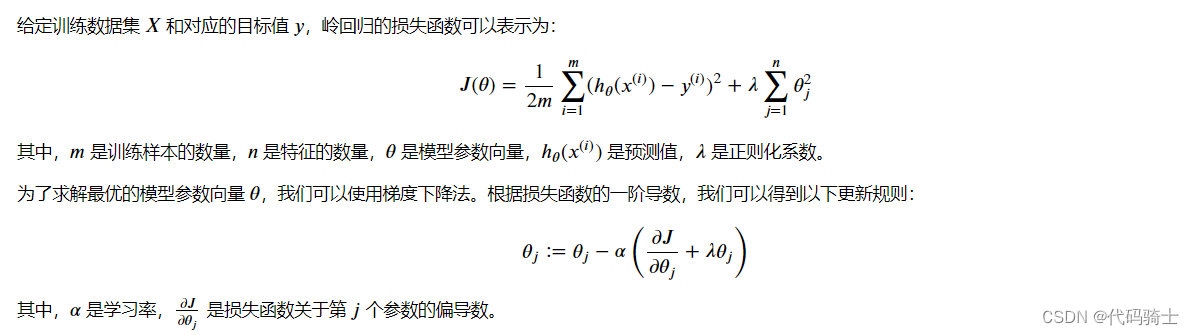

5、岭回归(Ridge Regression)公式与解析

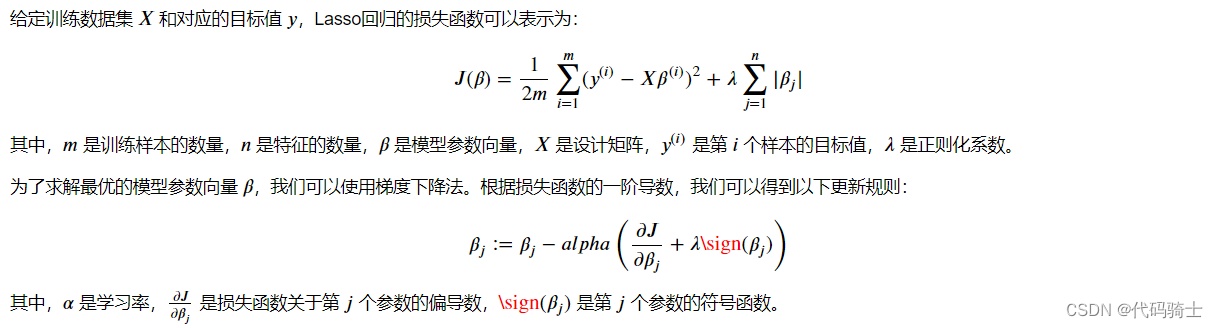

6、Lasso回归(Least Absolute Shrinkage and Selection Operator)公式与解析

7、逻辑回归(Logistic Regression)公式与解释

8、决策树算法公式与解析

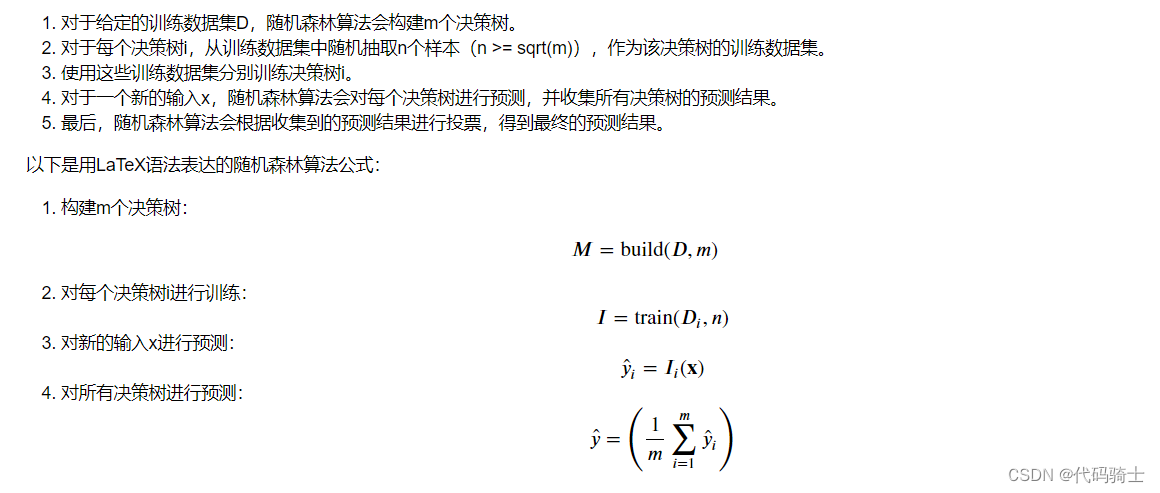

9、随机森林算法公式与解析

10、Adaboost(自适应增强)算法公式与解析

11、XGBoost算法公式与解析

12、Gradient Boosting算法公式与解析

13、KNN算法的公式与解析

14、支持向量机(SVM)算法公式与解析

15、贝叶斯算法公式与解析

16、K-Means聚类算法公式与解析

16、层次聚类算法公式与解析

17、DBSCAN(Density-Based Spatial Clustering of Applications with Noise)算法公式与解析

18、PCA(Principal Component Analysis)算法公式与解析

1、一元一次线性回归公式与解析

y = ax + b,其中a为斜率,b为截距。

解析:

- 首先,我们需要收集数据点(x, y)。

- 然后,计算所有数据点的x和y的平均值。

- 接下来,计算斜率a,即数据点之间的x差的平均值与y差的平均值之比。

- 最后,计算截距b,即y轴上的截距,即y轴上所有数据点的平均值减去斜率a乘以x轴上所有数据点的平均值。

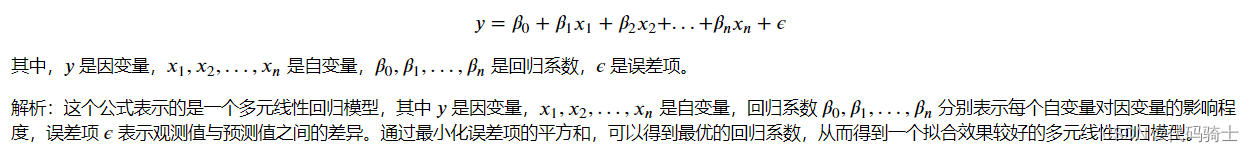

2、多元一次线性回归公式与解析

3、多项式线性回归公式与解析

4、VIF(Variance Inflation Factor,方差膨胀因子)公式与解析

VIF(Variance Inflation Factor,方差膨胀因子)是一种衡量多重共线性的统计指标。在回归分析中,如果一个自变量与多个其他自变量高度相关,那么这个自变量就存在多重共线性问题。

VIF的计算公式为:

VIF = 1 / (1 - R²)

其中,R²表示自变量与其他自变量的相关系数平方和。

5、岭回归(Ridge Regression)公式与解析

岭回归(Ridge Regression)是一种线性回归的改进方法,它通过在损失函数中添加一个L2正则项(权重系数的平方和)来防止过拟合。岭回归的公式如下:

6、Lasso回归(Least Absolute Shrinkage and Selection Operator)公式与解析

Lasso回归(Least Absolute Shrinkage and Selection Operator)是一种线性回归的正则化方法,它通过在损失函数中添加一个L1正则项(权重系数的绝对值之和)来控制模型的复杂度。Lasso回归的公式如下:

7、逻辑回归(Logistic Regression)公式与解释

逻辑回归(Logistic Regression)是一种分类算法,主要用于解决二分类问题。其公式为:

8、决策树算法公式与解析

是一种集成学习方法,它通过构建多个决策树并将它们的预测结果进行投票来得到最终的预测结果。随机森林算法的主要公式如下:

9、随机森林算法公式与解析

是一种集成学习方法,它通过构建多个决策树并将它们的预测结果进行投票来得到最终的预测结果。随机森林算法的主要公式如下:

10、Adaboost(自适应增强)算法公式与解析

10、Adaboost(自适应增强)算法公式与解析

即自适应增强算法,是一种集成学习的算法。其核心思想是通过对训练数据集进行重新加权,使得前一个基础分类器分错的样本在后一个基础分类器中得到更多的关注,同时减小前一个分类器分对的样本在后一个分类器中的关注。此外,该算法会赋予每个弱分类器一个权重系数,这个权重系数体现了这个弱分类器的性能好坏。

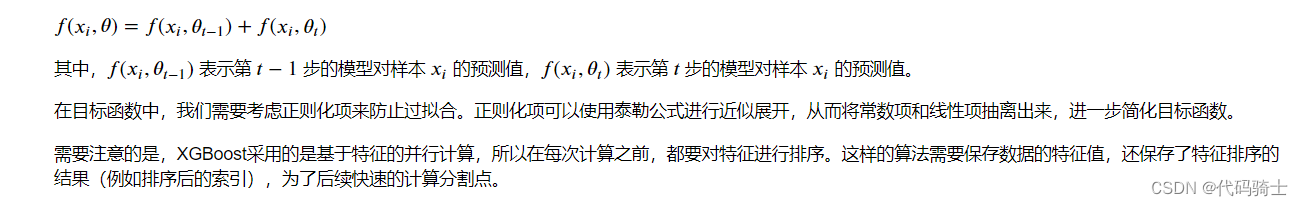

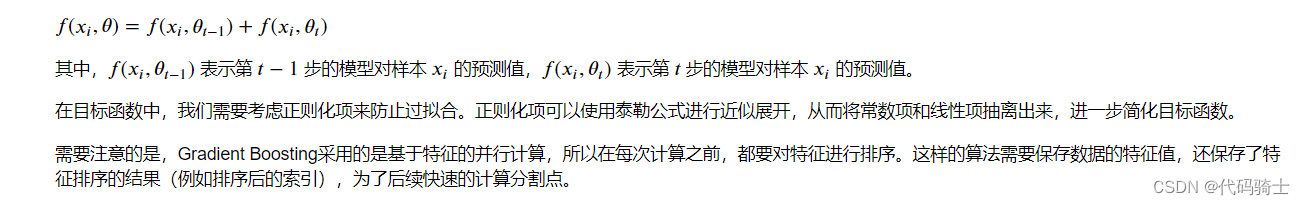

11、XGBoost算法公式与解析

12、Gradient Boosting算法公式与解析

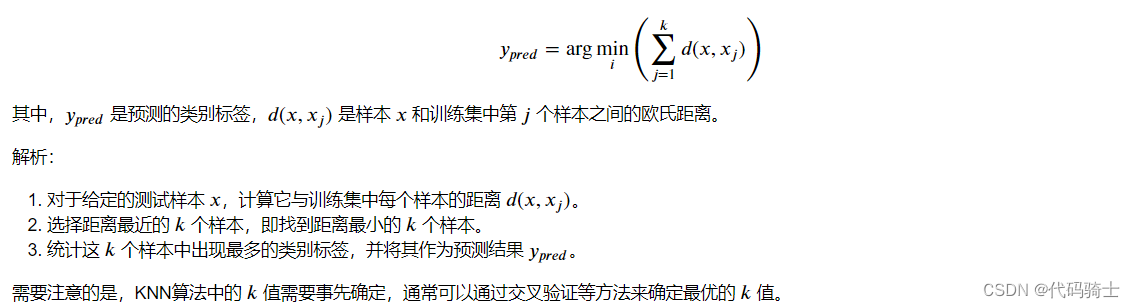

13、KNN算法的公式与解析

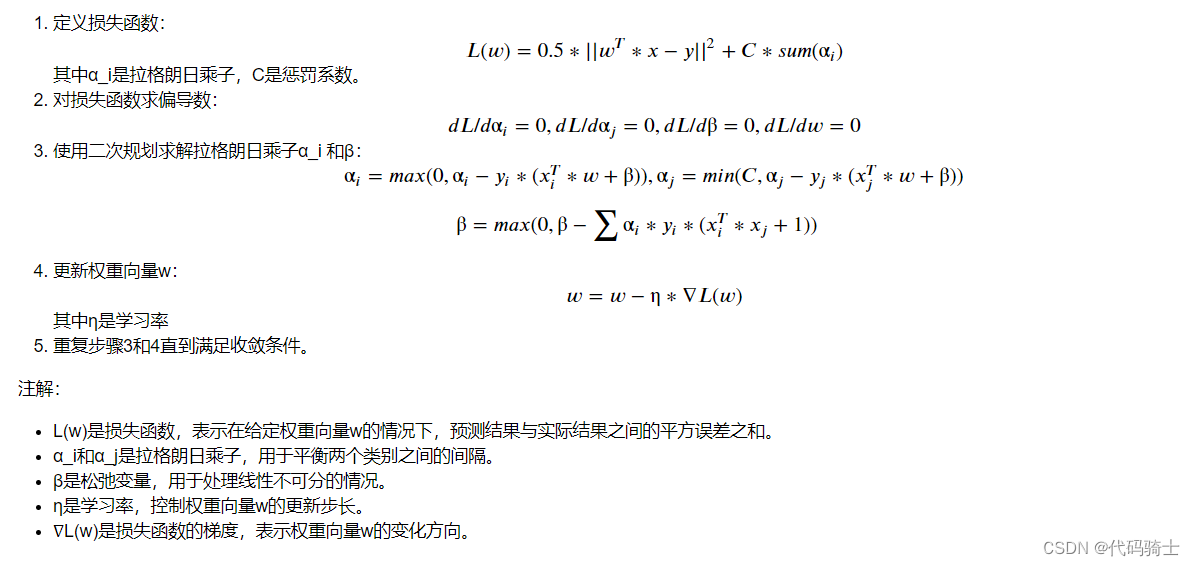

14、支持向量机(SVM)算法公式与解析

支持向量机(SVM)算法的核心思想是找到一个超平面,使得两个类别之间的间隔最大化。这个超平面被称为最优分割超平面。支持向量机算法的公式如下:

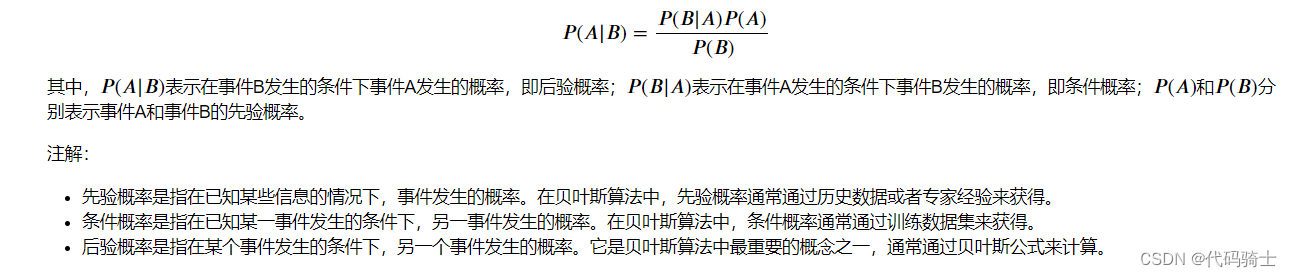

15、贝叶斯算法公式与解析

是一种基于概率的分类算法,它通过计算先验概率和后验概率来进行分类。贝叶斯公式是该算法的核心公式,其表达式如下:

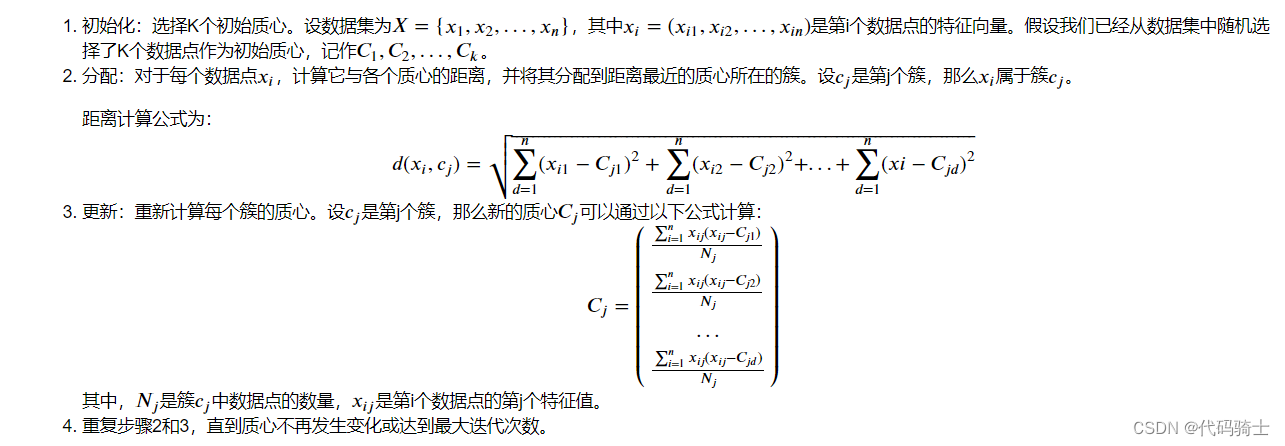

16、K-Means聚类算法公式与解析

是一种无监督学习方法,其基本思想是通过迭代计算,将数据集划分为K个簇。算法的主要步骤如下:

- 初始化:选择K个初始质心(可以随机选择数据集中的数据点作为初始质心)。

- 分配:将每个数据点分配到距离其最近的质心所在的簇。

- 更新:重新计算每个簇的质心,即簇内所有数据点的均值。

- 重复步骤2和3,直到质心不再发生变化或达到最大迭代次数。

K-Means算法的LaTeX公式表示如下:

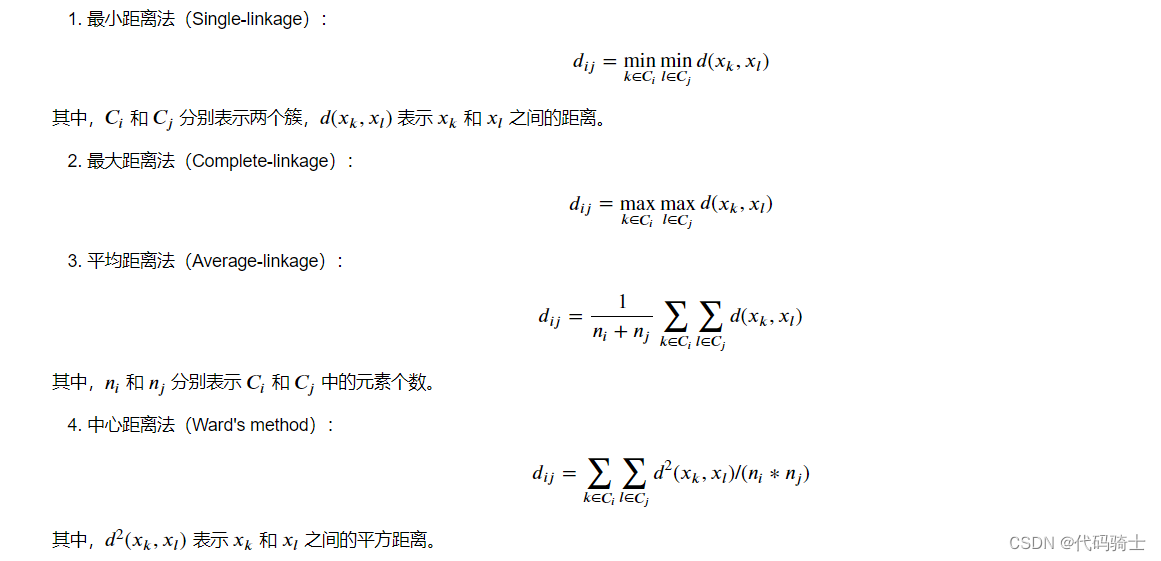

16、层次聚类算法公式与解析

主要包括两种:凝聚式(Agglomerative)和分裂式(Divisive)。这里以凝聚式为例,介绍其公式及注解。

-

最小距离法(Single-linkage):计算簇内各点之间的距离,取最小值作为簇间的距离。

-

最大距离法(Complete-linkage):计算簇内各点之间的距离,取最大值作为簇间的距离。

-

平均距离法(Average-linkage):计算簇内各点之间的距离,取平均值作为簇间的距离。

-

中心距离法(Ward's method):计算簇内各点之间的距离,加上簇间的距离的平方和的倒数作为簇间的距离。

层次聚类算法的公式表示如下:

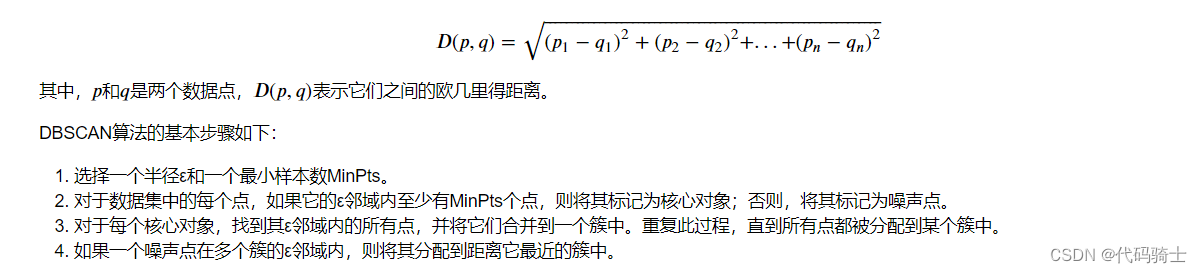

17、DBSCAN(Density-Based Spatial Clustering of Applications with Noise)算法公式与解析

是一种基于密度的聚类算法,它可以找到任意形状的簇,并且能够识别噪声点。DBSCAN算法的主要公式如下:

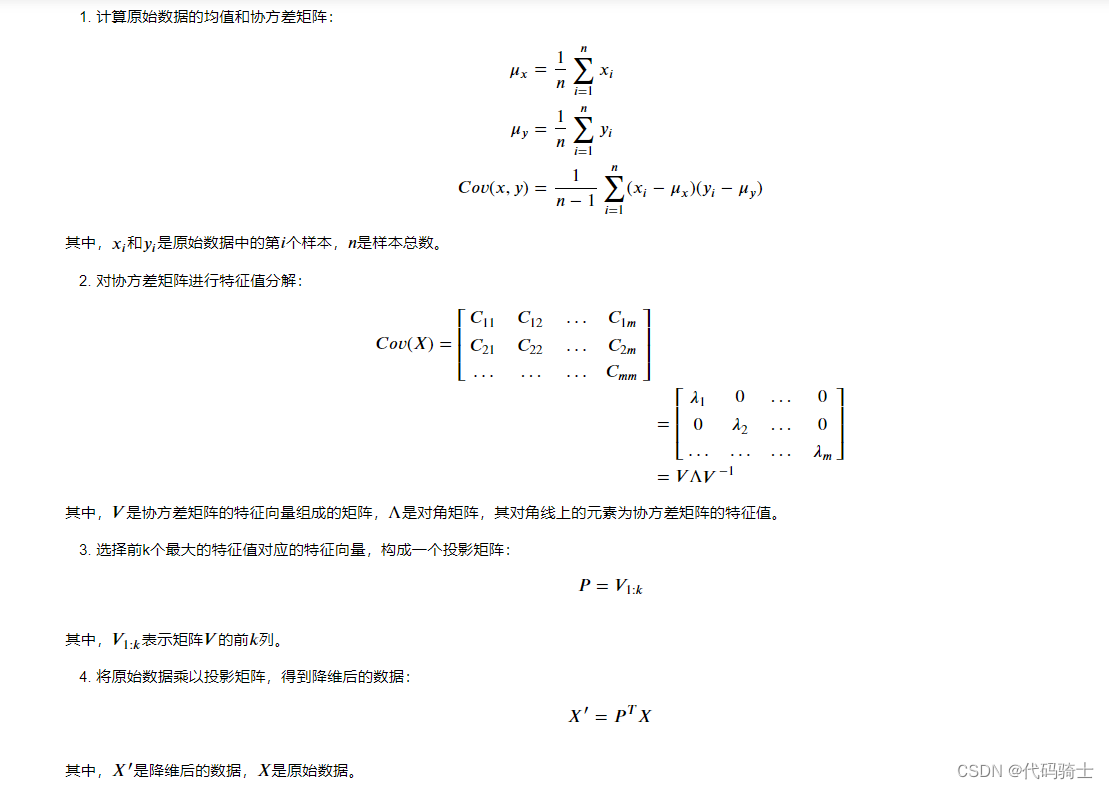

18、PCA(Principal Component Analysis)算法公式与解析

是一种常用的无监督学习算法,用于精简高维数据。它的主要思想是通过线性变换将原始数据投影到新的坐标系中,使得新坐标系的基向量尽可能接近于原始数据的协方差矩阵的特征向量。

PCA算法的基本步骤如下:

- 计算原始数据的均值和协方差矩阵。

- 对协方差矩阵进行特征值分解,得到特征值和特征向量。

- 选择前k个最大的特征值对应的特征向量,构成一个投影矩阵。

- 将原始数据乘以投影矩阵,得到降维后的数据。

以下是PCA算法公式及注解: