文章目录

- 一、内容简介

- 二、前言

- 2.1 Transformer 模型标志着AI 新时代的开始

- 2.2 Transformer 架构具有革命性和颠覆性

- 2.3 Google BERT 和OpenAI GPT-3 等Transformer 模型将AI 提升到另一个层次

- 2.4 本书将带给你的“芝士”

- 2.5 本书面向的读者

- 三、本书内容简介

- 3.1 第一章

- 3.2 第二章

- 3.3 第三章

- 3.4 第四章

- 3.5 第五章

- 3.6 第六章

- 3.7 第七章

- 3.8 第八章

- 3.9 第九章

- 3.10 第十章

- 3.11 第十一章

- 3.12 第十二章

- 3.13 第十三章

- 3.14 第十四章

- 3.15 第十五章

- 3.16 第十六章

- 3.17 第十七章

- 四、粉丝福利

一、内容简介

Transformer正在颠覆AI领域。市面上有这么平台和Transformer模型。本书将引导你使用Hugging Face从头开始预训练一个RoBERTa模型,包括构建数据集、定义数据整理器以及训练模型等。将引领你进入Transformer的世界,将讲述不同模型和平台的优势,指出如何消除模型的缺点和问题。

《基于GPT-3、ChatGPT、GPT-4等Transformer架构的自然语言处理》分步展示如何微调GPT-3等预训练模型。研究机器翻译、语音转文本、文本转语音、问答等NLP任务,并介绍解决NLP难题的技术,甚至帮助你应对假新闻焦虑(详见第13章)。

从书中可了解到,诸如OpenAI的高级平台将Transformer扩展到语言领域、计算机视觉领域,并允许使用DALL-E 2、ChatGPT和GPT-4生成代码。通过本书,你将了解到Transformer的工作原理以及如何实施Transformer来决NLP问题。主要内容总结如下:

-

了解用于解决复杂语言问题的新技术

-

将GPT-3与T5、GPT-2和基于BERT的Transformer的结果进行对比

-

使用TensorFlow、PyTorch和GPT-3执行情感分析、文本摘要、非正式语言分析、机器翻译等任务

-

了解ViT和CLIP如何标注图像(包括模糊化),并使用DALL-E从文本生成图像

-

学习ChatGPT和GPT-4的高级提示工程机制

二、前言

2.1 Transformer 模型标志着AI 新时代的开始

Transformer 是自然语言理解(Natural Language Understanding,NLU)的游戏规则改变者,NLU 是自然语言处理(Natural Language Processing,NLP)的一个子集。NLU已成为全球数字经济中AI 的支柱之一。

Transformer 模型标志着AI 新时代的开始。语言基础已成为语言建模、聊天机器人、个人助理、问答、文本摘要、语音转文本、情绪分析、机器翻译等的支柱。社交网络正在取代实体接触,电子商务正在取代实体购物,数字报纸、流媒体正在取代实体剧院,远程文档咨询正在取代实体访问,远程工作正在取代现场办公,我们正在见证数百个领域的类似趋势。如果没有理解AI 语言,社会上使用网络浏览器、流媒体服务和任何涉及语言的数字活动都将非常困难。我们的社会从物理信息到海量数字信息的范式转变迫使AI 进入一个新时代。AI 已经发展到数十亿级参数模型,以应对万亿级单词数据集的挑战。

2.2 Transformer 架构具有革命性和颠覆性

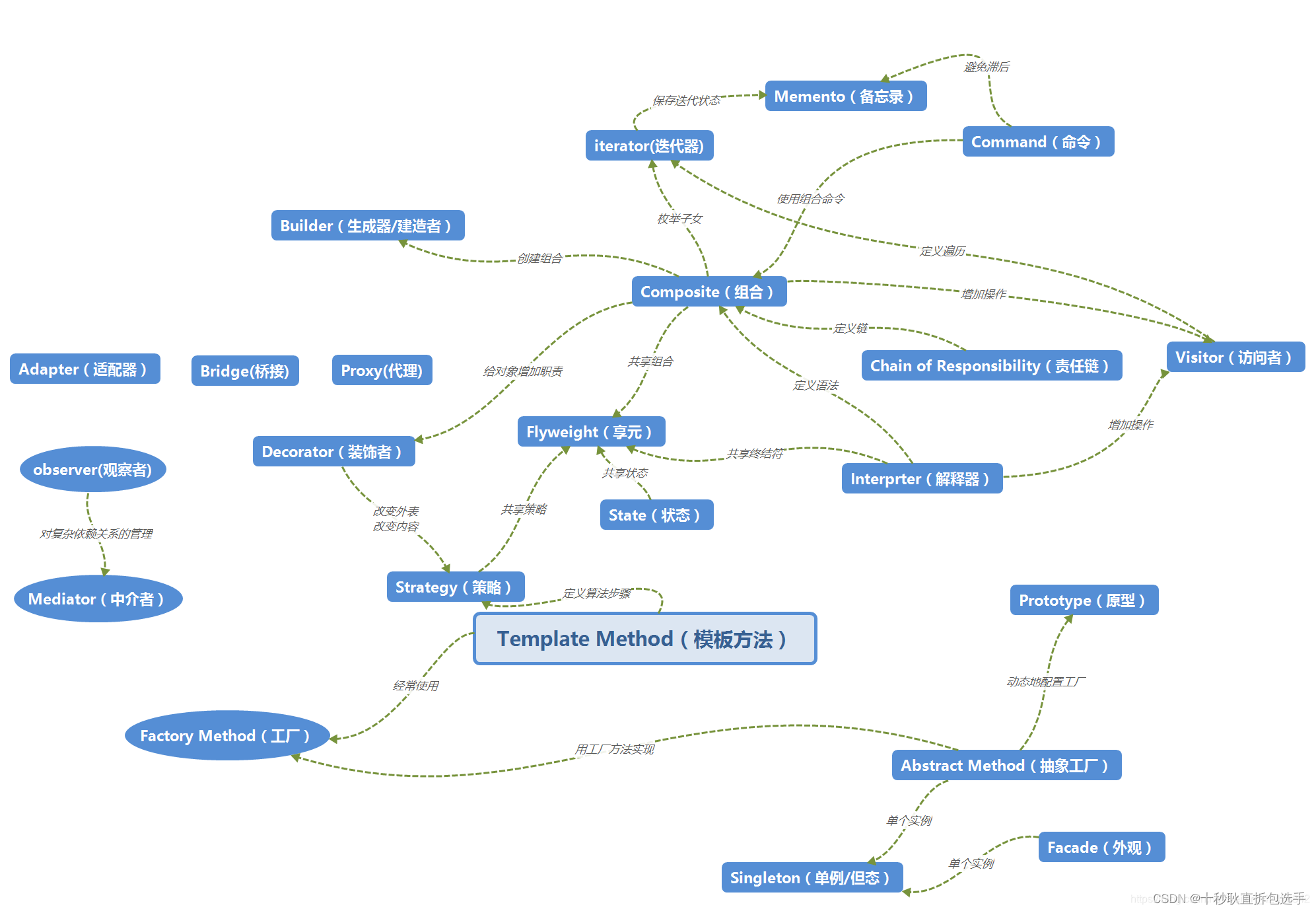

Transformer 架构具有革命性和颠覆性,它打破了过往RNN 和CNN 的主导地位。BERT 和GPT 模型放弃了循环网络层,使用自注意力机制取而代之。Transformer 模型优于RNN 和CNN。这是AI 历史上划时代的重大变化。Transformer 编码器和解码器包含单独训练的注意力头(attention head),并能使用GPU、TPU 等尖端硬件进行并行化。注意力头可以使用GPU 运行,从而为十亿级参数模型和即将出现的万亿级参数模型打开大门。OpenAI 在一台具有10 000个GPU和285 000 个CPU 内核的超级计算机上训练出具有1750 亿个参数的GPT-3 Transformer 模型。随着数据量的不断增长,训练AI 模型需要的规模也越来越大。Transformer 模型为参数驱动的AI 开启了新时代。我们需要大量参数进行学习,才能学习到由数以亿计的单词组合的数据集。

2.3 Google BERT 和OpenAI GPT-3 等Transformer 模型将AI 提升到另一个层次

-

Transformer 可以执行数百项它们没有接受过训练的NLP 任务。

-

Transformer 还可通过将图像视为单词序列来学习图像分类和重构图像。本书将介绍尖端的计算机视觉Transformer,如Vision Transformer(ViT)、CLIP 和DALL-E。

-

基础模型是指经过充分训练的、不需要微调即可执行数百项任务的Transformer模型。这种规模的基础模型是我们在这个海量信息时代所需的工具。

想想每天需要多少人来控制社交网络上发布的数十亿条消息的内容,以便在提取所包含的信息之前确定是否合法和合乎道德。想想每天在网络上发布的数百万页文字需要多少人来翻译。或者想象一下,如果要人工对每分钟多达数百万条消息进行控制需要多少人力资源!想想将每天在网络上发布的所有大量流媒体转换为文字需要多少人力资源。想想为不断出现的数十亿幅在线图像生成AI 图像字幕需要多少人力资源。

2.4 本书将带给你的“芝士”

本书将带领你开发代码和设计提示(这是一项控制Transformer 模型行为的新的“编程”技能)。每一章都会使用Python、PyTorch 和TensorFlow 从头开始讲授语言理解的关键方面。你将学习原始Transformer、Google BERT、OpenAI GPT-3、T5 和其他几个模型的架构。最后一章将在前面16 章所学知识的基础上,展示ChatGPT 和GPT-4 的增强能力。你将学会如何微调Transformer,如何从头开始训练模型,如何使用强大的API。Facebook、Google、Microsoft 和其他大型科技公司提供了大量数据集供我们探索。你会密切关注市场上对语言理解的需求,例如媒体、社交媒体和研究论文等领域。在数百项AI 任务中,我们需要总结大量的研究数据,为各个领域翻译文件,并出于伦理和法律原因扫描所有社交媒体帖子。整本书将使用Python、PyTorch 和TensorFlow 进行实战。你将首先学习AI 语言理解神经网络模型的要素,然后学习如何探索和实现Transformer。本书旨在为读者提供在这个颠覆性的AI 时代中,有效开发语言理解关键方面所需的Python 深度学习知识和工具,呈现成为工业 4.0 AI 专家所需要的新技能。

2.5 本书面向的读者

-

熟悉Python 编程的深度学习和NLP 从业者。

-

数据分析师和数据科学家,他们希望了解AI 语言理解,从而完成越来越多的语言驱动的功能。

三、本书内容简介

3.1 第一章

“Transformer 模型介绍”从较高层次解释什么是Transformer 模型。我们将研究Transformer 生态系统和基础模型的特性。该章重点介绍许多可用的平台以及工业4.0 AI 专家的发展历程。

3.2 第二章

“Transformer 模型架构入门”通过回顾NLP 的背景,讲述了循环神经网络(RNN)、长短期记忆网络(LSTM)和卷积神经网络(CNN)深度学习架构是如何演变为Transformer 架构的。我们将通过Google Research 和Google Brain 的作者们独创的“注意力机制就是一切(Attention Is All You Need)”的方法来分析Transformer 的架构。将描述Transformer 的理论,并通过Python 实践来讲解多头注意力子层是如何工作的。通过本章的学习,你将理解Transformer 的原始架构,从而为后续章节探索Transformer多种变体和用法打下良好基础。

3.3 第三章

微调BERT 模型”基于原始Transformer 的架构进行扩展。BERT(Bidirectional Encoder Representations from Transformers)向你展示了一种理解NLP 世界的新方式。与通过分析过去序列来预测未来序列不同,BERT 关注整个序列!首先介绍BERT 架构的关键创新,然后通过在Google Colab 笔记本中逐步执行每个步骤来微调一个BERT模型。与人类一样,BERT 可以学习任务并执行其他新任务,而不需要从头学习。

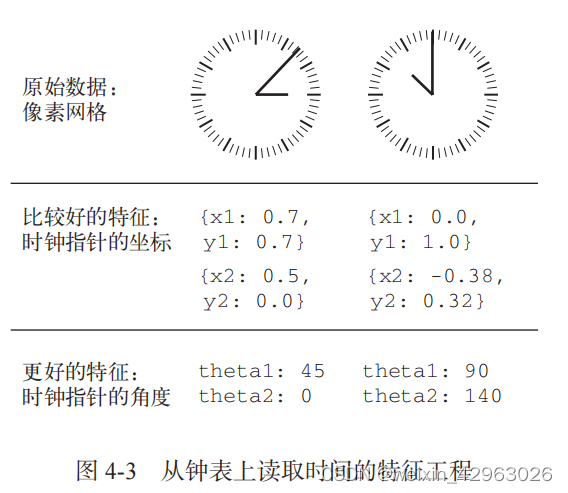

3.4 第四章

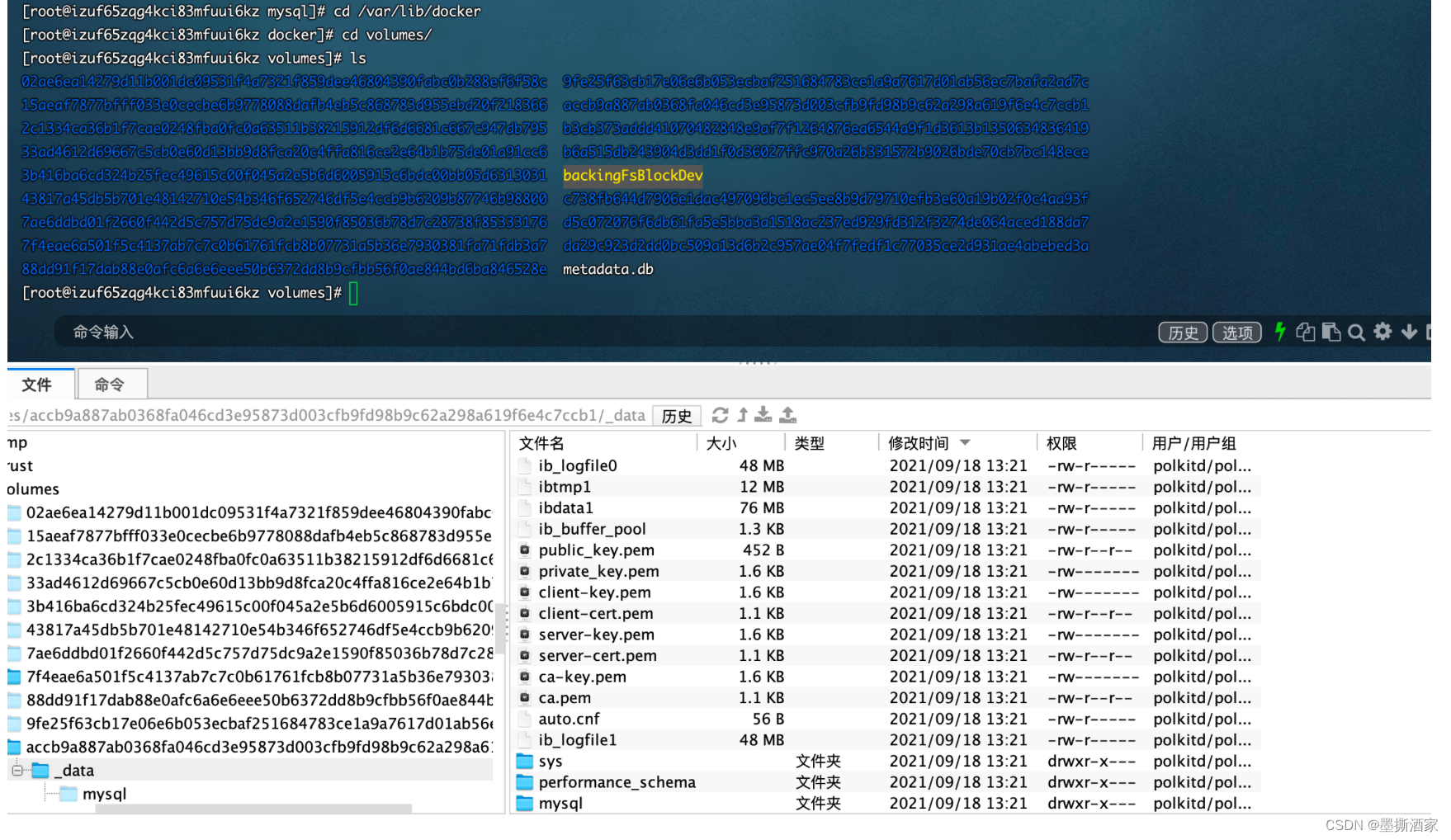

从头开始预训练RoBERTa 模型”使用Hugging Face PyTorch 模块从头构建一个RoBERTa Transformer 模型。这个Transformer 模型既类似于BERT,又类似于DistilBERT。首先,我们将使用自定义数据集从头训练一个词元分析器。然后将使用训练好的Transformer 运行下游的掩码语言建模任务。

3.5 第五章

“使用Transformer 处理下游NLP 任务”揭示了Transformer 模型在下游NLP 任务中的神奇之处。我们可以微调预训练Transformer 模型以执行一系列NLP 任务,如BoolQ、CB、MultiRC、RTE、WiC 等在GLUE 和SuperGLUE 排行榜上占据主导地位的NLP 任务。将介绍Transformer 的评估过程、任务、数据集和评估指标。然后将使用Hugging Face 的Transformer 流水线处理一些下游任务。

3.6 第六章

机器翻译”讲述什么是机器翻译,并讨论如何从依赖人类翻译的基准转向使用机器翻译的方法,从而帮助读者理解如何构建机器翻译系统并进行进一步的研究和开发。然后,我们将预处理来自欧洲议会的WMT 法英数据集。机器翻译需要精确的评估方法,这一章将讲述BLEU 评分方法。最后,我们将使用Trax 实现一个Transformer 机器翻译模型。

3.7 第七章

“GPT-3”探索了OpenAI GPT-2 和GPT-3 Transformer 的许多方面。首先研究OpenAI GPT 模型的架构,解释GPT-3 引擎。然后将运行一个GPT-2 345M 参数模型,并与之交互生成文本。接着将讲述GPT-3 playground 的实际应用,使用GPT-3模型运行NLP 任务,并将结果与GPT-2 进行比较。

3.8 第八章

“文本摘要(以法律和财务文档为例)”介绍T5 Transformer 模型的概念和架构。我们将使用Hugging Face 初始化一个T5 模型进行文本摘要。将使用T5 模型汇总各种文本,然后探索应用于Transformer 的迁移学习方法的优点和局限性。最后,将使用GPT-3 将一些公司法律文本汇总为小学二年级学生都能看懂的文本。

3.9 第九章

“数据集预处理和词元分析器”分析词元分析器的局限性,并介绍一些改进数据编码过程质量的方法。首先构建一个Python 程序,调查为什么一些单词会被Word2Vector 词元分析器省略或误解,讲述预训练词元分析器的局限性。然后我们改进了第8 章T5 模型生成的摘要,以展示词元化过程方法仍然有很大的改进空间。最后,将测试GPT-3 语言理解能力的极限。

3.10 第十章

“基于BERT 的语义角色标注”探索Transformer 如何学习理解文本内容。语义角色标注(SRL)对人类来说是一项具有挑战性的任务。Transformer 能够产生令人惊讶的结果。我们将使用Google Colab 笔记本实现由Allen AI 研究所设计的基于BERT的Transformer 模型。还将使用该研究所的在线资源来可视化SRL 的输出。最后将讲述SRL 的局限性和适用范围。

3.11 第十一章

“使用Transformer 进行问答”展示Transformer 如何学习推理。Transformer能够理解文本、故事,并进行推理。我们将看到如何通过添加NER 和SRL 来增强问答过程。我们将介绍如何设计并实现一个问题生成器;它可以用于训练Transformer模型,也可以单独使用来生成问题。

3.12 第十二章

“情绪分析”展示了Transformer 如何改进情绪分析。我们将使用斯坦福情绪树库对复杂句子进行分析,然后挑战几个Transformer 模型,看看是否能够理解序列的结构及其逻辑形式。我们将看到如何使用Transformer 进行预测,并根据情绪分析的输出触发不同的行为。该章最后还列举一些使用GPT-3 的案例。

3.13 第十三章

“使用Transformer 分析假新闻”深入讲述假新闻这个热门话题,以及Transformer 如何帮助我们理解每天在网络上看到的在线内容的不同观点。每天有数十亿条消息、帖子和文章通过社交媒体、网站和各种实时通信方式发布在网络上。我们将利用前几章介绍的技术来分析关于气候变化和枪支管控的辩论。我们将讨论在合理怀疑的基础上如何确定什么可以被视为假新闻,以及什么新闻仍然是主观的道德和伦理问题。

3.14 第十四章

“可解释AI”通过可视化Transformer 模型的活动来揭开Transformer 模型的面纱。我们将使用BertViz 来可视化注意力头,并使用语言可解释性工具(LIT)进行主成分分析(PCA)。最后将使用LIME 通过字典学习来可视化Transformer。

3.15 第十五章

“从NLP 到计算机视觉”深入研究高级模型Reformer 和DeBERTa,并使用Hugging Face 运行示例。Transformer 可将图像视作单词序列进行处理。该章还将研究各种视觉Transformer 模型,如ViT、CLIP 和DALL-E;我们将使用计算机视觉任务测试它们,包括图像生成。

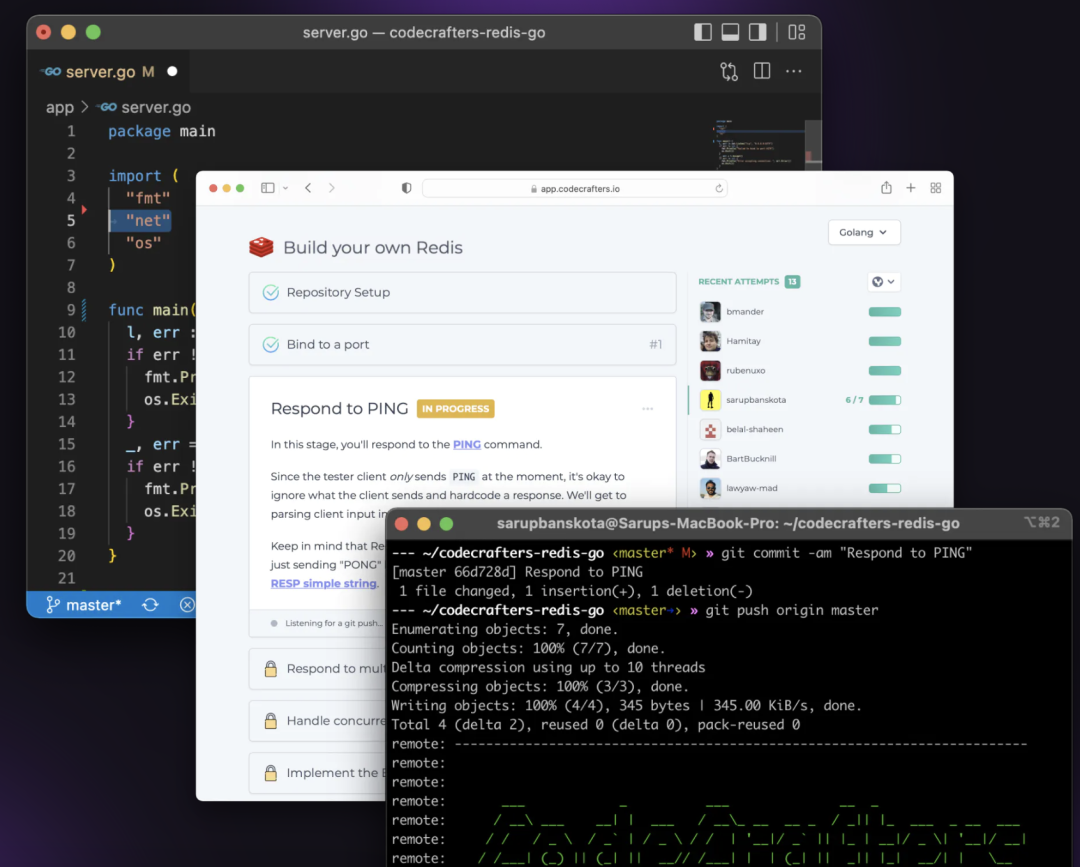

3.16 第十六章

“AI 助理”讲述了当工业4.0(I4.0)达到成熟阶段时,我们将主要与AI助理(Copilot)一起工作。AI 助理主要基于提示工程,所以该章首先列举几个非正式/正式英语提示工程的示例,使用GitHub Copilot 来辅助生成代码。然后讲述视觉Transformer 如何帮助NLP Transformer 可视化周围的世界。最后将创建一个基于Transformer 的推荐系统,可将它应用于数字人和元宇宙中!

3.17 第十七章

“ChatGPT 和GPT-4”在前几章的基础上,探索了OpenAI 最先进的Transformer 模型ChatGPT 和GPT-4。将使用ChatGPT 建立对话式AI,并学习如何使用可解释AI 解释Transformer 的输出。将探索GPT-4,并使用提示编写一个k-means聚类程序。还将介绍一个高级用例。最后将使用DALL-E 2 来创建和生成图像的变体。

四、粉丝福利

没中奖的小伙伴,如果对此书感兴趣可以点击下方的链接自行购买!基于GPT-3、ChatGPT、GPT-4等Transformer架构的自然语言处理。

今天的分享到这里就结束啦!如果觉得文章还不错的话,可以三连支持一下,春人的主页还有很多有趣的文章,欢迎小伙伴们前去点评,您的支持就是春人前进的动力!

![[SpingBoot] 3个扩展点](https://img-blog.csdnimg.cn/direct/af4af2bc98a449babec7d7cfab429290.png)

![[RootersCTF2019]I_<3_Flask](https://img-blog.csdnimg.cn/direct/df40927f9f2e42c58635ec1f21fcc520.png)