yolov8上使用gpu教程

- 安装Cuda和Cudnn

- yolov8上使用gpu

安装Cuda和Cudnn

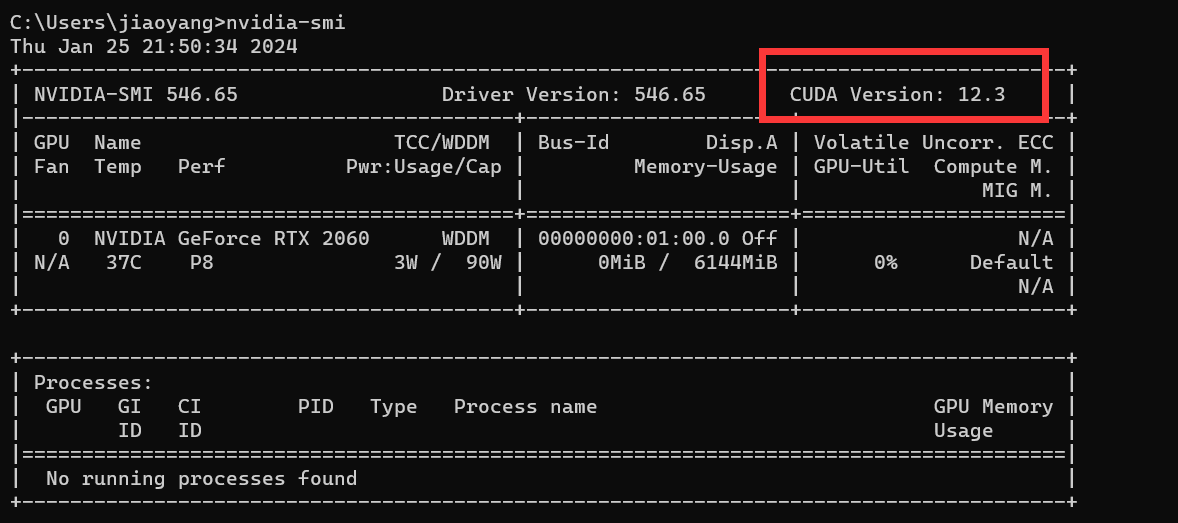

1.查看支持的cuda版本,并去官网下载。

nvidia-smi

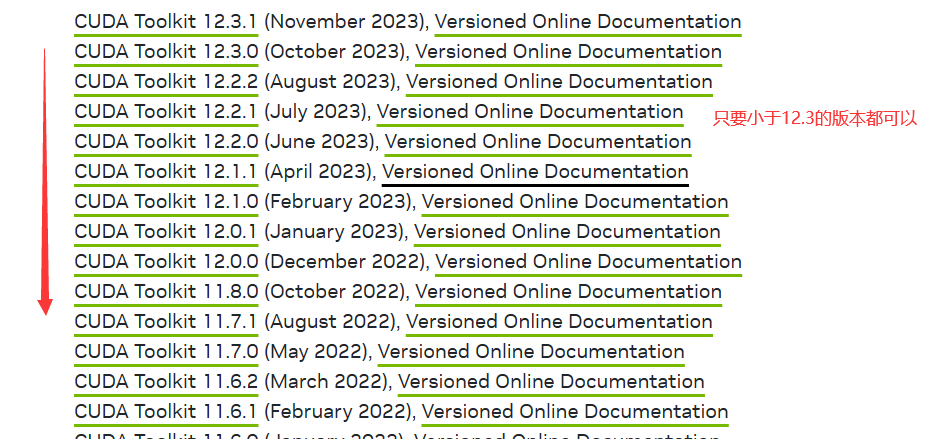

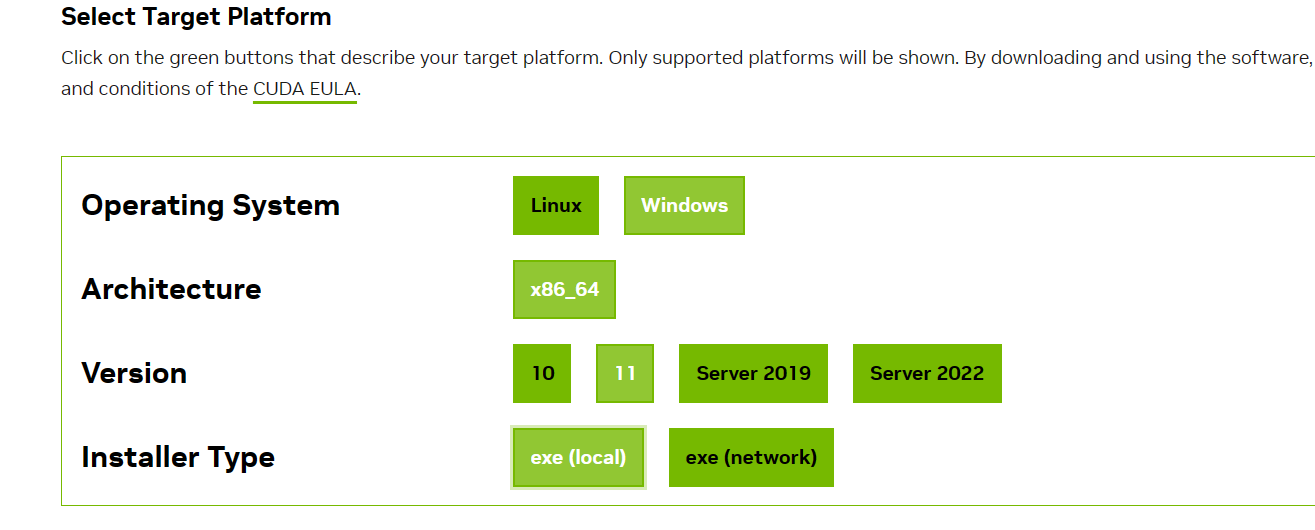

2.网址:https://developer.nvidia.com/cuda-toolkit-archive

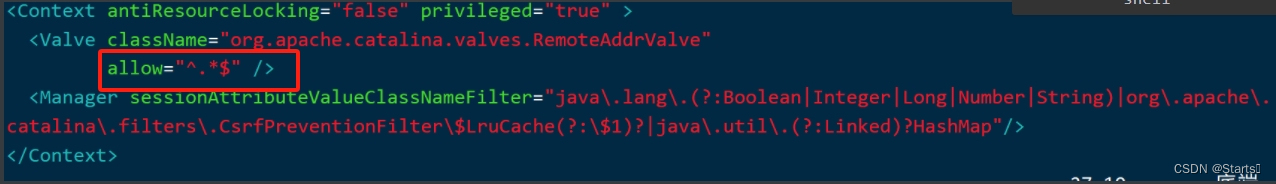

3.安装细节

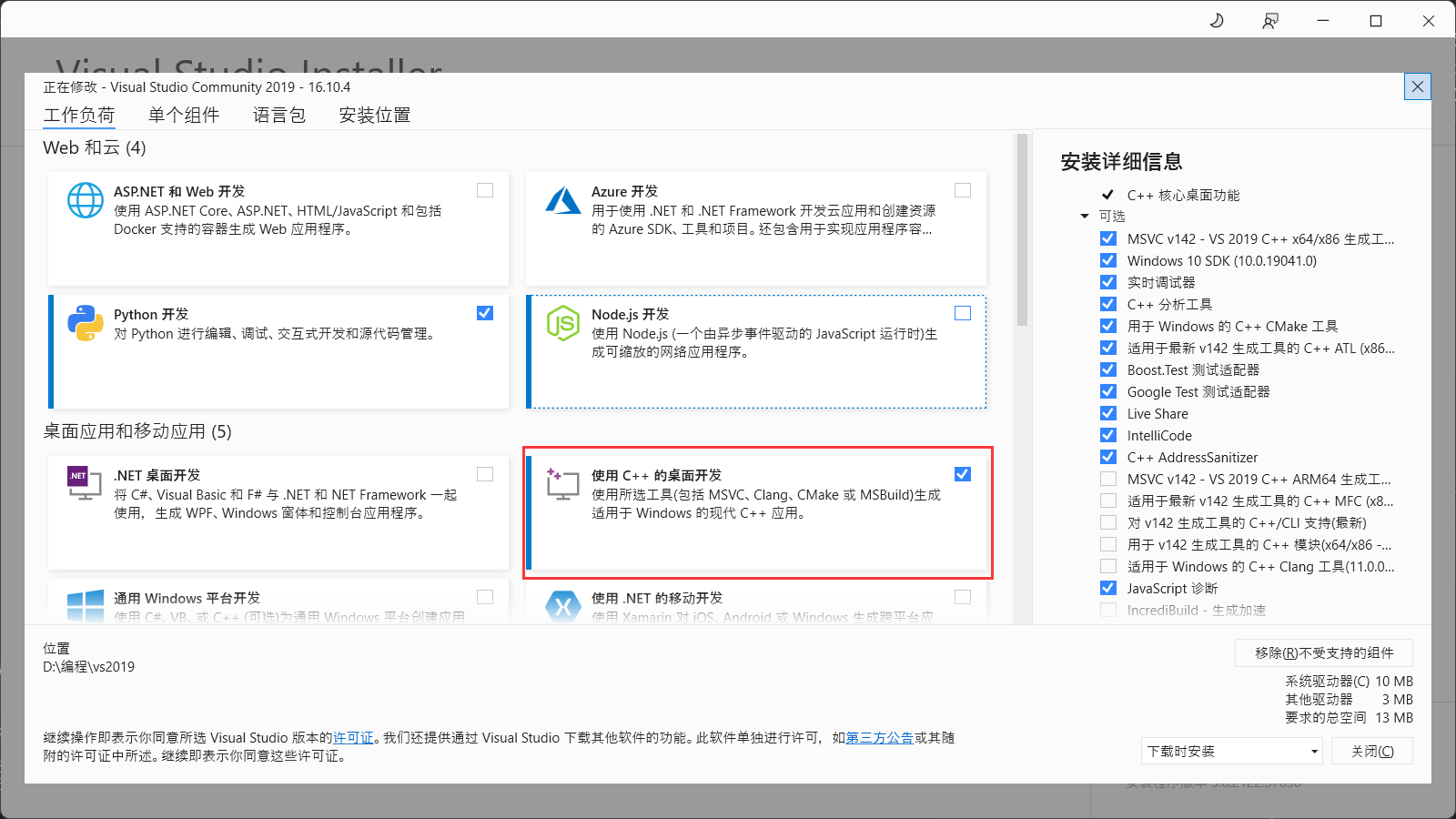

安装的前提基础是,有vs的C++环境。我电脑有vs2019的C++环境。

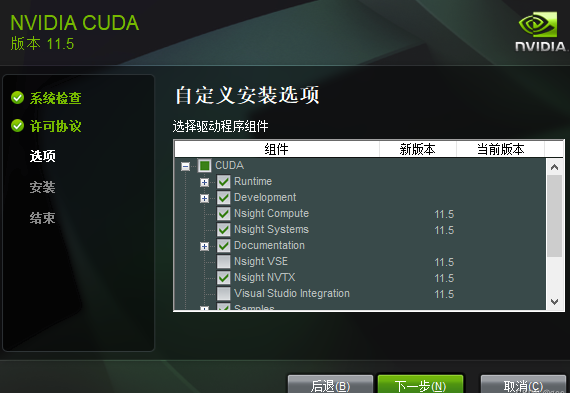

4.取消勾选,这里就借用了其他博主的一些图。

附链接

一开始没有取消勾选,会报错。

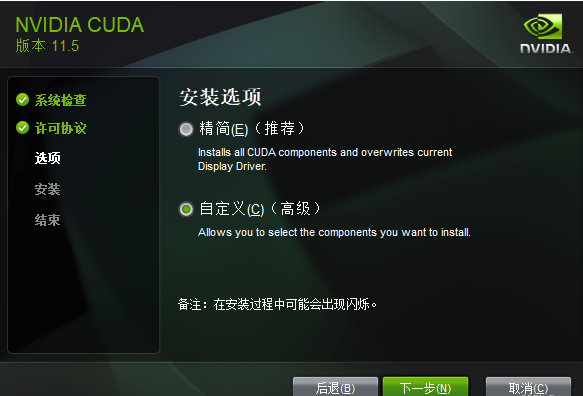

选择自定义

在选择组件的时候,将CUDA中的Nsight VSE和Visual Studio Integration取消勾选,后选择下一步,即可安装成功。

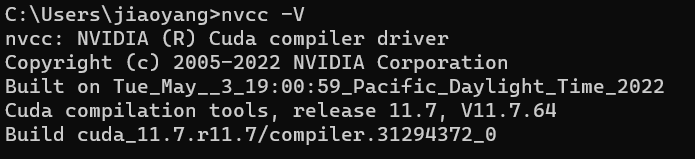

5.查看安装成功与否。

6.安装cudnn。参考一个博主的文章:链接

下载cudnn,先注册账号登录。

选择自己的合适版本。

下载地址:https://developer.nvidia.com/rdp/cudnn-download

7.解压

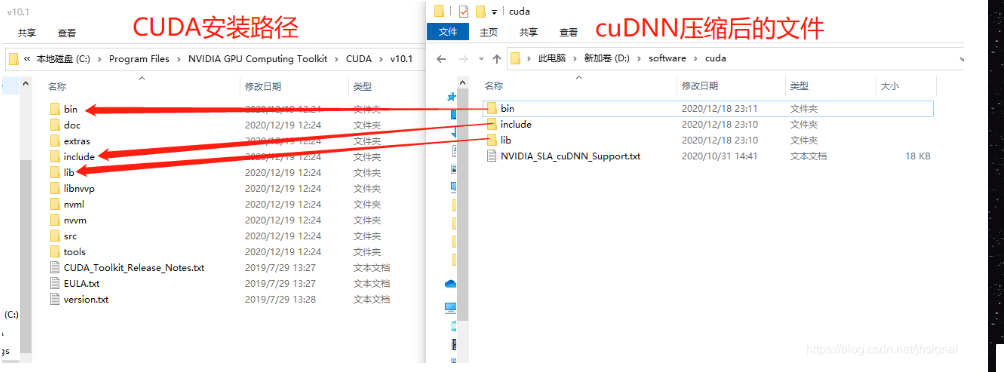

cudnn压缩包解压如图所示

找到cuda安装目录,将这三个文件夹下的文件全部移到cuda对应的文件夹下。

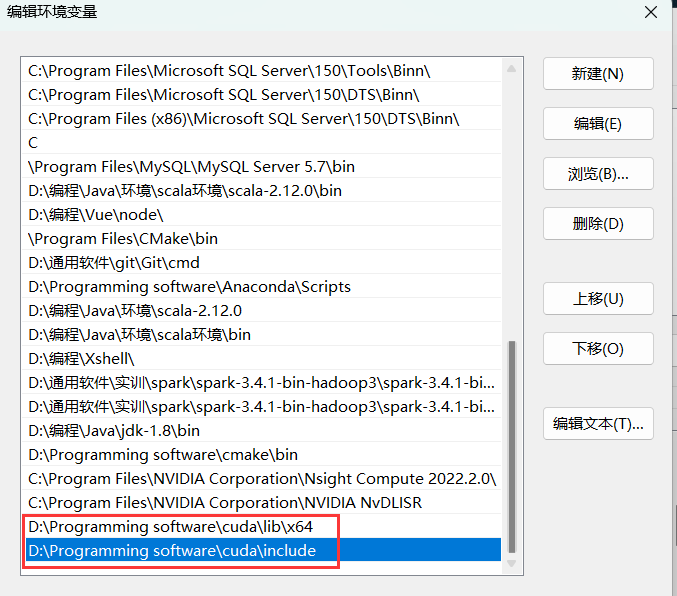

8.添加环境变量

找到安装目录,将这两个添加进去。

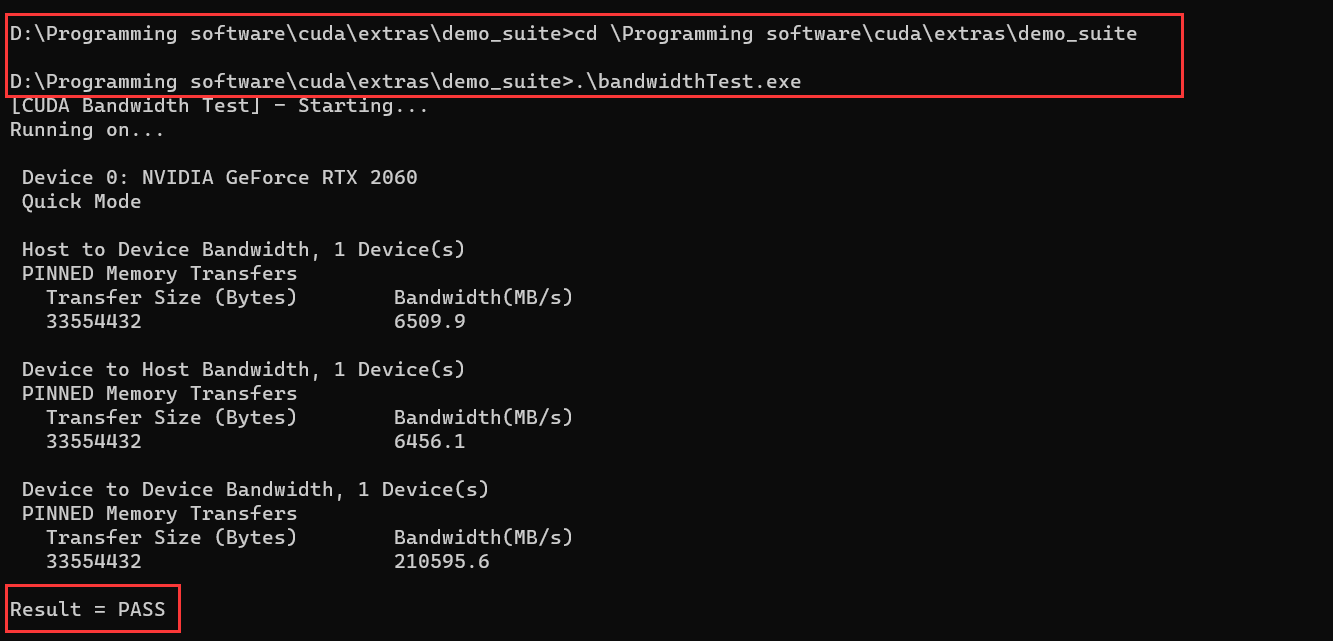

9.测试cudnn是否安装成功。

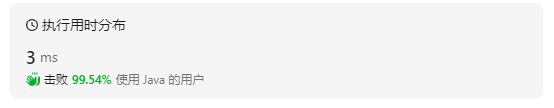

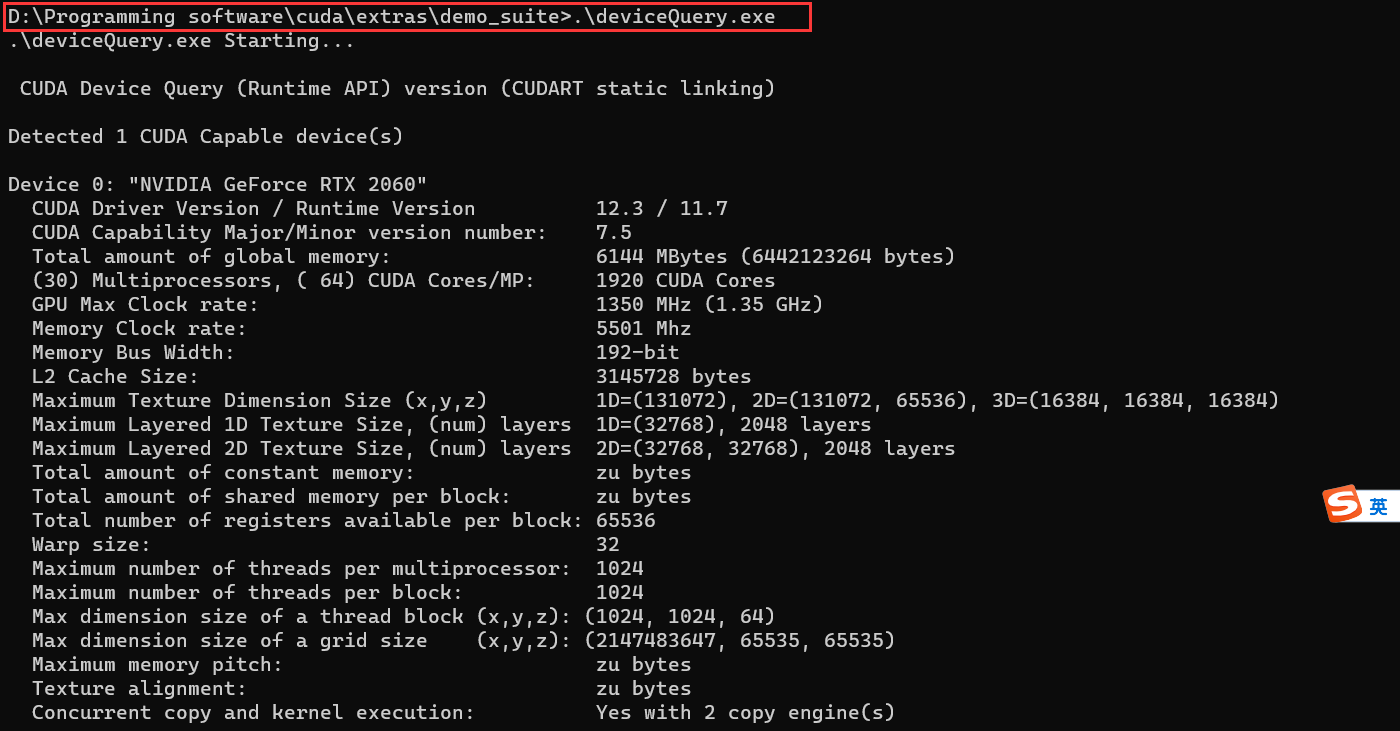

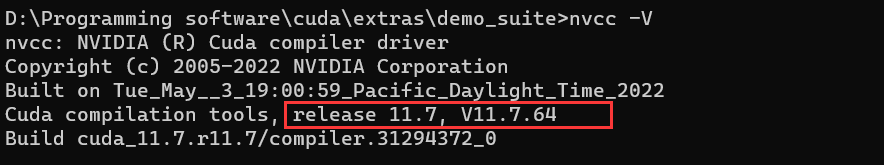

cd到安装目录下的 …\extras\demo_suite,然后分别执行bandwidthTest.exe和deviceQuery.exe(进到目录后需要直接输“bandwidthTest.exe”和“deviceQuery.exe”),得到下图:

至此,安装结束。

yolov8上使用gpu

1.新创建conda虚拟环境,yolov8_conda。

conda create -n yolov8_conda pyhton=3.10

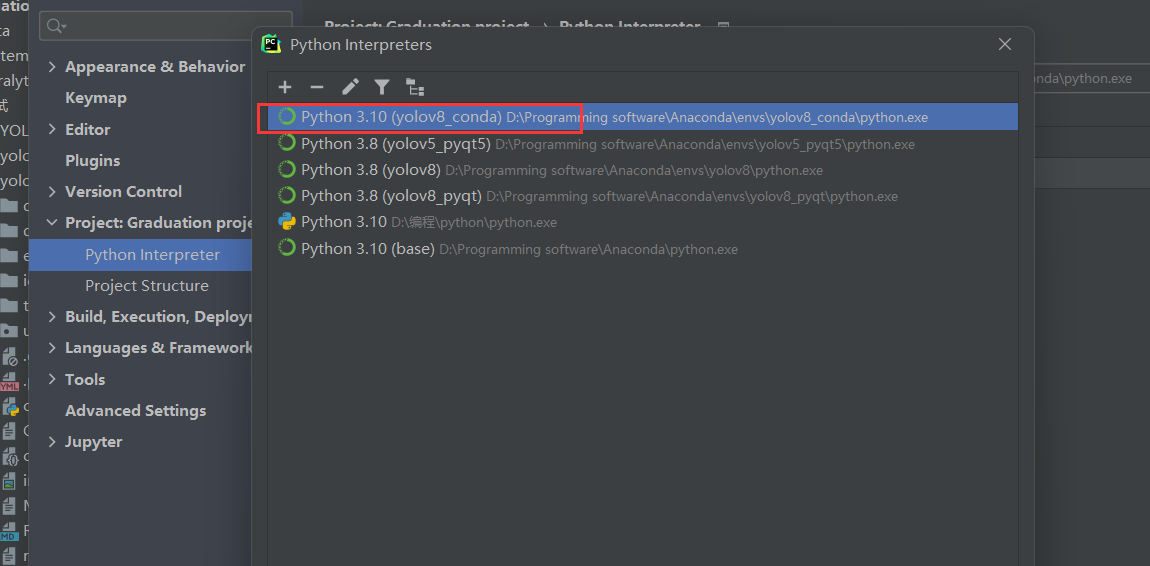

2.别忘了pycharm中也要切换刚创建的环境

3.进入虚拟环境,下载安装yolov8所需依赖

activate yolov8_conda

pip install ultralytics

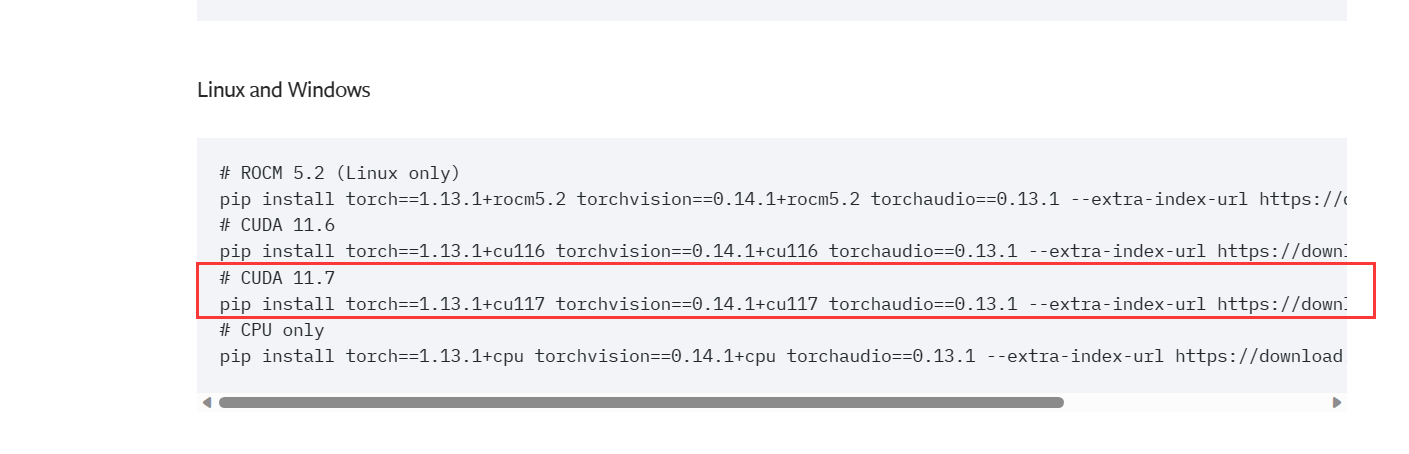

4.下载对应gpu版本的torch

我这里cuda版本是11.7

去pytorch官网,下载对应的版本。最好下载cu+的,pip命令的。因为下其他的我不知道为什么失败了。

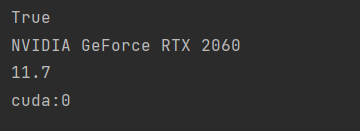

5.测试gpu,为True即可。

import torch

# 检查torch是否有CUDA支持,即是否能用GPU

print(torch.cuda.is_available())

# 如果CUDA可用,它还会打印出当前默认的CUDA设备(通常是第一个GPU)

if torch.cuda.is_available():

print(torch.cuda.get_device_name(0))

print(torch.version.cuda)

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

print(device)