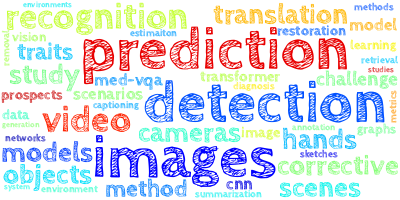

AI视野·今日CS.CV 计算机视觉论文速览

Thu, 11 Jan 2024

Totally 50 papers

👉上期速览✈更多精彩请移步主页

Daily Computer Vision Papers

| Towards Online Sign Language Recognition and Translation Authors Ronglai Zuo, Fangyun Wei, Brian Mak 手语识别的目标是弥合聋哑人和听力正常者之间的沟通差距。之前的许多工作都使用完善的联结主义时间分类 CTC 损失来训练他们的模型。在推理阶段,基于 CTC 的模型通常将整个标志视频作为输入来进行预测。这种类型的推理方案称为离线识别。相比之下,虽然成熟的语音识别系统可以有效地即时识别口语单词,但由于缺乏实用的在线解决方案,手语识别仍然存在不足。在这项工作中,我们迈出了填补这一空白的第一步。我们的方法包括三个阶段: 1 开发包含目标手语数据集中存在的所有注释的手语词典 2 使用传统分类损失和我们新颖的显着性损失来训练增强符号上的孤立手语识别模型 3 在输入符号序列并将每个符号片段输入到优化良好的模型中进行在线识别。此外,我们的在线识别模型可以扩展以提高任何离线模型的性能,并通过在识别模型上附加文本网络注释来支持在线翻译。通过将我们的在线框架与之前性能最佳的离线模型 TwoStream SLR 相集成,我们在 Phoenix 2014、Phoenix 2014T 和 CSL Daily 三个基准测试中实现了最先进的性能。 |

| InseRF: Text-Driven Generative Object Insertion in Neural 3D Scenes Authors Mohamad Shahbazi, Liesbeth Claessens, Michael Niemeyer, Edo Collins, Alessio Tonioni, Luc Van Gool, Federico Tombari 我们介绍 InseRF,这是一种在 3D 场景的 NeRF 重建中生成对象插入的新方法。基于用户提供的文本描述和参考视点中的 2D 边界框,InseRF 在 3D 场景中生成新对象。最近,由于在 3D 生成建模中使用了文本到图像扩散模型的强先验,3D 场景编辑方法已经发生了深刻的转变。现有方法在通过样式和外观更改或删除现有对象来编辑 3D 场景时最有效。然而,生成新对象仍然是此类方法的一个挑战,我们在本研究中解决了这个问题。具体来说,我们建议将 3D 对象插入基础为场景参考视图中的 2D 对象插入。然后使用单视图对象重建方法将 2D 编辑提升为 3D。然后,在单目深度估计方法的先验指导下,将重建的对象插入场景中。我们在各种 3D 场景上评估我们的方法,并对所提出的组件进行深入分析。我们在多个 3D 场景中生成对象插入的实验表明,与现有方法相比,我们的方法是有效的。 InseRF 能够进行可控且 3D 一致的对象插入,而不需要明确的 3D 信息作为输入。 |

| URHand: Universal Relightable Hands Authors Zhaoxi Chen, Gyeongsik Moon, Kaiwen Guo, Chen Cao, Stanislav Pidhorskyi, Tomas Simon, Rohan Joshi, Yuan Dong, Yichen Xu, Bernardo Pires, He Wen, Lucas Evans, Bo Peng, Julia Buffalini, Autumn Trimble, Kevyn McPhail, Melissa Schoeller, Shoou I Yu, Javier Romero, Michael Zollh fer, Yaser Sheikh, Ziwei Liu, Shunsuke Saito 现有的真实感可重复照明手部模型需要在不同的视图、姿势和照明下进行广泛的特定于身份的观察,并且在推广到自然照明和新颖的身份方面面临挑战。为了弥补这一差距,我们推出了 URHand,这是第一个通用的可重新照明的手模型,它概括了视角、姿势、照明和身份。我们的模型允许使用手机拍摄的图像进行很少的镜头个性化,并且可以在新颖的照明下进行照片级真实感渲染。为了简化个性化过程,同时保留照片真实感,我们基于在具有数百个身份的光舞台中捕获的手部多视图图像的神经重新照明,构建了一个强大的通用可重新照明先验。关键的挑战是扩展跨身份训练,同时保持个性化的保真度和清晰的细节,而不影响自然照明下的泛化能力。为此,我们提出了一种空间变化的线性光照模型作为神经渲染器,它将物理启发的着色作为输入特征。通过消除非线性激活和偏差,我们专门设计的照明模型明确地保持了光传输的线性。这使得能够从光阶段数据进行单阶段训练,同时推广到跨不同身份的任意连续照明下的实时渲染。此外,我们引入了基于物理的模型和神经重新照明模型的联合学习,这进一步提高了保真度和泛化能力。大量的实验表明,我们的方法在质量和通用性方面都优于现有方法。 |

| Enhanced Muscle and Fat Segmentation for CT-Based Body Composition Analysis: A Comparative Study Authors Benjamin Hou, Tejas Sudharshan Mathai, Jianfei Liu, Christopher Parnell, Ronald M. Summers 目的 通过常规腹部 CT 进行身体成分测量,可以对无症状和患病患者进行个性化风险评估。特别是,肌肉和脂肪的衰减和体积测量与重要的临床结果相关,例如心血管事件、骨折和死亡。 |

| Score Distillation Sampling with Learned Manifold Corrective Authors Thiemo Alldieck, Nikos Kolotouros, Cristian Sminchisescu 分数蒸馏采样 SDS 是一种最近但已经广泛流行的方法,它依靠图像扩散模型使用文本提示来控制优化问题。在本文中,我们对 SDS 损失函数进行了深入分析,确定了其公式的固有问题,并提出了一种非常简单但有效的解决方案。具体来说,我们将损失分解为不同的因素,并隔离导致噪声梯度的成分。在最初的配方中,使用高文本指导来解决噪音,从而导致不必要的副作用。相反,我们训练一个浅层网络来模仿图像扩散模型的时间步相关的去噪缺陷,以便有效地将其分解出来。 |

| PIXART-δ: Fast and Controllable Image Generation with Latent Consistency Models Authors Junsong Chen, Yue Wu, Simian Luo, Enze Xie, Sayak Paul, Ping Luo, Hang Zhao, Zhenguo Li 本技术报告介绍了 PIXART delta ,这是一种文本到图像合成框架,它将潜在一致性模型 LCM 和 ControlNet 集成到先进的 PIXART alpha 模型中。 PIXART alpha 因其通过非常高效的训练过程生成 1024 像素分辨率的高质量图像的能力而受到认可。 PIXART delta 中 LCM 的集成显着加快了推理速度,只需 2 4 个步骤即可生成高质量图像。值得注意的是,PIXART delta 生成 1024x1024 像素图像的时间突破了 0.5 秒,比 PIXART alpha 提高了 7 倍。此外,PIXART delta 设计为可在一天内在 32GB V100 GPU 上进行高效训练。凭借其 8 位推理能力 von Platen 等人,2023,PIXART delta 可以在 8GB GPU 内存限制内合成 1024px 图像,大大增强了其可用性和可访问性。此外,合并类似 ControlNet 的模块可以对文本到图像扩散模型进行细粒度控制。我们引入了一种新颖的 ControlNet Transformer 架构,专为 Transformer 量身定制,可在生成高质量图像的同时实现明确的可控性。 |

| Structure from Duplicates: Neural Inverse Graphics from a Pile of Objects Authors Tianhang Cheng, Wei Chiu Ma, Kaiyu Guan, Antonio Torralba, Shenlong Wang 我们的世界充满了相同的物体,例如,可乐罐、相同型号的汽车。当将这些重复项放在一起查看时,它们为我们有效地推理 3D 提供了额外且强有力的线索。受这一观察的启发,我们引入了 Structure from Duplicates SfD ,这是一种新颖的逆向图形框架,可以从包含多个相同对象的单个图像中重建几何形状、材质和照明。 |

| Measuring Natural Scenes SFR of Automotive Fisheye Cameras Authors Daniel Jakab, Eoin Martino Grua, Brian Micheal Deegan, Anthony Scanlan, Pepijn Van De Ven, Ciar n Eising 调制传递函数 MTF 是汽车领域通常使用的重要图像质量指标。然而,尽管光学质量对车辆自动化中计算机视觉的性能有影响,但对于许多公共数据集来说,这个指标是未知的。此外,宽视场 FOV 相机已变得越来越流行,特别是对于低速车辆自动化应用。 |

| Exploring Vulnerabilities of No-Reference Image Quality Assessment Models: A Query-Based Black-Box Method Authors Chenxi Yang, Yujia Liu, Dingquan Li, Tingting jiang 无参考图像质量评估 NR IQA 旨在预测与人类感知一致的图像质量分数,而不依赖原始参考图像,作为各种视觉任务的关键组成部分。确保 NR IQA 方法的稳健性对于不同图像处理技术的可靠比较和推荐中一致的用户体验至关重要。 NR IQA 的攻击方法为测试 NR IQA 的鲁棒性提供了有力的工具。然而,目前的NR IQA攻击方法严重依赖NR IQA模型的梯度,导致在梯度信息不可用时受到限制。在本文中,我们提出了一种针对 NR IQA 方法的开创性的基于查询的黑盒攻击。我们提出了 emph 分数边界的概念,并利用具有多个分数边界的自适应迭代方法。同时,最初的攻击方向也是利用人类视觉系统HVS的特性来设计的。实验表明,我们的攻击方法优于所有比较的最先进方法,并且远远领先于以前的黑盒方法。有效的 DBCNN 模型在我们的方法的攻击下,Spearman 排序相关系数 SROCC 下降了 0.6972,揭示了 NR IQA 对黑盒攻击的脆弱性。 |

| Video-based Automatic Lameness Detection of Dairy Cows using Pose Estimation and Multiple Locomotion Traits Authors Helena Russello, Rik van der Tol, Menno Holzhauer, Eldert J. van Henten, Gert Kootstra 这项研究提出了一种自动跛行检测系统,该系统使用深度学习图像处理技术来提取与跛行相关的多种运动特征。使用T LEAP姿势估计模型,从牛行走的视频中提取了九个关键点的运动。视频是在户外录制的,光照条件各异,T LEAP 提取了 99.6 个正确的关键点。然后使用关键点的轨迹来计算六个运动特征:背部姿势测量、头部摆动、跟踪距离、步幅、站立持续时间和摆动持续时间。三个最重要的特征是背部姿势测量、头部摆动和跟踪距离。对于基本事实,我们表明,对观察者分数进行深思熟虑的合并可以提高观察者内部的可靠性和一致性。 |

| CLIP-guided Source-free Object Detection in Aerial Images Authors Nanqing Liu, Xun Xu, Yongyi Su, Chengxin Liu, Peiliang Gong, Heng Chao Li 域适应在航空图像中至关重要,因为这些图像的视觉表示可能会根据地理位置、时间和天气条件等因素而发生显着变化。此外,高分辨率航拍图像通常需要大量存储空间,并且公众可能无法轻松访问。为了解决这些挑战,我们提出了一种新颖的无源对象检测 SFOD 方法。具体来说,我们的方法是建立在自我训练框架之上的,但是,在没有标记的训练数据的情况下,自我训练可能会导致学习不准确。为了解决这个问题,我们进一步集成对比语言图像预训练 CLIP 来指导伪标签的生成,称为 CLIP 引导聚合。通过利用 CLIP 的零样本分类功能,我们用它来聚合原始预测边界框的分数,使我们能够获得伪标签的精确分数。为了验证我们方法的有效性,我们基于 DIOR 数据集构建了两个来自不同领域的新数据集,分别命名为 DIOR C 和 DIOR Cloudy。 |

| Watermark Text Pattern Spotting in Document Images Authors Mateusz Krubinski, Stefan Matcovici, Diana Grigore, Daniel Voinea, Alin Ionut Popa 文档图像中的水印文本识别可以提供对经常未被探索的信息源的访问,提供有关记录范围、受众甚至有时甚至真实性的重要证据。由于文本识别、检测和理解文档中的水印的问题在野外也面临同样的困难,书写可以有各种字体、大小和形式,这使得通用识别成为一个非常困难的问题。为了解决该领域资源的缺乏并推动进一步的研究,我们提出了一个新的基准 K Watermark,其中包含使用 Wrender(一种水印文本模式渲染程序)生成的 65,447 个数据样本。使用人类评分者进行的有效性研究相对于预先生成的带水印的文档得出了 0.51 的真实性得分。为了证明数据集和渲染技术的有用性,我们开发了一种端到端解决方案 Wextract,用于检测水印文本的边界框实例,同时预测所描绘的文本。为了处理这个特定任务,我们引入了方差最小化损失和分层自注意力机制。 |

| REACT 2024: the Second Multiple Appropriate Facial Reaction Generation Challenge Authors Siyang Song, Micol Spitale, Cheng Luo, Cristina Palmero, German Barquero, Hengde Zhu, Sergio Escalera, Michel Valstar, Tobias Baur, Fabien Ringeval, Elisabeth Andre, Hatice Gunes 在二元互动中,人类使用言语和非言语暗示来传达他们的意图和精神状态,其中多种不同的面部反应可能适合响应特定的说话者行为。那么,如何开发一种机器学习 ML 模型,能够根据以前未见过的说话者行为自动生成多种适当的、多样化的、真实的、同步的人类面部反应,是一项具有挑战性的任务。继首届 REACT 挑战赛 REACT 2023 成功组织之后,本次挑战赛 REACT 2024 采用了上一挑战赛使用的子集,其中包含最初记录为 NOXI 和 RECOLA 数据集一部分的分段 30 秒二元交互剪辑,鼓励参与者开发和基准测试机器学习 ML 模型,该模型可以在各种二元视频会议场景下,根据输入对话伙伴的刺激,生成多种适当的面部反应,包括面部图像序列及其属性。本文介绍了 REACT 2024 挑战的指南、挑战中使用的数据集以及基线系统分别在两个拟议子挑战“离线多重适当面部反应生成”和“在线多重适当面部反应生成”上的性能。 |

| MISS: A Generative Pretraining and Finetuning Approach for Med-VQA Authors Jiawei Chen, Dingkang Yang, Yue Jiang, Yuxuan Lei, Lihua Zhang 医学视觉问答VQA是一项具有挑战性的多模态任务,其中视觉语言预训练VLP模型可以有效提高泛化性能。然而,医学领域的大多数方法将VQA视为答案分类任务,很难迁移到实际应用场景。此外,由于医学图像的隐私性和昂贵的注释过程,严重缺乏用于预训练的大规模医学图像文本对数据集。在本文中,我们提出了一种用于医疗 VQA 任务的基于大规模多任务自监督学习的框架 MISS。与现有方法不同,我们将医学 VQA 视为一项生成任务。我们统一文本编码器和多模态编码器,并通过多任务学习对齐图像文本特征。此外,我们提出了一种传输和描述方法,该方法使用大型语言模型 LLM 扩展单模态图像数据集的特征空间,使这些传统的医学视觉领域任务数据能够应用于 VLP。实验表明,我们的方法用较少的多模态数据集取得了优异的结果,并展示了生成式 VQA 模型的优势。 |

| Derm-T2IM: Harnessing Synthetic Skin Lesion Data via Stable Diffusion Models for Enhanced Skin Disease Classification using ViT and CNN Authors Muhammad Ali Farooq, Wang Yao, Michael Schukat, Mark A Little, Peter Corcoran 本研究探索利用通过稳定扩散模型生成的皮肤镜合成数据作为增强机器学习模型训练稳健性的策略。合成数据生成在缓解与有限标记数据集相关的挑战方面发挥着关键作用,从而促进更有效的模型训练。在这种背景下,我们的目标是通过将最近成功的少量镜头学习和文本中的少量数据表示扩展到图像潜在扩散模型来结合增强的数据转换技术。经过优化调整的模型进一步用于渲染具有多样化和真实特征的高质量皮肤病变合成数据,为现有训练数据提供了有价值的补充和多样性。我们研究了将新生成的合成数据纳入最先进的机器学习模型的训练流程中的影响,评估其在增强模型性能和对未见过的现实世界数据的泛化方面的有效性。 |

| Toward distortion-aware change detection in realistic scenarios Authors Yitao Zhao, Heng Chao Li, Nanqing Liu, Rui Wang 在传统的变化检测CD管道中,两个手动注册和标记的遥感数据集作为训练和预测模型的输入。然而,在现实场景中,由于坐标系不同,来自不同时期或传感器的数据可能无法对齐。坐标偏移引起的几何畸变仍然是 CD 算法的棘手问题。在本文中,我们提出了一种可重用的自监督框架,用于 CD 任务中的双时态几何失真。整个框架由借口表示预训练、双时图像对齐和下游解码器微调组成。只需单阶段预训练,框架的关键组件就可以重复使用以帮助双时图像对齐,同时增强 CD 解码器的性能。 |

| CrossDiff: Exploring Self-Supervised Representation of Pansharpening via Cross-Predictive Diffusion Model Authors Yinghui Xing, Litao Qu, ShiZhou Zhang, Xiuwei Zhang, Yanning Zhang 全色PAN图像和相应的多光谱MS图像的融合也称为全色锐化,其目的是将PAN丰富的空间细节和MS的光谱信息结合起来。由于缺乏高分辨率 MS 图像,可用的基于深度学习的方法通常遵循降低分辨率训练以及降低分辨率和全分辨率测试的范式。当以原始 MS 和 PAN 图像作为输入时,由于尺度变化,它们总是获得次优结果。在本文中,我们建议通过设计一个名为 CrossDiff 的交叉预测扩散模型来探索全色锐化的自监督表示。它有两个阶段的训练。在第一阶段,我们引入交叉预测借口任务来预训练基于条件DDPM的UNet结构,而在第二阶段,UNet的编码器被冻结以直接从PAN和MS中提取空间和光谱特征,并且仅融合头经过训练以适应全色锐化任务。大量的实验表明,与最先进的监督和无监督方法相比,所提出的模型的有效性和优越性。此外,跨传感器实验还验证了所提出的自监督表示学习器对其他卫星数据集的泛化能力。 |

| Efficient Fine-Tuning with Domain Adaptation for Privacy-Preserving Vision Transformer Authors Teru Nagamori, Sayaka Shiota, Hitoshi Kiya 我们提出了一种使用 Vision Transformer ViT 保护深度神经网络 DNN 隐私的新方法。该方法不仅使我们能够使用受视觉保护的图像来训练模型和进行测试,而且还可以避免由于使用加密图像而导致的性能下降,而传统方法无法避免图像加密的影响。域适应方法用于有效地微调 ViT 和加密图像。 |

| SwiMDiff: Scene-wide Matching Contrastive Learning with Diffusion Constraint for Remote Sensing Image Authors Jiayuan Tian, Jie Lei, Jiaqing Zhang, Weiying Xie, Yunsong Li 随着航空航天技术的最新进步,未标记的遥感图像RSI数据量急剧增加。通过自我监督学习 SSL 有效利用这些数据在遥感领域至关重要。然而,当前的方法,特别是对比学习 CL(一种领先的 SSL 方法),在该领域遇到了特定的挑战。首先,CL经常错误地将具有相似语义内容的地理上相邻的样本识别为负对,导致模型训练过程中的混乱。其次,作为实例级判别任务,它往往忽略非结构化 RSI 固有的细粒度特征和复杂细节。为了克服这些障碍,我们引入了 SwiMDiff,这是一种专为 RSI 设计的新型自监督预训练框架。 SwiMDiff 采用场景范围匹配方法,可以有效地重新校准标签,以将来自同一场景的数据识别为漏报。这一调整使 CL 更适用于遥感的细微差别。此外,SwiMDiff 将 CL 与扩散模型无缝集成。通过实施像素级扩散约束,我们增强了编码器更全面地捕获图像的全局语义信息和细粒度特征的能力。我们提出的框架显着丰富了遥感下游任务可用的信息。 |

| Application of Deep Learning in Blind Motion Deblurring: Current Status and Future Prospects Authors Yawen Xiang, Heng Zhou, Chengyang Li, Fangwei Sun, Zhongbo Li, Yongqiang Xie 运动去模糊是计算机视觉的基本问题之一,受到持续关注。图像内部和图像之间的模糊变化对依赖于估计模糊内核的非盲去模糊技术施加了限制。作为回应,盲运动去模糊应运而生,旨在在深度学习方法进步的推动下,在不事先了解模糊类型的情况下恢复清晰详细的图像。尽管该领域取得了长足的进步,但基于深度学习的盲运动去模糊的最新进展的全面综合仍然明显缺乏。本文通过详尽概述深度学习在盲运动去模糊中的作用(包括过去六年开发的数据集、评估指标和方法)来填补这一空白。具体来说,我们首先介绍运动模糊的类型和去模糊的基本原理。接下来,我们概述了传统非盲去模糊算法的缺点,强调了采用深度学习技术进行去模糊任务的优势。接下来,我们根据不同的骨干网络对现有的盲运动去模糊方法进行分类和总结,包括卷积神经网络、生成对抗网络、循环神经网络和 Transformer 网络。随后,我们不仅阐述了这些不同类别的基本原理,还对它们的优点和局限性进行了全面的总结和比较。在四个广泛使用的数据集上进行的定性和定量实验结果进一步比较了 SOTA 方法的性能。最后,分析当前的挑战和未来的路径。 |

| Content-Aware Depth-Adaptive Image Restoration Authors Tom Richard Vargis, Siavash Ghiasvand 这项工作优先考虑构建一个模块化管道,利用现有模型系统地恢复图像,而不是从头开始创建新的恢复模型。恢复是在对象特定级别进行的,每个对象使用其相应的类标签信息重新生成。该方法的突出之处在于为用户提供了对整个恢复过程的完全控制。用户可以选择专门的恢复步骤的模型,自定义步骤顺序以满足他们的需求,并通过深度感知来细化生成的再生图像。该研究提供了两种不同的实现图像再生的途径,可以比较它们各自的优点和局限性。这个多功能系统最引人注目的方面是它的适应性。 |

| AdvMT: Adversarial Motion Transformer for Long-term Human Motion Prediction Authors Sarmad Idrees, Jongeun Choi, Seokman Sohn 为了在共享环境中实现机器人和人类之间的无缝协作,准确预测未来的人类运动至关重要。传统上,人体运动预测被视为序列预测问题,利用历史人体运动数据来估计未来的姿势。从普通的循环网络开始,研究界研究了各种学习人体运动动力学的方法,包括基于图的方法和生成方法。尽管做出了这些努力,实现准确的长期预测仍然是一个重大挑战。在这方面,我们提出了对抗性运动变换器 AdvMT,这是一种集成了基于变换器的运动编码器和时间连续性鉴别器的新颖模型。这种组合有效地在帧内同时捕获空间和时间依赖性。通过对抗性训练,我们的方法有效地减少了预测中不需要的伪影,从而确保学习更真实、更流畅的人体动作。 |

| Source-Free Cross-Modal Knowledge Transfer by Unleashing the Potential of Task-Irrelevant Data Authors Jinjing Zhu, Yucheng Chen, Lin Wang 无源跨模态知识转移是一项至关重要但具有挑战性的任务,其目的是将知识从单一源模态(例如 RGB)转移到目标模态(例如深度或红外),但由于内存和隐私问题而无法访问任务相关的 TR 源数据。最近的一项尝试利用与任务无关的 TI 数据进行配对,并直接匹配其中的特征以消除模态差距。然而,它忽略了一个关键线索,即配对的 TI 数据可用于有效估计源数据分布并更好地促进知识向目标模态的迁移。为此,我们提出了一个新颖而简洁的框架来释放配对 TI 数据的潜力,以增强无源跨模式知识转移。我们的工作由两个关键技术组成部分支撑。首先,为了更好地估计源数据分布,我们引入了任务无关数据引导模态桥接 TGMB 模块。它基于配对 TI 数据和可用源模型的指导,将目标模态数据(例如红外)转换为源(如 RGB 图像),以缓解两个关键差距 1 配对 TI 数据之间的模态间间隙 2 TI 和 TR 之间的模态内间隙目标数据。然后,我们提出了一个与任务无关的数据引导知识转移 TGKT 模块,该模块通过利用配对的 TI 数据将知识从源模型转移到目标模型。值得注意的是,由于 TR 目标数据的标签不可用,并且源模型的预测不太可靠,我们的 TGKT 模型采用了自我监督的伪标签方法,使目标模型能够从其预测中学习。 |

| Dual-Perspective Knowledge Enrichment for Semi-Supervised 3D Object Detection Authors Yucheng Han, Na Zhao, Weiling Chen, Keng Teck Ma, Hanwang Zhang 半监督 3D 对象检测是一个有前途但尚未探索的方向,可降低数据注释成本,尤其是对于杂乱的室内场景。一些先前的工作,例如 SESS 和 3DIoUMatch,试图通过利用教师模型为未标记的样本生成伪标签来解决此任务。然而,由于收集 3D 数据需要付出更大的努力,因此与 2D 领域相比,3D 领域中未标记样本的可用性相对有限。此外,SESS 中的松散一致性正则化和 3DIoUMatch 中的受限伪标签选择策略导致低质量监督或有限数量的伪标签。为了解决这些问题,我们提出了一种新颖的双视角知识丰富方法,称为 DPKE,用于半监督 3D 对象检测。我们的DPKE从数据角度和特征角度两个角度丰富了有限训练数据,特别是未标记数据的知识。具体来说,从数据的角度来看,我们提出了一种类概率数据增强方法,该方法根据类概率的变化分布使用额外的实例来增强输入数据。我们的 DPKE 通过设计一种几何感知特征匹配方法来实现特征透视知识丰富,该方法可以规范学生模型和教师模型的对象建议之间的特征级别相似性。对两个基准数据集的广泛实验表明,我们的 DPKE 在各种标签比率条件下比现有的最先进方法实现了卓越的性能。 |

| Less is More : A Closer Look at Multi-Modal Few-Shot Learning Authors Chunpeng Zhou, Haishuai Wang, Xilu Yuan, Zhi Yu, Jiajun Bu Few shot Learning 旨在利用数量非常有限的可用图像来学习和区分新类别,这在深度学习领域提出了重大挑战。最近的研究人员试图利用这些罕见类别的额外文本或语言信息与预先训练的语言模型来促进学习,从而部分缓解监督信号不足的问题。然而,迄今为止,在少数镜头学习中,文本信息和预训练语言模型的全部潜力被低估,导致性能提升有限。为了解决这个问题,我们为少量镜头学习任务提出了一个简单但有效的框架,专门设计用于利用文本信息和语言模型。更详细地说,我们通过可学习的提示明确地利用了预训练语言模型的零样本功能。我们只是将视觉特征与文本特征直接相加进行推理,而不需要像之前的作品那样复杂地设计融合模块。此外,我们应用自集成和蒸馏来进一步增强这些组件。我们在四个广泛使用的少量镜头数据集上进行的广泛实验表明,我们的简单框架取得了令人印象深刻的结果。特别值得关注的是它在 1 shot 学习任务中的出色表现,在分类精度方面平均超过最先进的方法 3.0。脚注 我们将在接受后公开拟议框架的源代码。 |

| Optimising Graph Representation for Hardware Implementation of Graph Convolutional Networks for Event-based Vision Authors Kamil Jeziorek, Piotr Wzorek, Krzysztof Blachut, Andrea Pinna, Tomasz Kryjak 基于事件的视觉是一个新兴的研究领域,涉及处理动态视觉传感器神经形态相机生成的数据。该领域的最新提议之一是图卷积网络 GCN,它允许以原始稀疏形式处理事件,同时保持较高的检测和分类性能。在本文中,我们考虑了 FPGA 的优点和局限性,介绍了从事件摄像机数据流生成图形的硬件实现过程。我们提出了各种方法来简化图形表示并使用值的缩放和量化。我们考虑使用 PointNet 卷积的无向图和有向图。获得的结果表明,通过适当修改图表示,可以创建用于图生成的硬件模块。 |

| MGNet: Learning Correspondences via Multiple Graphs Authors Luanyuan Dai, Xiaoyu Du, Hanwang Zhang, Jinhui Tang 学习对应关系的目的是从对应分布不均匀且内点率较低的初始对应集中找到正确的对应内点,可以将其视为图数据。最近的进展通常使用图神经网络 GNN 来构建单一类型的图,或者简单地将局部图堆叠到全局图中来完成任务。但他们忽略了不同类型图之间的互补关系,而这种关系可以有效捕获稀疏对应关系之间的潜在关系。为了解决这个问题,我们提出 MGNet 来有效地组合多个互补图。为了获得集成隐式和显式局部图的信息,我们从隐式和显式方面构建局部图,并将它们有效地结合起来,用于构建全局图。此外,我们提出了图软度注意力GSDA,以充分利用全局图中的所有稀疏对应信息,可以捕获和放大判别性特征。大量实验表明 MGNet 在不同的视觉任务中优于最先进的方法。 |

| HaltingVT: Adaptive Token Halting Transformer for Efficient Video Recognition Authors Qian Wu, Ruoxuan Cui, Yuke Li, Haoqi Zhu 视频中的动作识别由于其高计算成本而提出了挑战,特别是对于联合时空视频转换器 Joint VT 而言。尽管它们很有效,但此类架构中过多的代币极大地限制了它们的效率。在本文中,我们提出了 HaltingVT,一种高效的视频转换器,可自适应删除冗余视频补丁标记,它主要由 Joint VT 和 Glimpser 模块组成。具体来说,HaltingVT 在每一层应用数据自适应令牌缩减,从而显着降低总体计算成本。此外,Glimpser 模块可以快速删除浅层转换器层中的冗余标记,根据我们的观察,这甚至可能会误导视频识别任务。为了进一步鼓励 HaltingVT 关注视频中的关键运动相关信息,我们在训练期间设计了有效的运动损失。 HaltingVT 在统一的训练过程中同时获得视频分析能力和令牌停止压缩策略,无需额外的训练过程或子网络。在 Mini Kinetics 数据集上,我们以 24.2 GFLOPs 实现了 75.0 top 1 ACC,并以极低的 9.9 GFLOPs 实现了 67.2 top 1 ACC。 |

| Large Model based Sequential Keyframe Extraction for Video Summarization Authors Kailong Tan, Yuxiang Zhou, Qianchen Xia, Rui Liu, Yong Chen 关键帧提取的目的是用最少的帧数总结视频的语义。本文提出了一种基于大型模型的视频摘要序列关键帧提取,称为LMSKE,它包含以下三个阶段。首先,我们使用大型模型 TransNetV21 将视频切割成连续镜头,并使用大型模型 CLIP2 生成每个镜头内的每个帧的视觉特征。 其次,我们开发一种自适应聚类算法来为每个镜头生成候选关键帧,每个镜头第三,我们通过每个镜头内的冗余消除进一步减少上述候选关键帧,最后按照镜头顺序将它们连接起来作为最终的顺序关键帧。 |

| ECC-PolypDet: Enhanced CenterNet with Contrastive Learning for Automatic Polyp Detection Authors Yuncheng Jiang, Zixun Zhang, Yiwen Hu, Guanbin Li, Xiang Wan, Song Wu, Shuguang Cui, Silin Huang, Zhen Li 准确的息肉检测对于早期结直肠癌诊断至关重要。尽管近年来取得了显着的进展,但复杂的结肠环境和边界不清晰的隐匿性息肉仍然给该领域带来严峻的挑战。现有方法要么涉及计算成本高昂的上下文聚合,要么缺乏息肉的事先建模,导致在具有挑战性的情况下表现不佳。在本文中,我们提出了具有对比学习 ECC PolypDet 的增强型 CenterNet,这是一个两阶段训练端到端推理框架,利用图像和边界框注释来训练通用模型并根据推理分数对其进行微调以获得最终的鲁棒性模型。具体来说,我们在训练期间进行 Box 辅助对比学习 BCL,以最小化类内差异并最大化前景息肉和背景之间的类间差异,使我们的模型能够捕获隐藏的息肉。此外,为了增强对小息肉的识别,我们设计了语义流引导的特征金字塔网络 SFFPN 来聚合多尺度特征,并设计了热图传播 HP 模块来提高模型对息肉目标的注意力。在微调阶段,我们引入了 IoU 引导的样本重新加权 ISR 机制,通过在微调过程中自适应调整每个样本的损失权重来优先考虑硬样本。 |

| EmMixformer: Mix transformer for eye movement recognition Authors Huafeng Qin, Hongyu Zhu, Xin Jin, Qun Song, Mounim A. El Yacoubi, Xinbo Gao 眼动EM是一种新型的高度安全的生物识别行为方式,近年来受到越来越多的关注。尽管深度神经网络(例如卷积神经网络 CNN)最近取得了可喜的性能,但当前的解决方案无法捕获眼动数据中的局部和全局时间依赖性。为了克服这个问题,我们在本文中提出了一种称为 EmMixformer 的混合变压器来提取时域和频域信息以进行眼动识别。为此,我们提出了一个由三个模块组成的混合块:变压器、注意力长期短期记忆注意力 LSTM 和傅里叶变压器。我们是第一个尝试利用 Transformer 来学习眼球运动中的长期时间依赖性的人。其次,我们将注意力机制融入到 LSTM 中,提出注意力 LSTM,旨在学习短时间依赖性。第三,我们在频域中进行自注意力以学习全局特征。由于这三个模块在局部和全局依赖性方面提供了互补的特征表示,因此所提出的 EmMixformer 能够提高识别精度。 |

| Latency-aware Road Anomaly Segmentation in Videos: A Photorealistic Dataset and New Metrics Authors Beiwen Tian, Huan ang Gao, Leiyao Cui, Yupeng Zheng, Lan Luo, Baofeng Wang, Rong Zhi, Guyue Zhou, Hao Zhao 在过去的几年里,道路异常分割在学术界得到了积极的探索,并越来越受到业界的关注。背后的原理很简单,如果自动驾驶汽车能够在撞到异常物体之前刹车,那么安全性就会得到提升。然而,这种基本原理自然需要一个临时知情的设置,而现有的方法和基准是以不切实际的框架方式设计的。为了弥补这一差距,我们贡献了第一个用于自动驾驶的视频异常分割数据集。由于将各种异常物体放置在繁忙的道路上并在每一帧中对其进行注释既危险又昂贵,因此我们求助于合成数据。为了提高这个合成数据集与现实世界应用的相关性,我们训练了一个以渲染 G 缓冲区为条件的生成对抗网络,以增强照片真实感。我们的数据集由 7 个不同城镇记录的 120,000 个 60 FPS 帧速率的高分辨率帧组成。作为初始基准测试,我们使用最新的监督和无监督道路异常分割方法提供基线。除了传统的指标之外,我们还关注两个新指标时间一致性和延迟感知流准确性。 |

| Diffusion-based Pose Refinement and Muti-hypothesis Generation for 3D Human Pose Estimaiton Authors Hongbo Kang, Yong Wang, Mengyuan Liu, Doudou Wu, Peng Liu, Xinlin Yuan, Wenming Yang 之前的 3D 人体姿势估计 3DHPE 概率模型旨在通过生成多个假设来提高姿势准确性。然而,大多数生成的假设与真实姿势有很大偏差。与确定性模型相比,概率模型过多的不确定性导致单一假设预测的性能较差。为了解决这两个挑战,我们提出了一种名为 DRPose 的基于扩散的细化框架,该框架通过反向扩散细化确定性模型的输出,并通过使用多个噪声的多步细化实现针对当前姿态基准的更合适的多假设预测。为此,我们提出了可扩展图卷积变换器 SGCT 和用于去噪和细化的姿势细化模块 PRM。对 Human3.6M 和 MPI INF 3DHP 数据集进行的大量实验表明,我们的方法在单假设和多假设 3DHPE 上均实现了最先进的性能。 |

| SnapCap: Efficient Snapshot Compressive Video Captioning Authors Jianqiao Sun, Yudi Su, Hao Zhang, Ziheng Cheng, Zequn Zeng, Zhengjue Wang, Bo Chen, Xin Yuan 视频字幕 VC 是一项具有挑战性的多模态任务,因为它需要通过理解各种复杂的视频来用语言描述场景。对于机器来说,传统的视频编码遵循图像压缩解码和字幕流水线,其中压缩是存储和传输的关键。然而,在这样的管道中,一些潜在的缺点是不可避免的,即信息冗余导致字幕采样过程中的效率低下和信息丢失。为了解决这些问题,在本文中,我们提出了一种新颖的 VC 管道,直接从压缩测量生成字幕,该字幕可以由快照压缩传感相机捕获,我们将我们的模型称为 SnapCap。更具体地说,受益于信号模拟,我们可以为我们的模型获得丰富的测量视频注释数据对。此外,为了更好地从压缩测量中提取与语言相关的视觉表示,我们建议通过预先训练的 CLIP 从视频中提取知识,并具有丰富的语言视觉关联,以指导 SnapCap 的学习。为了证明 SnapCap 的有效性,我们在两个广泛使用的 VC 数据集上进行了实验。定性和定量结果都验证了我们的管道相对于传统 VC 管道的优越性。 |

| Knowledge-aware Graph Transformer for Pedestrian Trajectory Prediction Authors Yu Liu, Yuexin Zhang, Kunming Li, Yongliang Qiao, Stewart Worrall, You Fu Li, He Kong 预测行人运动轨迹对于自动驾驶车辆的路径规划和运动控制至关重要。由于不同环境中人体运动的不确定性,准确预测人群轨迹具有挑战性。对于训练,最近基于深度学习的预测方法主要利用轨迹历史和行人之间的交互等信息。由于训练数据集之间的差异尚未正确纳入,这可能会限制各种场景的预测性能。为了克服这一限制,本文提出了一种图转换器结构来提高预测性能,捕获数据集中包含的各个站点和场景之间的差异。特别是,设计了自注意力机制和领域适应模块来提高模型的泛化能力。此外,出于训练和性能评估目的,引入了考虑跨数据集序列的附加度量。使用流行的公共数据集(即 ETH 和 UCY)对所提出的框架进行了验证并与现有方法进行了比较。 |

| CTNeRF: Cross-Time Transformer for Dynamic Neural Radiance Field from Monocular Video Authors Xingyu Miao, Yang Bai, Haoran Duan, Yawen Huang, Fan Wan, Yang Long, Yefeng Zheng 我们工作的目标是从复杂和动态场景的单眼视频中生成高质量的新颖视图。先前的方法,例如 DynamicNeRF,通过利用随时间变化的动态辐射场而显示出令人印象深刻的性能。然而,这些方法在精确建模复杂物体的运动时存在局限性,这可能导致细节渲染不准确和模糊。为了解决这个限制,我们提出了一种基于最近的泛化 NeRF 的新方法,它将附近的视图聚合到新的观点上。然而,此类方法通常仅对静态场景有效。为了克服这一挑战,我们引入了一个在时域和频域中运行的模块来聚合对象运动的特征。这使我们能够学习帧之间的关系并生成更高质量的图像。我们的实验证明了动态场景数据集上最先进方法的显着改进。 |

| Modality-Aware Representation Learning for Zero-shot Sketch-based Image Retrieval Authors Eunyi Lyou, Doyeon Lee, Jooeun Kim, Joonseok Lee 零样本学习为机器学习模型提供了一种有效的解决方案来处理看不见的类别,避免详尽的数据收集。基于零镜头草图的图像检索 ZS SBIR 模拟现实世界的场景,在这些场景中,收集配对草图照片样本既困难又昂贵。我们提出了一种新颖的框架,通过文本对比草图和照片来间接对齐草图和照片,从而消除了访问草图照片对的必要性。通过从数据中学习到的显式模态编码,我们的方法将模态不可知的语义与模态特定信息分开,弥合模态间隙并在联合潜在空间内实现有效的跨模态内容检索。 |

| Refining Remote Photoplethysmography Architectures using CKA and Empirical Methods Authors Nathan Vance, Patrick Flynn 模型架构细化是远程光电体积描记 rPPG 等深度学习研究领域的一项具有挑战性的任务。一种架构考虑因素,即模型的深度,可能会对最终的性能产生重大影响。在过度配置过多层的 rPPG 模型中,存在冗余,消除冗余可以加快训练速度并减少推理时的计算负载。如果层数太少,模型可能会表现出次优的错误率。我们将中心核对齐 CKA 应用于不同深度的 rPPG 架构阵列,证明较浅的模型不会学习与较深的模型相同的表示,并且在达到一定深度后,添加冗余层而不会显着增加功能。 |

| DedustNet: A Frequency-dominated Swin Transformer-based Wavelet Network for Agricultural Dust Removal Authors Shengli Zhang, Zhiyong Tao, Sen Lin 虽然灰尘显着影响自动化农业机械的环境感知,但现有的基于深度学习的除尘方法需要在该领域进一步研究和改进,以提高农业自动化农业机械的性能和可靠性。我们提出了一种端到端可训练学习网络 DedustNet 来解决现实世界的农业除尘任务。据我们所知,DedustNet 是首次在小波网络中使用基于 Swin Transformer 的单元来进行农业图像除尘。具体来说,我们通过向 Swin Transformer 添加空间特征聚合方案 SFAS 并将其与小波变换、DWTFormer 块和 IDWTFormer 块相结合,提出了频率主导块 DWTFormer 块和 IDWTFormer 块,减轻了 Swin 全局感受野的限制处理复杂的灰尘背景时的变压器。此外,我们提出了一个跨级信息融合模块来融合不同级别的特征并有效捕获全局和远程特征关系。此外,我们提出了一种扩张卷积模块来捕获多尺度小波变换引导的上下文信息,它结合了小波变换和扩张卷积的优点。我们的算法利用深度学习技术有效去除图像中的灰尘,同时保留原始的结构和纹理特征。与现有最先进的方法相比,DedustNet在农业图像除尘方面取得了更优越的性能和更可靠的结果,为农业机械在粉尘环境下的应用提供了有力的支持。 |

| Convolutional Neural Network Ensemble Learning for Hyperspectral Imaging-based Blackberry Fruit Ripeness Detection in Uncontrolled Farm Environment Authors Chollette C. Olisah, Ben Trewhella, Bo Li, Melvyn L. Smith, Benjamin Winstone, E. Charles Whitfield, Felicidad Fern ndez Fern ndez, Harriet Duncalfe 几十年来,水果成熟度估计模型一直依赖于光谱指数特征或基于颜色的特征,例如平均值、标准差、偏度、颜色矩和/或直方图来学习水果成熟度的特征。最近,很少有研究探索使用深度学习技术从具有可见成熟度线索的水果图像中提取特征。然而,黑莓悬钩子果实成熟时并没有表现出明显且可靠的成熟度可见特征,因此给采摘者带来了很大的困难。对于人眼来说,成熟的黑莓在成熟前、成熟中和成熟后都是黑色的。为了解决这一工程应用挑战,本文提出了一种新型多输入卷积神经网络 CNN 集成分类器,用于检测黑莓果实成熟度的细微特征。多输入 CNN 是根据在 ImageNet 数据集上训练的预训练视觉几何组 16 层深度卷积网络 VGG16 模型创建的。全连接层经过优化,可学习成熟黑莓果实的成熟度特征。由此产生的模型作为构建同质集成学习器的基础,这些学习器是使用堆栈泛化集成 SGE 框架进行集成的。网络的输入是使用波长为 700 nm 和 770 nm 的可见光和近红外 VIS NIR 光谱滤波器通过立体传感器采集的图像。通过实验,所提出的模型在未见过的集合上达到了 95.1 的准确率,在现场条件下达到了 90.2 的准确率。 |

| Content-Conditioned Generation of Stylized Free hand Sketches Authors Jiajun Liu, Siyuan Wang, Guangming Zhu, Liang Zhang, Ning Li, Eryang Gao 近年来,手绘草图的识别仍然是一项热门任务。但在军事领域等一些特殊领域,徒手草图很难大规模采样。常见的数据增强和图像生成技术很难生成具有各种手绘草图风格的图像。因此,相关领域的识别和分割任务受到限制。在本文中,我们提出了一种新颖的对抗性生成网络,可以准确生成各种风格的逼真手绘草图。我们探索了模型的性能,包括使用从先验正态分布中随机采样的样式来生成具有各种手绘草图风格的图像,将画家风格与已知的手绘草图分离以生成具有特定风格的图像,以及生成未知类别的图像不在训练集中。 |

| ANIM-400K: A Large-Scale Dataset for Automated End-To-End Dubbing of Video Authors Kevin Cai, Chonghua Liu, David M. Chan 互联网内容丰富,其中以英语发布的内容多达 60 条,这与全球人口形成鲜明对比,全球人口中只有 18.8 人以英语为母语,只有 5.1 人将英语视为自己的母语,这导致了在线信息获取的差异。不幸的是,由于管道的原因,用翻译后的替代方案替换视频音轨的视频配音自动化过程仍然是一项复杂且具有挑战性的任务,需要精确的计时、面部运动同步和韵律匹配。虽然端到端配音提供了一种解决方案,但数据稀缺仍然阻碍着端到端和基于管道的方法的进展。在这项工作中,我们介绍了 Anim 400K,这是一个包含超过 425K 对齐的日语和英语动画视频片段的综合数据集,支持各种视频相关任务,包括自动配音、同声翻译、引导视频摘要和流派主题风格分类。 |

| Strategic Client Selection to Address Non-IIDness in HAPS-enabled FL Networks Authors Amin Farajzadeh, Animesh Yadav, Halim Yanikomeroglu 在垂直异构网络(例如由高空平台站 HAPS 支持的网络)中部署联邦学习 FL,提供了吸引广泛客户的机会,每个客户都具有不同的通信和计算能力。这种多样性不仅提高了 FL 模型的训练精度,而且加速了它们的收敛。然而,在这些广阔的网络中应用 FL 会带来显着的挑战,特别是客户端数据分布中显着的非独立同分布性。这种数据异构性通常会导致收敛速度变慢并降低模型训练性能的有效性。我们的研究引入了一种针对解决此问题而定制的客户选择策略,利用用户网络流量行为。该策略涉及根据客户的网络使用模式对客户进行预测和分类,同时优先考虑用户隐私。通过战略性地选择数据表现出相似模式的客户来参与 FL 培训,我们的方法在整个网络中促进了更加统一和具有代表性的数据分布。 |

| DISCOVER: 2-D Multiview Summarization of Optical Coherence Tomography Angiography for Automatic Diabetic Retinopathy Diagnosis Authors Mostafa El Habib Daho, Yihao Li, Rachid Zeghlache, Hugo Le Boit , Pierre Deman, Laurent Borderie, Hugang Ren, Niranchana Mannivanan, Capucine Lepicard, B atrice Cochener, Aude Couturier, Ramin Tadayoni, Pierre Henri Conze, Mathieu Lamard, Gwenol Quellec 糖尿病视网膜病变 DR 是糖尿病的一种眼部并发症,是全球失明的主要原因。传统上,DR 使用彩色眼底摄影 CFP(一种广泛使用的 2D 成像方式)进行监测。然而,基于CFP的DR分类预测能力较差,导致DR管理不理想。光学相干断层扫描血管造影 OCTA 是一种最新的 3D 成像方式,可提供增强的血流结构和功能信息以及更宽的视野。本文研究了使用 3 D OCTA 进行自动 DR 严重性评估。此任务的一个直接解决方案是 3D 神经网络分类器。然而,3D 架构具有大量参数,通常需要大量训练样本。更轻的解决方案包括使用 2D 神经网络分类器处理 2D 正面或正面投影和/或 2D 横截面切片。这种方法模仿了眼科医生分析 OCTA 采集的方式,例如,1 个面部血流图通常用于检测无血管区域和新血管形成,并且通常分析 2 个横截面切片以检测黄斑水肿。然而,任意的数据缩减或选择可能会导致信息丢失。因此,提出了两种互补策略,以通过 2D 图像最佳地总结 OCTA 体积:1 通过深度学习优化的参数化正面投影,2 通过基于梯度的归因控制的横截面切片选择过程。完整的摘要和 DR 分类管道是端到端训练的。自动二维摘要可以显示在查看器中或打印在报告中以支持决策。 |

| Inconsistency-Based Data-Centric Active Open-Set Annotation Authors Ruiyu Mao, Ouyang Xu, Yunhui Guo 主动学习是一种常用的方法,可以减少训练深度神经网络所需的标记工作。然而,当前主动学习方法的有效性受到其封闭世界假设的限制,该假设假设未标记池中的所有数据都来自一组预定义的已知类。这种假设在实际情况中通常是无效的,因为未标记数据中可能存在未知类,从而导致主动开放集注释问题。由于引入的不确定性,数据中未知类的存在可能会显着影响现有主动学习方法的性能。为了解决这个问题,我们提出了一种名为 NEAT 的新型以数据为中心的主动学习方法,它可以主动注释开放集数据。 NEAT 旨在标记已知和未知类未标记数据池中的已知类数据。它利用标签的可聚类性从未标记的池中识别已知类别,并根据衡量模型预测和局部特征分布之间不一致的一致性标准从这些类别中选择信息样本。与最近针对同一问题提出的以学习为中心的方法不同,NEAT 的计算效率更高,并且是一种以数据为中心的主动开放集注释方法。 |

| SOS-SLAM: Segmentation for Open-Set SLAM in Unstructured Environments Authors Jouko Kinnari, Annika Thomas, Parker Lusk, Kota Kondo, Jonathan P. How 我们提出了一种在非结构化环境中进行开放集同步定位和建图 SLAM 的新颖框架,该框架使用分段来创建对象地图以及对象之间的几何关系以进行定位。我们的系统包括 1 个前端映射管道,使用零镜头分割模型从图像中提取对象蒙版并跨帧跟踪它们以生成基于对象的地图,以及 2 个帧对齐管道,该管道使用对象的几何一致性来高效定位在各种条件下拍摄的地图。与传统的基于特征的 SLAM 系统或全局描述符方法相比,这种方法对光照和外观的变化更加鲁棒。这是通过在 Batvik 季节性数据集上评估 SOS SLAM 来建立的,该数据集包括在不同季节和照明条件下在芬兰南部沿海地区收集的无人机飞行数据。在不同环境条件下的飞行中,我们的方法比基准方法实现了更高的召回率,精度为 1.0。 SOS SLAM 在参考地图中的定位速度比其他基于特征的方法快 14 倍,并且地图大小小于最紧凑的其他地图大小的 0.4。当从不同的角度考虑本地化性能时,我们的方法优于同一角度的所有基准测试以及不同角度的大多数基准测试。 SOS SLAM 是非结构化环境中一种很有前途的 SLAM 新方法,它对光照和外观的变化具有鲁棒性,并且比其他方法的计算效率更高。 |

| DiffSHEG: A Diffusion-Based Approach for Real-Time Speech-driven Holistic 3D Expression and Gesture Generation Authors Junming Chen, Yunfei Liu, Jianan Wang, Ailing Zeng, Yu Li, Qifeng Chen 我们提出了 DiffSHEG,一种基于扩散的方法,用于语音驱动的整体 3D 表达和任意长度的手势生成。虽然以前的工作主要集中在单独的语音手势或表情生成上,但同步表情和手势的联合生成仍然很少被探索。为了解决这个问题,我们基于扩散的协同语音运动生成转换器能够实现从表情到手势的单向信息流,从而促进改进联合表情手势分布的匹配。此外,我们引入了一种基于外画的采样策略,用于扩散模型中的任意长序列生成,提供了灵活性和计算效率。我们的方法提供了一种实用的解决方案,可以产生由语音驱动的高质量同步表达和手势生成。通过对两个公共数据集的评估,我们的方法在定量和定性方面都实现了最先进的性能。此外,一项用户研究证实了 DiffSHEG 相对于先前方法的优越性。 |

| Skin Cancer Segmentation and Classification Using Vision Transformer for Automatic Analysis in Dermatoscopy-based Non-invasive Digital System Authors Galib Muhammad Shahriar Himel, Md. Masudul Islam, Kh Abdullah Al Aff, Shams Ibne Karim, Md. Kabir Uddin Sikder 皮肤癌是一个全球性的健康问题,需要早期准确的诊断以改善患者的治疗结果。这项研究引入了一种突破性的皮肤癌分类方法,采用了 Vision Transformer,这是一种最先进的深度学习架构,以其在各种图像分析任务中的成功而闻名。该模型利用包含 10,015 个精心注释的皮肤病变图像的 HAM10000 数据集,进行预处理以增强鲁棒性。适应皮肤癌分类任务的 Vision Transformer 利用自注意力机制来捕获复杂的空间依赖性,实现了优于传统深度学习架构的性能。 Segment Anything Model 有助于精确分割癌变区域,获得高 IOU 和 Dice 系数。 |

| Segment anything model (SAM) for brain extraction in fMRI studies Authors Dwith Chenna, Suyash Bhogawar 从磁共振图像中提取大脑并去除头骨伪影 MRI 是神经影像分析中重要的预处理步骤。有许多工具被开发来处理人类功能磁共振成像图像,这可能涉及验证大脑分割结果的手动步骤,这使得它既耗时又低效。在本研究中,我们将使用分段任何模型 SAM ,这是 Meta 4 发布的免费神经网络,它在许多通用分段应用中显示了有希望的结果。我们将通过去除头骨伪影来分析 SAM 在神经成像大脑分割中的效率。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com