Softmax函数是一种常用的激活函数,用于将一组实数值转换为概率分布。它常用于多类别分类问题中,将输入向量映射为各个类别的概率。

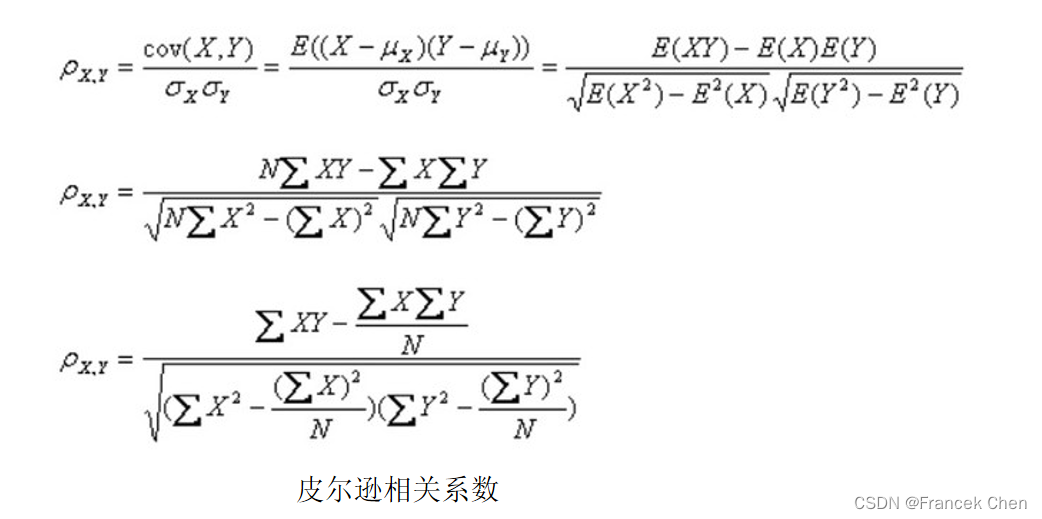

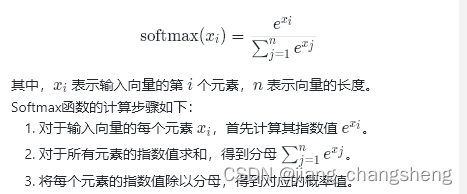

Softmax函数的公式如下:

其中,示输入向量的第 �i 个元素,�n 表示向量的长度。

Softmax函数的计算步骤如下:

- 对于输入向量的每个元素,首先计算其指数值

- 对于所有元素的指数值求和,得到分母

- 将每个元素的指数值除以分母,得到对应的概率值。

Softmax函数的输出是一个概率分布,其中每个元素代表对应类别的概率。由于Softmax函数的性质,输出的概率值总和为1,且每个概率值介于0和1之间。

Softmax函数在多类别分类问题中的应用非常广泛。在训练神经网络时,通常将Softmax函数应用于网络的最后一层,将网络的输出转换为类别概率。然后,可以使用交叉熵损失函数来比较预测概率分布与真实标签之间的差异,从而进行模型的训练和优化。

当使用Python和PyTorch来实现Softmax函数时,可以使用PyTorch提供的torch.nn.functional模块中的softmax函数来实现。下面是一个详细的代码示例:

import torch

import torch.nn.functional as F

# 定义输入向量

input_vector = torch.tensor([2.0, 1.0, 0.5])

# 使用softmax函数进行转换

output_probs = F.softmax(input_vector, dim=0)

print(output_probs)在这个示例中,我们首先导入了torch和torch.nn.functional模块。然后,我们定义了一个输入向量input_vector,它包含了3个元素。

接下来,我们使用F.softmax函数对input_vector进行Softmax转换。dim=0参数指定了在哪个维度上进行Softmax计算。在本例中,我们将在维度0上进行Softmax计算,即对输入向量的每个元素进行Softmax。

最后,我们打印输出的概率分布output_probs,它包含了Softmax函数计算后得到的每个类别的概率。

这个示例展示了如何使用PyTorch中的函数来实现Softmax函数。可以根据自己的需求进行修改和扩展。