在深度学习中,正则化是一种用于防止模型过拟合的技术。过拟合是指模型在训练数据上表现良好,呆在未见过的测试数据集上表现效果较差的情况。正则化的目标是通过对模型性的参数或层的约束,使其在训练数据上表现的不那么复杂,从而提高在未见过数据上的泛化能力。

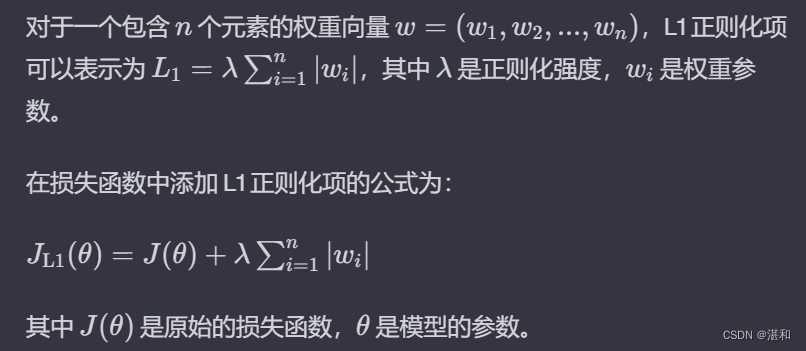

1.L1正则化

定义:L1正则化是通过添加网络权重的绝对值的总和来实现的。在损失函数中,L1正则化项为λ * Σ|w_i|,其中λ是正则化强度,w_i 是权重参数。

作用:L1正则化有助于使一些权重变得稀疏,即使其中一些权重为零。这可以被视为一种特征选择的机制,可以降低模型的复杂性。

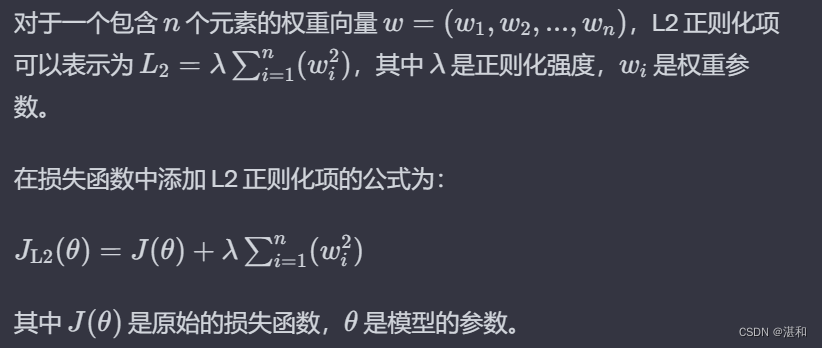

2.L2正则化

定义:L2正则化是通过添加网络权重的平方的总和来实现的。在损失函数中,L2正则项为λ * Σ(w_i^2),其中λ是正则化强度,w_i 是权重参数。

作用:L2正则化有助于防止权重过大,使得模型对输入数据的小变化不敏感。它可以有效地平滑权重,促使模型更加均匀的利用输入数据的信息。

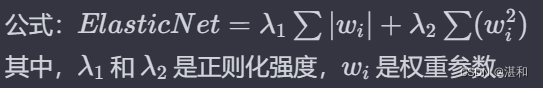

3.弹性网络(Elastic Net)

定义:弹性网络是L1正则化和L2正则化的组合,具有两个超参数,一个用于控制L1正则化,一个控制L2正则化。

作用:综合了L1和L2的优点,可以同时实现权重的稀疏性和防止权重过大。

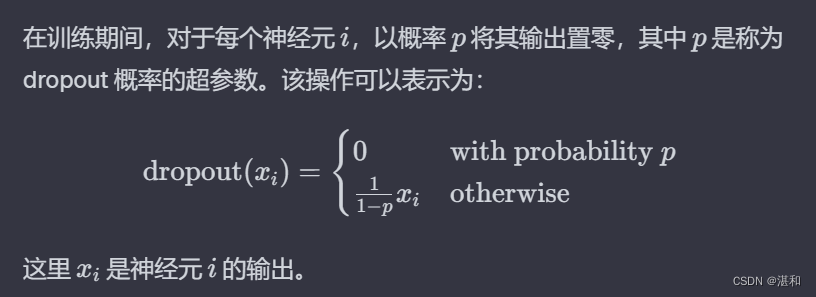

4.Dropout

定义:通过在训练过程中随机将神经元的输出置零来实现,从而随机地将一些神经元从网络中丢弃。

作用:Dropout通过随机丢弃神经元,强制网络学习更加鲁棒和泛化的特征,减少对某些特定神经元的依赖,防止过拟合。