目录

- 前言

- 1 大模型训练优化的目标

- 1.1 简单性

- 1.2. 高效性

- 1.3 廉价性

- 2 显存的组成与利用

- 2.1 参数存储

- 2.2 梯度计算与存储

- 2.3 中间计算结果

- 2.4 优化器信息

- 3 优化方法

- 3.1 数据并行

- 3.2 模型并行

- 3.3 零冗余优化器(Zero Redundancy Optimizer)

- 3.4 Pipeline并行方法

- 结语

前言

随着深度学习模型不断增大,参数数量激增,对显卡性能提出了更高的要求。本文将深入分析显存利用、多显卡协作、CPU与GPU的协作,以及显存的组成,然后详细讨论数据并行、模型并行、Zero Redundancy Optimizer和Pipeline并行等优化方法,旨在实现简单、高效、廉价的分布式训练。

1 大模型训练优化的目标

迅速发展的深度学习领域,随着模型规模的不断增加,为了更快、更高效地完成训练,分布式训练成为一种不可忽视的策略,以简单、高效、廉价为目标,提升深度学习模型的训练效率。

1.1 简单性

分布式训练的简单性是提高工作效率的关键。通过合理的显存管理、协同计算方式的选择以及高效的参数更新策略,可以降低分布式训练的实施难度,使其更易于实现和维护。

1.2. 高效性

高效性是分布式训练的核心目标之一。通过数据并行、模型并行、Zero Redundancy Optimizer等优化方法,实现多张显卡之间的协同训练,提高训练速度,确保模型在有限时间内取得更好的性能。

1.3 廉价性

在追求高效性的同时,廉价性也是考虑的因素之一。合理利用多张低成本显卡、高效利用硬件资源,以及选择适当的分布式策略,可以在降低训练成本的同时提高训练效果。

为了实现简单、高效、廉价的分布式训练,我们将深入研究数据并行、模型并行、Zero Redundancy Optimizer和Pipeline并行等策略。通过选择最适合任务需求的策略,使得分布式训练更加贴合实际应用场景。

2 显存的组成与利用

深度学习模型在显存中占用的空间主要包括模型的参数、梯度、中间计算结果和优化器所需的信息。理解显存的组成对于优化显存利用至关重要。

2.1 参数存储

模型参数是深度学习模型的核心,包括各层的权重和偏置。这些参数需要存储在显存中以支持前向传播和反向传播过程。通过精细的参数管理,可以降低显存的占用。

2.2 梯度计算与存储

在反向传播中,显存还需要存储梯度信息。梯度是模型参数的变化率,通过梯度可以更新模型参数以最小化损失函数。有效的梯度管理有助于减少显存占用。

2.3 中间计算结果

深度学习模型的计算过程中会生成中间结果,例如各层的激活值。这些中间计算结果需要存储在显存中,以便用于反向传播和模型的优化过程。

2.4 优化器信息

优化器负责调整模型参数以最小化损失函数。相关的优化器信息,如动量、学习率等,也需要存储在显存中。对这些信息的高效管理有助于提高显存的利用率。

通过对显存的详细组成和分析过程的讨论,以及采用合理的显存管理策略,可以更好地适应模型规模的增加,从而实现更为高效和经济的训练过程。

3 优化方法

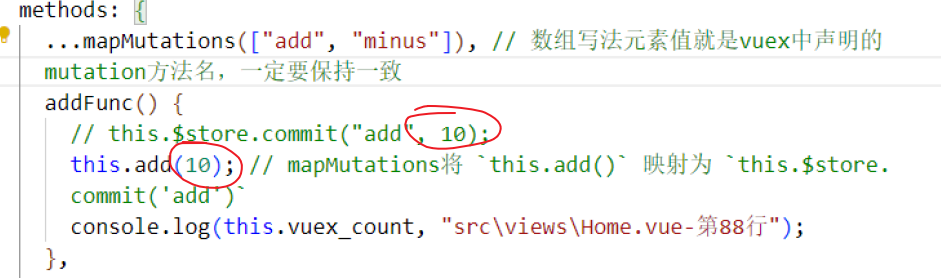

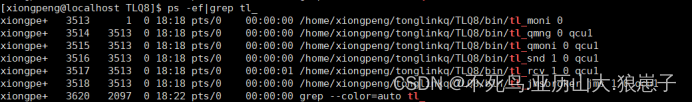

3.1 数据并行

数据并行是一种在多个GPU上分布数据以同时训练模型的方法。将数据分为n份,n个显卡对数据分别计算,最后通过规约操作得到聚合的梯度,实现同步更新的参数。

广播算子是将数据有效地传播到所有显卡的操作。通过广播,每个GPU都能够访问整个模型,而无需在每个GPU上存储一份完整的模型。规约算子用于在多个GPU上计算梯度,然后将这些梯度汇总为一个聚合梯度。这有助于同步更新模型参数,确保所有GPU上的模型保持一致。在规约后,需要一种操作来收集并应用聚合的梯度。这确保每个GPU都更新其本地模型参数,以反映整个批次的训练结果。

3.2 模型并行

模型并行是将模型划分为多个部分,分别在不同GPU上计算的方法。以矩阵乘法为例,将模型分割成n份,分别在不同显卡上计算,最后通过all gather操作收集拼接,得到完整的模型结果。

模型分割。将模型划分为n份,每份分配到不同的GPU上。这确保每个GPU只处理模型的一部分,而无需存储整个模型。

计算和拼接。每个GPU独立计算其分配的模型部分,然后通过all gather操作将结果收集拼接,得到完整的模型结果。

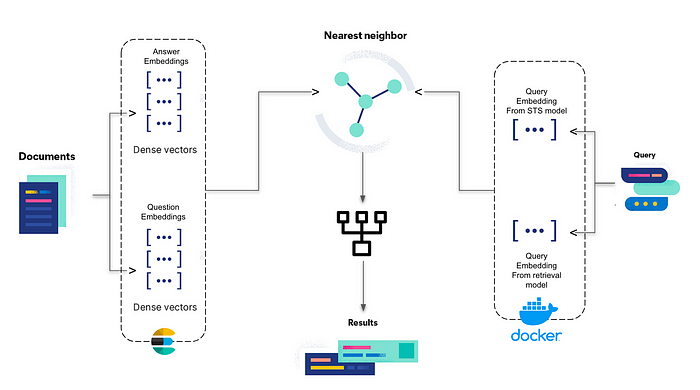

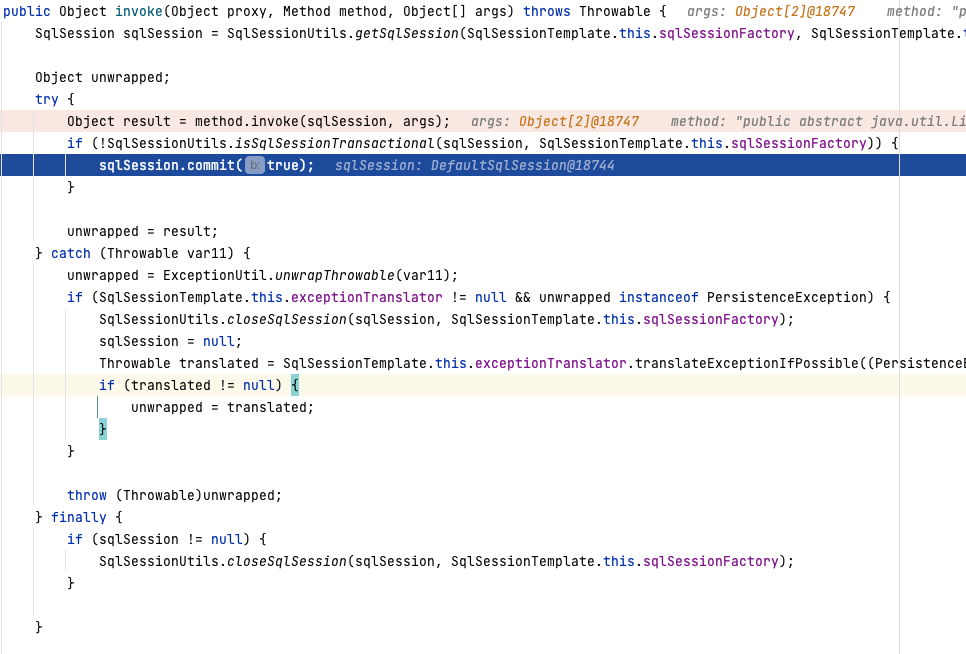

3.3 零冗余优化器(Zero Redundancy Optimizer)

零冗余优化器是一种分布式训练的优化方法,其关键思想是每张显卡只更新一部分参数和梯度,通过协作实现全局参数的更新。每张显卡更新一部分参数和梯度,通过前向传播和反向传播协作,最后通过合作结果的收集实现所有显卡的参数更新。

每张显卡独立更新一部分参数,通过前向传播和反向传播的协作,最后通过结果的收集实现所有显卡的参数更新。

3.4 Pipeline并行方法

Pipeline并行是一种将模型的不同层分配到不同显卡上,通过异步计算提高训练速度的方法。

将模型的不同层分配到不同显卡上,形成一个流水线结构。前一层的输出作为下一层的输入,通过流水线的方式实现多层级的并行计算,提高训练速度。

结语

通过对显存管理、多显卡协作、显存组成及优化方法的全面讨论,本文旨在为深度学习从业者提供清晰的指导,使其能够在模型越来越大、参数越来越多的情况下,实现简单、高效、廉价的分布式训练。选择合适的优化方法,对于充分发挥显卡性能、提高训练效率至关重要。