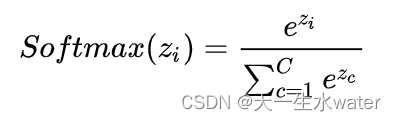

在神经网络中,Softmax 是一个用于多类别分类的激活函数。给定一个包含原始分数(未经处理的模型输出)的向量,Softmax 将这些分数转化为表示概率分布的向量。具体而言,对于给定的原始分数向量 ( z ),Softmax 函数的计算方式如下:

其中,( z_i ) 是向量中第 ( i ) 个元素,C为输出节点数。

Softmax 层解释:

Softmax 层通常被用作神经网络输出层的激活函数,特别是在多类别分类问题中。它的作用是将原始的类别分数转化为概率分布,使得所有类别的概率之和为 1。这样,神经网络的输出可以被解释为每个类别的概率。

例如,如果神经网络用于图像分类,Softmax 层可以将网络输出的原始分数(每个类别的得分)转换为每个类别的概率。这使得我们可以很容易地确定网络认为图像属于每个类别的可能性。

Softmax 层的应用例子:

-

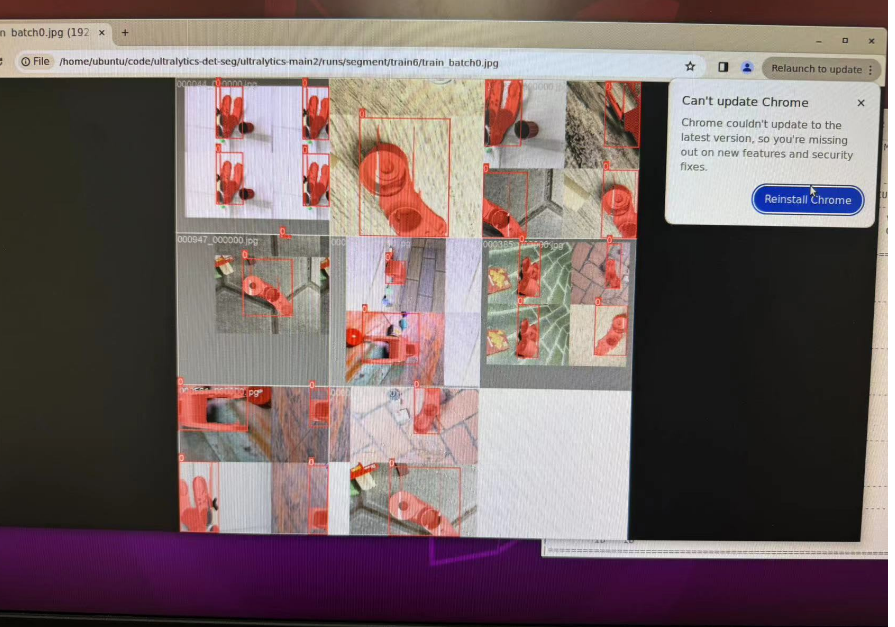

图像分类: 在卷积神经网络 (CNN) 中,Softmax 层用于将网络输出的特征映射为图像属于不同类别的概率。

-

情感分析: 在自然语言处理中,Softmax 层可以用于将神经网络的输出转换为文本所表达情感的概率分布。

-

手写数字识别: 在数字识别任务中,Softmax 层可以将神经网络输出的原始分数转换为图像包含不同数字的概率分布。

-

语音识别: 在声学建模中,Softmax 层用于将神经网络输出的声学特征转换为不同语音类别的概率。

-

机器翻译: 在翻译任务中,Softmax 层可以将神经网络输出的原始分数转换为每个词汇的翻译概率分布。

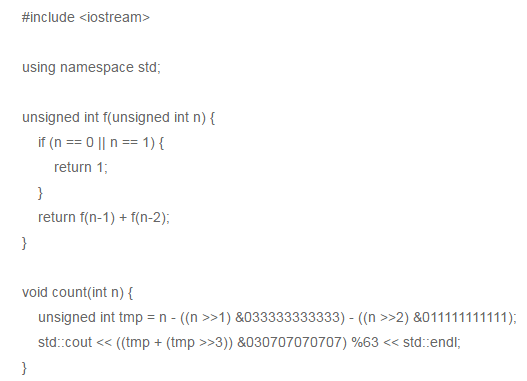

Python 示例代码:

以下是一个简单的 Python 代码示例,演示如何使用 Softmax 函数将原始分数转换为概率分布:

import numpy as np

def softmax(x):

exp_x = np.exp(x - np.max(x)) # 避免数值不稳定性

return exp_x / exp_x.sum(axis=0)

# 示例输入,原始分数

raw_scores = np.array([2.0, 1.0, 0.1])

# 使用 Softmax 函数转换为概率分布

probabilities = softmax(raw_scores)

print("原始分数:", raw_scores)

print("Softmax 概率分布:", probabilities)

运行结果为:

原始分数: [2. 1. 0.1] Softmax 概率分布: [0.65900114 0.24243297 0.09856589]

这个示例演示了如何使用 Softmax 函数将原始分数转换为概率分布,以及如何在实际应用中避免数值不稳定性。