实时数据处理已经成为当今大数据时代的一个重要领域,它使组织能够及时分析和采取行动,以应对不断变化的数据。Spark Streaming是Apache Spark生态系统中的一个模块,专门用于实时数据处理。本文将深入探讨实时数据处理的概念,并介绍如何使用Spark Streaming来处理实时数据流。

什么是实时数据处理?

实时数据处理是一种处理流式数据的方法,它使组织能够在数据产生后立即对其进行分析和操作。这与传统的批处理不同,批处理通常是周期性的、离线的,需要等待一段时间才能获得处理结果。

实时数据处理的典型应用包括:

-

实时监控:监控网络流量、服务器性能、交易活动等。

-

实时分析:实时计算统计信息、趋势分析、异常检测等。

-

实时决策:根据实时数据做出决策,例如广告投放、库存管理等。

Spark Streaming简介

Spark Streaming是Apache Spark的一个模块,用于实时数据处理和流处理。它提供了高级别的API,使开发人员能够轻松处理来自各种数据源的实时数据流。Spark Streaming将实时数据流划分为小批次(micro-batch),并在每个批次上执行Spark操作。这种微批处理的方法允许开发人员使用Spark的批处理和机器学习功能来处理实时数据。

示例:Word Count实时处理

通过一个简单的示例来了解Spark Streaming的工作原理。假设要实时统计文本数据流中的单词频率。

from pyspark.streaming import StreamingContext

# 创建StreamingContext,每秒处理一次数据

ssc = StreamingContext(spark, 1)

# 创建一个输入数据流

lines = ssc.socketTextStream("localhost", 9999)

# 对每个批次的数据进行处理

word_counts = lines.flatMap(lambda line: line.split(" ")).map(lambda word: (word, 1)).reduceByKey(lambda a, b: a + b)

# 打印每秒的Word Count结果

word_counts.pprint()

# 启动StreamingContext

ssc.start()

# 等待终止

ssc.awaitTermination()

在上面的示例中,首先创建了一个StreamingContext,它定义了每秒处理一次数据的批处理间隔。然后,创建了一个输入数据流,它可以连接到网络套接字(localhost:9999)以接收实时数据。接下来,对每个批次的数据进行处理,通过flatMap拆分单词,然后使用reduceByKey来计算单词频率,并使用pprint打印结果。

Spark Streaming的核心概念

要理解Spark Streaming,有一些核心概念需要了解:

-

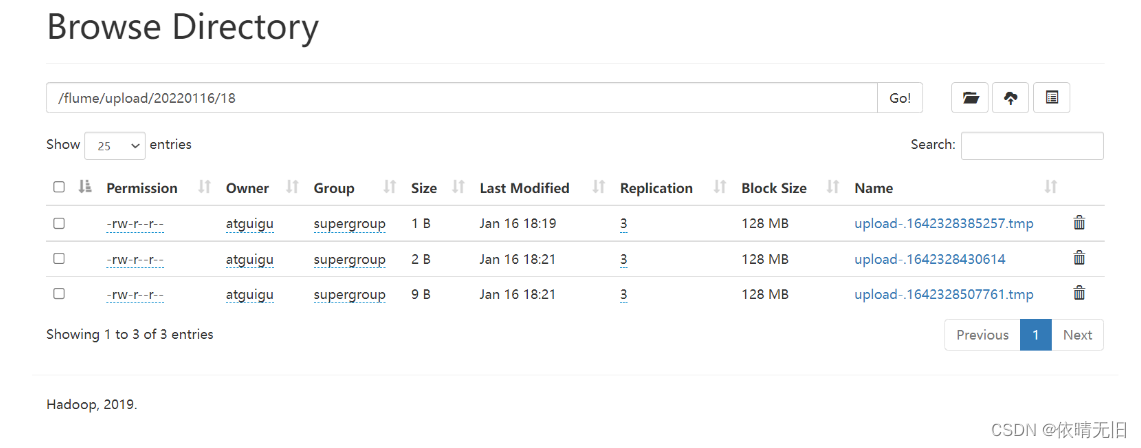

DStream(离散流):DStream是Spark Streaming的基本抽象,表示连续的数据流。它可以从多种数据源创建,例如Kafka、Flume、HDFS等。

-

转换操作:您可以在DStream上应用各种转换操作,例如

map、reduceByKey、join等,以进行实时数据处理。 -

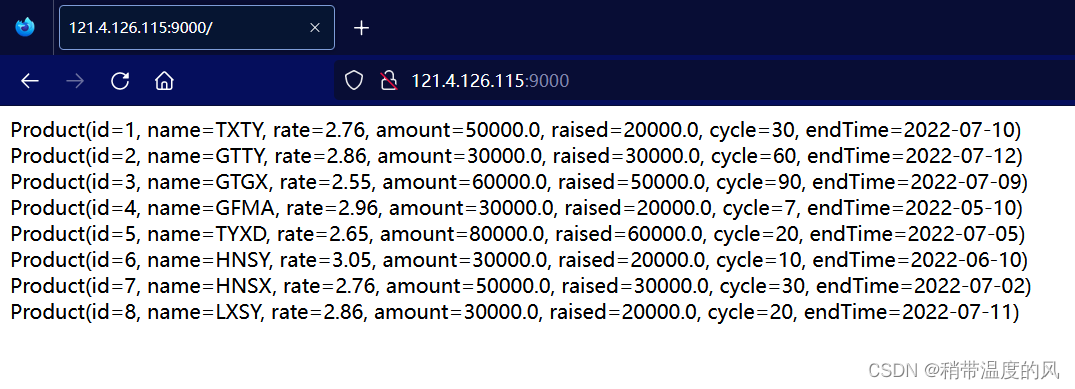

输出操作:您可以将处理结果输出到不同的目的地,例如文件系统、数据库、控制台等。

-

检查点:检查点是将DStream的状态保存到可靠的文件系统中,以便在应用程序重新启动时恢复状态。

-

窗口操作:Spark Streaming允许您在数据流上定义窗口,以便对某个时间范围内的数据进行处理。

实际用例

Spark Streaming适用于各种实际用例,包括网络监控、实时报警、日志分析、推荐系统、金融交易监控等。以下是一个实际用例示例:

网络监控和实时报警

假设你是一个网络运营商,负责监控网络流量和服务器性能。可以使用Spark Streaming来实时处理网络流量数据流,并检测异常情况。如果某个服务器的流量突然激增,您可以触发实时报警。

# 创建StreamingContext

ssc = StreamingContext(spark, 1)

# 创建输入数据流,监控网络流量数据源

network_data = ssc.socketTextStream("localhost", 9999)

# 实时检测异常情况并

触发报警

def detect_anomalies(rdd):

# 实现异常检测逻辑

# 如果检测到异常,触发报警

pass

network_data.foreachRDD(detect_anomalies)

# 启动StreamingContext

ssc.start()

# 等待终止

ssc.awaitTermination()

在上面的示例中,使用Spark Streaming监控网络流量数据流,然后通过detect_anomalies函数检测异常情况并触发报警。

性能优化

在使用Spark Streaming时,性能优化是一个重要的考虑因素。

以下是一些性能优化和注意事项:

-

合理选择批处理间隔:选择合适的批处理间隔以平衡实时性和性能。

-

使用检查点:定期将DStream状态保存到检查点以确保容错性。

-

谨慎使用窗口操作:窗口操作可以增加计算开销,需要谨慎使用。

总结

Spark Streaming是一个强大的实时数据处理框架,可用于各种实时数据处理应用程序。本文深入探讨了实时数据处理的概念,并介绍了Spark Streaming的基本原理和核心概念,以及一个简单的示例。希望本文能够帮助大家更好地理解和应用实时数据处理和Spark Streaming,以满足您的实时数据分析需求。