将下发的ds_db01.sql数据库文件放置mysql中

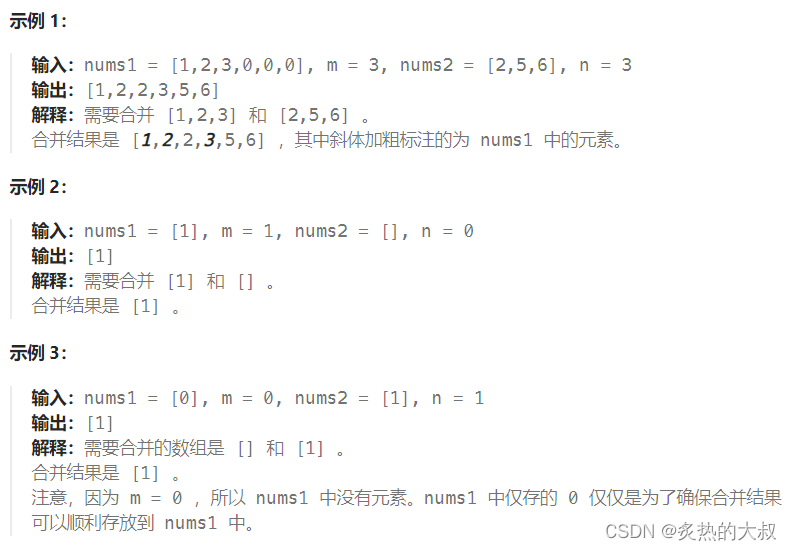

12、编写Scala代码,使用Spark将MySQL的ds_db01库中表user_info的全量数据抽取到Hive的ods库中表user_info。字段名称、类型不变,同时添加静态分区,分区字段为etl_date,类型为String,且值为当前日期的前一天日期(分区字段格式为yyyyMMdd)。使用hive cli执行show partitions ods.user_info命令,将结果截图粘贴至答案表.docx中对应的任务序号下;

13、 编写Scala代码,使用Spark将MySQL的ds_db01库中表sku_info的全量数据抽取到Hive的ods库中表sku_info。字段名称、类型不变,同时添加静态分区,分区字段为etl_date,类型为String,且值为当前日期的前一天日期(分区字段格式为yyyyMMdd)。使用hive cli执行show partitions ods.sku_info命令,将结果截图粘贴至答案表.docx中对应的任务序号下;

| 软件名称 | 版本 |

| ubuntu | 18.04 64 位 |

| Hadoop:hadoop-3.1.3.tar.gz | 3.1.3 |

| Jdk:jdk-8u212-linux-x64.tar.gz | 1.8 |

| Spark:spark-3.1.1-bin-hadoop3.2.tgz | 3.1.1 |

| Hive:apache-hive-3.1.2-bin.tar.gz | 3.1.2 |

| MySQL | 5.7 |

| Scala:scala-2.12.x.tgz | 2.12 |

| Vue.js | 3.2 |

| ECharts | 5.1 |

| JDBC驱动: mysql-connector-java-5.1.37.jar | |

| 集成开发工具:IDEA 2022 社区版 | |

一、Hive安装地址

1)Hive官网地址

Apache Hive![]() https://hive.apache.org/

https://hive.apache.org/

2)文档查看地址

GettingStarted - Apache Hive - Apache Software Foundation![]() https://cwiki.apache.org/confluence/display/Hive/GettingStarted

https://cwiki.apache.org/confluence/display/Hive/GettingStarted

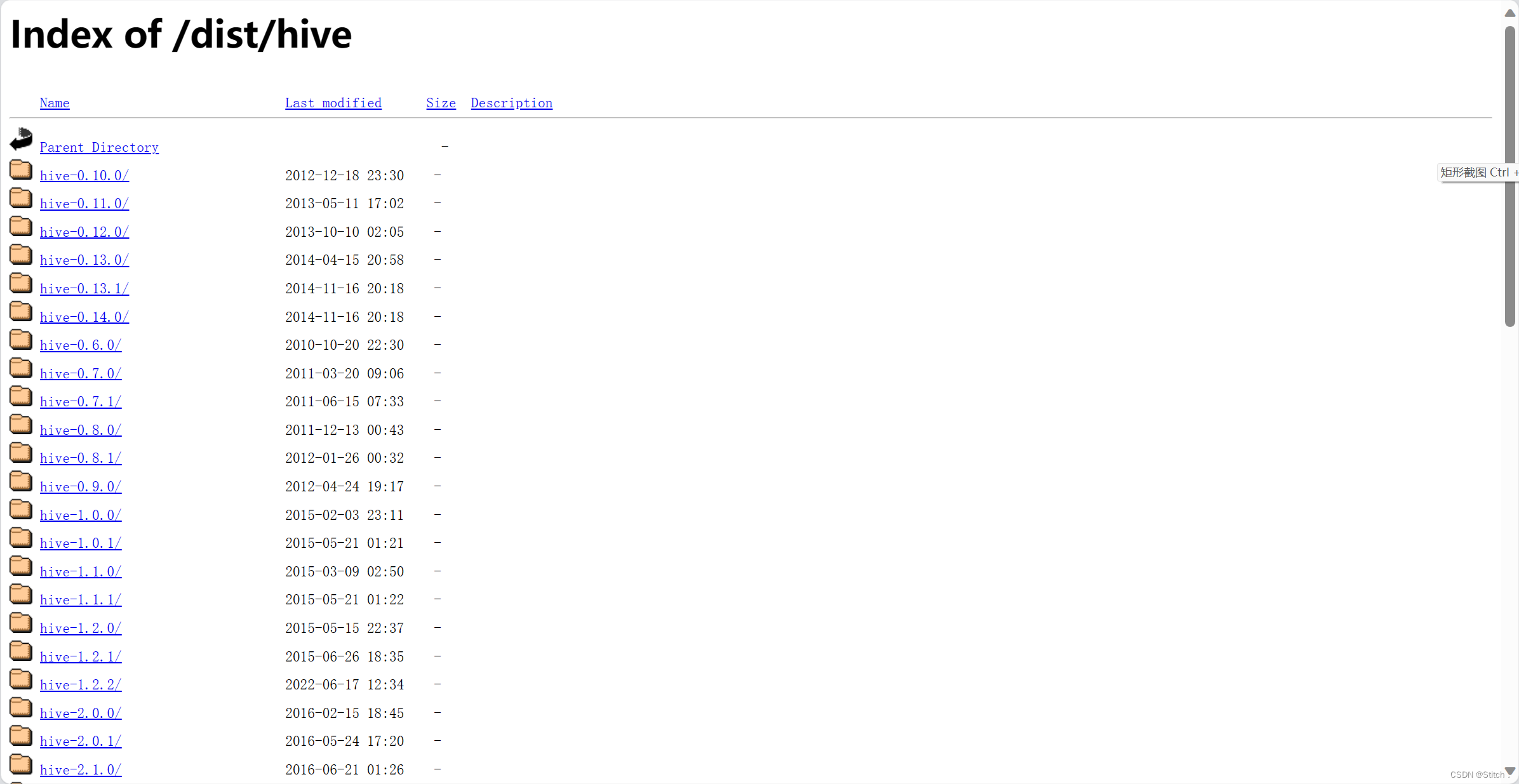

3)下载地址

Index of /dist/hive (apache.org)![]() http://archive.apache.org/dist/hive/

http://archive.apache.org/dist/hive/

二、Hive安装部署

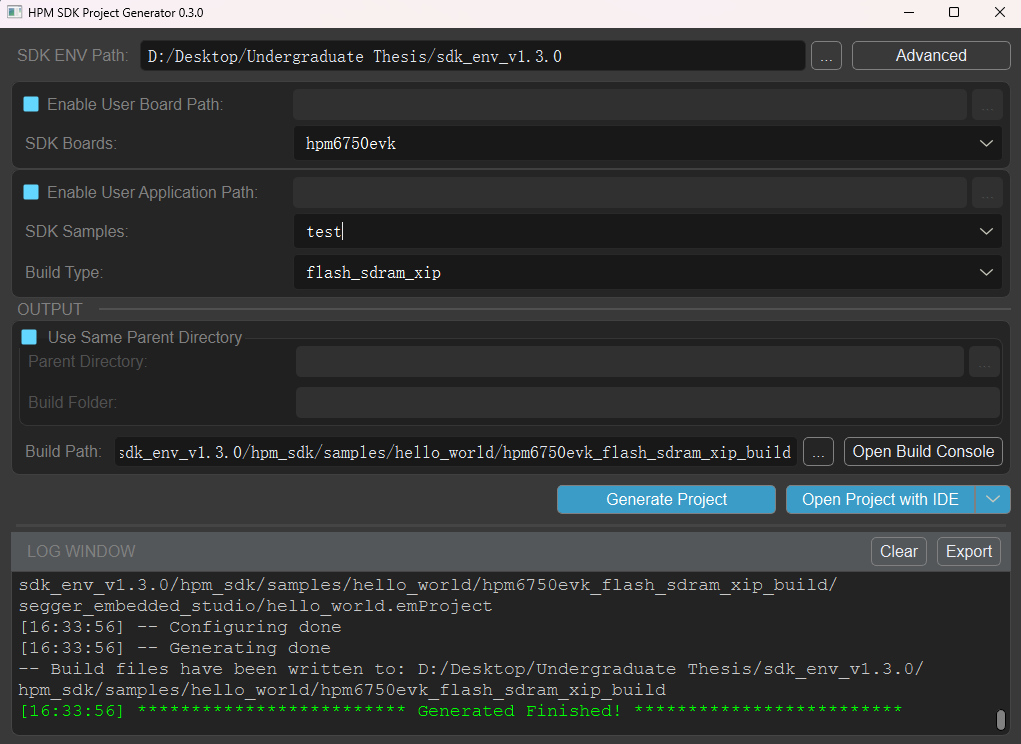

1. 把 apache-hive-3.1.2-bin.tar.gz上传到Linux的/export/software目录下