现有的基于学习的自动驾驶系统(AD)在理解高级信息和提供可解释性方面存在挑战。为了解决这些问题,这项工作采用LLM作为复杂AD场景的决策组件。作者设计了认知途径(cognitive pathway)来实现LLM的综合推理,并开发了将LLM决策转化为可操作的驾驶命令的算法。通过这种方法,LLM决策通过引导参数矩阵自适应与底层控制器无缝集成。大量的实验表明,由于LLM的常识推理能力,提出的方法不仅在单车辆任务中始终优于基线方法,而且还有助于处理复杂的驾驶行为,甚至多车辆协调。

来自:LANGUAGEMPC: LARGE LANGUAGE MODELS AS DECISION MAKERS FOR AUTONOMOUS DRIVING

工程地址:https://sites.google.com/view/llm-ad

目录

- 引言

- 方法

- 背景

- 思维链

- 关注定位

- 状态感知和动作指导

- 实验

引言

想象一下,我们正在开车,驶近一个没有信号的十字路口,正准备左转,迎面有一辆车驶来。人类司机本能地知道,根据交通规则,他们应该减速和让行。然而,现有的先进的基于学习的自动驾驶系统通常需要复杂的规则或奖励功能设计来有效地处理这些场景。

现有基于学习的AD系统面临的另一个挑战是长尾问题。有限的数据集和采样效率都会给现有的基于学习的自动驾驶系统在罕见的真实驾驶场景中做出决策带来挑战。Chauffeurnet 证明了这样的限制,即使是3000万个状态动作样本也不足以学习将鸟瞰图像(状态states)映射到控制(动作action)的最佳策略。

此外,缺乏可解释性是现有基于学习的AD系统面临的一个紧迫问题。成熟的AD系统必须具有可解释性,以获得社会的认可,使其能够进行有针对性的优化和迭代改进。然而,现有的基于学习的AD系统几乎都是黑盒。

考虑到上述挑战,一个基本问题出现了:我们能否为自动驾驶系统配备像人类一样思考和驾驶的能力?作者提出的解决方案包括使用LLM作为AD系统的“大脑”。最近的ChatGPT等模型将LLM定位为通用智能的早期版本,该特性使LLM成为上述AD系统所面临问题的强大解决方案。

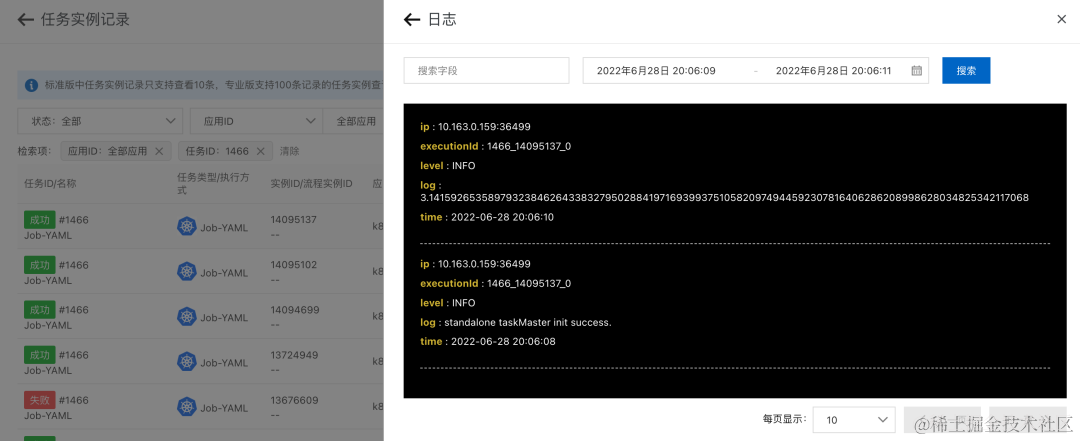

在该研究中,作者利用LLM来分析和推理各种场景,使其能够提供高级决策,并通过调整参数矩阵,将高级决策转换为数学表示来指导底层控制器,MPC。图1展示了该系统对罕见和复杂场景的强大推理能力,展示了其在理解高级信息、常识推理和可解释性方面的优势。通过定量实验,发现该系统明显优于现有的基于学习和基于优化的单车辆决策任务方法。

- 图1:面对在环形交叉路口罕见的故障车辆停在路中间的情况,LLM通过常识推理和对高层信息的理解,做出符合交通规则的决策。

方法

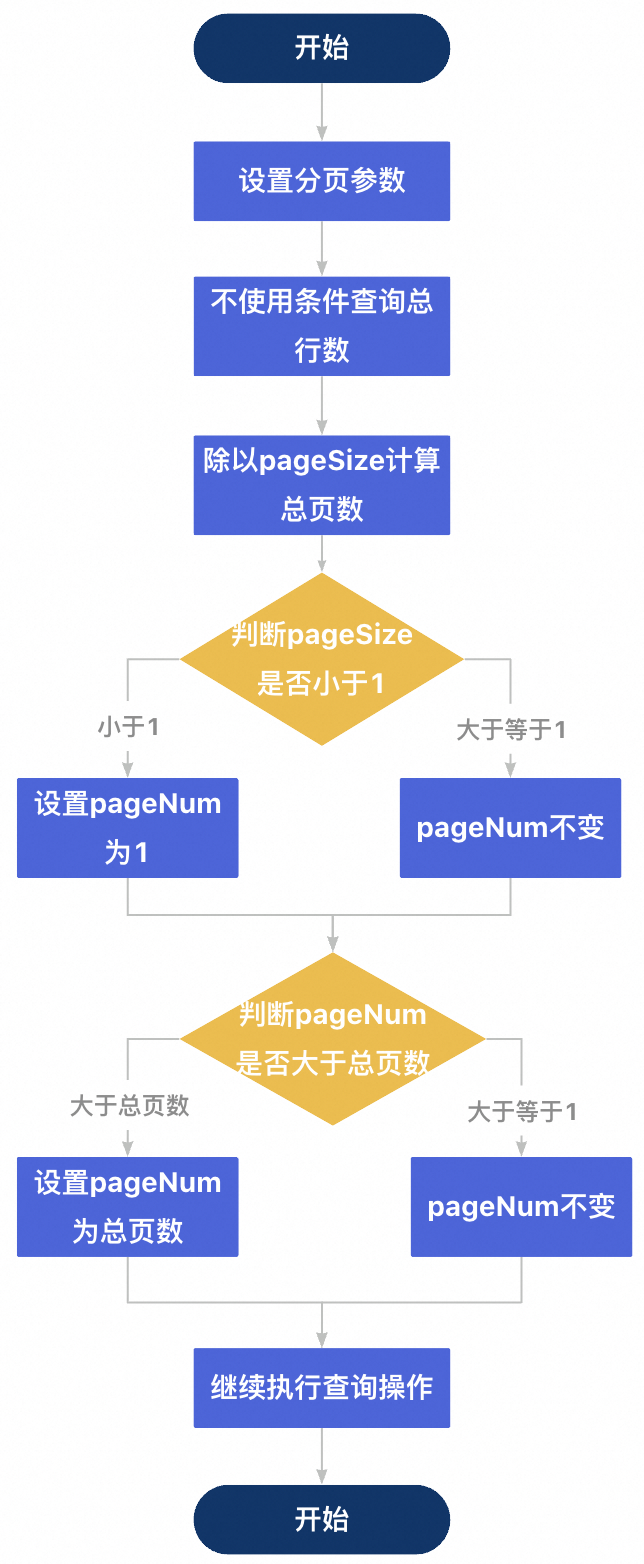

作者开发了一个以LLM为高层决策核心的AD系统,如图2a所示。LLM根据提供的prompt启动对话,不断从环境中收集信息,进行推理并做出判断。如图2a中间所示,从左到右,LLM依次进行:1识别需要注意的车辆,2评估情况,3提供行动指导。然后,系统将这三个高级文本决策转换为数学表示,即观察矩阵、权重矩阵和action偏差。这些元素作为底层控制器MPC的指令,指示其要采取的具体驾驶动作。

以十字路口左转为例,在图2b中,展示了如何将上述三个高级文本决策转换为MPC所需的数学表示。LLM选择“vehicle_26”,我们使用MPC的观测算子创建相应的向量,并将观测矩阵中的其他元素归零,仅关注“vehicle_26”。根据LLM发出信号的交叉口等待情况,调整权值矩阵,使减速指令优先于轨迹跟随,从而促使MPC按照LLM的指令及时减速。通过预定义的规则将LLM的action指导直接转化为action偏差。在上述三个方面的数学形式的指导下,MPC完成了停止的action。

- 图2a:以LLM为核心的决策管道。

- 图2b:将LLM文本高级决策转换为指导MPC给出具体驾驶动作的数学表示,以十字路口左转为例。

背景

MPC基于获得的当前测量信息,在每一时刻在线求解一个有限时间开环优化问题,并将得到的控制序列中代价最低的第一个元素应用于被控车辆。在这项工作中,作者在马尔可夫决策过程(MDP)的背景下定义MPC的代价函数,MDP通常用于形式化车辆控制问题: ( S , A , C , P , p 0 ) (S,A,C,P,p_{0}) (S,A,C,P,p0),其中 S S S是状态空间, A A A是action空间, C : S × A → R C:S\times A→\mathbb{R} C:S×A→R是代价函数, P : S × A → S P:S\times A→S P:S×A→S是动态方程, p 0 p_{0} p0是初始状态分布。给定一个代价函数 C C C,MPC找到action序列 a 1 : H = a 1 , . . . , a H a_{1:H}=a_{1},...,a_{H} a1:H=a1,...,aH以最小化预期的累积代价 J ( a 1 : H ) = ∑ t = 1 H C ( s t , a t ) J(a_{1:H})=\sum_{t=1}^{H}C(s_{t},a_{t}) J(a1:H)=∑t=1HC(st,at)。代价函数形式如下: C ( s , a ) = ∑ i = 0 M w i ⋅ n i ( r i ( s , a , ψ i ) ) C(s,a)=\sum_{i=0}^{M}w_{i}\cdot n_{i}(r_{i}(s,a,\psi_{i})) C(s,a)=i=0∑Mwi⋅ni(ri(s,a,ψi))其中 w ∈ R + w\in\mathbb{R}+ w∈R+为非负权重, n ( ⋅ ) : R → R + n(\cdot):\mathbb{R}→\mathbb{R}+ n(⋅):R→R+为二次可微范数,其最小值为0, r ∈ R r\in\mathbb{R} r∈R是当 r = 0 r=0 r=0时达到最优性能的残差项, ψ i \psi_{i} ψi为残差项的参数。例如,如果我们希望车辆采用所需的加速度,我们可以设计一个残差项 r a c c ( a c c , ψ ) = a c c − ψ r_{acc}(acc,\psi)=acc-\psi racc(acc,ψ)=acc−ψ,其中 ψ \psi ψ表示所需的加速度,并用 l 2 l_{2} l2范数构造最终的奖励: C a c c = w ∣ r a c c ∣ 2 C_{acc}=w\vert r_{acc}\vert_{2} Cacc=w∣racc∣2。由于驾驶场景的复杂性,设计一组适用于所有驾驶场景的权重和残差项几乎是不可能的。在这项工作中,作者使用一组通用的简单残差项来调整控制行为,其中包括action偏差,并基于MPC应该执行动作偏差的确定性设计了多组权重矩阵。使用LLM来给出动作偏差,并选择权重矩阵来驱动不复杂场景。

思维链

我们采用LangChain作为管理LLM的框架,并为LLM建立一个结构和流程。首先,我们在对话开始时立即介绍这些指定的工具。随后,在对话过程中,LLM积极调用这些工具,为其正在进行的决策过程获取相关信息和指导。LLM遵循这些指导方针来确定其下一步行动,直到成功解决整个问题。

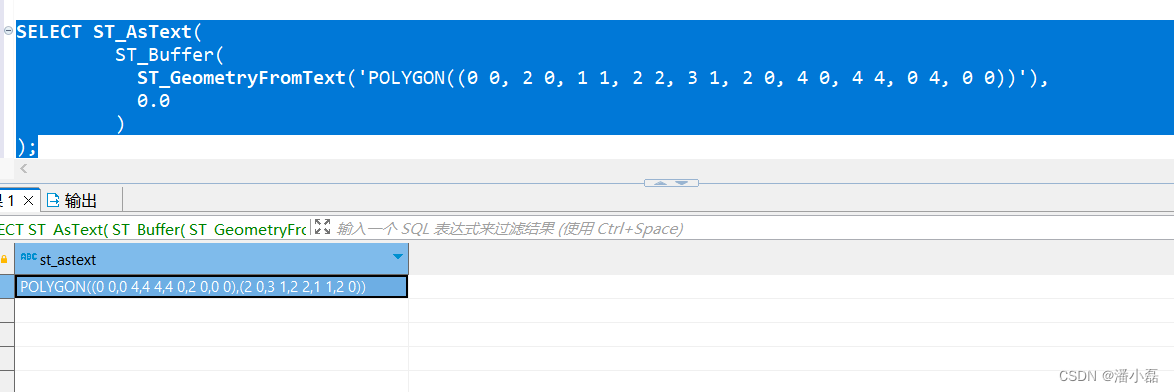

作为一个示例,考虑图3中所示的三个核心工具。这些工具中的每一个都有双重目的,即为LLM提供相关信息和完成推理所需的指导。

- 图3:定义的三个用于提示的核心工具。每个工具的提示都包含信息和指导原则,以帮助LLM完成推理和判断并开始下一步。

此外,这些工具使我们能够改进提供场景信息的方式。关键在于只提供LLM思维过程中每个决策步骤所需的相关信息,如图3所示。这种方法代表了一种解决方案的转变,解决了LLM在处理复杂而广泛的数据时面临的重大挑战。它确保了信息的组织简洁性和必要性,从而大大提高了LLM推理和判断的能力。

关注定位

开车时有效分散注意力的能力反映了一种类似人类的思维过程。在这种情况下,我们要求LLM系统地评估与周围车辆有关的信息。目标是辨别这些车辆的意图,并最终确定它们是否与AD车辆的运动产生冲突。特别的,在时刻 t t t,对于周围车辆的每个元素 V t = { V 1 t , V 2 t , . . . } V^{t}=\left\{V_{1}^{t},V_{2}^{t},...\right\} Vt={V1t,V2t,...},我们有: I i t = L L M ( S i t , S i t − 1 , . . . , S i t − 10 , e n v t ) M i t = L L M ( S i t , I i t , e n v t ) I_{i}^{t}=LLM(S_{i}^{t},S_{i}^{t-1},...,S_{i}^{t-10},env^{t})\\M_{i}^{t}=LLM(S_{i}^{t},I_{i}^{t},env^{t}) Iit=LLM(Sit,Sit−1,...,Sit−10,envt)Mit=LLM(Sit,Iit,envt)其中, e n v t env^{t} envt为场景道路信息, S i t S_{i}^{t} Sit为环境中 V i t V_{i}^{t} Vit的状态, I i t I_{i}^{t} Iit为 V i t V_{i}^{t} Vit的意图, M i t M_{i}^{t} Mit为0或1,表示 V i t V_{i}^{t} Vit被LLM认为是否需要关注,随后,根据LLM识别的车辆为MPC创建了一个观察矩阵: o b s i t = M P C o b s ( S i t , I i t , e n v t ) ∗ M i t obs_{i}^{t}=MPC_{obs}(S_{i}^{t},I_{i}^{t},env^{t})*M_{i}^{t} obsit=MPCobs(Sit,Iit,envt)∗Mit其中, o b s i t obs_{i}^{t} obsit为MPC观测矩阵的第 i i i行, M P C o b s MPC_{obs} MPCobs是MPC计算观测矩阵的算子。这确保了MPC只关注这些选定的车辆。

状态感知和动作指导

在驾驶过程中,状态感知是一个关键的高层决策过程,包括对当前场景的深刻理解,以及常识推理。在这个框架内,作者让LLM负责从几个选项中选择一个特定的情况,利用在关注定位section中概述的关注分配过程中收集的信息,以及LLM判断的结果。定义特征 F i t = { S i t , I i t , M i t } F_{i}^{t}=\left\{S_{i}^{t},I_{i}^{t},M_{i}^{t}\right\} Fit={Sit,Iit,Mit}描述 V i t V_{i}^{t} Vit相关的信息,此时有: X t = L L M ( F 1 t , . . . , F k t , e n v t ) X^{t}=LLM(F_{1}^{t},...,F_{k}^{t},env^{t}) Xt=LLM(F1t,...,Fkt,envt)其中, k k k为LLM选择的周围车辆数量, X t X^{t} Xt为选择的情况。对 X t X^{t} Xt的判断作为MPC权重矩阵的调整机制。对于每个预定义的情况,都建立了相应的权重矩阵 W t W^t Wt。随后,LLM根据其选择的情况提供关于加速和转向的指导: A t = L L M ( F 1 t , . . . , F k t , e n v t , X t ) A^{t}=LLM(F_{1}^{t},...,F_{k}^{t},env^{t},X^{t}) At=LLM(F1t,...,Fkt,envt,Xt)其中, A t A^{t} At为动作指导。 A t A^{t} At会影响MPC动作偏差的调整,随着车辆的动作与提供的指导相互接近,代价会降低: r b i a s ( b i a s , ψ ) = b i a s − ψ C b i a s = w b i a s ∣ r b i a s ∣ 2 r_{bias}(bias,\psi)=bias-\psi\\C_{bias}=w_{bias}\vert r_{bias}\vert_{2} rbias(bias,ψ)=bias−ψCbias=wbias∣rbias∣2其中, b i a s bias bias表示加速或者转向,值得注意的是,预定义场景集虽然数量有限,但足够抽象和广泛,可以涵盖广泛的驾驶场景,因为它们不代表特定的场景,但具备MPC应该执行动作偏差的确定性。

实验

实验使用IdSim生成场景地图和交通流。在单车辆决策的背景下,对三种不同的方法进行了评估:基于强化学习的规划,模型预测控制,以及该研究提出的系统LLM+MPC。其中,RL在大范围复杂交通场景中进行了训练和验证,MPC在实车实验中进行了微调和验证。每一种方法都在不同的场景下进行了测试,包括有信号的十字路口、无信号的十字路口、车道、紧急规避和环形交叉路口。作者为每个场景类型选择了25个复杂且具有挑战性的案例,以全面评估系统性能。

单车辆决策的定量结果如表1所示。LLM+MPC在四种场景类型中实现了总体代价的降低。在非紧急情况下,观察到最小的故障发生概率。在紧急情况下,LLM+MPC显著降低了事故率,表明了它在避障方面的有效性。

- 表1:单车辆决策的评估。SI指有信号交叉口,USI指无信号交叉口,EOA指紧急避障。对于所有的参数,越低越好。

具体来说,在十字路口,主要关注的是左转弯的情况,在这种情况下,AD车辆固有地拥有较低的路权地位,需要根据既定的交通规则选择减速和让步。在十字路口和环形交叉路口的左转弯情况下,虽然LLM+MPC可能会导致运行时间的轻微增加,但它在提高交通流量效率和减少安全处罚方面产生了实质性的好处。在车道上(Lane),LLM+MPC在所有指标上都表现出色,表明了超车和变道的效率。最后,在紧急情况下,LLM+MPC通过降低事故率和提高整体性能来证明其有效性。