今天分享的AI系列深度研究报告:《AI大模型专题报告:AI大模型及应用加速落地,持续带动算力产业链发展》。

(报告出品方:长城证券)

报告共计:23页

1.行业观点

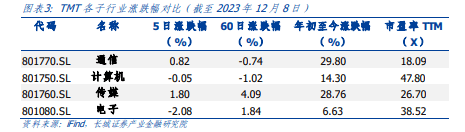

在 TMT 各子板块:电子、通信、传媒以及计算机中,通信周涨幅居第二位。

1.1本周策略观点速览

1.1.1 谷歌 AI大模型 Gemini没布,持续看好算力产业链投资机会

12月6日,谷歌 CEO 皮查伊和 DeepMind CEO 哈萨比斯在歌官网联合发文称将正式推出AI大模型 Gemni,并针对Gemini1.0推出三种不同尺寸的优化模型 GeminiUtraGeminiPro 和 Gemini Nano,Gemini作为歌重新构建的多模态大模型,可以概括和无缝地理解、操作和组合不同类型的信息,包括文本、代码、音频、图像和视频,能够满足从数据中心到移动设备的多种终端的高效运行。谷歌积极推进 Gemini的应用,努力进一步扩展未来版本的各种功能,加速落地 Bard、Pixel 8 Pro 等各产品,预计在 2024 年初将向开发者和企业客户提供 Gemini Ultra,此外,我国为应对多模态这一技术发展趋势,云厂商、创新企业、AI企业、大数据企业和传统软件企业都在积极布局多模态技术研发和应用。

我们认为,算力作为多模态 的关键基石,随着海内外各厂商对多模态技术的积极推进当前算力需求的最气度有望持续,带动算力基础设施产业发展,相关产业链有望持续受益

1.1.2 AMD 发布专为尖墙人工智能设计芯片,国内 AI 芯片产业持续发展

12 月6日,AMD在“推进人工智能”的活动中,发布了专为尖端人工智能设计系列芯片Instinct MI300X 和 Instinct M300A 两款产品,标志着世界上首个数据中心级的 APU加速处理单元的问世,目的是为抓住日益增长的生成式人工智能和高性能计算领域的机遇,MI300 系列产品是 AMD 运用前沿的生产技术,结合了创新的“3.5D”封装技术,打造出的多芯片组合。公司称该系列产品在执行各类人工智能任务时,其性能超越了竞争对手英伟达,在活动中,AMD 与多家合作伙伴在活动期问共同强调了 AMD Instinct数据中心人工智能加速器的强劲应用和增长势头,其中合作伙伴包括: 微软、Meta、甲骨文、戴尔、联想等科技巨头。

我们认为,随着国内外科技巨头大模型多模态能力的加速进展,国内厂商持续加速送代产品技术能力有望从上游解决当前算力需求旺盛的供给问题,国产化替代或将持续劳动算力基础设施产业发展。

2.本周专题解析

2.1 谷歌 AI大模型 Gemini 发布,持续看好算力产业链投资机会

2.1.1 谷歌 Gemini能力进展迅速,多模态能力得到大幅提升

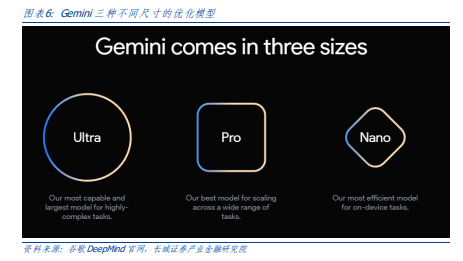

12月6 日,谷歌 CEO 皮查伊和 DeepMind CEO 哈萨比斯在谷歌官网联合发文称将正式推出AI大模型 Gemni,并针对 Gemini1.0 推出三种不同尺寸的优化模型 GeminiUltra.GeminiPro 和 GeminiNanoGemini作为谷歌重新构建的多模态大模型,可以概括和无缝地理解、操作和组合不同类型的信息,包括文本、代码、音频、图像和视频,能够满足从数据中心到移动设备的多种终端的商效运行。

DeepMind 成立于 2010 年,公司采用跨学科方法构建通用人工智能系统,汇集了机器学习、神经科学、工程学、数学、模拟和计算基础设施方面的新思路和新进展,以及组织科学工作的新方法。DeepMind 使命是负责任地构建人工智能以造福人类,其愿景是通过解决当代艰巨的科学和工程挑战,努力创造突破性技术,以推动科学发展、改变工作方式,服务不同社区,并改善数十亿人的生活。2015 年,DeepMind 发布了首个击败围棋世界冠军的计算机程序 AhaGo,开启了人工智能的新时代,其后续版本 AhaZero和 MuZero 越来越具有通用性,能实现压缩视频甚至是发现新的更高效的计算机算法,此外,公司通过 PaLMSayCan 在机器人系统中使用大型语言模型,以及通过RT-2 创建更通用的视觉语言动作模型,推动了机器人技术的发展,如今的 DeepMind 正积极利用其先进的计算基础设施,持续推进创造下一波研究突破和变革性的产品,持续打造公司愿景的实现。

Gemini 是包括 Google Research 在内的谷歌各团队间进行合作的成果,该模型从一开始 就被创建为多模态的模型,可以归纳并流畅地理解、操作以及组合不同类型的信息,包 括文本、代码、音频、图像和视频。Gemini 能够达到从数据中心到移动设备,都能够高 效运行的水平,其先进的功能将显著改善开发者和企业客户通过 AI 构建和扩展的方式。 公司针对三种不同的尺寸对第一代 Gemini 1.0 进行了优化:

✓ Gemini Ultra — 谷歌规模最大且功能最强大的模型,适用于高度复杂的任务。

✓ Gemini Pro — 谷歌适用于各种任务的最佳模型。

✓ Gemini Nano — 谷歌端侧设备上最高效的模型。

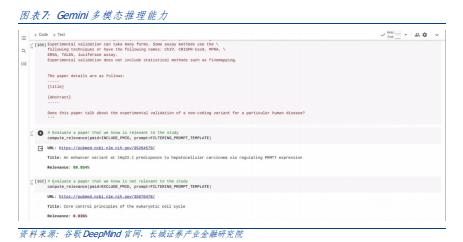

创建多模态模型的标准方法是分别训练不同模态的组件,随后拼接在一起,以粗略模拟 某些功能。这些模型有时可以很好地完成描述图像等特定任务,但在概念性更强、更复 杂的推理方面却显得力不从心。谷歌将 Gemini 设计为原生多模态,从一开始就在不同模 态上进行预训练。利用额外的多模态数据对其进行微调,以进一步提高其有效性,有助于 Gemini 从最初阶段就能对输入的各种内容顺畅地进行理解和推理。Gemini 1.0 主要具 有以下三大亮点:

1. 复杂的多模态推理能力:Gemini 1.0 可帮助理解复杂的书面和视觉信息,可以在海 量的数据中发掘难以辨别的知识内容。拥有通过阅读、过滤以及理解信息,从数十 万份文件中提取见解的卓越能力,将有助于在从科学到金融等多个领域以数字化速 度实现新的突破。

2. 理解文本、图像、音频等能力:Gemini 1.0 经过训练,可以同时识别并理解文本、 图像、音频等,因此能更好地理解具有细微差别的信息,回答与复杂主题相关的问 题,尤其擅长解释数学和物理等复杂科目中的推理。

3. 高级编码能力:Gemini 可以理解、解释和生成编程语言的高质量代码,其中包括 Python、Java、C++以及 Go 等,能够跨语言工作并对复杂信息进行推理使其成为 世界领先的编码基础模型之一。Gemini Ultra 在多个编码基准测试中表现出色,包 括 HumanEval(用于评估编码任务性能的重要行业标准)和 Natural2Code(谷歌内部的留出数据集),其中 Natural2Code 使用作者生成的信息作为来源,而不是基于 网络的信息。Gemini 还可用作更高级编码系统的引擎。谷歌利用一个专门版本的 Gemini,创建了更先进的代码生成系统 AlphaCode 2,该系统擅长解决不仅需要编 码能力而且也需要复杂数学和理论计算机科学知识的竞赛性编程问题。

在与最初的AlphaCode在同一个平台上进行评估时,AlphaCode 2 表现出了巨大的改进, 其解决的问题数量几乎是 AlphaCode 的两倍,谷歌预计其性能超过 85%的参赛者,比 AlphaCode 高出将近 50%。当程序员与 AlphaCode 2 合作并为示例代码定义某些属性时, AlphaCode 2 的表现甚至更好。

2.1.2 谷歌不断提升自研能力,稳步推进 Gemini 大模型的应用

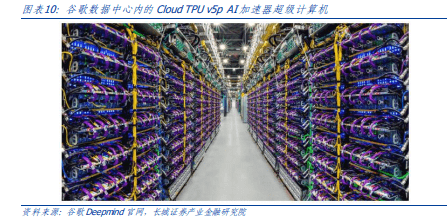

谷歌设计的 TPUs v4 和 v5e 在通过 AI 优化过的基础设施上对 Gemini 1.0 进行了大规模 训练。在 TPUs 上,Gemini 的运行速度明显快于早期规模更小、性能更弱的模型,其定 制设计的 AI 加速器一直是谷歌服务数十亿用户的 AI 赋能产品的核心,其中包括搜索、 YouTube、Gmail、Google 地图、Google Play 以及安卓,帮助世界各地的公司能够经济 高效地训练大规模的 AI 模型。公司还同时发布了迄今为止功能最强大、效率最高且可扩 展性最强的 TPU 系统之一:Cloud TPU v5p,旨在为训练前沿 AI 模型提供支持。新一代 TPU 将加速 Gemini 的开发,帮助开发者和企业客户更快地训练大规模生成式 AI 模型, 从而更快推出新产品和新功能。

谷歌积极推进 Gemini 的应用,努力进一步扩展未来版本的各种功能:

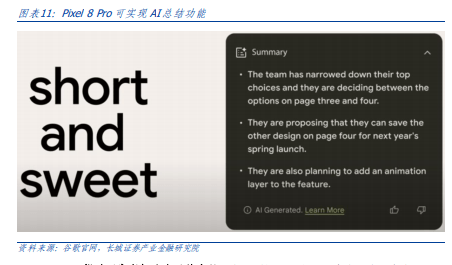

➢ Gemini落地谷歌各产品:Bard将使用Gemini Pro 的微调版本来进行更高级的推理、 规划和理解等,将在 170 多个国家和地区提供英语服务,谷歌计划在未来几个月内 扩展不同的模态,并支持新的语言和地区。此外,谷歌还在 Pixel 上搭载了 Gemini。 Pixel 8 Pro 是首款搭载 Gemini Nano 的智能手机,可以支持录音应用中的“总结” 等新功能,并在 Gboard 中推出“智能回复”功能,谷歌预计 2024 年还将推出更 多信息应用。未来几个月,Gemini 将应用于谷歌更多的产品和服务,如搜索、广告、 Chrome 浏览器和 Duet AI。公司已经开始在搜索中试验 Gemini,为用户提供更快的搜索生成体验。

✓ Gemini 帮助开发者打造自己的产品:自 12 月 13 日起,开发者和企业客户可以通 过 Google AI Studio 或 Google Cloud Vertex AI 中的 Gemini API 获取 Gemini Pro。 Google AI Studio 是一款基于网络的免费开发者工具,可使用 API 密钥快速创建原 型并启动应用程序。当需要一个完全托管的 AI 平台时,Vertex AI 允许对 Gemini 进行定制,提供全面的数据控制,同时受益于谷歌云的功能,可实现企业安全性、 保密性、隐私性以及数据治理和合规性。安卓开发者还可以通过 AICore(Android 14 中的一项新的系统功能)使用谷歌端侧任务最高效的模型 Gemini Nano。

✓ 持续推进 Gemini Ultra 落地:谷歌目前正在完成一系列的安全检查,其中包括由 外部团队进行红队测试,并在其被广泛使用前通过微调和人类反馈强化学习(RLHF) 进一步完善模型。在模型的完善过程中,公司将向部分客户、开发者、合作伙伴以 及安全专家提供 Gemini Ultra,以供其进行早期试验和提供反馈,谷歌预计在 2024 年初将向开发者和企业客户提供该模型。此外,公司还将推出 Bard Advanced,一 种全新的、前沿的 AI 体验,让用户可以从 Gemini Ultra 开始使用公司最佳的模型和功能。

2.1.3 AI 向多模态变革,算力骨求持续火热

AI模型走向多模态必然性的三大因素: 跨模态任务需求+跨模态数据融合+对人类认知愧力的模拟。据乐睛智库显示,多模态学习以多模态大规模数据为基础,同时利用多种感官进行学习,提供更丰富信息,除传统的语言以及图像问的交互作用,其结合声音、能觉以及动作等多维度信息进行深度学习,从而形成更准确、更具表现力的多模态表示。相比于单模态,多模态模型处理多种数据输入,结构上更复杂,可能涉及使用多个子网络,然后将其输出合井,多模态模型的核心是处理和整合这些不同类型的数据源,这种模型可以捕获跨模态的复杂关系,使机器能够更全面地理解和分析信息,从而在各种任务中表现得更好。

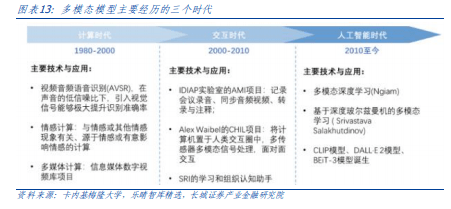

多模态模型根据技术迭代可以分为三个主要发展阶段,2010 年至今,深度学习为多模态研究带来了巨大的推动力,多模态模型已经达到了前所未有的准确性和复杂性。这一阶段受益于四个关键因素的推动:

1)大规模的多模态数据集;

2)更强大的计算能力;

3)研究者也开始掌握更为先进的视觉特征提取技术;4)出现了强大的语言特征抽取模型包括 Transformer 架构。

2023 年,根据财联社数据显示,已有多个多模态 AI 应用惊艳亮相,其中包括 Pika 和三 大图片转视频应用:阿里的 Animate Anyone、字节跳动的 Magic Animate 以及微软的 GAIA。11 月 29 日,据电子发烧友官网显示,美国 AI 初创公司 Pika labs 发布了全新的 文生视频产品 Pika 1.0,这款产品能够生成和编辑 3D 动画、动漫、卡通和电影。用 Pika 1.0 制作视频几乎不需要任何门槛,用户只需要输入一句话,就可以生成想要的各种风格的视频,并通过简单的描述,更改视频中的形象和风格。

此外,多家科技公司在文生视频领域也取得新的进展,其中包括: Meta 发布工具 EmuVideo,能够基于文本和图像输入生成视频剪辑; Runway 在 Gen2 中上线 Motion Brush动态笔刷功能,只需对着图像任意位置一刷,就能让静止的一切物体动起来; Stable AI推出 Stable Video Dffusion,可以从图像中生成高品质的视频剪辑。

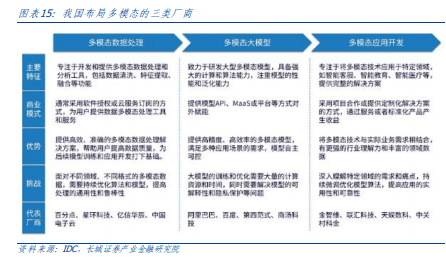

据 IDC 数据,我国为应对多模态这一技术发展趋势,云厂商、创新企业、AI企业、大数据企业和传统软件企业都在积极布局多模态技术研发和应用,这些企业、机构在多模态厂商生态中扮演着不同的角色,通过相互合作、优势互补,共同推动多模态技术的发展。

据 IDC 数据显示,我国智能算力规模正在高速增长。2021 年我国智能算力规模达 155.2 每秒百亿亿次浮点运算(EFLOPS),2022 年智能算力规模将达到 268.0 EFLOPS,预计 到 2026 年智能算力规模将进入每秒十万亿亿次浮点计算(ZFLOPS)级别,达到 1,271.4 EFLOPS。预计 2021-2026 年期间我国智能算力规模年复合增长率将达 52.3%,同期通用算力规模年复合增长率为 18.5%。

2.2 AMD 发布专为尖端人工智能设计芯片,国内 AI 芯片产业持续发展

2.2.1 AMD 发布 MI300 系列芯片,多项性能测试超过英伟达

12 月 6 日,AMD 在“推进人工智能”的活动中,发布了 Instinct MI300X 和 Instinct MI300A 两款产品,标志着世界上首个数据中心级的 APU(加速处理单元)的问世,目的是为了 抓住日益增长的生成式人工智能和高性能计算领域的机遇。MI300 系列产品是 AMD 运用前沿的生产技术,结合了创新的“3.5D”封装技术,打造出的多芯片组合。公司称该系列产品在执行各类人工智能任务时,其性能超越了竞争对手英伟达。

AMD Instinct MI300A APU:专为高性能计算(HPC)设计的 APU

AMD Instinct MI300A APU 是专为处理大型数据集而设计的,非常适合用于计算密集型 建模和高级分析。MI300A 采用了创新的 3D 芯片组设计,将 3D 堆叠的“Zen 4”x86 CPU 和 AMD CDNA 3 GPU XCD 集成到同一个封装中,并配备了高带宽内存(HBM)。AMD Instinct MI300A APU 拥有 24 个 CPU 核心和 14,592 个 GPU 流处理器。这种先进的架构 为 MI300A 加速器提供了突破性的性能、密度和能效,非常适合加速高性能计算(HPC) 和人工智能应用,并有望被世界上最大、最可扩展的数据中心和超级计算机所利用,以 促进医疗保健、能源、气候科学、交通、科学研究等领域的发现、建模和预测,其中包括为即将上线的、预计是世界上最快的之一的两百万亿次每秒的 El Capitan 超级计算机提供动力。

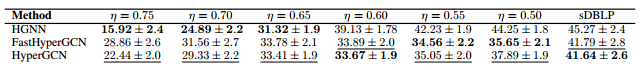

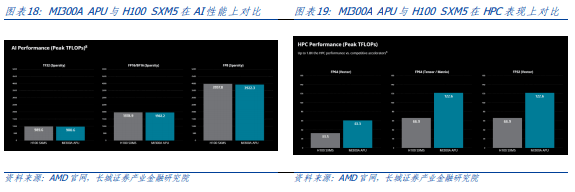

从性能表现上来看,AMD MI300A APU 虽在 AI 表现上略低于其竞品英伟达 H100 SXM5, 但从 HPC 表现结果来看,都显著高于 H100 SXM5,最高达到 1.8 倍。

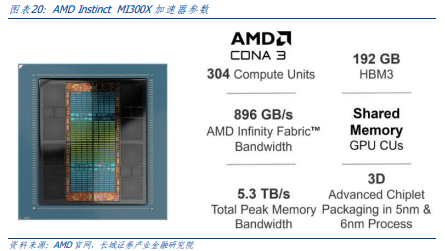

AMD Instinct MI300X 加速器:为尖端人工智能而设计

AMD Instinct MI300X 加速器专为大型语言模型和其他需要在大规模数据集上进行训练 以及大规模推理的尖端人工智能应用而设计。为实现这一目标,MI300X 在 MI300A 的基础上,用两个额外的 AMD CDNA 3 XCD 芯片组替换了三个“Zen 4”CPU 芯片组,并增 加了 64GB 的 HBM3 内存。凭借高达 192GB 的内存,创建了一个优化的 GPU,能够运行 更大的 AI 模型。在内存中直接运行更大的语言模型可以让云服务提供商和企业用户在每个 GPU 上运行比以往更多的推理任务,从而减少所需 GPU 的总数,加快推理性能,并帮助降低总体拥有成本(TCO)。

报告共计:23页