论文链接:

https://arxiv.org/pdf/2308.14575.pdf

代码链接:

https://github.com/fawnliu/TRIS

基本概念:Referring Image Segmentation(RIS)是一种图像分割技术,旨在根据自然语言表达来标记图像或视频中表示对象实例的像素。也就是根据自然语言描述来实现图像分割。

与一般图像分割的区别:RIS 可以通过自然语言引导对不同对象进行分割,例如,有一张包含两只猫的图片,一只黑猫和一只白猫。一般图像分割模型会将两只猫都标记为“猫”,而不进行更精细的区分。但在 RIS 中,如果给定参考表达式“白色的猫”,模型将仅标记白色的猫。

问题:RIS 图像分割技术的 label,除了分割对象的自然语言描述,还需要大量的像素级标注,而像素级标注成本相当高。限制了 RIS 技术的发展。

解决方案:提出一个新的弱监督 RIS 框架,只使用文本描述监督情况下,实现与现有完全监督 RIS 方法相当的表现,且优于最新的弱监督方法。

前景展望:视觉语言大模型已有长足发展,已有很多视觉语言大模型可以进行 VQA 或者对图像进行结构化问答,如果按照本文思路,后续可能的应用:给一个数据集,一个描述,视觉语言大模型就可以返回你想要的结果,比如框,前景 mask 等。

比如你正在做手势识别项目,拍摄了大量手势相关图像,将图像输入给视觉语言大模型,给视觉语言大模型一个 prompt:请输出所有图像中的手部框,手部 mask。视觉语言大模型就端到端返回你想要的结果。再多想一层:如果算力够的话,是不是就不需要专门的检测分类分割之类的图像处理任务,只通过自然语言描述就可以实现想要的任何图像任务结果?

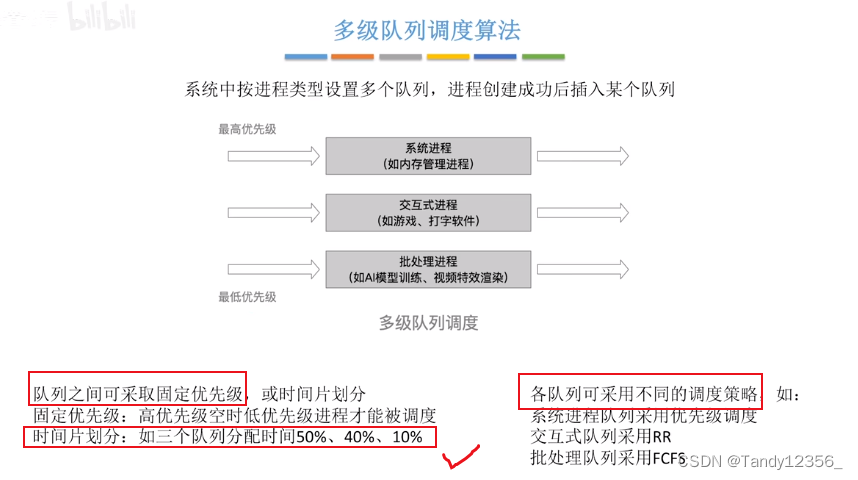

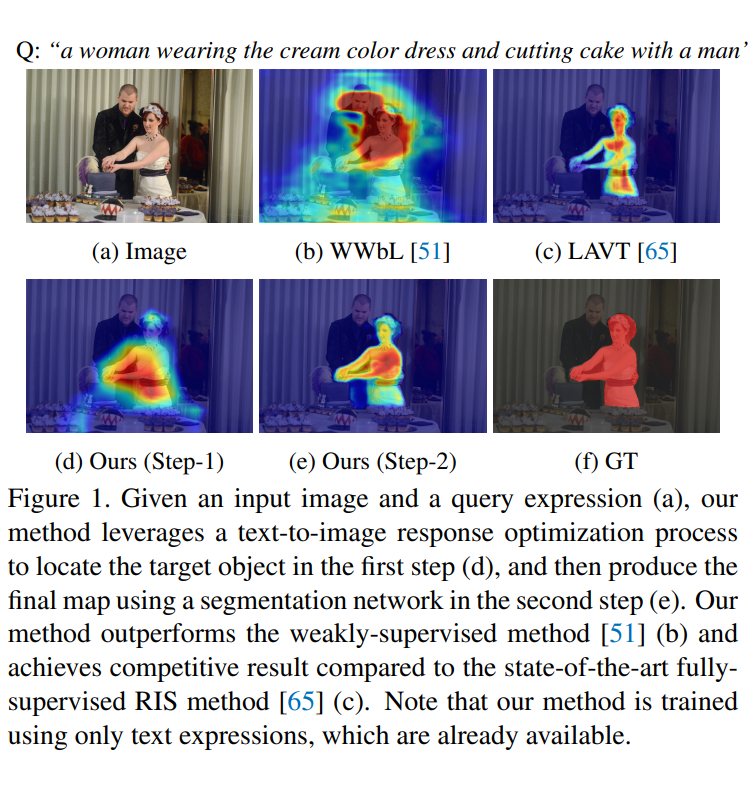

图 1 所示,本文方法可以准确地定位目标对象并生成分割图。尽管它只使用文本描述进行训练,但结果与完全监督方法相当。本文主要贡献如下:

提出了一种新的弱监督 RIS 框架,它只使用现成可用的文本语言进行监督,不需要任何额外标注。

本文的框架有三个主要的技术创新点。首先,提出双向提示方法来协调视觉和语言特征的域差异。其次,提出校准方法来提高响应图定位目标的正确性。最后,提出响应图选择策略来生成高质量的伪标签,用于目标对象的分割。

本文提出一种新的指标来评估定位精度。大量实验表明,本文框架与以前的完全监督 RIS 方法相比可以产生可行的结果,并且优于从相关任务改编的现有弱监督基线。

本文框架

弱监督 RIS 任务的主要目标是在没有像素级标注(使用框级标注,涂鸦,点,类别标签)的情况下建立图像内容与输入文本表达式之间的像素级关联。本文框架旨在通过学习对每个输入图像进行正样本文本和正样本文本的分类,从而学习根据正样本文本定位图像中的目标对象。正样本文本是用于描述输入图像目标对象的语言表达,而正样本文本是来自其他图像的语言表达。

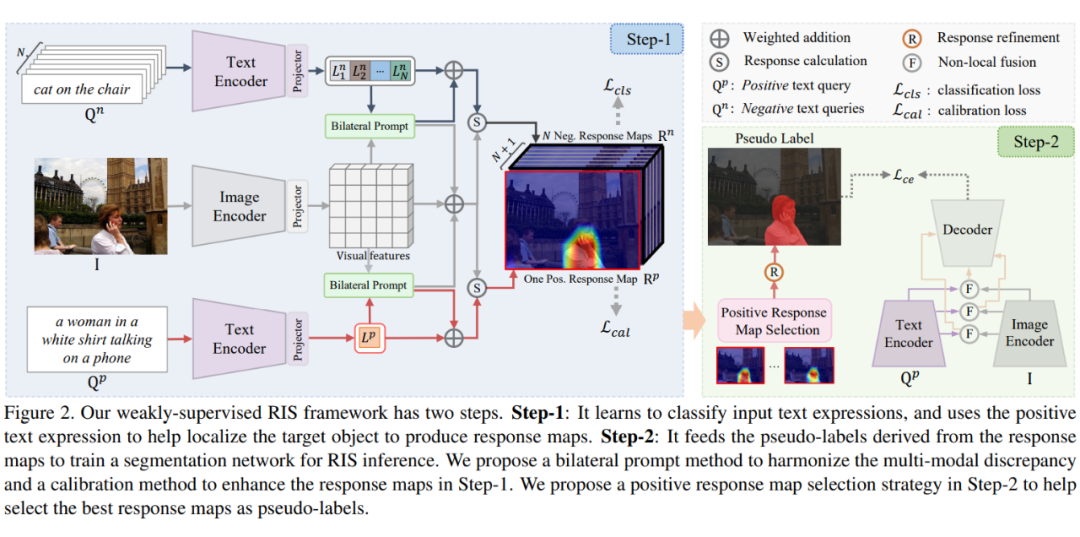

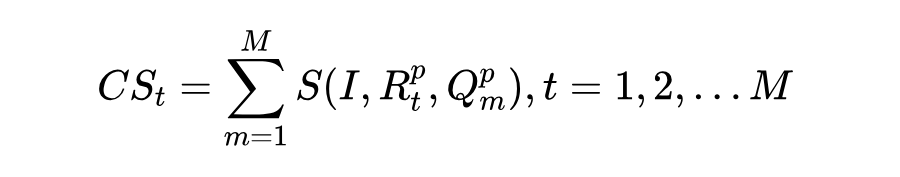

图 2 显示了本文的弱监督 RIS 框架,它分两个步骤。第一步对分类过程中的文本到图像响应建模,以帮助定位目标对象并产生响应图。本文在这一步中提出了双向提示方法,以协调多模态差异,并提出了校准方法以增强响应图。第二步利用第一步中的响应图产生伪标签。这些伪标签然后用于训练分割网络进行 RIS 推理。本文提出了正响应图选择策略,以帮助选择最佳响应图作为伪标签。

1.1 文本到图像响应建模

首先解释如何对文本到图像响应进行建模,这些响应用于根据查询分类过程中的正样本文本来定位目标对象。

给定输入图像 和含有 T 个词的文本表达查询 ,首先用图像编码器 和文本编码器 分别提取视觉特征 和文本特征 ,其中 ,。 和 分别表示视觉特征和文本特征的通道数。 是下采样率。

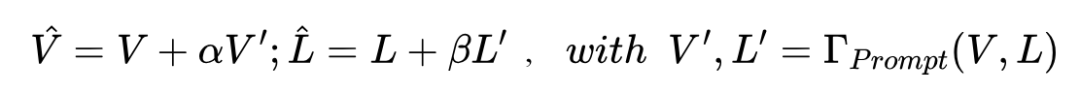

然后,本文使用投影层将 和 转换到统一的隐藏维度 ,即 和 。使用 通道归一化来正则化投影层的输出。为协调域差异,使用双向提示方法(第 1.2 节) 来更新视觉和文本特征:

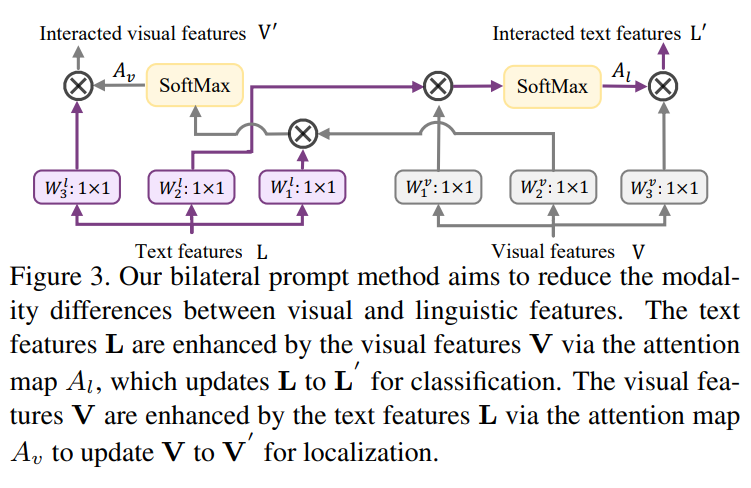

其中 和 分别表示更新后的视觉和文本特征, 和 是控制双向提示比例的权重。 是双向提示方法。现在已经明确地对齐了 和 。重塑后,第i个扁平化像素的 与第j个查询的 之间的响应可以计算为:

其中 ϑ 和 分别表示通道索引和逐元素乘法。采用可学习的温度参数 来缩放并约束 的范围。通过这种方式,建立了每个像素与整个文本表达式 的关系,不同像素将产生不同程度的响应。更高的响应表示像素更有可能属于正样本文本描述的目标对象。

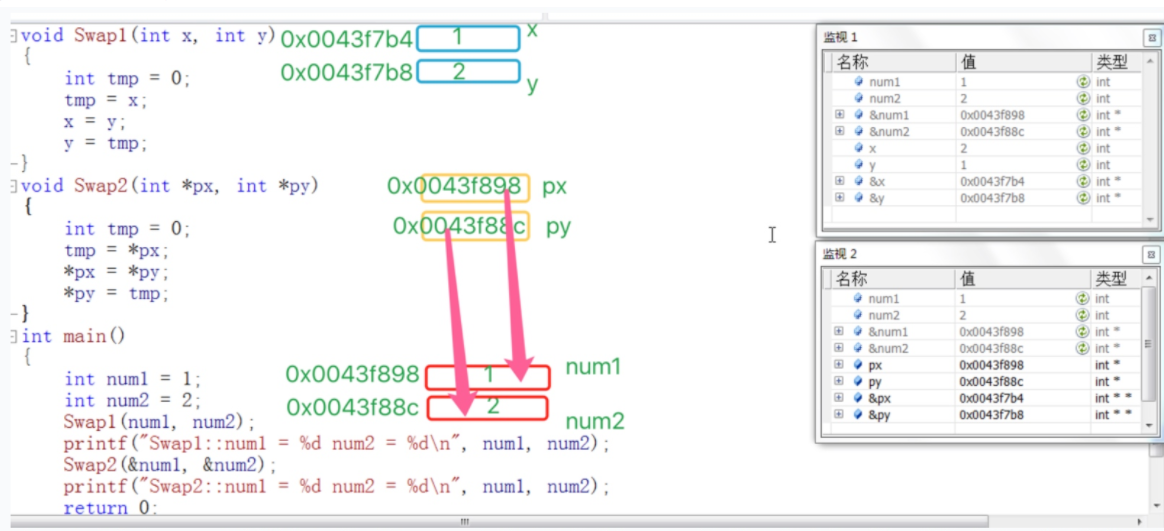

1.2 双向提示

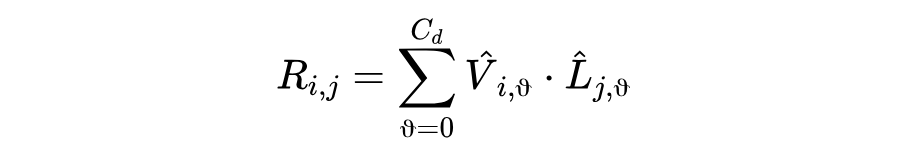

双向提示方法,用于协调视觉特征和文本特征之间的域差异。双向提示方法用一种模态的特征增强另一种模态的特征。用视觉特征增强文本特征有助于分类过程,而用文本特征增强视觉特征有助于定位目标对象。

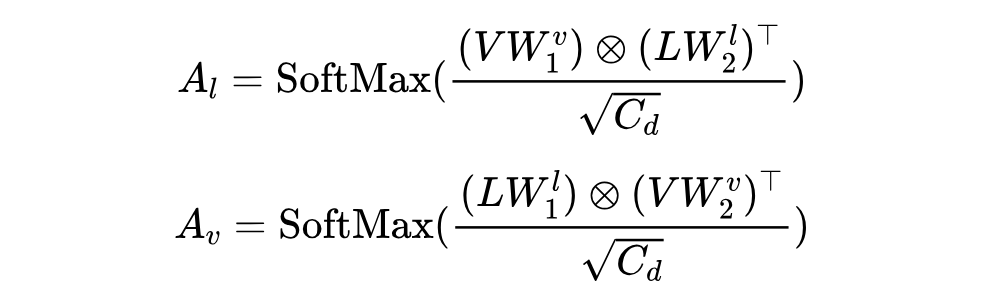

图 3 显示了双向提示方法。给定输入特征 和 ,首先计算两个注意力图:

其中 和 分别表示视觉特征到文本特征和文本特征到视觉特征的关联传播。 和

双向提示方法可以表示为:

其中 Re 是一个形状变换函数, 和 分别表示视觉增强的语言特征和语言引导的视觉特征。通过这种方式,学习到的双向残差(即 和 )可以同时更新视觉和语言特征,有效地协调它们之间的差异。

1.3 通过文本到图像优化进行定位

分类:构建一个分类过程,使网络学习从一组正样本和负样本中选择正样本,其中优化文本到图像的响应图来定位目标对象。以对比学习的方式实现分类过程。使用输入图像 ,正样本文本表达式 作为正样本(或锚点),并从整个数据集中随机采样 N 个负样本文本表达式 (即其他图像的文本表达式)作为负样本。

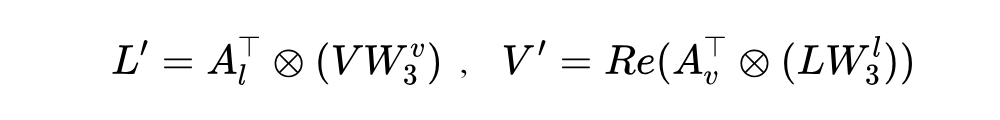

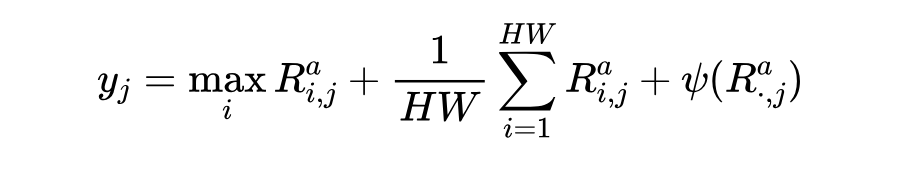

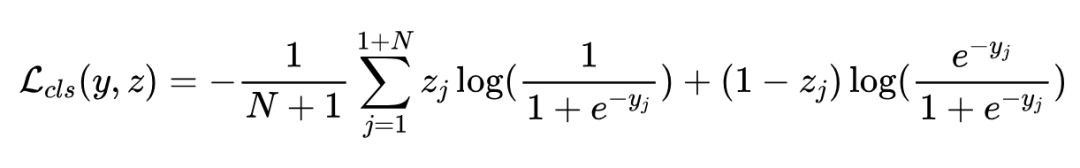

如图 2 所示,计算图像 的响应图 (包括用于正样本文本式 的 ,以及用于负样本文本式 的 )。然后计算每个文本查询 的图像级分数 如下:

其中 , 是正则化项。用来重新平衡负样本和正样本文本查询。 的范围是 0 到 1,越大,当前查询 与输入图像的匹配程度就越好。

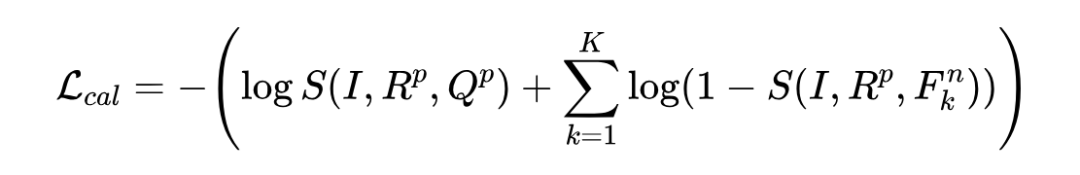

分类过程受到以下监督:

其中 是一个易于获得的监督信号,1 表示正样本查询,0 表示负样本查询。

校准:基于分类过程得到的粗糙响应图,提出校准方法以通过与图像中其他对象(即将它们视为背景噪声)的对比来增强正响应图 的正确性。

具体来说,将输入图像 与 相乘以获得目标对象,并将其用作锚点。使用正样本查询 作为正样本,并额外采样描述同一图像中其他对象的 K 个查询作为负样本(即 ,,,,)。然后校准过程可以表示为:

其中 ,, 是一个用于测量目标对象和查询之间匹配分数的相似函数:

其中 和 是 CLIP 视觉和文本编码器。 和 分别是 Hadamard 乘积和上采样函数。, 计算余弦相似性得分。

式(8)以两种方式校准正响应图。第一项有助于通过鼓励实例级目标对象与正样本查询之间的更高相关性来学习更紧凑的前景区域。第二项通过降低前景对象区域与那些负样本查询之间的匹配分数来抑制其他背景对象的噪声信息。

1.4 伪标签生成和分割

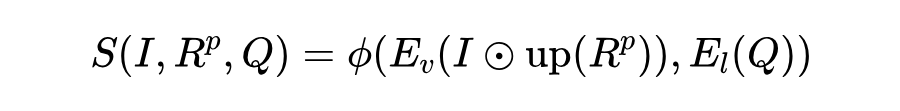

正响应图选择(PRMS):在一个图像中,通常有多个文本表达式可用于引用同一个目标对象,描述目标对象的不同属性。尽管这些表达式对于神经网络来定位目标对象足够具有区分度,但对应的响应图可能不完全相同。因此,= 通过计算累积相似性得分来选择质量最好的响应图。

具体来说,= 首先为每一个包含 M 个正样本查询 的图像计算文本到图像响应 。然后 = 计算它的蒙版目标对象与所有正样本查询的相似度,并对当前响应图的所有对象到文本相似度得分进行求和,以反映当前响应图的准确性:

选择具有最大累积分数 的响应图 作为目标对象的响应图。

分割:使用(Weakly supervised learning of instance segmentation with inter-pixel relations)中的方法来细化响应图,并对响应进行阈值处理以获得伪标签,以训练分割网络进行 RIS 推理。分割网络具有图像编码器、文本编码器、多模态融合模块和解码器。使用与式(9)中相同的编码器,解码器与编码器对称。由于分割网络只需要预测分割图,在最后三个编码器层中使用非局部模块来用文本特征丰富视觉特征,并将它们发送到解码器。用标准的交叉熵损失(Lce)训练分割网络。

实验

2.1 实验设置

数据集:在四个基准测试集上进行实验:ReferIt、RefCOCO、RefCOCO+ 和 RefCOCOg。ReferIt 包含 19,894 张图像,具有 130525 个注释的文本表达式。其他三个数据集都基于 MSCOCO,它们各自包含(图像,注释表达式)为:(19994,142209)、(19992,141564)和(26711,104560)。

RefCOCO 中的表达更关注对象的位置属性,而 RefCOCO+ 中的表达更关注外观。与这两个数据集相比,RefCOCOg 更具挑战性,因为其表达式通常更长更复杂。该数据集有两个分区,即 Google 和 UMD 分区。

实现细节:使用 ResNet-50 作为默认图像编码器,CLIP 初始化图像和文本编码器。双向提示中使用的 α 和 β 均设置为 0.1。分类损失和校准方法中将负样本数设置为 N=47 和 K=6。对于没有足够负样本查询的图像(只有一个对象和表达),从数据集的其余部分随机采样查询以将 K 补充到 6。隐藏维度数为 Cd=1024,下采样比为 s=32。第一步中使用的损失函数为 λ。λ 用于保证训练过程中数值和梯度的等效性,经验性地将 λ 设置为 5。

在 24GB 内存 NVIDIA RTX3090 GPU 上使用 PyTorch 在批量大小为 48 的情况下训练 15 个 epoch。训练中将输入图像调整为 320×320,将每个文本表达式的最大长度设置为 20。网络使用 AdamW 优化器,权重衰减为 1e-2,初始学习率为 5e-5,并采用多项式学习率衰减。两个步骤的训练设置相同。在推理时,将输入图像和查询文本送到第 2 步的分割网络以产生分割图。

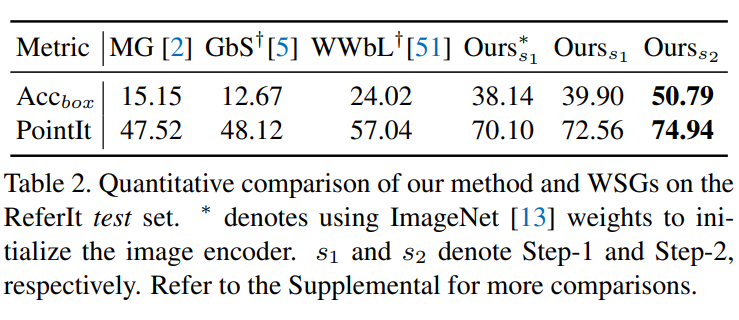

评估指标:采用 MASK INTERSECTION-OVER-UNION(IoU)和 Prec@0.5 (P@0.5)指标来评估分割精度。还使用 POINTING-GAME(PointIt)和 BOX 准确率(Accbox)来测量定位性能。

注意到 PointIt 在任务中倾向于产生不准确的定位分数,因为 PointIt 可以将落在标注框内但不在真值 mask 内的命中计为正确。因此,提出一个新的指标(PointM),公式为:,#Hits 和 #Misses 分别是 Hits 和 Misses 的数量。如果响应图的最大点落在真值 mask 区域内,则将其计为 Hit。否则视为 Miss。

2.2 与SOTA比较

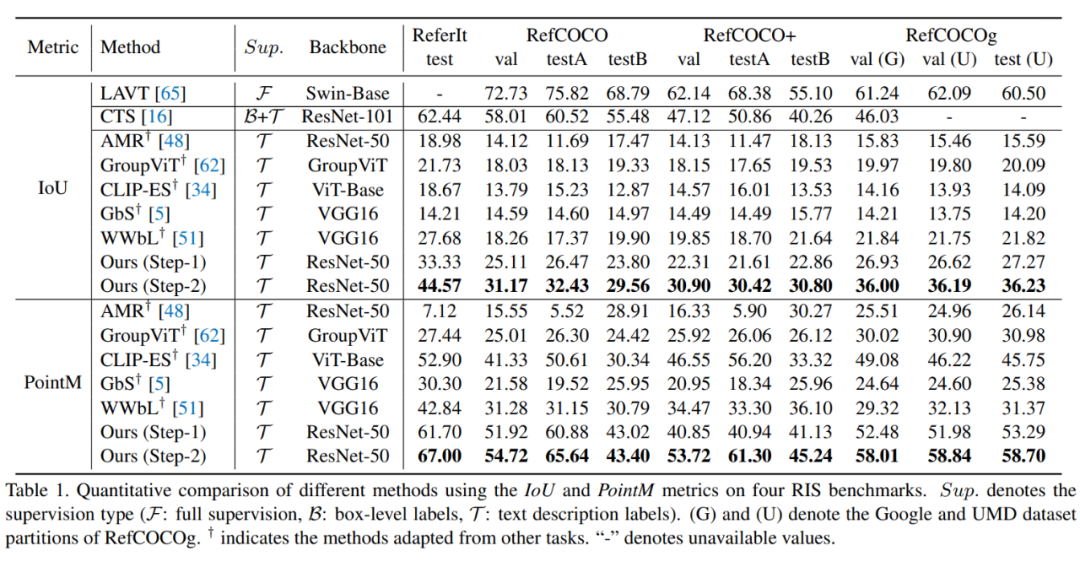

将其与完全监督 RIS 方法(LAVT)、弱监督 RIS 方法(CTS)以及其他相关弱监督方法(MG、AMR、GroupViT、CLIP-ES 、GbS 和 WWbL)进行比较来验证框架有效性。

表 1 报告了不同方法在四个基准测试集上的分割和定位精度的定量比较。与通常仅使用类别标签生成伪标签的现有方法相比,显示出显著性能改进。这是因为它们缺乏区分和推理图像中实例级对象关系的能力,使其适应 RIS 更具挑战性。与基于文本的弱监督方法相比,也表现出优越的性能。例如,在 ReferIt 测试集和RefCOCOg val(G)集上,它分别优于 WWbL 达 16.56 和 14.16 的 IoU 增益。这是由于三个原因。

第一,目标对象定位的形式不同。WWbL 使用的输出相关性图(主要对类别标签建模语义信息)作为监督训练生成响应图。如果未能定位目标对象,则可能不正确。相比之下,本文通过文本到图像优化过程生成的响应图来定位目标对象,这使本文的模型对两种模态的信息更敏感。

第二,双向提示生成语言引导的视觉特征和图像增强的文本特征,用于更好的特征对齐。

第三,利用实例级负样本来抑制噪声背景区域,这可以校准目标的位置,而 WWbL 无法减少背景噪声。尽管 CTS 的性能优于本文方法,但它使用辅助的边界框监督和离线掩码提议网络来分割目标对象。相比之下,本文的方法不从手动标注的 mask 或边界框中学习。该比较表明,仅使用文本就有可能训练 RIS 模型。

此外,还在表 2 中报告了 PointIt和 Accbox 准确性与 WSG 的比较。在 ReferIt 测试集上,本文框架在步骤 1 中相较于 MG、GbS 和 WWbL 分别带来了 25.04、24.44和 15.52 的 PointIt 改进。即使使用预训练的 ImageNet 权重来初始化图像编码器,本文方法仍大幅优于 WWbL(Accbox:14.12;PointIt:13.06)。这表明了本文的框架在定位和分割目标对象方面的有效性。

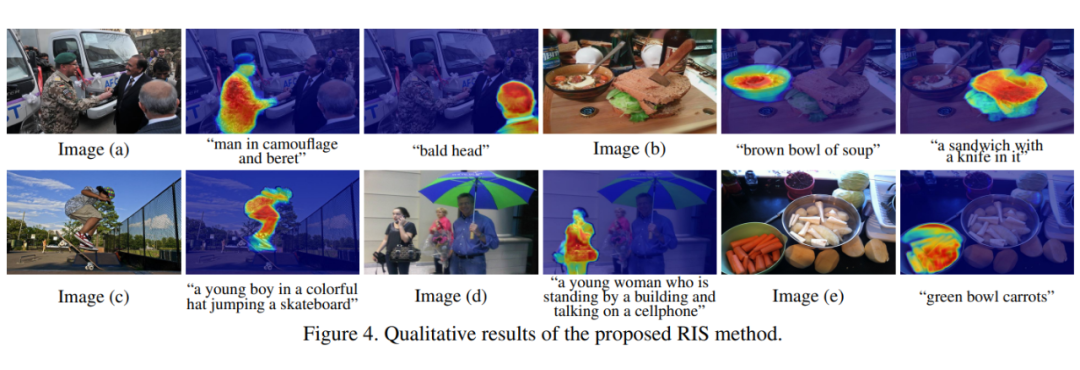

图 4 中显示了一些视觉示例,可以看到,在不需要额外标注训练的情况下,本文方法可以在具有挑战性的场景(例如图像(d)中的长且复杂的句子)中准确定位目标对象,并产生与完全监督方法可比的结果。

结论

本文提出了一种新的 RIS 框架,可仅使用文本描述作为监督信号进行训练。该方法新颖独特,受大语言模型可以理解万事万物影响,后续会不会计算机视觉都受到自然语言引导,如检测、分类,分割,目标跟踪等等,笔者认为这是一个非常明朗的趋势!

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·