今年以来,AI大模型明争暗斗、百花齐放。

但不管各种大模型打的有多厉害,很多人都认为“卖铲子”的英伟达才是最大赢家。

看一下英伟达今年的股票就知道英伟达赚的是多么盆满钵满。

英伟达CEO黄仁勋在发布 H200显卡时,应该是今年最意气风发的人。

但是最近英伟达四面楚歌,“显卡市场”或将被分食,毕竟这块蛋糕实在是太大了,谁都不想错过。

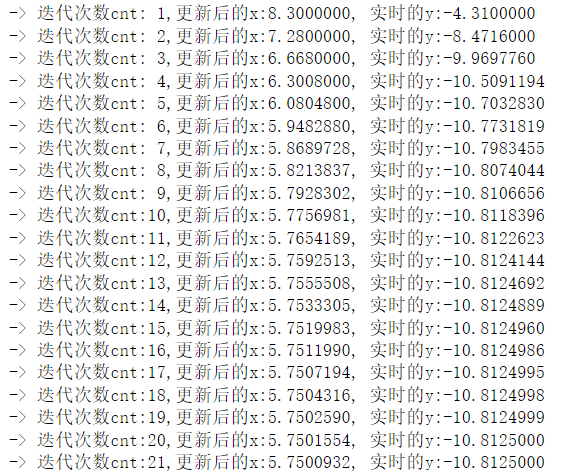

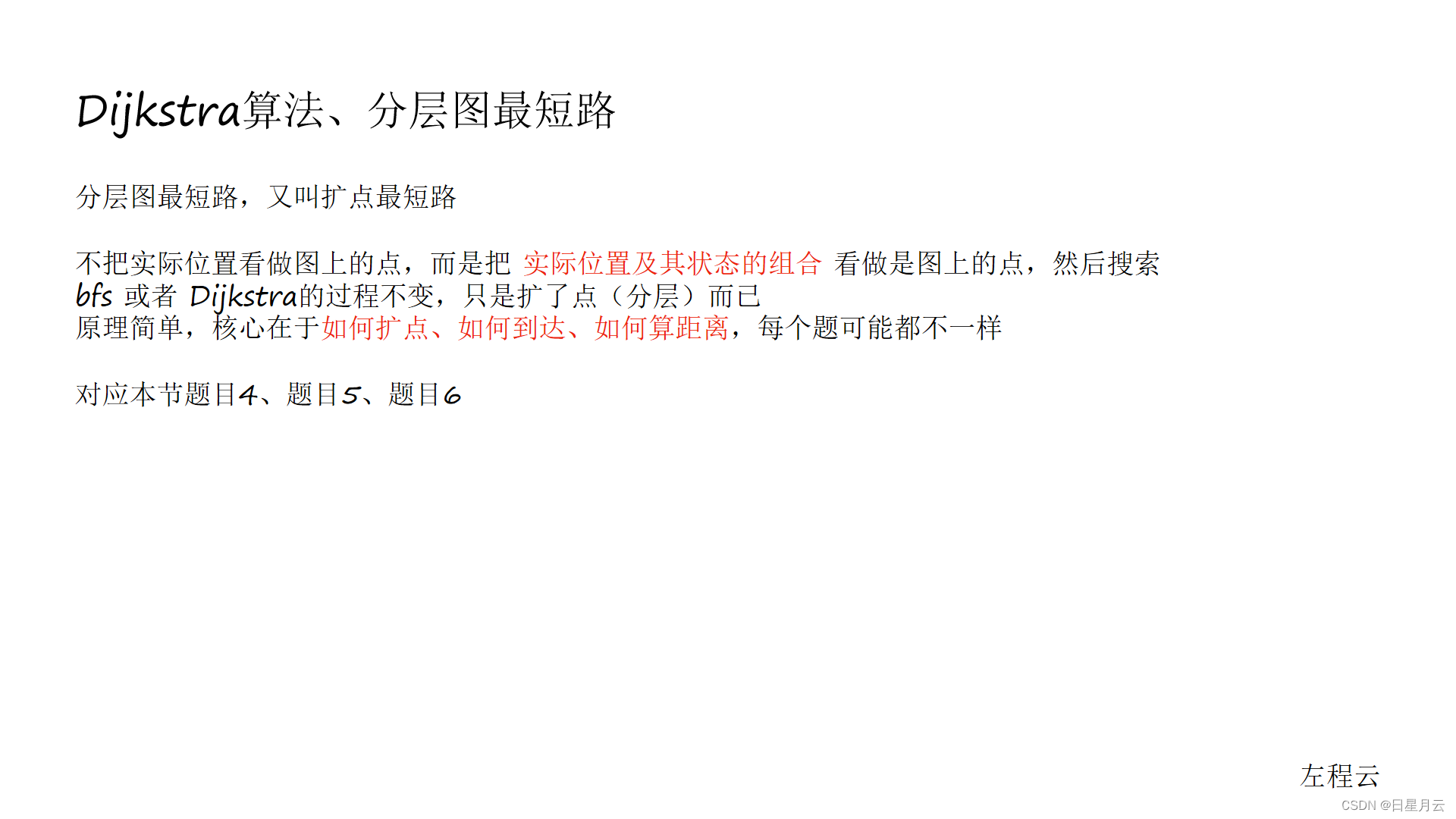

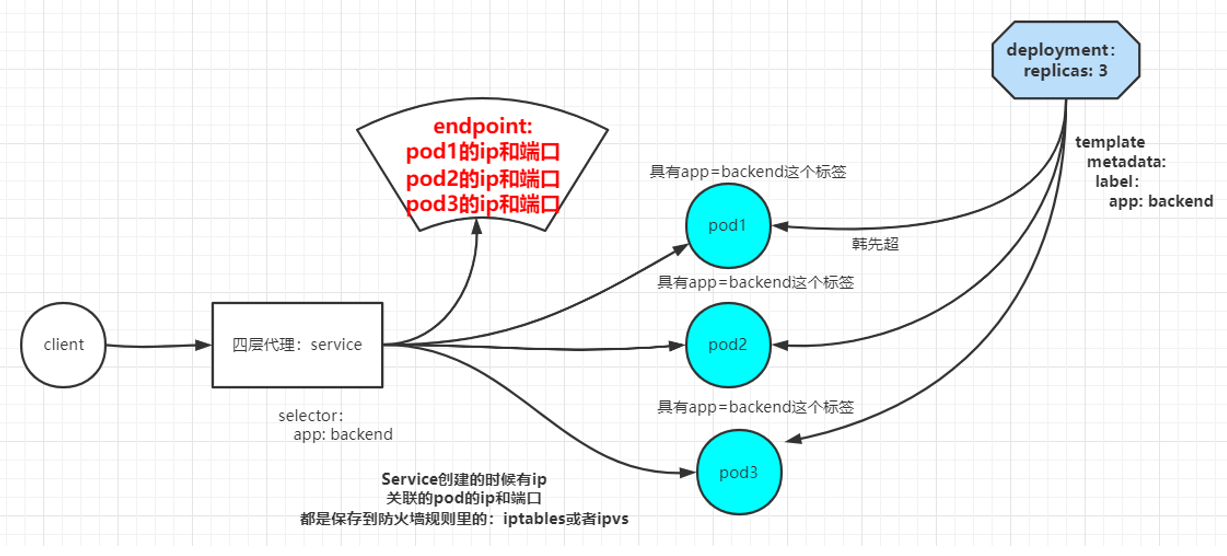

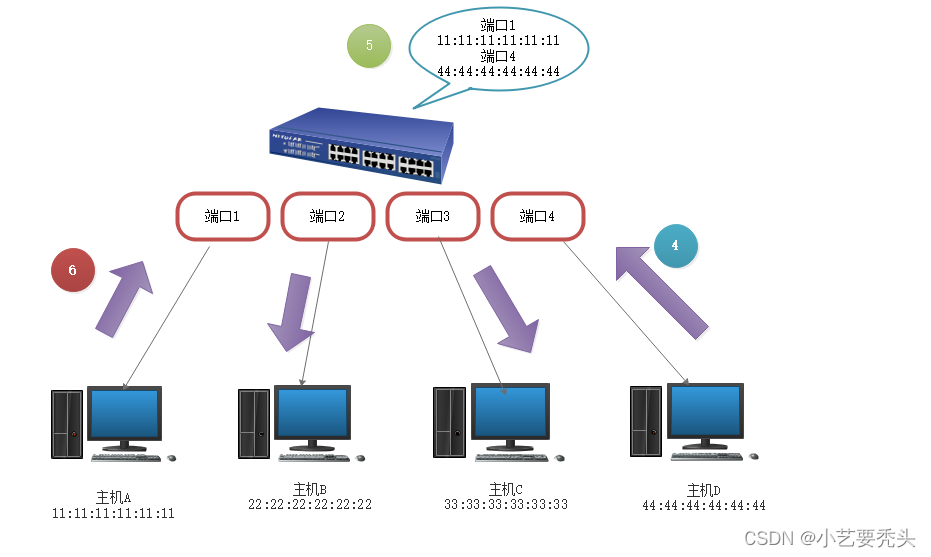

下图是研究公司 Omidia 最近的一份报告,显示了英伟达2023年Q3季度Top12的H100显卡购买客户:

可以看出,购买英伟达显卡的客户基本都是科技巨头。

但是最近英伟达这段时间将面临很多挑战,可能会导致微软、Meta这些科技巨头户及更多客户流失,且竞争力会下降。

1、AMD正面挑战英伟达显卡霸主地位

就在前两天,英伟达在正面交锋中迎来了最强对手——AMD。

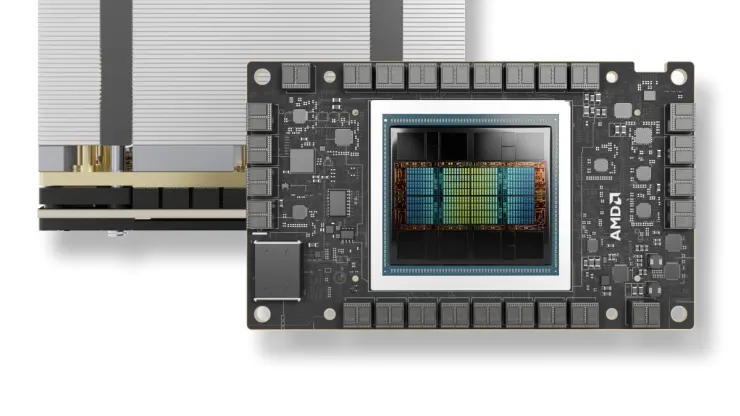

AMD董事会主席兼CEO苏姿丰在一场活动中发布了用于生成式AI和数据中心的新一代Intinct MI300X GPU芯片加速卡。

苏妈称MI300X是业界最先进的AI加速器,拥有1530亿颗晶体管,5.3TB/s峰值内存带宽,内存容量192GB,是H100的2.4倍。

大模型研究测试传送门

GPT-4传送门(免墙,可直接测试,遇浏览器警告点高级/继续访问即可):

http://hujiaoai.cn

图注:AMD MI300X 芯片

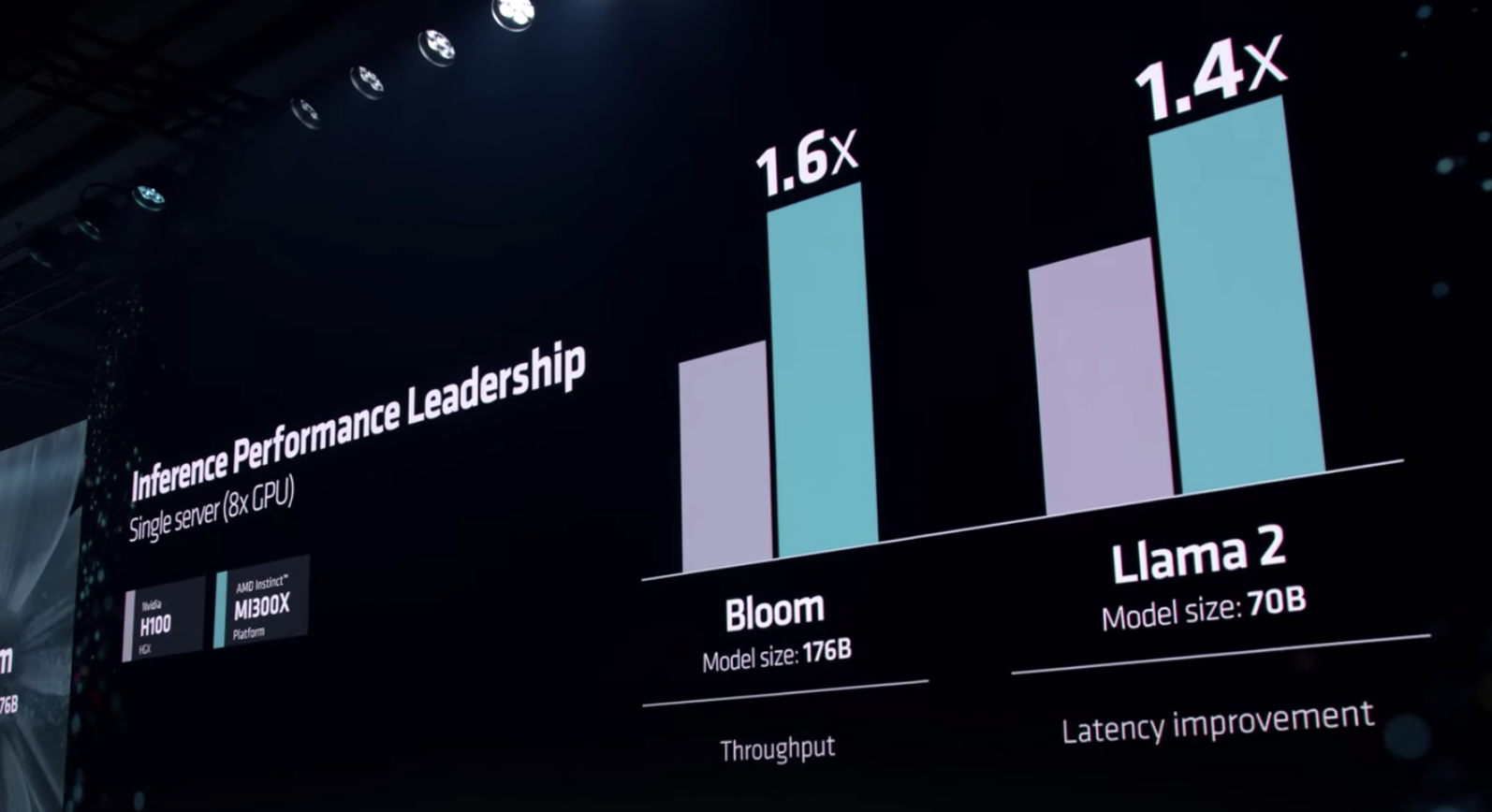

另外,MI300X支持与英伟达相同的连接和网络功能,并在多项硬件规格及大模型训推测试上超过了英伟达。比如在8卡AMD Instinct MI300X在1760亿参数的BLOOM 大语言模型上跑推理任务的性能是英伟达H100 HGX的1.6倍。

对于大家最关心的价格,苏妈透露:“肯定低于英伟达”。

目前,AMD已经向HPE、戴尔、联想、SuperMicro等制造商发货,正式发售时间定于明年第一季度。

Meta及微软将购买使用AMD最新AI芯片

很显然,MI300将在明年初开始发货时足够好且足够便宜,可以降低开发AI模型的成本。

鉴于此,Meta和微软表示,他们将购买使用AMD最新的AI芯片 Instinct MI300X,这意味着在英伟达显卡缺货的情况下,AMD应成为最优先的替代品。

OK,到目前,英伟达预计将会失去Meta和微软这两个最大客户的部分显卡订单。

随后,OpenAI表示,也将购买使用MI300X芯片。

英伟达客户订单再次减1。

2、微软自研AI芯片,软件硬件两手抓

上面谈到微软会购买AMD的最新MI300XAI芯片,但是微软的野心并不止于此。这里先插一句,通过投资OpenAI,微软号称是今年软件层面的最大赢家,这一年来的市值也是蹭蹭往上涨啊。

接着谈微软的野心,既然软件层面有了OpenAI这个最大保障,微软自然想着把野心扩张到硬件层面。

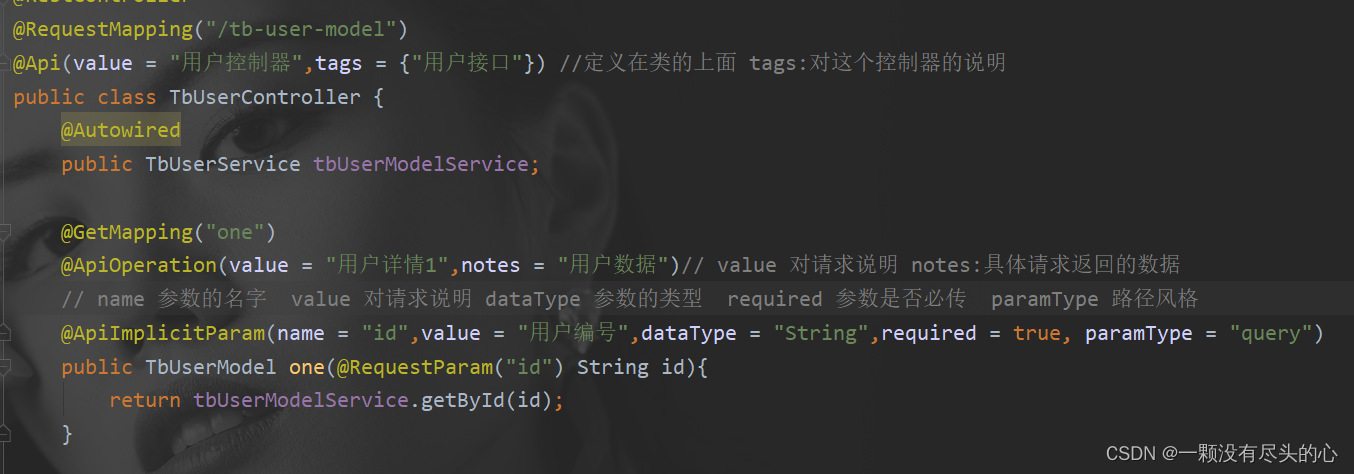

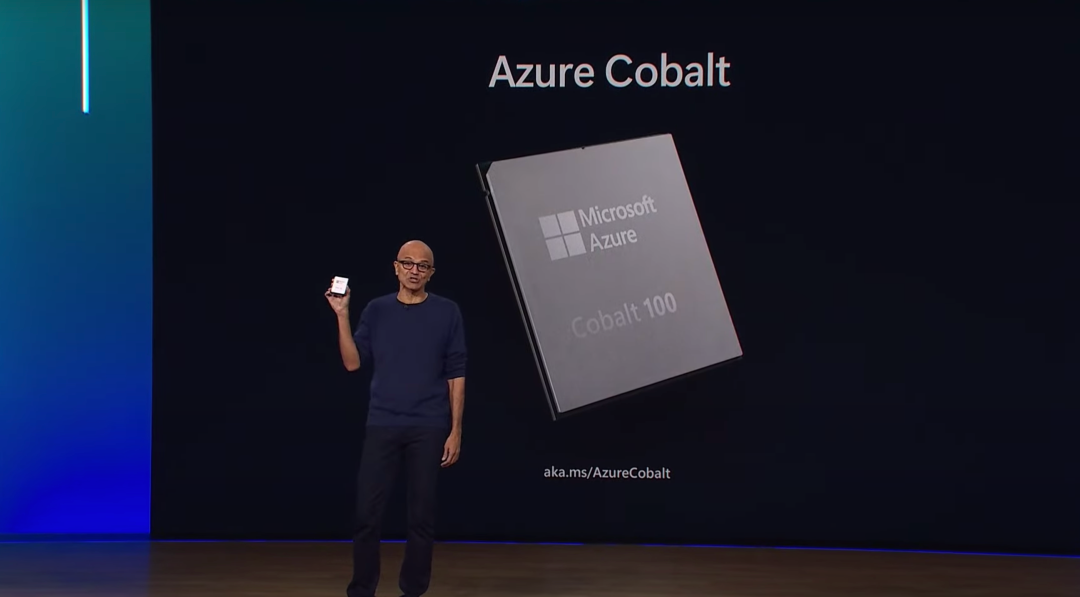

11月中旬,微软CEO Satya Nadella 在年度开发者大会Ignite上官宣推出两款自研AI芯片——Azure Maia 100和Azure Cobalt 100。

Maia100拥有1050亿个晶体管,采用5纳米台积电工艺制造,针对生成式AI专门进行了优化。微软表示,Maia被专门设计用来运行 GPT3.5 Turbo 和 GPT-4 等大语言模型,从而支撑其 Azure OpenAI 服务和 Microsoft Copilot。

Cobalt100是一款基于ARM架构的128核CPU,旨在执行传统计算任务,例如为 Microsoft Teams 提供支持。

微软表示,除了在 Bing和 Office AI 产品上测试该芯片外,OpenAI也正在测试该芯片。Sam Altman表示当微软第一次给他们使用Maia芯片时,感到非常兴奋,并努力在 GPT系列模式上测试。

长期看来,对于微软这个大客户,英伟达的大部分显卡订单注定要减少了。

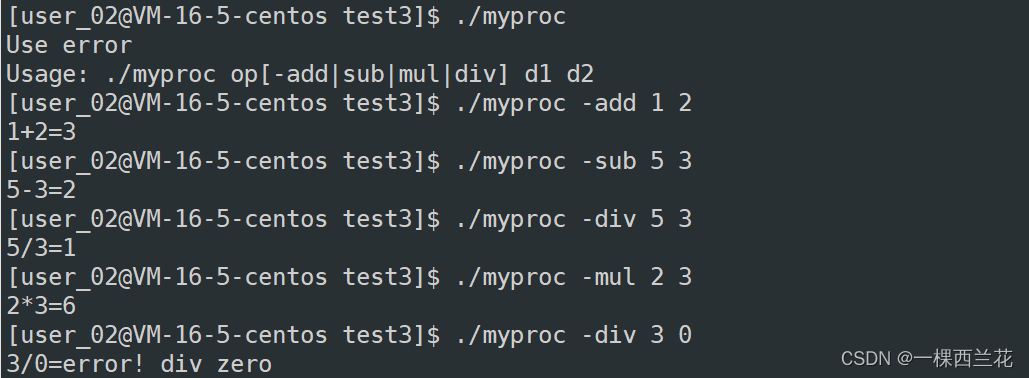

3、谷歌坚持自用TPU,打造下一代最强TPU

谷歌虽然也是英伟达H100的客户,但是谷歌购买英伟达显卡应该更多的是一种防御性策略。强大又傲娇的谷歌在前两天发布了史上最强大最通用的Gemini模型(后来又陷入演示视频造假争议),Gemini模型并没有英伟达的显卡来训练,而是使用了谷歌内部设计的TPU v4 和 v5e,在 TPU 上,Gemini 的运行速度明显快于早期、较小且功能较差的模型。这些定制设计的AI加速器一直是谷歌人工智能产品的核心。

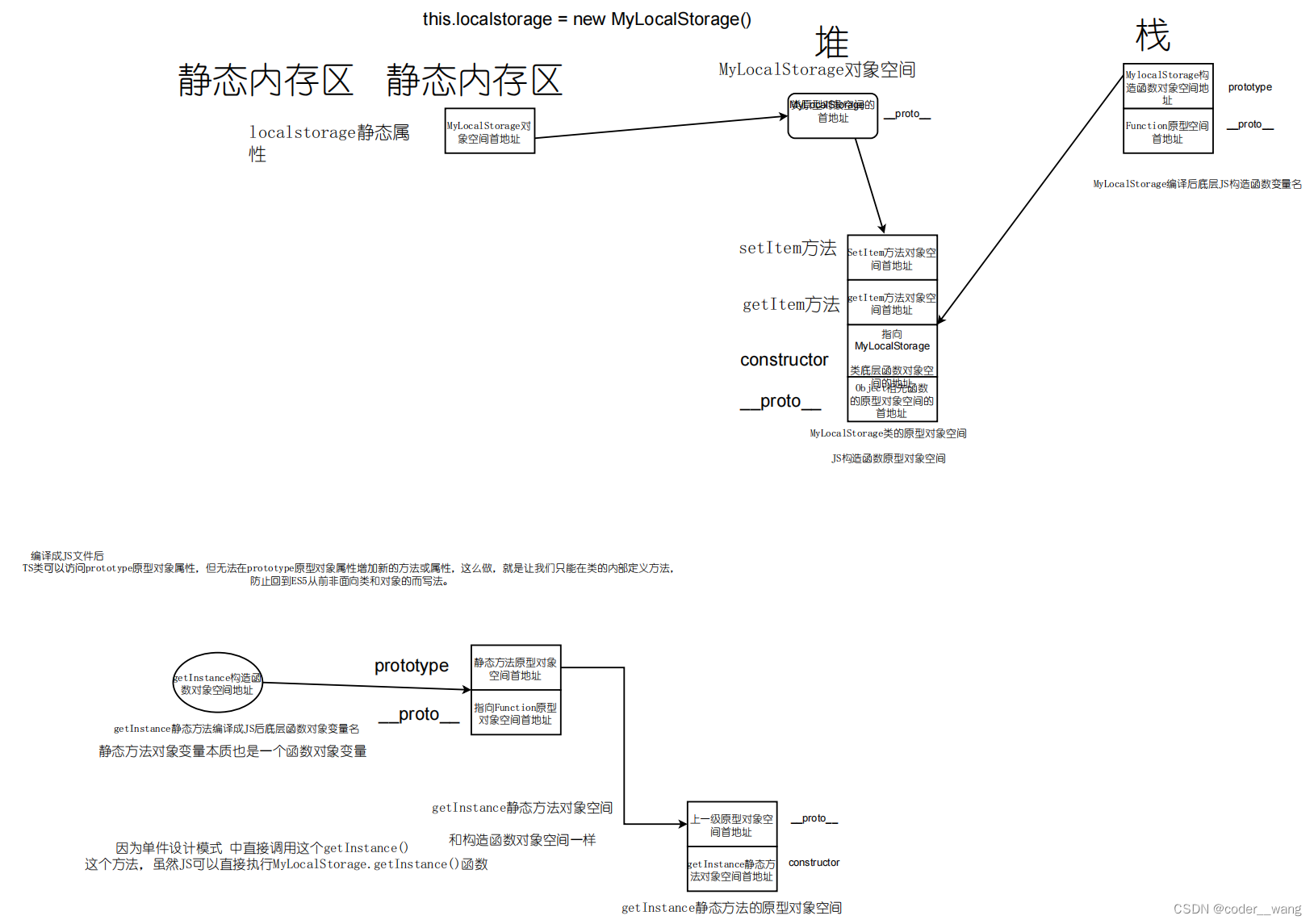

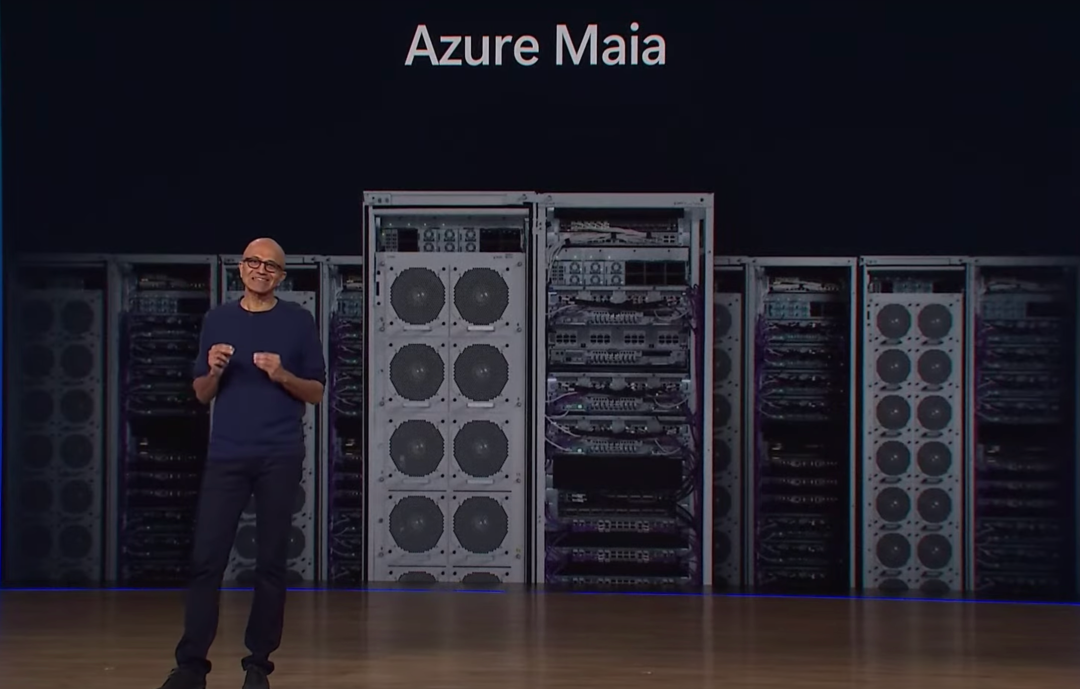

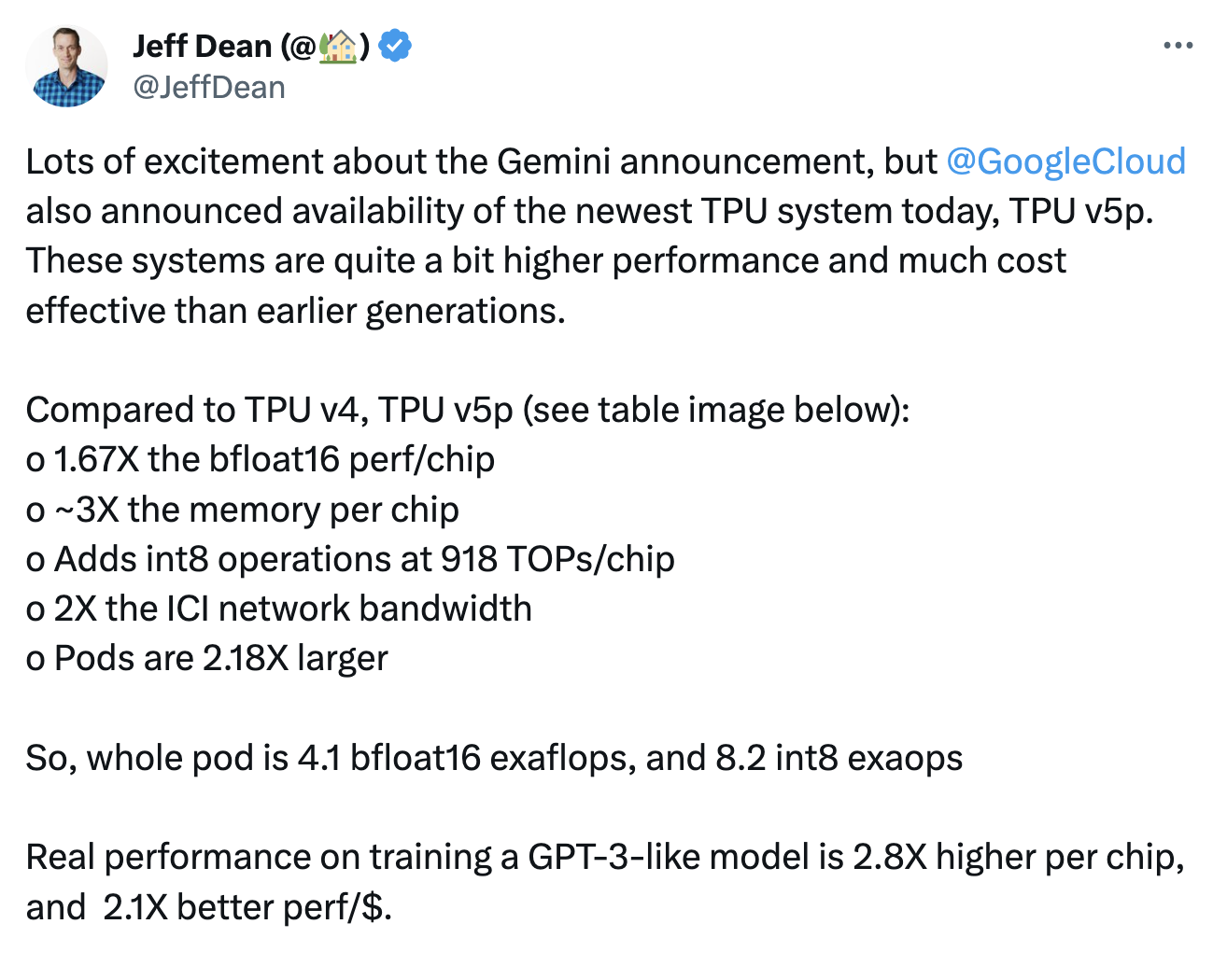

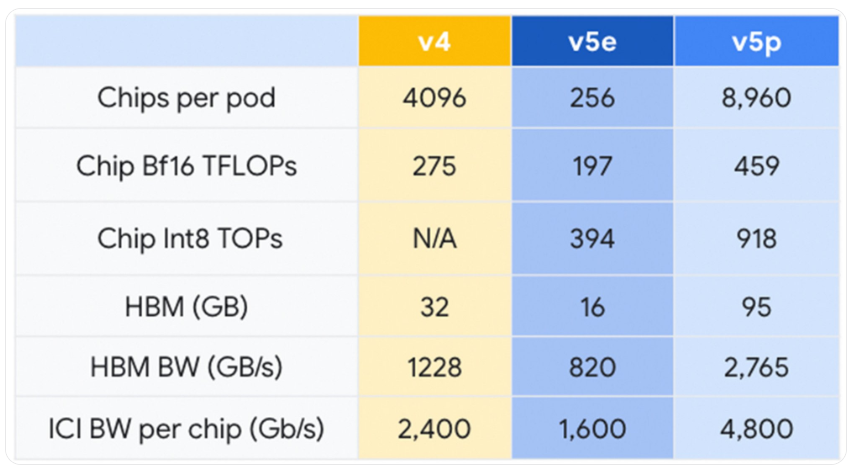

就在发布Gemini模型同一天,谷歌还宣布推出迄今为止最强大、最高效和可扩展的 TPU 系统 Cloud TPU v5p,专为训练尖端 AI 模型而设计。

JeffDean表示,与前代的TPU v4、TPU v5p 相比,bfloat16 性能提升1.67 倍,芯片的内存容量提升大概 3倍,新增 int8 运算,速度为918 TOPs,ICI 网络带宽提升2 倍...

这款下一代TPU将加速Gemini的开发,帮助开发者和企业客户更快地训练大规模生成式AI模型。

图注:Google 数据中心内的一排 Cloud TPU v5p AI 加速器超级计算机

或许谷歌之后还将购买英伟达H100或H200系列显卡,但谷歌自主研发打造TPU的战略是不会动摇的。

OK,到目前为止,英伟达的大客户订单将再次减1。

4、美国政府对英伟达的限令,禁售中国大陆,将失去百度阿里抖音客户;

关于美国政府对中国的显卡禁令,想必不用多讲,大家心里都很清楚。

只要是像英伟达 A100、A800、H100、H800等能支持AI大模型训练的显卡,美国都有禁售,甚至一度谣传 RTX 4090这样的游戏显卡也要禁售。

有关数据显示,Nvidia数据中心收入的20%至25%来自中国的销售。

而在英伟达2023年Q3季度Top12的H100显卡购买客户中,也能清楚地看到百度、阿里和字节对于高性能显卡的渴求。

早在今年8月,就有媒体报道包括阿里、百度、字节和腾讯在内的国内多家科技巨头为了应对美国可能的出口管制措施,就已经提前下单了超过 50 亿美元的芯片订单,主要用来研发和训练AI大模型。

然而,这超过 50 亿美元的订单大多数“并未交付”,这也就是说,一旦美国的出口禁令生效,那么这些没有交付的订单很有可能变成一纸空文,使得国内科技公司的芯片供应出现麻烦,这将直接影响到大模型的研发和训练。

目前还不清楚,Q3季度百度、阿里和字节的显卡订单之后能不能顺利交付到手。

尽管老黄一直很想用各种办法把显卡卖给大陆,但美国政府方面的态度显然丝非常坚决。美国商务部长吉娜·雷蒙多上周末在加利福尼亚州举行的里根国防论坛上发表讲话时表示,美国必须继续收紧限制,以阻止中国想办法绕过这些限制。

雷蒙多:“如果你(英伟达)围绕特定的切割重新设计芯片,使他们能够用于人工智能,我将在第二天控制它,我们不能让中国获得这些芯片。”

OK,到目前为止,英伟达在中国大陆方面的大客户订单将再次减少。

5、OpenAI等创业公司正在研发自己的AI芯片。**

此前据知情人士透露,在 Sam Altman 令人震惊地被OpenAI解雇之前的几周,他一直在积极努力从一些全球最大的投资者那里筹集数十亿美元,用于一个新的芯片项目,Altman把这个项目代号为Tigris。

Altman当时正在中东旅行,为这个代号为“Tigris”的项目筹集资金。Altman 计划分拆出一家专注于人工智能芯片的公司,其目标是研发TPU,与市场现有的英伟达芯片提供更低成本的竞争,并通过降低运行 ChatGPT 和 Dall-E 等自有服务的持续成本来帮到 OpenAI。

但据透露,Altman的芯片合资企业尚未成立,与投资者的谈判还处于早期阶段。

然而事情还没完,前几天一份订购意向书曝光,Altman任职CEO期间,OpenAI承诺从一家初创公司Rain AI订购芯片,金额高达5100万美元。

而这家名为Rain AI的公司奥特曼本人参与了投资,这不就相当于利益输送吗?

Rain AI成立于2017年,AI芯片设计理念受大脑启发,专注于研发类脑芯片,号称其研究成果可将训练神经网络的性能提高至超过10000倍。

如果这一野心勃勃的目标真的有一天能够实现,那将是英伟达等显卡公司的终结者。

业界会一直等待英伟达吗?

英伟达的订单一直处于爆满的状态,业界会一直等待英伟达吗?

戴尔亚太和日本总裁 Peter Marrs 表示,买家不会容忍英伟达GPU 的交货时间过长,这将给大量竞争对手制造机会。

另外,有意思的是,英伟达 CEO 黄仁勋认为,华为和英特尔将是英伟达在GPU方面的潜在挑战者。

英伟达的护城河

但英伟达真的会这么容易失去市场吗?

那大家可能小看了英伟达的护城河了——CUDA计算平台以及软硬件生态。

这正是AI开发人员目前更喜欢英伟达的主要原因之一。

竞争对手或许在显卡制造方面赶了上来,但CUDA计算平台以及软硬件生态以及开发者生态和习惯可不是一时半会能给撵上来的。

很显然,英伟达的竞争对手也想到了这一点。

AMD在发布最新AI芯片MI300X的当天,告诉投资者和合作伙伴,AMD已经改进了名为 ROCm 的软件套件,用来和 Nvidia 的行业标准 CUDA 软件竞争,解决了一个关键缺陷。

但具体用起来如何,能否让AI开发人员觉得容易上手好用,还是未知。

坐以待毙从来都不是老黄的风格。

英伟达也意识到要在硬件之外开辟另外一个业务——投资AI独角兽。

除此之外,也有媒体报道英伟达似乎也要亲自下场研发AI模型:

12月4日下午消息,据报道,黄仁勋表示,英伟达计划与包括软银在内的日本公司合作研发生成式AI。

行业会等待英伟达吗?英伟达的“显卡蛋糕”将被分食多少?

答案或许不乐观,但是英伟达依旧可能是Top赢家。

这一点,苏妈的心态很是乐观,她表示:“AMD并不认为自己需要击败英伟达才能在市场上取得好成绩,预计AI显卡的总市场可能在未来四年内攀升至 4000 亿美元,我们只需从中分得一杯羹即可。