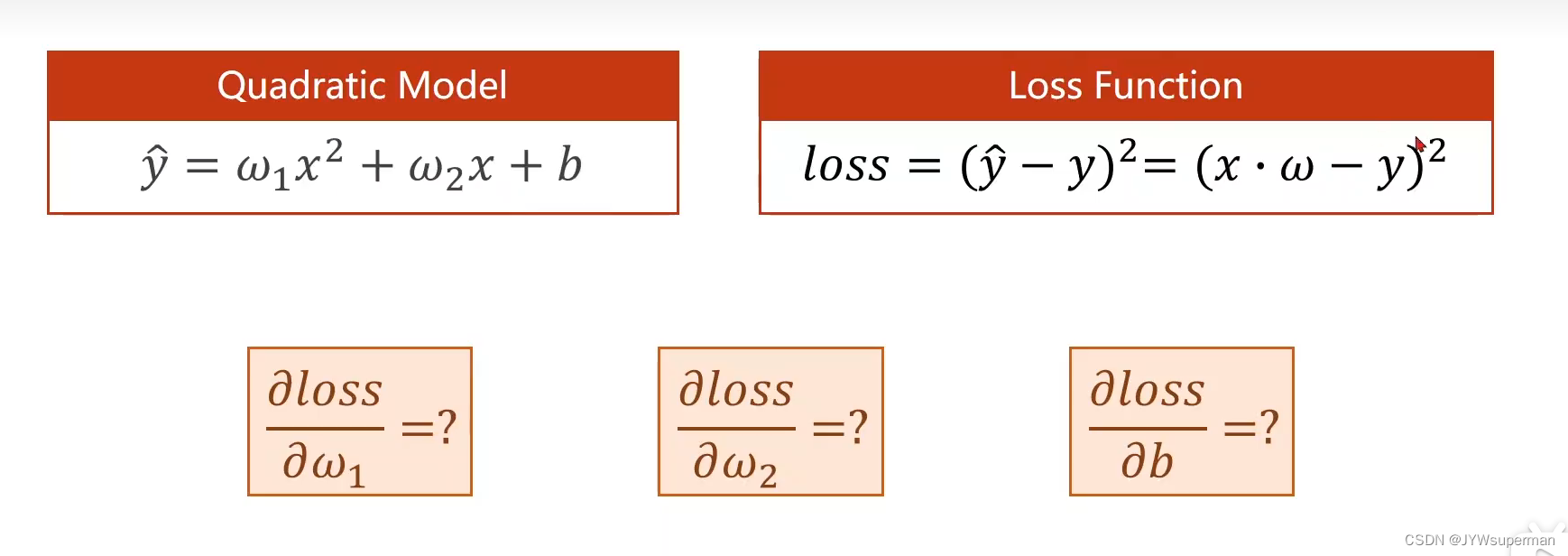

二次函数的反向传播

代码:

import torch

x_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]

w1 = torch.Tensor([1.0])

w1.requires_grad = True #定义要进行反向传播

w2 = torch.Tensor([1.0])

w2.requires_grad = True

b = torch.Tensor([1.0])

b.requires_grad = True

def forward(x):

return w1 * x ** 2 + w2 * x + b

def loss(x,y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("开始时的数据:", 4, forward(4).item()) #参数都为1时,调用前向函数

开始时的数据: 4 21.0

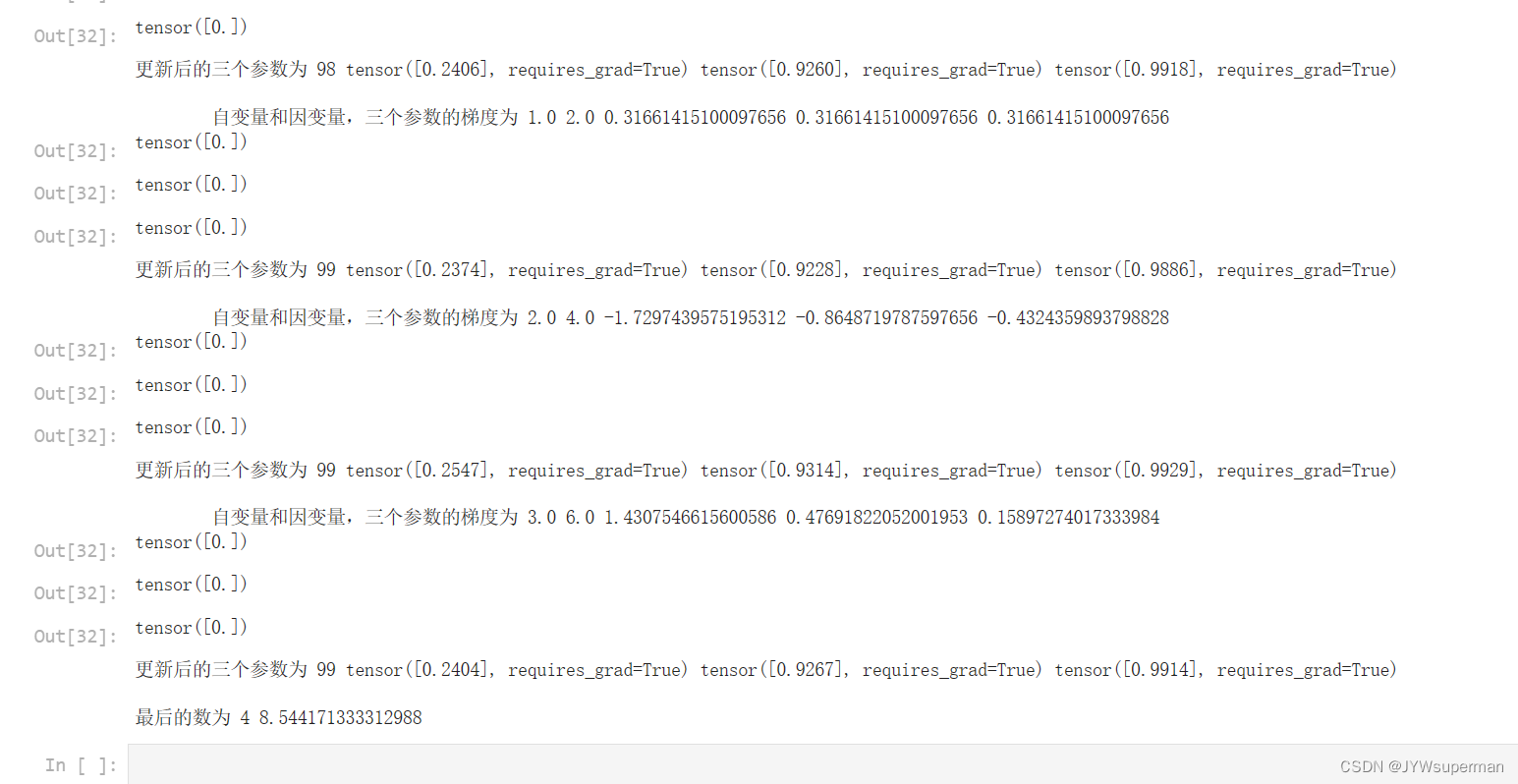

for epoch in range(100):

for x, y in zip(x_data, y_data):

l = loss(x, y) #根据loss函数进行梯度更新

l.backward()

print('\t自变量和因变量,三个参数的梯度为', x, y, w1.grad.item(), w2.grad.item(), b.grad.item())

#接下来根据梯度进行三个参数的更新

w1.data = w1.data - 0.01 * w1.grad.data

w1.grad.data.zero_() #这一步不能忘记,否则梯度没有清零,参数最终更新为无穷

w2.data = w2.data - 0.01 * w2.grad.data

w2.grad.data.zero_()

b.data = b.data - 0.01 * b.grad.data

b.grad.data.zero_()

print("更新后的三个参数为", epoch, w1, w2, b)

print("")

print("最后的数为", 4, forward(4).item()) #最后更新参数后调用forward函数

运行结果: