前言:ceph的资料真是很少,摸索一断时间,将整理的一资料和操作经验分享。本篇为干货,实操。生产环境可以借鉴使用。

知识点:

1、建议使用LVM卷管理作为Ceph底层的存储块设备,因为LVM卷可以随时扩展,方便在后续维护中按需调整

2、通常情况下 block.db 大小应该是 block 大小的 4% (或更多)

3、当使用相同速度的设备,就不需要独立的逻辑卷用于 block.db 或 block.wal ,BlueStore会自动计算它们在 block 中的空间

一、新增OSD节点操作

1、查看新增OSD节点的磁盘(本测试为三个data磁盘,三个DB磁盘,三个WAL磁盘)

[root@ceph-mon04 ~]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 40G 0 disk

├─sda1 8:1 0 600M 0 part /boot/efi

├─sda2 8:2 0 1G 0 part /boot

└─sda3 8:3 0 38.4G 0 part

├─cs-root 253:0 0 34.4G 0 lvm /

└─cs-swap 253:1 0 4G 0 lvm [SWAP]

sdb 8:16 0 100G 0 disk

sdc 8:32 0 100G 0 disk

sdd 8:48 0 100G 0 disk

sde 8:64 0 50G 0 disk

sdf 8:80 0 50G 0 disk

sdg 8:96 0 50G 0 disk

sdh 8:112 0 16G 0 disk

sdi 8:128 0 16G 0 disk

sdj 8:144 0 16G 0 disk

sr0 11:0 1 1024M 0 rom

2、所有磁盘创建PV

[root@ceph-mon04 ~]# for i in {b..j} ; do pvcreate /dev/sd$i ;done

Physical volume "/dev/sdj" successfully created.

3、创建VG

[root@ceph-mon04 ~]# vgcreate ceph-block-0 /deb/sdb

No device found for /deb/sdb.

4、查看所有创建的VG

[root@ceph-mon04 ~]# pvs

PV VG Fmt Attr PSize PFree

/dev/sda3 cs lvm2 a-- 38.41g 0

/dev/sdb ceph-block-0 lvm2 a-- <100.00g <100.00g

/dev/sdc ceph-block-1 lvm2 a-- <100.00g <100.00g

/dev/sdd ceph-block-2 lvm2 a-- <100.00g <100.00g

/dev/sde ceph-db-0 lvm2 a-- <50.00g <50.00g

/dev/sdf ceph-db-1 lvm2 a-- <50.00g <50.00g

/dev/sdg ceph-db-2 lvm2 a-- <50.00g <50.00g

/dev/sdh ceph-wal-0 lvm2 a-- <16.00g <16.00g

/dev/sdi ceph-wal-1 lvm2 a-- <16.00g <16.00g

/dev/sdj ceph-wal-2 lvm2 a-- <16.00g <16.00g

[root@ceph-mon04 ~]#

5、创建LV

[root@ceph-mon04 ~]# lvcreate -l 100%FREE -n block-0 ceph-block-0

Logical volume "block-0" created.

二、ceph-ansible admin 节点

1、配置需要添加的OSD节点的配置文件 (如没有 host_vras文件夹,可自行创建)

[root@ceph-admin ansible]# cd host_vars/

[root@ceph-admin host_vars]# pwd

/etc/ansible/host_vars

[root@ceph-admin host_vars]# ls

ceph-osd06

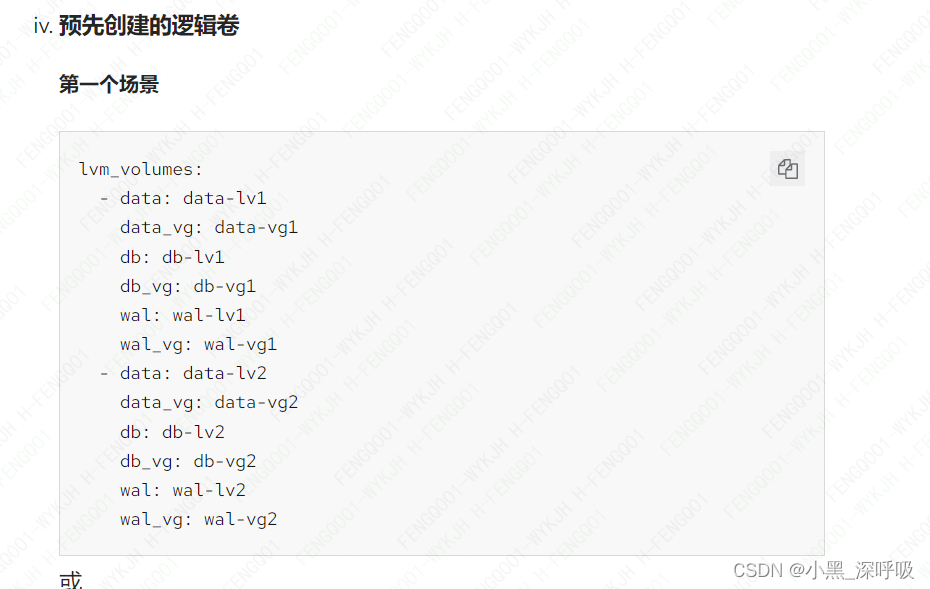

2、自行创建osd的配置文件 (注意,lv&vg的名称都要写入)

[root@ceph-admin host_vars]# cat ceph-osd06

lvm_volumes:

- data: block-0 #lv 的名称

data_vg: ceph-block-0 #vg的名称

db: db-0

db_vg: ceph-db-0

wal: wal-0

wal_vg: ceph-wal-0

- data: block-1

data_vg: ceph-block-1

db: db-1

db_vg: ceph-db-1

wal: wal-1

wal_vg: ceph-wal-1

- data: block-2

data_vg: ceph-block-2

db: db-2

db_vg: ceph-db-2

wal: wal-2

wal_vg: ceph-wal-2

[root@ceph-admin host_vars]#

3、修改/etc/ansible/hosts文件

[osds]

ceph-osd0[1:4]

#ceph-osd05

ceph-osd06 #新增节点

4、切换到/ceph-ansible目录

[root@ceph-admin ceph-ansible]# pwd

/root/ceph-ansible

[root@ceph-admin ceph-ansible]# ansible-playbook -vvvv -i /etc/ansible/hosts site.yml

redhat-4官网资料

5.2. 安装 Red Hat Ceph Storage 集群 Red Hat Ceph Storage 4 | Red Hat Customer Portal