ParNet注意力是一种用于自然语言处理任务的注意力机制,它是由谷歌在2019年提出的。ParNet注意力旨在解决传统注意力机制在处理长序列时的效率问题。传统的注意力机制在计算注意力权重时,需要对所有输入序列的位置进行逐一计算,这导致了在长序列上的计算复杂度较高。而ParNet注意力通过将序列分割成多个子序列,并对每个子序列进行独立的注意力计算,从而降低了计算复杂度。ParNet Block Attention是ParNet模型的子模块,可即插即用到其他网络模型中。

论文地址:https://arxiv.org/pdf/2110.07641.pdf

仓库地址:https://github.com/imankgoyal/NonDeepNetworks

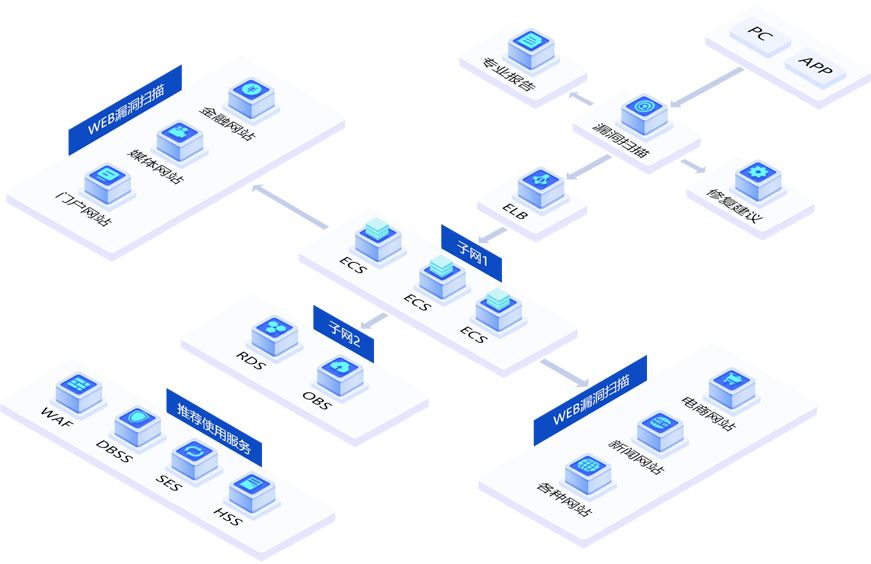

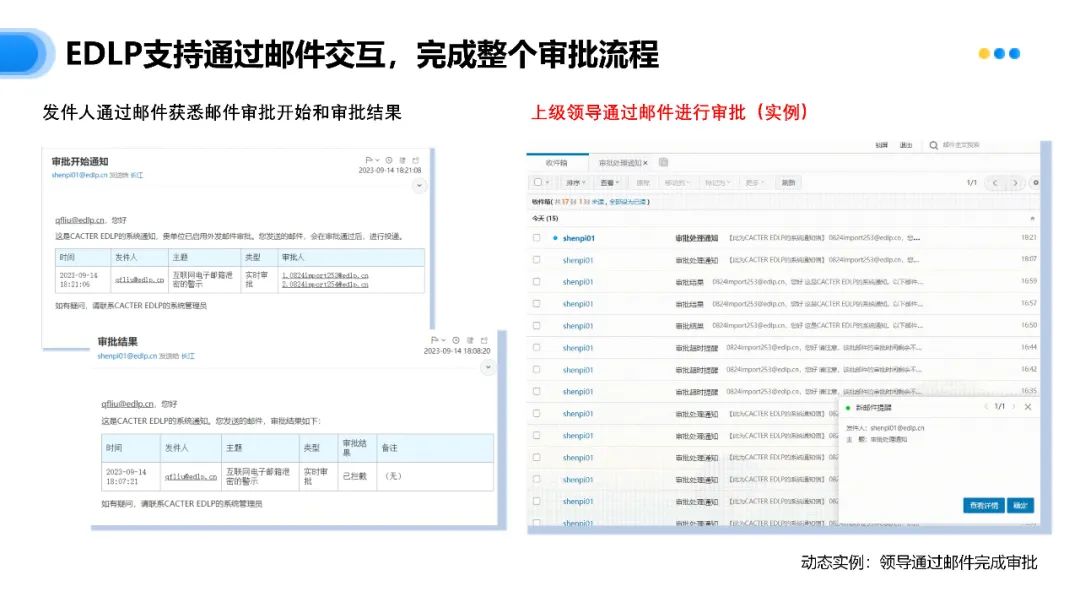

模型结构

ParNet是一种基于注意力机制的神经网络架构,主要用于自然语言处理(NLP)任务。它的名字来源于其在网络中的特点:参考性(Par)和注意力(Net)。ParNet的核心思想是通过注意力机制,让网络在处理序列中的不同位置之间建立参考关系,从而更好地捕捉序列中的长距离依赖关系。ParNet的主要特点包括:

- 注意力机制:ParNet使用注意力机制来模拟序列中的长距离依赖关系,这使得网络能够更好地捕捉序列中的上下文信息。这与传统的RNN和LSTM等序列模型相比,能够更好地处理长距离依赖关系。

- 参考性:ParNet通过建立参考关系,让网络在处理序列中的不同位置之间建立联系。这使得网络能够在处理序列时,更好地利用之前的上下文信息,从而提高模型的性能。

- 结构简洁:ParNet的结构相对简单,易于实现和训练。这使得它成为一种可行的方法,用于解决各种NLP任务。

ParNet的主要应用包括:

- 文本分类:ParNet可以用于文本分类任务,如情感分析、新闻分类等。通过使用注意力机制,ParNet能够更好地捕捉文本中的上下文信息,从而提高分类性能。

- 文本摘要:ParNet可以用于文本摘要任务,如自动摘要生成、文本纵览等。通过建立参考关系,ParNet能够更好地捕捉文本中的关键信息,从而生成更准确的摘要。

- 机器翻译:ParNet可以用于机器翻译任务。通过使用注意力机制,ParNet能够更好地捕捉源语言和目标语言之间的上下文信息,从而提高翻译质量。

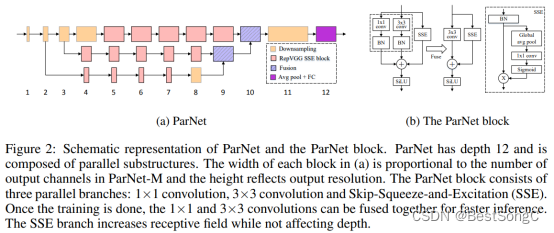

总体来说,ParNet是一种基于注意力机制的神经网络架构,它在NLP任务中表现出色。其注意力机制和参考性使得网络能够更好地捕捉序列中的长距离依赖关系,从而提高模型的性能。ParNet的结构简洁,易于实现和训练,使其成为一种可行的方法,用于解决各种NLP任务。ParNet及ParNet block结构如下图所示。

本文将ParNet Block Attention结构应用到YOLOv5结构中,利用其捉序列中的长距离依赖关系来更好的建模前后特征图之间的联系。

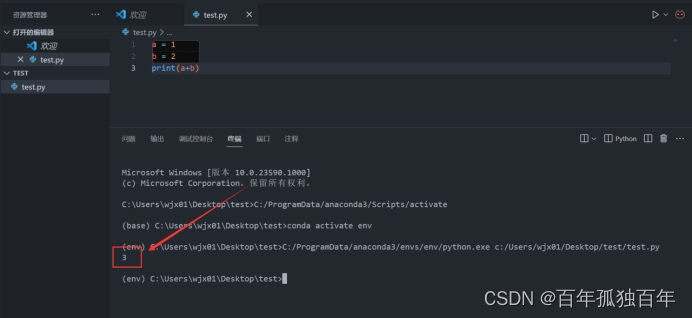

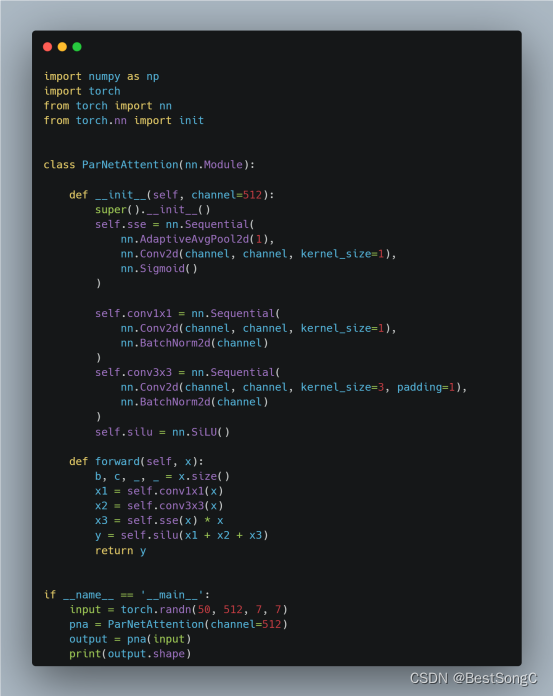

实现代码

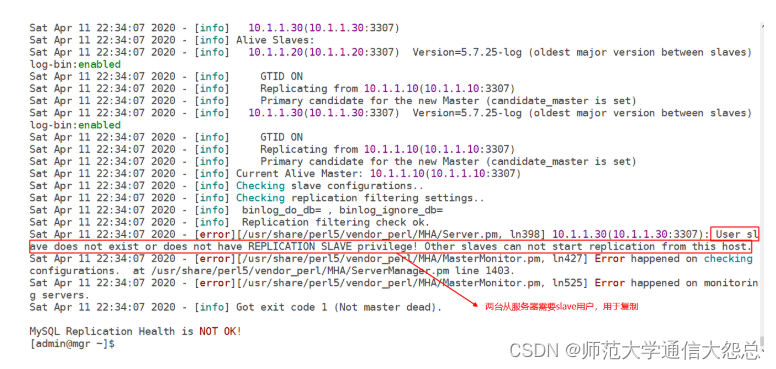

YOLOv5模型改进

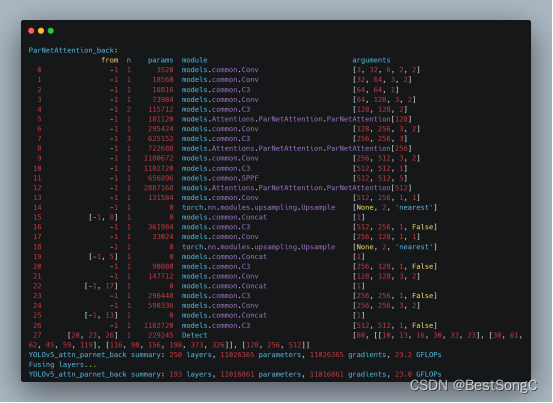

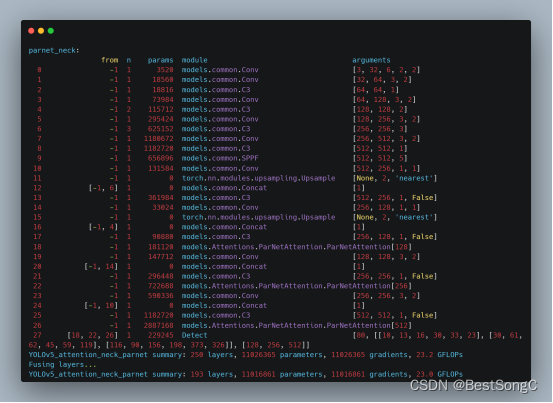

本文在YOLOv5目标检测算法的Backbone和Head部分分别加入SKAttention来增强目标提取能力,以下分别是在Backbone以及Head中改进的模型结构和参数(以YOLOv5s为例)。

在Backbone部分

在Head部分

总结

ParNet的核心思想是通过注意力机制,让网络在处理序列中的不同位置之间建立参考关系,从而更好地捕捉序列中的长距离依赖关系。本文将ParNet注意力机制应用到YOLOv5模型中。此外,ParNet注意力可进一步应用于YOLOv7、YOLOv8等模型中,欢迎大家关注本博主的微信公众号 BestSongC,后续更多的资源如模型改进、可视化界面等都会在此发布。另外,本博主最近也在MS COCO数据集上跑了一些YOLOv5的改进模型,实验表明改进后的模型能在MS COCO 2017验证集上分别涨点1-3%,感兴趣的朋友关注后回复YOLOv5改进。