有时候老板没事安排点事,为了偷懒,只能使出大招,毕竟自己不是那么老老实实干活的人,整理数据这类累和繁琐的活,我怎么能轻易动,好在gpt可以帮我来实现,有人可能会说,这么点内容你还不如自己去搞,但是有一点,这个搞熟悉后,遇到类似的事情,下次基本就是秒完成,剩下就是划水。

很多事情都这样,前期的时候稍微费点事,但是后面就很爽了。

首先,我们需要安装两个重要的Python库来执行网络爬虫任务:requests和BeautifulSoup。requests库用于发送HTTP请求,而BeautifulSoup库用于解析HTML文档。你可以使用Python的包管理器pip来安装这两个库,命令如下:

pip install requests beautifulsoup4

接下来,我们需要配置代理服务器。在Python中,我们可以通过requests库的proxies参数来实现这一点。以下是一个示例代码:

import requests

from bs4 import BeautifulSoup

# 配置代理服务器

proxies = {

'http': 'http://www.duoip.cn:8000',

'https': 'http://www.duoip.cn:8000'

}

# 使用requests库发送HTTP请求

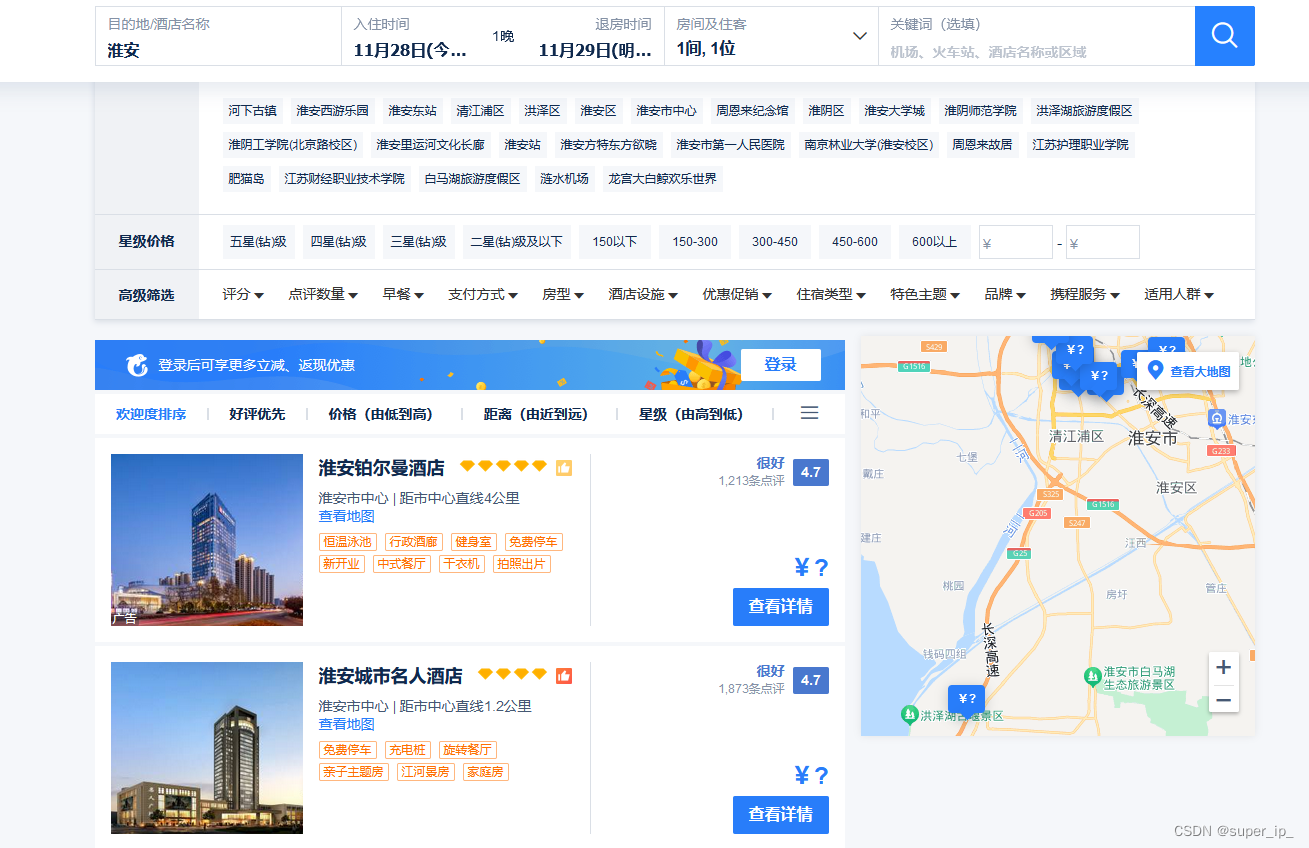

response = requests.get('http://www.ctrip.com', proxies=proxies)

# 使用BeautifulSoup解析HTML文档

soup = BeautifulSoup(response.text, 'html.parser')

# 查找包含酒店价格和日期信息的HTML元素

# 这里假设这些信息包含在class属性为'hotel-info'的div元素中

hotel_info = soup.find_all('div', class_='hotel-info')

# 遍历每个酒店信息,提取并打印价格和日期信息

for info in hotel_info:

price = info.find('span', class_='price').text

date = info.find('span', class_='date').text

print('Price: ', price)

print('Date: ', date)

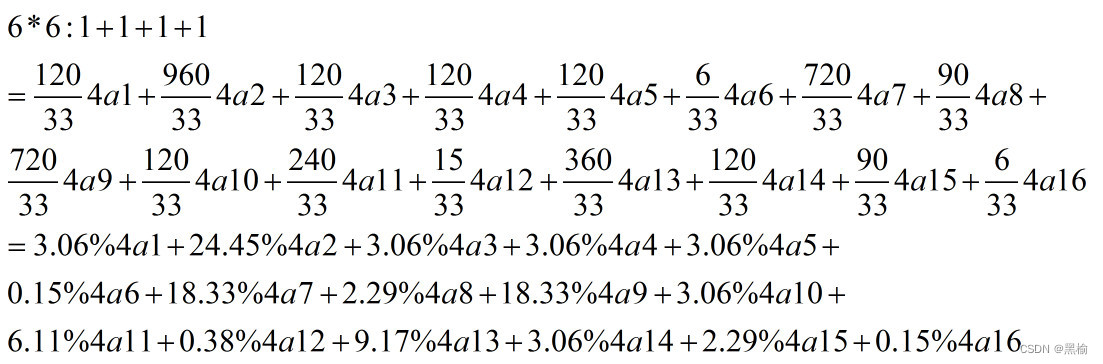

在这段代码中,我们首先导入了requests和BeautifulSoup库。然后,我们创建了一个名为proxies的字典来配置代理服务器。在这个字典中,'http'和'https'是HTTP协议的类型,后面跟着的是代理服务器的地址和端口号。

接着,我们使用requests.get函数发送了一个GET请求到'http://www.ctrip.com',并将proxies参数设置为我们之前创建的proxies字典。

请注意,在实际的HTML文档中,价格和日期信息可能不是包含在class属性为'hotel-info'的div元素中,也可能不是包含在span元素中。你需要根据实际的HTML文档结构来修改这段代码。

此外,这段代码没有处理可能出现的错误和异常,也没有考虑到网站可能会对爬虫进行反爬措施。在实际的爬虫程序中,你需要考虑到这些问题,并采取相应的策略和措施。

这只是一个基础的网络爬虫示例。在实际的爬虫程序中,你可能需要处理更多的内容,例如解析HTML文档结构,提取有用的信息,以及处理可能出现的错误和异常。此外,你也需要确保你的爬虫程序遵守网站的robots.txt文件,以及相关的法律法规