- 起源

- 多任务学习中的定义

- 理解

- 结合定义分析例子

- 示例 1:计算机视觉

- 示例 2:自然语言处理

- 示例 3:语音处理

- 示例 4:强化学习

- 总结

起源

"上游任务"和"下游任务"这两个术语在深度学习领域中通常用来描述一种 多任务学习的框架,其中上游任务的学习结果被用于辅助下游任务的学习。

这些术语的具体起源可能难以追溯到某一篇具体的论文,因为术语的发展通常是渐进的,而非一次性的。

然而,多任务学习和相关概念的研究可以追溯到早期的机器学习文献。早期的一些工作探讨了如何通过在多个任务上共享知识来提高学习性能。例如,1993 年的一篇名为《Using knowledge-based neural networks for handprint recognition》的论文就讨论了在手写体识别任务上使用基于知识的神经网络。在这些早期的工作中,虽然可能没有明确提到"上游任务"和"下游任务"这两个术语,但已经包含了一些多任务学习的思想。

具体到"上游任务"和"下游任务"这两个术语的使用,可能是在近年来的深度学习研究中逐渐流行起来的。

多任务学习中的定义

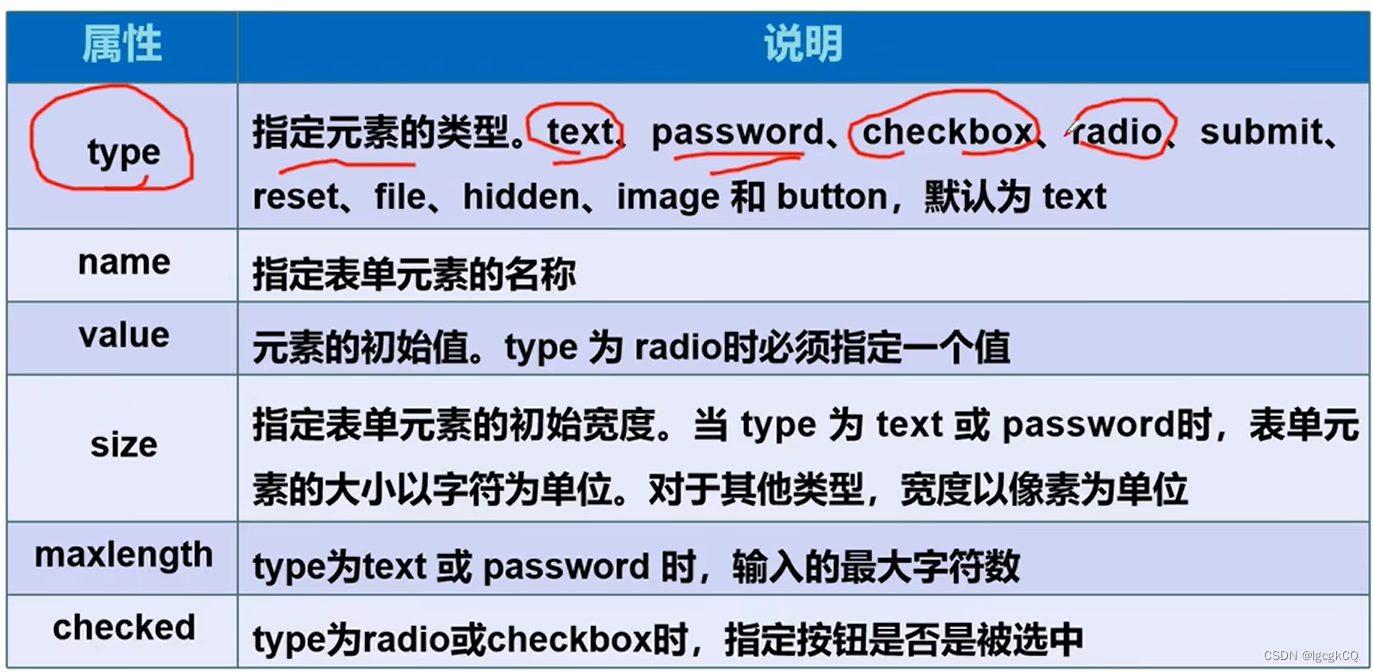

在深度学习中,"上游任务"和"下游任务"是用来描述 多任务学习框架中任务之间关系 的术语。

这两个术语的具体定义可能有一些变化,但通常可以按照以下方式理解:

-

上游任务(Upstream Task):上游任务通常是一个相对较为复杂的任务,其 学习过程产生的知识、特征或模型参数 可以被用于 帮助解决一个或多个相关的下游任务。上游任务的训练通常在模型中的较早阶段完成。

-

下游任务(Downstream Task):下游任务是在上游任务的基础上进行的,其目标是通过 利用上游任务学到的知识或特征 来 改善下游任务的性能。下游任务通常是 应用特定的任务,可能相对简单或者与上游任务相关。

多任务学习的目标是通过在多个任务上联合学习来提高整体性能。上游任务提供了一些通用的知识或特征,使得下游任务能够更有效地学习。

- 这种多任务学习框架的好处在于,如果上游任务足够复杂,它可以学到通用的、泛化性强的特征,从而对下游任务产生积极影响。

- 这种多任务学习的方法可以提高模型在不同任务上的表现,并加速模型在新任务上的学习过程。

理解

- 上游任务 是指利用 大量的通用 无标签数据或有标签数据,通过训练一个模型(例如卷积神经网络或 Transformer),该模型能够 从输入数据中提取出通用的图像特征。

这里的关键点是 上游任务的目标是学习通用的特征,这些特征在不同的任务中都能够表现出良好的性能。通常,这些上游任务使用大规模的数据集,例如 ImageNet,以 学习能够泛化到多个领域的特征表示。

- 下游任务 是指利用 有限的 有标签数据或无标签数据,对通过上游任务学到的模型进行 微调或优化,以完成 特定的 应用,如图像分类、目标检测、语义分割等。下游任务的性能往往受制于上游任务的特征提取能力。

这里的关键点在于:

- 有限的 有标签数据或无标签数据:下游任务通常不会拥有与上游任务相同规模的数据集。相反,它可能只有很少的标记数据,这使得模型在特定任务上进行适配或优化。

- 微调或优化:下游任务的模型通常是通过在上游任务的 预训练模型基础上微调,而 不是从零开始训练。这可以充分利用上游任务学到的通用特征。

- 性能受制于上游任务的特征提取能力:上游任务学到的通用特征对下游任务的性能起到关键作用。如果上游任务的特征提取能力强大且泛化性好,那么下游任务的性能通常也会更好。

举例来说,如果我们想要训练一个能够识别猫和狗的图像分类器,

- 可以先利用 ImageNet 这样的大规模有标签数据集,训练一个能够提取图像特征的卷积神经网络,如 ResNet。这就是一个 上游任务,也可以称为 backbone,主干网络。这个任务的目标是 使网络能够提取对各种图像分类任务都有用的通用特征。

- 然后利用自己收集的一些猫和狗的图像,对 ResNet 的 最后一层进行微调,使其能够输出 猫和狗的类别。这就是一个 下游任务,也可以称为 head,头部网络。这一阶段的目标是使网络在 特定的图像分类任务 上表现出良好的性能。

通过在 上游任务上进行预训练,网络能够学到通用的特征,然后通过微调,这些通用特征能够被定制为适应特定的下游任务。

大规模数据集的上游任务通常能够为模型提供强大的泛化能力,而相对较小的数据集的下游任务则能够使模型更适应特定的应用场景。

结合定义分析例子

当分析具体的例子时,我们可以结合上游任务和下游任务的定义,来更详细地理解它们之间的关系。

示例 1:计算机视觉

- 上游任务:物体识别或图像分类

- 下游任务:目标检测或图像分割

在这个例子中,

- 上游任务是通过学习图像中不同物体的通用特征来进行图像分类。这些通用特征可以包括边缘、纹理、颜色等。

- 下游任务是目标检测或图像分割,其中目标是在图像中定位和分割出特定物体。

上游任务学到的通用特征可以用于下游任务,使得目标检测或图像分割的性能得到提升,因为这些特征是具有泛化能力的。

示例 2:自然语言处理

- 上游任务:语言模型的预训练

- 下游任务:命名实体识别或情感分析

在这个例子中,

- 上游任务是语言模型的预训练,它通过大规模文本数据学习了语言的结构和语义。

- 下游任务可以是命名实体识别,其中系统需要识别文本中的特定实体,或者是情感分析,其中系统需要理解文本中的情感色彩。

上游任务学到的语言知识可以在下游任务中被利用,提高模型对实体和情感的识别能力。

示例 3:语音处理

- 上游任务:语音识别

- 下游任务:说话人识别或情感识别

在这个例子中,

- 上游任务是语音识别,模型通过学习从声音信号到文本的映射,掌握了声音的特征。

- 下游任务可以是说话人识别,其中系统需要确定说话者的身份,或者是情感识别,其中系统需要理解说话者的情感状态。

上游任务学到的声音表示可以为下游任务提供有用的信息,例如说话者的语音特征或声音中蕴含的情感信息。这种信息可以帮助提高说话人识别或情感识别的准确性。

示例 4:强化学习

- 上游任务:游戏中的策略学习

- 下游任务:机器人控制或决策制定

在这个例子中,

- 上游任务是在游戏中学习策略,使得模型能够在复杂环境中做出有效的决策。

- 下游任务可以是机器人控制,其中系统需要在实际环境中执行动作,或者是决策制定,其中系统需要在特定情境下做出适当的决策。

上游任务学到的策略和决策能力可以在下游任务中传递,使得机器人能够更好地执行任务或做出更明智的决策。

总结

这些领域中,深度学习模型通常通过 在大规模数据上进行预训练(上游任务),然后 在相对较小的数据集上进行微调或适应(下游任务),以解决 特定的应用问题。

这种迁移学习的思想有助于模型更好地利用通用知识,提高在特定任务上的性能。

![[PyTorch][chapter 1][李宏毅深度学习-AI 简介]](https://img-blog.csdnimg.cn/da05a63adea64dac9405e730d5fcb59f.png)