它能从一个或多个网址爬取网站内容,然后生成JSON文件格式。这样爬取的内容可以直接导入到GPTs知识库中,方便你创建自定义知识库的GPTs。比如你有自己的网站或者资料库,但是整理起来太麻烦,就可以使用这个工具。

主要功能:

爬取网站内容:用户通过配置文件设置目标网址和选择器,GPT-Crawler 自动从这些网站上收集信息。

生成知识文件:爬取的内容被整理成 JSON 文件,这个文件包含了从网站上获取的所有知识。

创建自定义 GPT:利用这个知识文件,用户可以在 OpenAI 平台上创建自己定制的 GPT 聊天机器人。

也可以使用爬取的内容创建Assistant自定义助手,这样你就可以通过一个 API来访问这些生成的知识。可以将这些知识集成到你自己的产品或应用中去。

简单来说,就是提供了一种方式,让你能够在你的软件或产品中使用这些爬取并整理好的知识。

具体步骤:

确保您已安装 Node.js 版本大于等于 16

克隆存储库

git clone https://github.com/builderio/gpt-crawler

安装依赖项

npm i

如果您没有安装 Playwright:

npx playwright install

配置爬虫

打开 config.ts 文件并编辑 url 和 selectors 属性以满足您的需求。

例如,要爬取 Builder.io 文档以创建我们自定义的 GPT,您可以使用:

export const config: Config = {url: "https://www.builder.io/c/docs/developers",match: "https://www.builder.io/c/docs/**",selector: `.docs-builder-container`,maxPagesToCrawl: 50,outputFileName: "output.json",};

查看文件顶部的类型定义,了解您可以配置的内容:

type Config = {/** URL to start the crawl */url: string;/** Pattern to match against for links on a page to subsequently crawl */match: string;/** Selector to grab the inner text from */selector: string;/** Don't crawl more than this many pages */maxPagesToCrawl: number;/** File name for the finished data */outputFileName: string;/** Optional function to run for each page found */onVisitPage?: (options: {page: Page;pushData: (data: any) => Promise<void>;}) => Promise<void>;/** Optional timeout for waiting for a selector to appear */waitForSelectorTimeout?: number;};

运行爬虫

npm start

上传你的数据到OpenAI

爬取将在项目的根目录生成一个名为 output.json 的文件。将其上传到 OpenAI 以创建您的自定义助手或自定义 GPT。

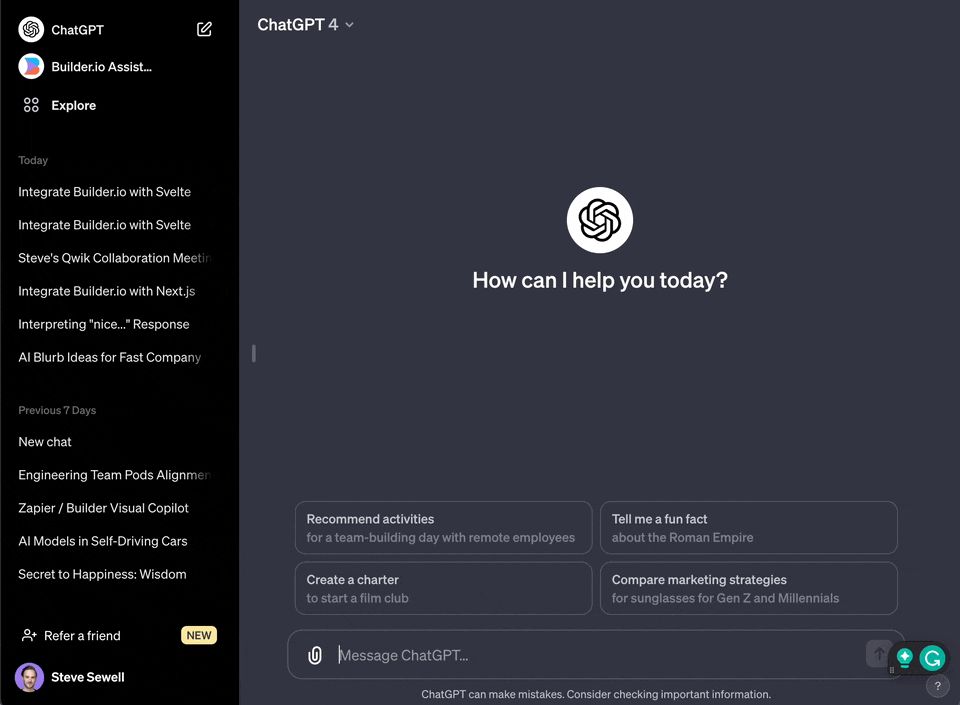

创建自定义 GPT 使用此选项可以通过用户界面访问您生成的知识,并轻松与他人共享

注意:您可能需要一个付费的 ChatGPT 计划来创建和使用自定义 GPT。

1.前往https://chat.openai.com/

2.单击左下角的您的姓名

3.在菜单中选择“我的 GPT”

4.选择“创建一个 GPT”

5.选择“配置”

6.在“知识”下选择“上传文件”并上传您生成的文件

创建自定义助手

使用此选项可以通过 API 访问生成的知识,以便将其集成到您的产品中。

1.前往https://platform.openai.com/assistants

2.单击“+ 创建”

3.选择“上传”并上传您生成的文件