一、摘要

本文提出了一种新型的联邦强化学习(FRL)方法,用于管理带有家电、太阳能光伏系统和储能系统的多个智能家庭的能源。

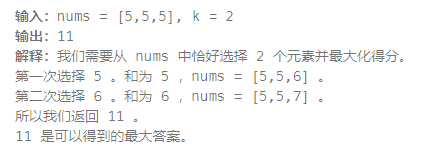

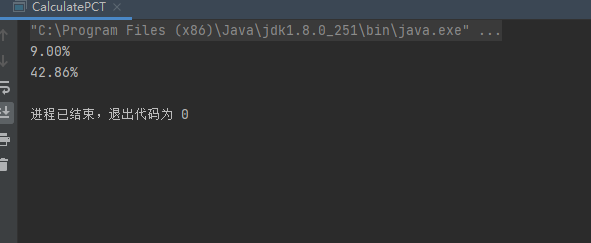

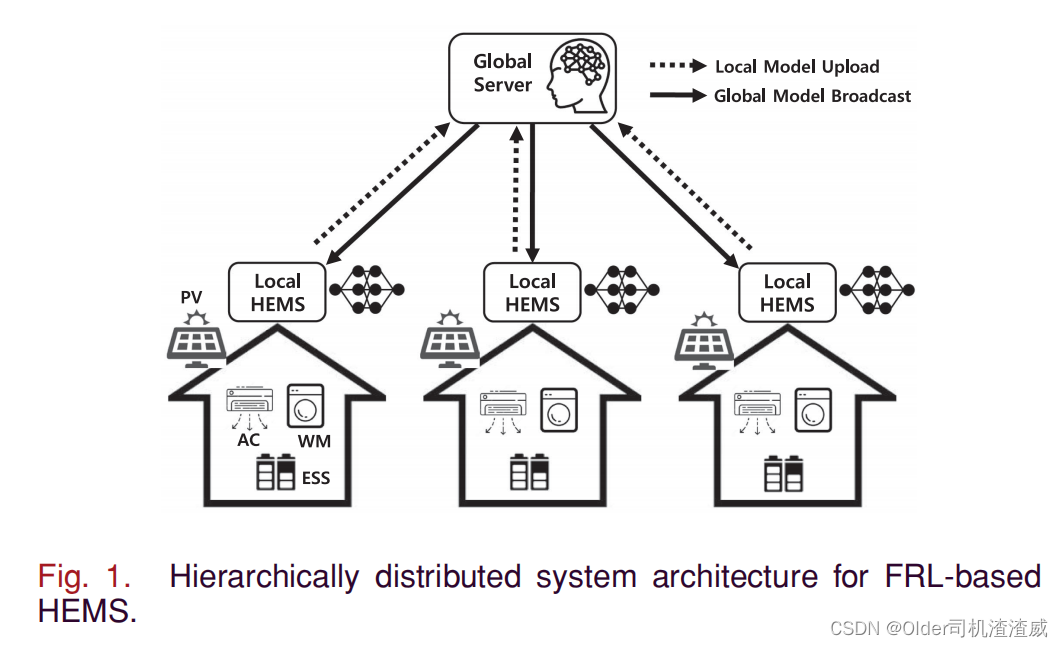

所提出的FRL方法的创新点在于开发了一种由本地家庭能源管理系统(LHEMS)和全局服务器(GS)组成的分布式深度强化学习(DRL)模型。使用能源消耗数据,LHEMS的DRL代理构建并上传其本地模型到全局服务器。然后,全局服务器聚合本地模型以更新LHEMS的全局模型并将其广播到DRL代理。最后,DRL代理用全局模型替换之前的本地模型,并反复重建其本地模型。在异构家庭环境下获得的仿真结果表明了所提出方法在收敛速度、设备能耗和代理数量方面的优势。

二、关键词

深度强化学习(DRL)、分布式能源资源、联邦强化学习(FRL)、家电、家庭能源管理系统、智能家庭

三、前言

智能家居(Smart Homes)正在配备部署在高级计量基础设施(AMI)中的智能电表,以实时监测消费者能源消耗并分析不同的消费模式。此外,连接到智能家居设备的智能插头可以快速测量能源消耗并控制设备的运行。从智能电表和智能插头收集的大量数据可以作为家庭能源管理系统(HEMS)的关键输入数据,用于管理带有电器和分布式能源资源(DERs)的智能家居的能源消耗,例如屋顶太阳能光伏(PV)和储能系统(ESS)。显然,有效利用这些大量能源消耗数据来改善HEMS的性能是大有希望的。本研究旨在开发一种基于机器学习(ML)的数据驱动方法,以实现多个智能家居的优化能源管理。

HEMS是一种在住宅领域实现高效和经济能源管理的有希望的技术。HEMS通过使用智能电表和智能插头,可以快速实时地监测消费者的能源消耗;它们自动安排家用电器和DERs的操作,以减少电费并确保消费者的舒适度,同时考虑到他们的偏好。传统上,已经将众多的HEMS算法表述为基于模型的优化问题[1]-[7]。这些算法包括使用混合整数线性规划(MILP)进行单户和多户住宅的负荷调度[1],[2],在不同热和电条件下开发住宅能源管理系统[3],考虑实时定价下操作依赖性的家用电器最优能源消耗调度[4]。设计一个与储能系统(ESS)集成的家庭能源管理系统(HEMS) [5],同时考虑通过ESS进行双向能源控制 [6],以及开发基于分层优化技术的HEMS,包括本地HEMS和全局HEMS,以实现多个智能家庭的能源管理 [7]。

然而,基于优化的HEMS方法是通过使用确定性和抽象的方程来表述的。它们没有考虑到家用电器和DERs的动态变化操作条件,例如WM和AC的消费者偏好的操作时间间隔和热舒适度,以及ESS的时间变化状态。因此,基于模型的HEMS优化方法可能为家庭能源消耗计划提供不准确的解决方案。此外,用于HEMS操作的大量参数和数据可以显著增加计算复杂性,甚至产生发散的解决方案。请注意,从一百万个智能电表每小时采样四次获得的数据将产生350.4亿条记录,大约相当于2920太字节[8]。

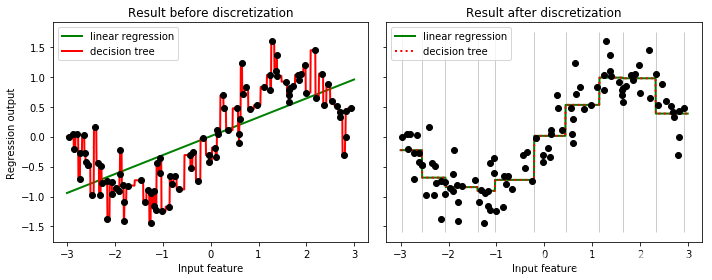

为了解决基于模型的HEMS所遇到的这些挑战,作为ML方法的强化学习(RL)最近引起关注作为一种模型无关的HEMS方法。已经提出了与人工神经网络(ANN)模型集成的基于RL的HEMS [9]-[11]。在这些研究中,在HEMS中采用ANN预测模型,用于预测实时价格、PV发电输出和各种电力服务下的室内温度过渡,从而确保更有效的RL过程。使用Q-learning算法的HEMS中需求响应的新结构已经被提出[12]。最近,深度RL(DRL)被用于安排住宅设备的能源消耗[13]和[14]。与基于离散动作空间的Q-learning不同,DRL框架利用连续动作空间来安排家用设备的能源消耗。

请注意,用于训练智能家居能源消耗模型的的大量数据可以为HEMS带来巨大的计算负担。为了解决这个问题,集中式基于RL的HEMS可以通过在一个单独的位置训练来自HEMS的能源消耗数据来降低本地HEMS的计算负担。然而,很明显,集中式方法对于大量动态时间变化数据处理来说可能不是实时的计算充分解决方案。此外,在中央服务器上的消费者聚合私有数据可能会暴露给潜在对手,他们可能会滥用数据来识别消费者的能源消费模式。为了同时降低由大量不确定数据引起的HEMS计算复杂性并保护消费者的隐私,本研究采用了联邦学习(FL)来解决多个智能家居的能源消耗调度问题。

FL是一种ML方法,以分布式方式训练本地设备并计算它们的最佳模型,同时减少上传到GS的本地数据,适应异构本地设备,并保护个人数据的隐私[16]。FL被应用于无线网络边缘服务器,消除了边缘服务器和移动设备之间的大量通信开销,并保护了移动设备用户的隐私数据[17],[18]。以前的一项研究使用FL预测了电动汽车充电站的能源需求[19]。因此,充电站只将其本地模型发送给充电站提供商,从而减少了通信开销,并有效地保护了电动汽车用户的隐私数据。最近,联邦强化学习(FRL)被用于以前的研究中[20],其中确定每个代理的最佳策略,但训练数据不共享给代理,并且通过利用高斯差分来保护共享信息时的数据和模型的隐私。以前的一项研究使用基于离散控制的RL方法的DQN来开发FRL模型进行个性化代理[21]。在另一项研究中[22],为云机器人系统的导航开发了FRL架构,其中导航学习机器人有效利用其先验知识并迅速适应新环境。

尽管FL和FRL用于解决各种工程领域的分布式控制和管理问题,但据我们所知,还没有研究开发基于FRL的HEMS框架来管理多个智能家庭的能源消耗,在考虑消费者的偏好并以分布式方式提供舒适度。在本文中,我们提出了一种计算效率高、隐私保护的基于FRL的HEMS,它由多个本地HEMS(LHEMS)和一个GS组成,如图1所示。GS和LHEMS通过以下两个步骤迭代交互构建多个家庭中空调、窗户和ESS的最优能源消耗模型。1)GS通过聚合来自所有LHEMS的本地模型来更新全局模型,并将其广播到LHEMS。2)LHEMS根据全局模型使用能源消耗数据训练其本地模型,并将它们上传到GS。

在每个LHEMS中,空调、窗户和ESS三个代理进行DRL过程[23]。在强化学习中,随着状态-动作空间维数的增加,ANN需要更多的隐藏层来准确描述训练过程中状态和动作之间的关系。在我们的HEMS问题中,我们采用了五层隐藏层的DRL方法。如果HEMS集成了其他可控家用电器,则状态和动作空间的维度将显著增加。在这种情况下,更多的隐藏层将有利于有效的训练过程。

本文的主要贡献如下:

与传统的以云为中心的机器学习模型不同,在本文中,我们提出了一种使用联邦强化学习的分层分布式机器学习框架,该框架可以优化安排多个智能家庭中的空调、窗户和ESS的能源消耗,同时确保消费者的舒适度。

我们提出了一个基于联邦强化学习的HEMS算法,该算法在全局服务器和本地HEMS之间迭代执行。全局服务器使用基于本地模型的联邦随机梯度下降算法(FedSGD)为所有本地HEMS开发全局模型。对于每个本地HEMS,三个针对空调、窗户和ESS的DRL代理将使用基于全局模型的能源消耗数据构建他们的本地模型。全局服务器和本地HEMS之间只交换本地和全局模型,可以减少通信开销并保护消费者的能源使用数据隐私。

仿真结果表明,提出的FRL方法可以成功地安排多个智能家庭中空调、窗户和ESS的最优能源消耗,并考虑到不同的设备参数和消费者的舒适度和偏好。此外,我们还证明了提出的FRL方法在收敛速度方面优于没有FRL的DRL方法。此外,我们还证明了即使有更多的DRL代理加入FRL网络,提出的FRL方法仍然可以保持良好的性能。

本文的其余部分组织如下:第二部分简要概述了深度强化学习和联邦强化学习。第三部分介绍了提出的基于联邦强化学习的HEMS算法的开发过程。第四部分展示了提出的方法的性能仿真结果。最后,第五部分总结了本文。