文章目录

- 前言

- 1 项目背景

- 2 训练YOLOV8的一维码检测模型

- 3 读取测试图片

-

- 3.1 调整首窗口位置

- 4 创建滑动窗口,窗口大小为(640,640),移动距离为160,对不足(640,640)的窗口进行填充

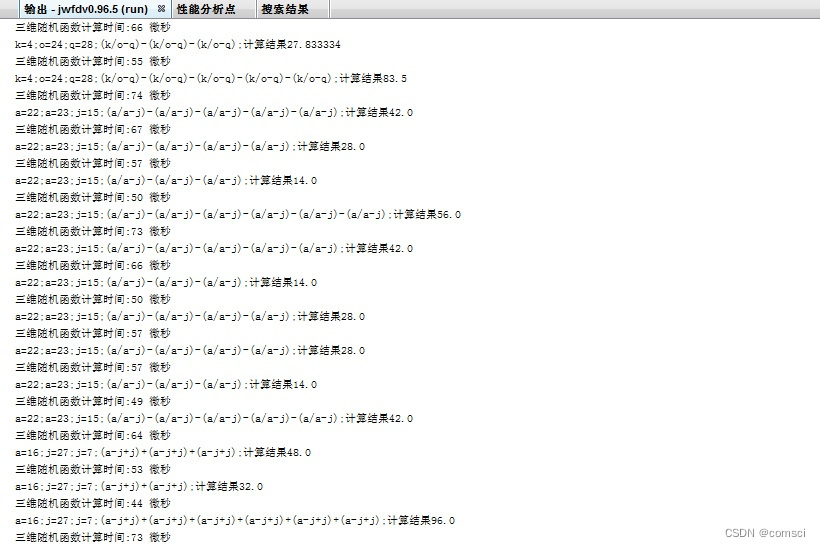

- 5 创建Onnxruntime推理引擎并测试

-

- 5.1推理测试

- 5.2获得ONNX模型输入层(输出层)和数据维度

- 5.3 预处理-构造输入张量 torch_list

- 6 执行推理预测

- 7 后处理-置信度过滤、NMS过滤

- 8 重构preds_dict坐标

-

- 8.1 把目标的坐标还原回原图的坐标

- 9 去重——用KMeans将检测目标分成15类

- 10 opencv 可视化

-

- 10.1 用Zbar识别二维码

- 10.2 ZBar解码

- 10.3 绘制检测框

- 总结

- 相关文章

前言

关于条码检测方案,一共有三部曲:

[1] 基于Opencv+Kmeans+Zbar的条码检测与基于锐化+双边高斯滤波+Zbar的条码检测在工业光伏产线上的检测效果研究

[2]大图像中的小目标检测——基于YOLOV8+OnnxRuntime部署+滑动窗口+Zbar的条码检测研究

本文是最后一篇,本专题三篇是步步深入的,因此如果觉得本文比较难,可以先看前两篇。这个专题的研究大概持续一个月左右,从传统学习到深度学习再到将传统机器学习算法和深度学习相结合,如今已经十分贴近工业应用的场合了,甚至超过了一般工业所见的条码场合的。

本文可以用在:

前提是完全理解本文在的算法和思维角度。

- 应届生简历(难度很大,但一定是加分项,本人做过公司硕士的面试官,但是没有遇见特别亮眼的项目)

- 进阶深度学习的素材(适合对yolov8+传统算法都要有基础的伙伴)

- 毕业课题(专硕是可以使用qt封装本算法,之后做几个实验基本是没问题的)

本文以条码检测为引,但本文作用不仅仅局限于此。本文记录了本人思考问题的过程,可以尝试问一下自己,在面对那些问题的时候,你会用什么方式处理。

声明:本项目是原创且开源的,本项目旨在帮助对cv深度学习感兴趣的伙伴,如要转载请注明出处。也希望大家帮忙支持点一下赞,谢谢。

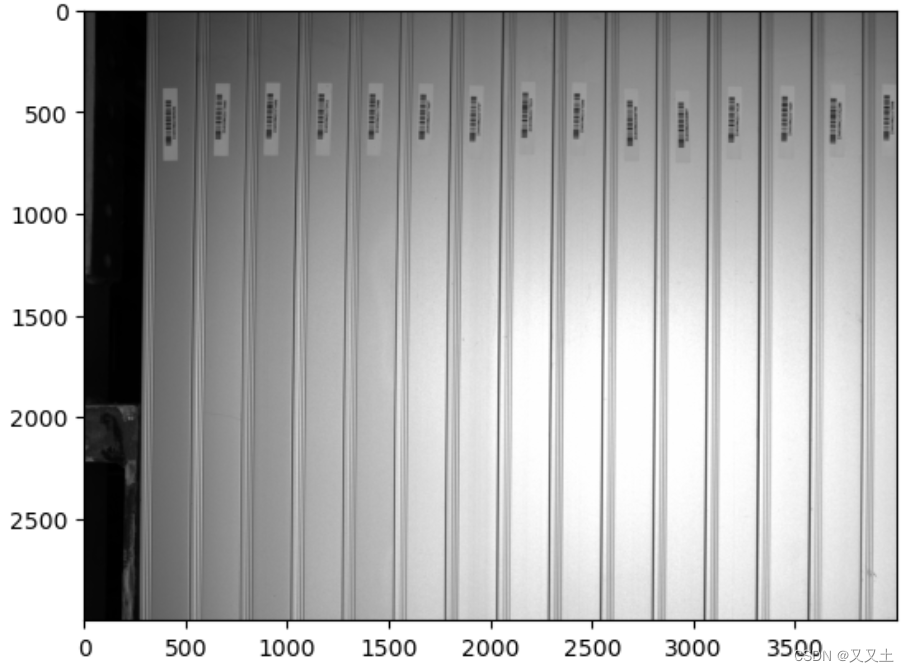

1 项目背景

条码检测是常见的工业应用场合,在国内可以用visionpro、halcon等一些软件自带的条码检测软件来实现。最近出现了国外项目,一些国内可以用的软件在国外都需要版权了,懂的都懂。因此opencv开发就显得十分重要了。本文采用目标检测用的是yolov8,解码器用的是Zbar,这两个包工程化都很好,可以大大缩短项目的开发周期。通过查阅资料以及自己试验,Zbar无法实现对复杂的工业环境的条码检测,问题主要出现在图像分辨率、环境光源,因此为了实现更准确更有效的的工业条码检测,本文基于YOLOV8+移动窗口切片(完整版)+OnnxRuntime+KMeans+Zbar+传统图像处理算法对大图片小目标光伏产线条码检测进行了研究。

2 训练YOLOV8的一维码检测模型

- 关于如何训练模型不是本文的重点,可以根据这篇文章简单训练一个模型(YOLOV8目标检测——最全完整的模型训练记录)

- 如果需要本人训练好的模型可以在这里下载( 文章顶部文件包:best.pt、best.onnx、 数据集、实验图片)

3 读取测试图片

import cv2

import numpy as np

from PIL import Image

import onnxruntime

import torch

# 有 GPU 就用 GPU,没有就用 CPU

device = torch.device('cuda:0' if torch.cuda.is_available() else 'cpu')

import matplotlib.pyplot as plt

%matplotlib inline

# 显示图片

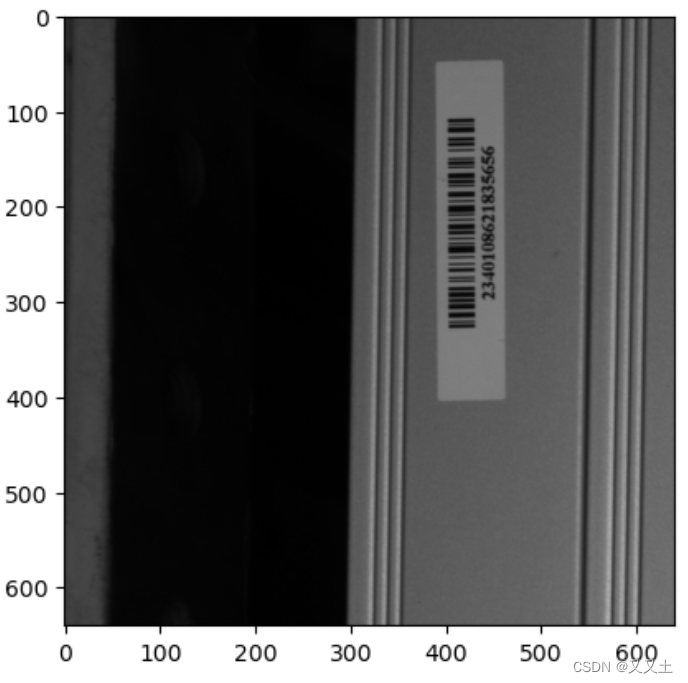

image = cv2.imread("D:/yolov5-6/data/images/Pic_2023_04_18_104022_3.bmp")

plt.imshow(image[:,:,::-1])

image_1 = image.copy()

3.1 调整首窗口位置

img_test = image[340:980,0:640]

plt.imshow(img_test[:,:,::-1])

4 创建滑动窗口,窗口大小为(640,640),移动距离为160,对不足(640,640)的窗口进行填充

-

win_coordinate记录了窗口切片在原图中的位置,所以为什么要这么做呢?

-

思考一个问题:我们用yolov8检测出了条码,那么在画检测框是在原图上画好,还是在窗口切片上画好呢?

-

先带着这个疑问看下去。

win = 0

image_list = [] # 用来存储滑动窗口

win_coordinate = []#记录窗口左上角坐标 [x,y],图片横向为x轴与笛卡尔坐标系一样

while(win<4000):

img_test = image[340:980,win:win+640]

win_coordinate.append([win,340])

if img_test.shape[1]<640:

top = 0

bottom = 0

left = 0

right = 640-img_test.