1.下载数据源

打开搜狗实验室链接:搜狗搜索引擎 - 上网从搜狗开始,由于搜狗实验室链接打不开了,所有这里自己制作一份数据进行实验。

SogouQ.txt:

2.上传下载文件至HDFS

2.1将下载的文件通过FinalShell工具上传到Linux系统

2.2SogouQ.txt并上传到HDFS

可以用tail命令查看解压文件最后3行的数据

tail -3 SogouQ.txt

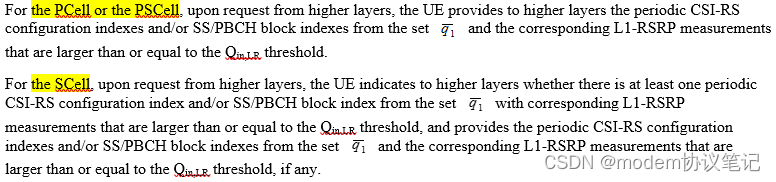

查询词为中文,这里编码按UTF-8查出来是乱码,编码时指定为‘GBK’可避免乱码。数据格式如前面的说明:

访问时间 用户ID [查询词] 该URL在返回结果中的排名 用户点击的顺序号 用户点击的URL

上传至HDFS:

hdfs dfs -put SogouQ.txt /

3. 数据清洗

因为原始数据中有些行的字段数不为6,且原始数据的字段分隔符不是Hive表规定的逗号',',所以需要对原始数据进行数据清洗。

通过编写MapReduce程序完成数据清洗:(打包运行)

(1)将不满足6个字段的行删除

(2)将字段分隔符由不等的空格变为逗号‘,’分隔符

3.1 idea新建Maven工程:MRHiveLog

新建工程目录结构如下:

3.2 修改pom.xml文件

在</project>一行之前添加如下语句

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>3.1.0</version>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<transformers>

<transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

<!-- main()所在的类,注意修改为包名+主类名 -->

<mainClass>com.wang.App</mainClass>

</transformer>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>添加依赖:在 </dependencies>一行之前添加如下语句:

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.7.3</version>

</dependency>

</dependencies>新建SogouMapper类:

package com.wang;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

// k1 , v1, k2 , v2

public class SogouMapper extends Mapper<LongWritable,Text,Text,NullWritable> {

@Override

/**

* 在任务开始时,被调用一次。且只会被调用一次。

*/

protected void setup(Context context) throws IOException, InterruptedException {

super.setup(context);

}

@Override

protected void map(LongWritable k1, Text v1, Context context) throws IOException, InterruptedException {

//避免乱码

//数据格式:20111230000005 57375476989eea12893c0c3811607bcf 奇艺高清 1 1 http://www.qiyi.com/

String data = new String(v1.getBytes(),0,v1.getLength(),"utf8");

//split("\\s+") \\s+为正则表达式,意思是匹配一个或多个空白字符,包括空格、制表、换页符等。

//参考:http://www.runoob.com/java/java-regular-expressions.html

String words[] = data.split("\\s+");

//判断数据如果不等于6个字段,则退出程序

if(words.length != 6){

return;//return语句后不带返回值,作用是退出该程序的运行 https://www.cnblogs.com/paomoopt/p/3746963.html

}

//用逗号代替空白字符

String newData = data.replaceAll("\\s+",",");

//输出

context.write(new Text(newData),NullWritable.get());

}

@Override

/**

* 在任务结束时,被调用一次。且只会被调用一次。

*/

protected void cleanup(Context context) throws IOException, InterruptedException {

super.cleanup(context);

}

}App.lava

package com.wang;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

/**

* 数据清洗器 主类

*

*/

public class App

{

public static void main( String[] args ) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf);

job.setJarByClass(App.class);

//指定map输出

job.setMapperClass(SogouMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(NullWritable.class);

//指定reduce的输出

job.setOutputKeyClass(Text.class);

job.setMapOutputValueClass(NullWritable.class);

//指定输入、输出

FileInputFormat.setInputPaths(job,new Path(args[0]));

FileOutputFormat.setOutputPath(job,new Path(args[1]));

//提交job,等待结束

job.waitForCompletion(true);

}

}打包工程:

上传到Linux: FinalShell工具:

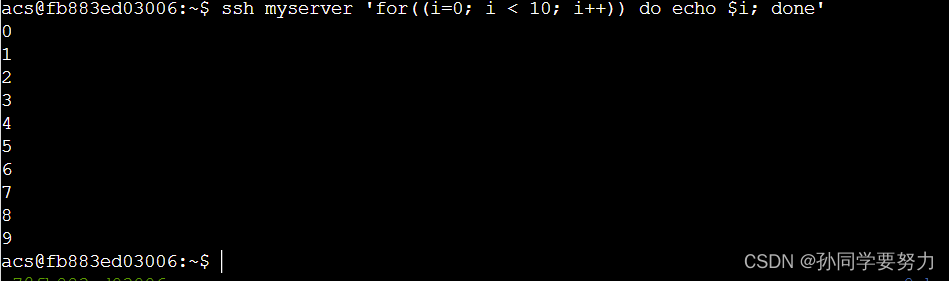

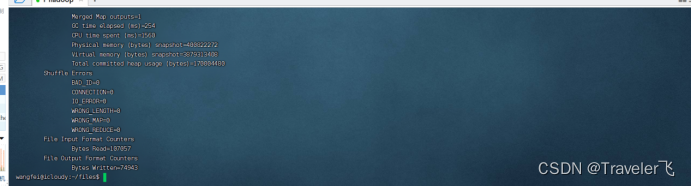

运行jar包

hadoop jar MRHiveLog-1.0-SNAPSHOT.jar /SogouQ.txt /oneday

查看输出结果

hdfs dfs -ls /oneday

查看输出文件最后10行数据:

hdfs dfs -tail /oneday/part-r-00000

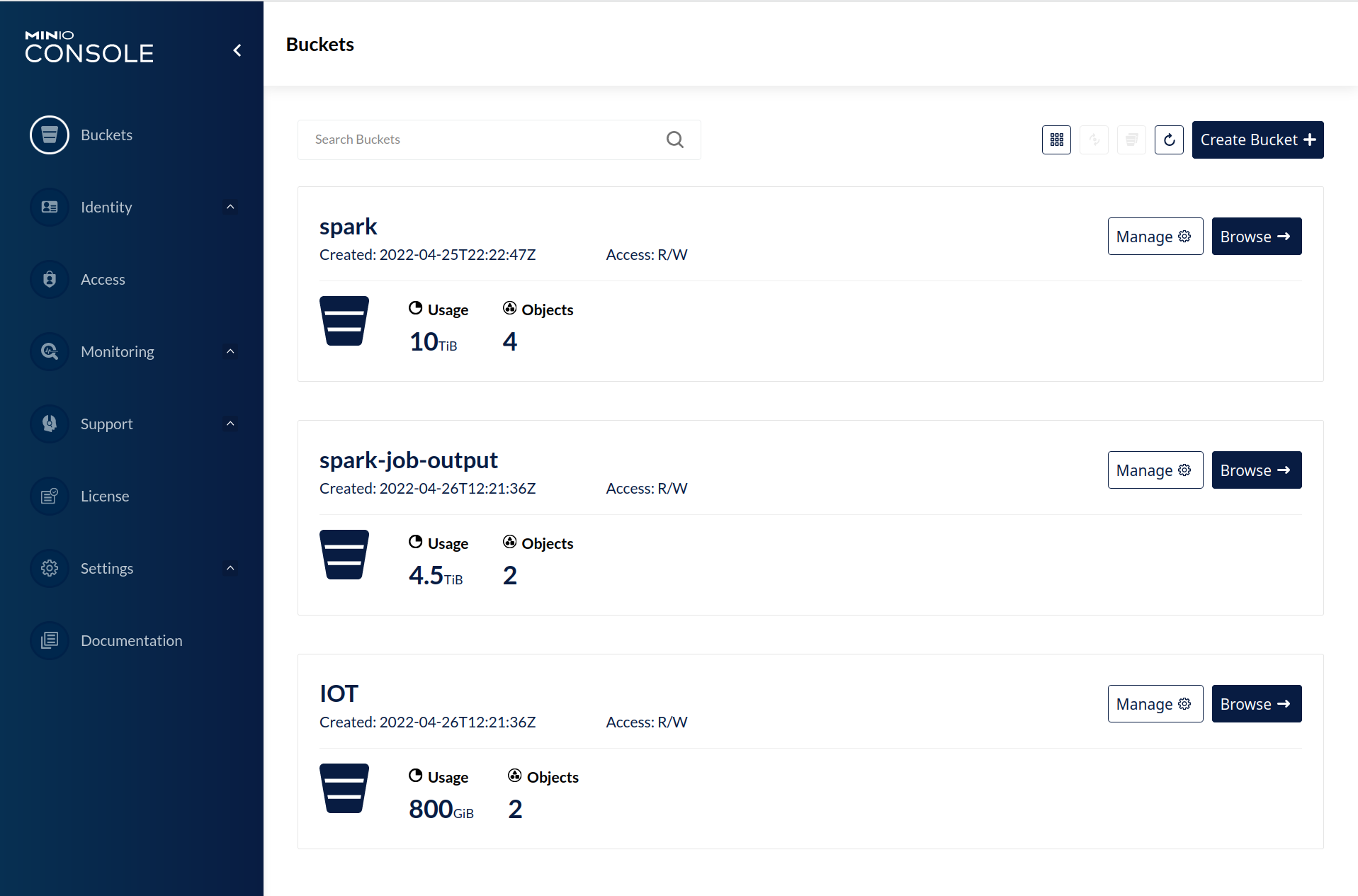

创建hive表

进入hive命令行

![]()

将MapReduce清洗后的数据导入Hive

load data inpath 'Oneday/part-r-00000' into table sogoulog_1;使用SQL查询满足条件的数据(只显示前10条)

select * from sogoulog_1 where no1=2 limit 10;

![[数据结构]什么是树?什么是二叉树?](https://img-blog.csdnimg.cn/71f60028d0c14282b604ae1fa49ba39c.png)