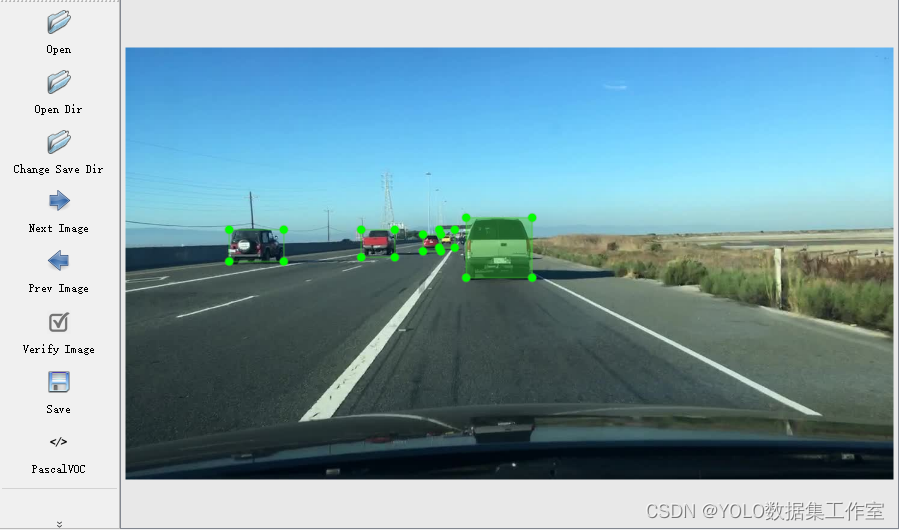

🚀🚀🚀本文改进:动态稀疏注意力(BiLevelRoutingAttention),实现更灵活的计算分配和内容感知,使其具备动态的查询感知稀疏性,引入到YOLOv8-Seg任务中,1)与C2f结合实现二次创新;2)注意力机制使用;

🚀🚀🚀BiLevelRoutingAttention 亲测在番薯破损分割任务中,mask mAP@0.5 从原始的0.625提升至0.662

🚀🚀🚀YOLOv8-seg创新专栏:http://t.csdnimg.cn/KLSdv

学姐带你学习YOLOv8,从入门到创新,轻轻松松搞定科研;

1)手把手教你如何训练YOLOv8-seg;

2)模型创新,提升分割性能;

3)独家自研模块助力分割;

1.BiFormer介绍

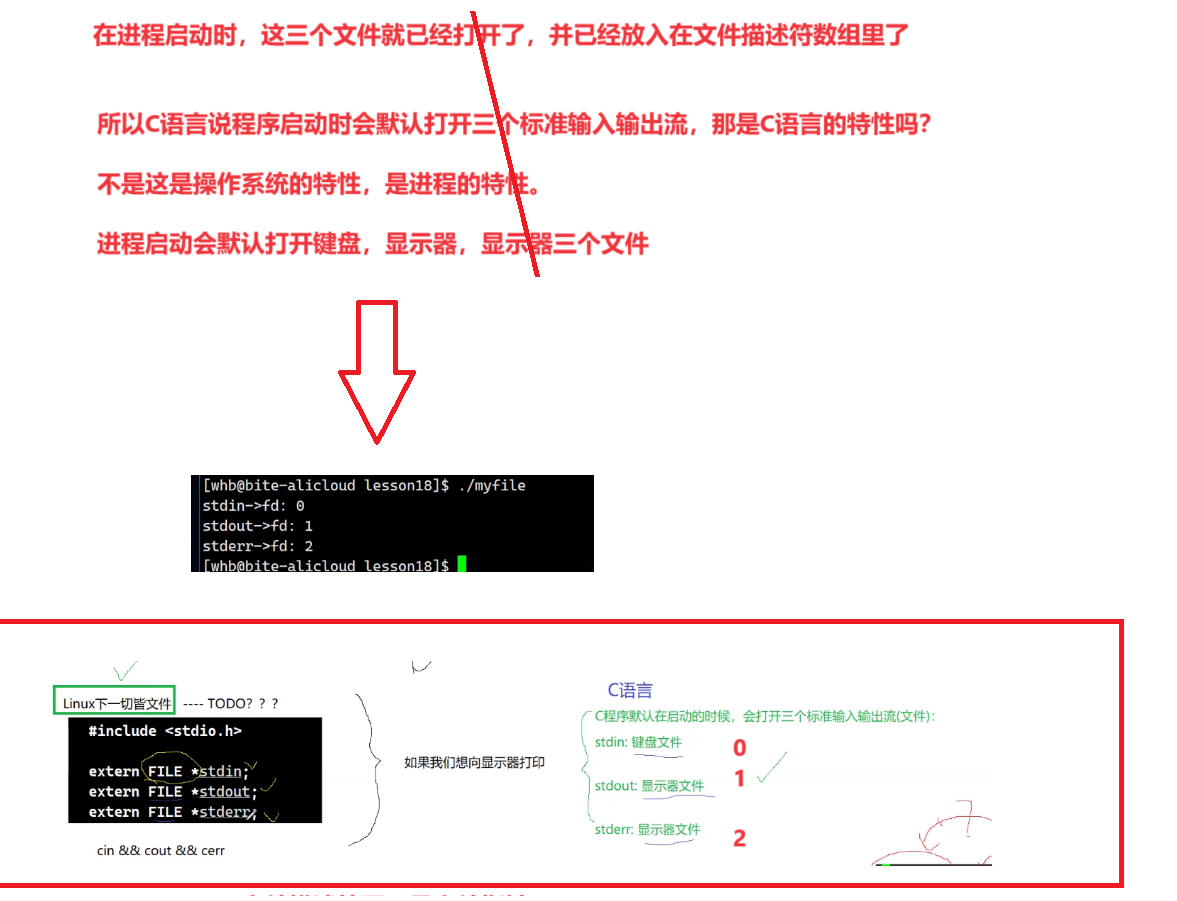

背景:注意力机制是Vision Transformer的核心构建模块之一,可以捕捉长程依赖关系。然而,由于

![[动态规划] (八) LeetCode 931.下降路径最小和](https://img-blog.csdnimg.cn/img_convert/95457a156e1975d19c468325612a5ba4.png)