目录

前言

一、什么是代理IP?

二、为什么需要使用代理IP?

1.突破访问限制

2.提高访问速度

3.保护隐私

三、代理IP的分类

1.高匿代理IP

2.普通代理IP

3.透明代理IP

四、如何获取代理IP?

1.免费代理IP网站

2.付费代理IP服务商

五、如何使用Python爬虫利用代理IP分析大数据?

1.获取代理IP:

2.验证代理IP的有效性:

3.使用代理IP访问目标网站:

总结

前言

随着互联网快速发展和普及,数据已经成为企业和个人决策的重要依据。而爬虫技术正是获取数据的重要手段,而代理IP则是爬虫技术中非常重要的一个环节。通过使用代理IP,可以突破网站的限制,获取更多的信息。本文将介绍如何使用Python爬虫利用代理IP分析大数据,同时提供代码案例。

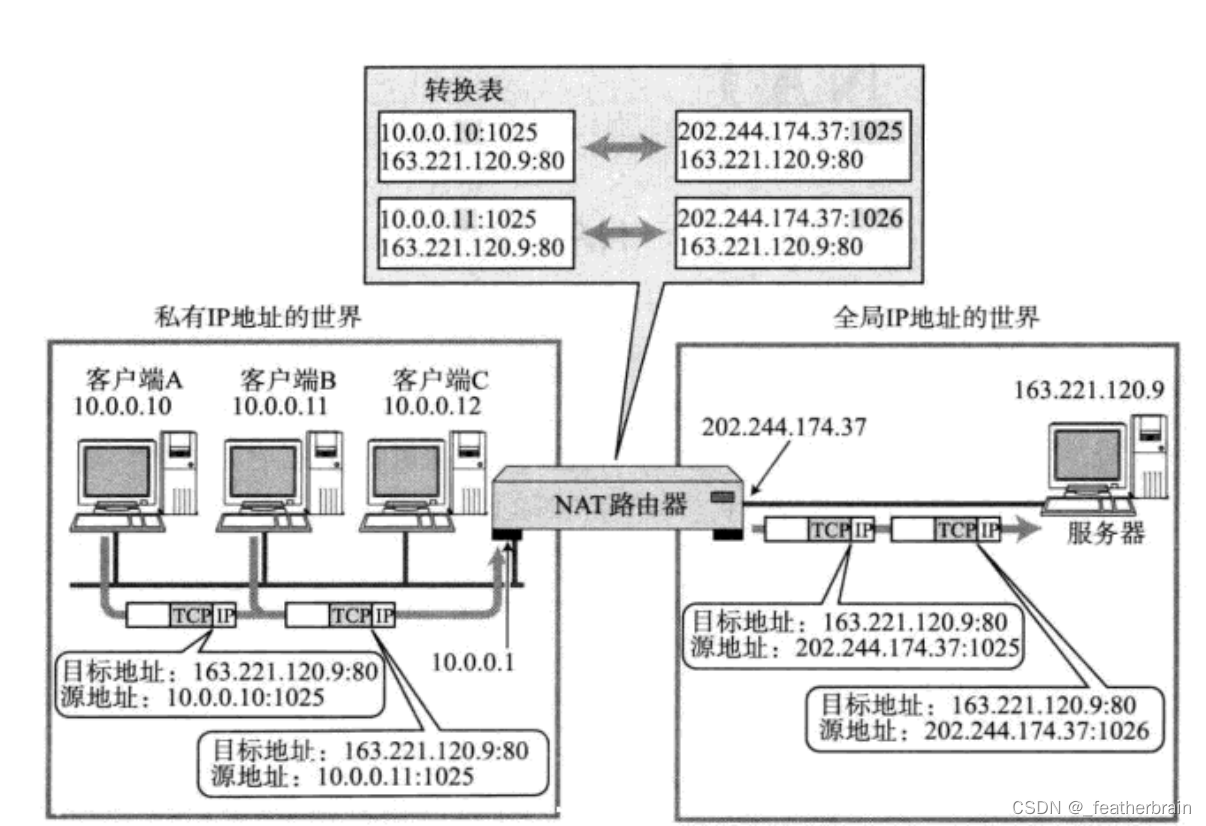

一、什么是代理IP?

代理IP(Proxy IP)指的是代理服务器所使用的IP地址。代理服务器作为一个中间人,代替客户端向服务器发送请求,服务器以为是代理服务器发送的请求而非客户端发送的请求。这样,通过使用代理IP,就可以隐藏真实的IP地址,从而达到访问被封IP的网站、提高访问速度等效果。

二、为什么需要使用代理IP?

1.突破访问限制

有些网站会对某些IP地址进行限制,例如限制某个国家的IP地址、封禁指定的IP地址等。这时,可以使用代理IP突破访问限制,访问被封IP的网站。

2.提高访问速度

有些代理服务器会缓存网站内容,如果使用代理IP访问这些网站,就可以提高访问速度。此外,代理服务器通常会部署在距离客户端更近的位置,这也可以提高访问速度。

3.保护隐私

使用代理IP可以隐藏真实IP地址,保护个人隐私。

三、代理IP的分类

代理IP可以分为以下几种:

1.高匿代理IP

高匿代理IP也叫透明代理IP,它在请求服务器时不会透露自己的IP地址,服务器只能得到代理服务器的IP地址。

2.普通代理IP

普通代理IP也叫匿名代理IP,它在请求服务器时会透露自己的IP地址,但是不会透露客户端的真实IP地址。

3.透明代理IP

在请求服务器时,透明代理IP会透露客户端的真实IP地址和代理服务器的IP地址。

四、如何获取代理IP?

1.免费代理IP网站

在互联网上有很多免费代理IP网站,可以通过这些网站获取代理IP。例如:站大爷代理ip(https://www.zdaye.com/)、开心代理(https://www.kaixin.com/)等。

2.付费代理IP服务商

付费代理IP服务商提供稳定、高速、高匿的代理服务器,一般需要购买。例如:站大爷代理ip(https://www.zdaye.com/)等。

五、如何使用Python爬虫利用代理IP分析大数据?

在使用Python爬虫利用代理IP分析大数据之前,需要先获取代理IP。这里以Kuaidaili为例,介绍如何使用Python代码获取代理IP。

1.获取代理IP:

import requests

from bs4 import BeautifulSoup

url = 'https://www.zdaye.com/free/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

trs = soup.find('table').find_all('tr')

for tr in trs[1:]:

tds = tr.find_all('td')

ip = tds[0].text

port = tds[1].text

print(ip + ':' + port)2.验证代理IP的有效性:

import requests

def check_proxy_ip(ip, port):

proxies = {

'http': 'http://' + ip + ':' + port,

'https': 'https://' + ip + ':' + port

}

try:

response = requests.get('https://www.baidu.com', proxies=proxies, timeout=5)

if response.status_code == 200:

print(ip + ':' + port + ' is ok')

else:

print(ip + ':' + port + ' is not ok')

except:

print(ip + ':' + port + ' is not ok')

ip = '183.88.214.248'

port = '8888'

check_proxy_ip(ip, port)3.使用代理IP访问目标网站:

import requests

ip = '183.88.214.248'

port = '8888'

proxies = {

'http': 'http://' + ip + ':' + port,

'https': 'https://' + ip + ':' + port

}

response = requests.get('https://www.baidu.com', proxies=proxies)

print(response.content)总结

本文介绍了代理IP的概念、分类和获取方法,并提供了使用Python爬虫利用代理IP分析大数据的代码案例。通过使用代理IP,可以突破网站的限制,提高访问速度,保护个人隐私。同时,需要注意代理IP的有效性,可以使用Python代码验证代理IP的有效性。在应用代理IP时,需要合理使用,遵守各网站的服务条款和法律法规。