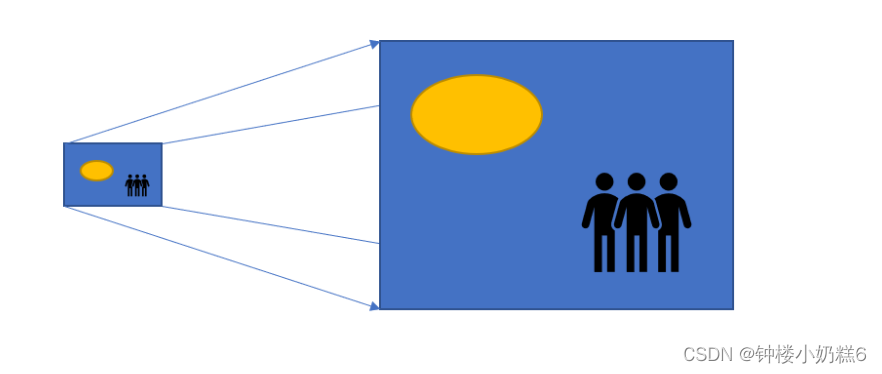

1.卷积层和汇聚层通常会减少下采样输入图像的空间维度(高和宽),语义分割对输入进行像素级别的输出,但是卷积会不断减小高宽,不利于像素级别的输出。通过转置卷积能增大输入的高和宽

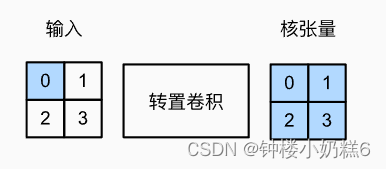

2.具体操作:步幅为1没有填充,输出(nh+kh-1)*(nw+kw-1)

3. 为什么称为转置卷积?

①对于卷积Y=X★W

可以对W构造一个V,使得卷积等价于矩阵乘法Y'=VX'

这里Y',X'是Y,X对应的向量版本

②转置卷积则等价于Y'=X'

③如果卷积将输入从(h,w)变成了(h',w')

同样超参数的转置卷积(h',w')变成(h,w)

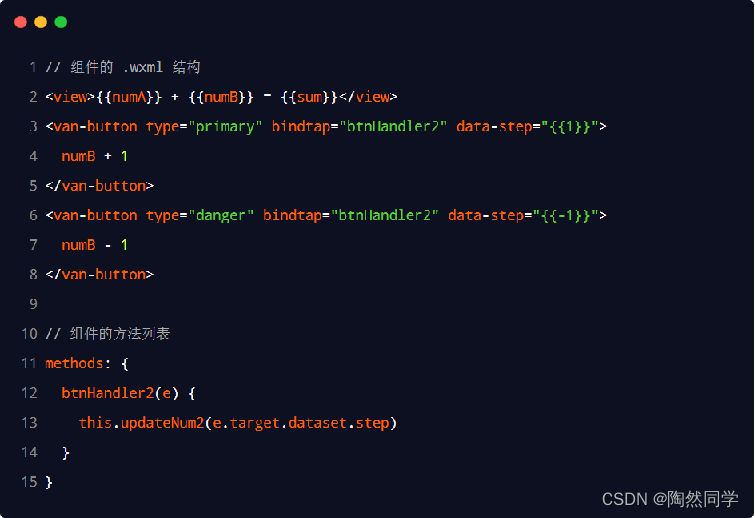

【代码实现】

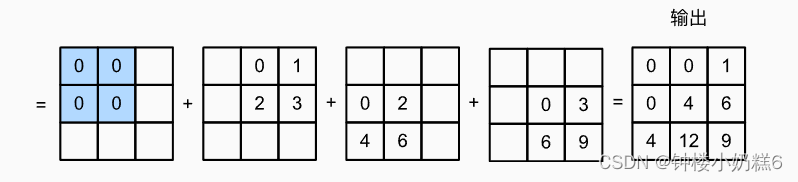

def trans_conv(X, K):

h, w = K.shape

Y = torch.zeros((X.shape[0] + h - 1, X.shape[1] + w - 1))

for i in range(X.shape[0]):

for j in range(X.shape[1]):

Y[i: i + h, j: j + w] += X[i, j] * K

return Y二维转置卷积运算

X = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

K = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

trans_conv(X, K)输出:

tensor([[ 0., 0., 1.],

[ 0., 4., 6.],

[ 4., 12., 9.]])

使用API

X, K = X.reshape(1, 1, 2, 2), K.reshape(1, 1, 2, 2)

tconv = nn.ConvTranspose2d(1, 1, kernel_size=2, bias=False)

tconv.weight.data = K

tconv(X)输出:

tensor([[[[ 0., 0., 1.],

[ 0., 4., 6.],

[ 4., 12., 9.]]]], grad_fn=<ConvolutionBackward0>)

填充,步幅和多通风的

当将高和宽两侧的填充数指定为1时,转置卷积的输出中将删除第一和最后的行与列。

tconv = nn.ConvTranspose2d(1, 1, kernel_size=2, padding=1, bias=False)

tconv.weight.data = K

tconv(X)输出:

tensor([[[[4.]]]], grad_fn=<ConvolutionBackward0>)