目前主流对大模型进行微调方法有三种:Freeze方法、P-Tuning方法和Lora方法。

Freeze: 即参数冻结,对原始模型部分参数进行冻结操作,仅训练部分参数,以达到在单卡或不进行TP或PP操作,就可以对大模型进行训练。

Freeze仅训练模型后五层的全连接层参数

训练、评估也是基于ChatGLM-Efficient-Tuning框架

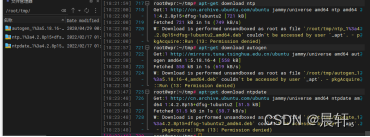

下载代码

git clone https://github.com/liucongg/ChatGLM-Finetuning

环境配置

cpm_kernels==1.0.11

deepspeed==0.9.0

numpy==1.24.2

peft==0.3.0

sentencepiece==0.1.96

tensorboard==2.11.0

tensorflow==2.13.0

torch==1.13.1+cu116

tqdm==4.64.1

transformers==4.27.1

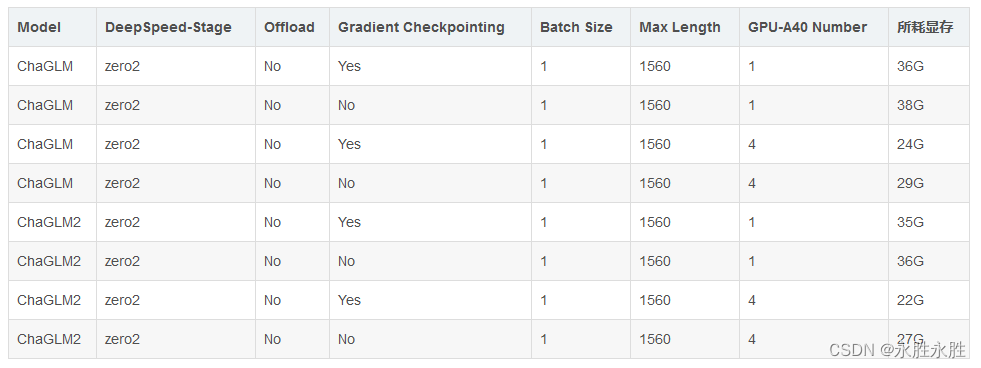

模型微调时,如果遇到显存不够的情况,可以开启gradient_checkpointing、zero3、offload等参数来节省显存。下面model_name_or_path参数为模型路径,请根据可根据自己实际模型保存地址进行修改。

修改train_type=freeze及其freeze_module_name参数

(1)、ChatGLM单卡训练

CUDA_VISIBLE_DEVICES=0 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B/ \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type freeze \

--freeze_module_name "layers.27.,layers.26.,layers.25.,layers.24." \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm

(2)、ChatGLM四卡训练:设置CUDA_VISIBLE_DEVICES参数

通过CUDA_VISIBLE_DEVICES控制具体哪几块卡进行训练,如果不加该参数,表示使用运行机器上所有卡进行训练

CUDA_VISIBLE_DEVICES=0,1,2,3 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B/ \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type freeze \

--freeze_module_name "layers.27.,layers.26.,layers.25.,layers.24." \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm

(3)、ChatGLM2单卡训练

CUDA_VISIBLE_DEVICES=0 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM2-6B/ \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm2 \

--train_type freeze \

--freeze_module_name "layers.27.,layers.26.,layers.25.,layers.24." \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm2

(4)、ChatGLM2四卡训练:设置CUDA_VISIBLE_DEVICES参数

CUDA_VISIBLE_DEVICES=0,1,2,3 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM2-6B/ \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm2 \

--train_type freeze \

--freeze_module_name "layers.27.,layers.26.,layers.25.,layers.24." \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm2

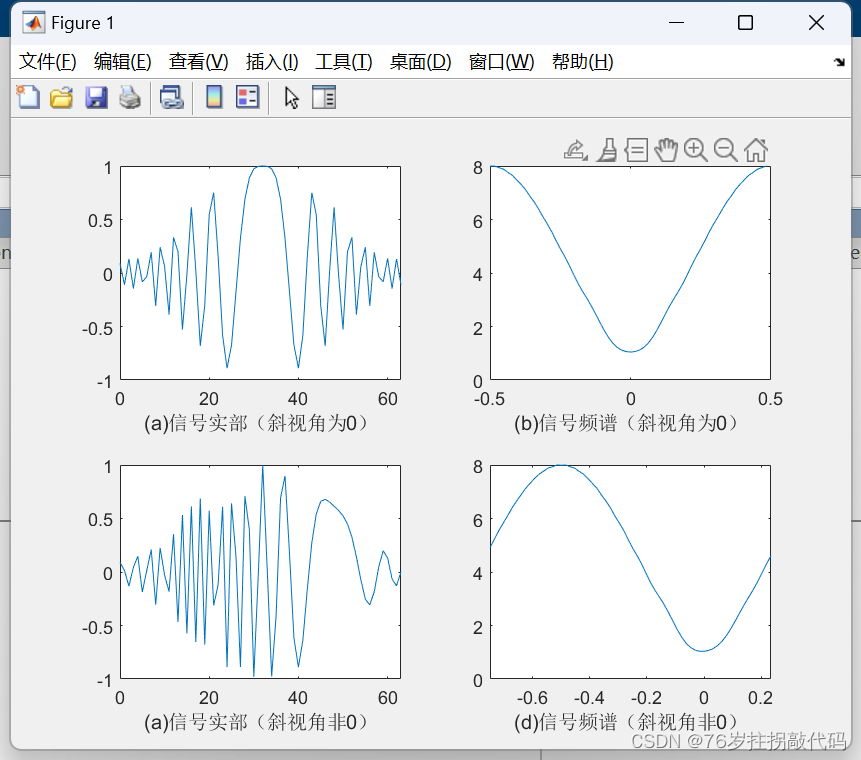

(5)、耗费显存资源占用对比—Freeze方法:对比ChaGLM和ChaGLM2