摘要

交通路口是部署未来智慧城市的计算、通信和情报服务的最合适地点。需要收集和处理的大量数据,再加上隐私和安全问题,促使边缘计算范式的使用,这种范式与大都市的物理交叉路口很好地吻合。本文主要针对高带宽、低时延的应用,在此背景下描述了:(i)智能城市交叉口智能节点的系统设计考虑因素;(二)关键技术组件,包括传感器、网络、边缘计算、低延迟设计和基于人工智能;(三)隐私保护、云连接车辆、实时“雷达屏幕”、交通管理和大流行期间行人行为监测等应用。实验研究的结果图示了位于纽约市的COSMOS试验台。未来的挑战总结了以人为本的智慧城市交叉口设计。

1 智慧城市交叉路口

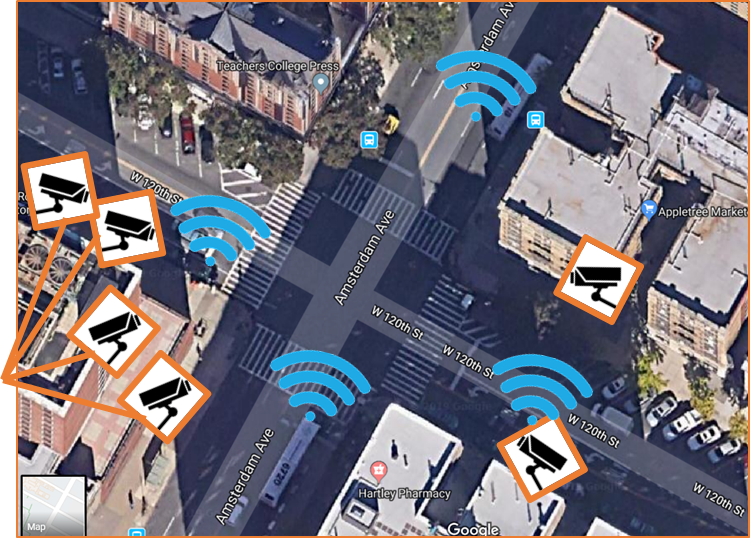

本文的重点是智慧城市交叉口的低延迟高带宽应用。我们探索如何支持隐私保护的实时应用,例如云联网车辆的协同控制和主动行人警报和辅助;两者都需要使用多个传感器,包括多个高分辨率摄像机。基于视频的应用的关键任务之一是高精度地检测和跟踪十字路口中的物体。我们探索了在智能城市交叉口应用中实现实时性的方法,这些应用由33.3毫秒以下的端到端延迟定义。这包括(i)传感器数据采集;(ii)最终用户、传感器和边缘云之间的通信;(iii)基于人工智能的推理计算;以及 (iv)向交叉路口的参与者提供反馈。先进的“雷达屏幕”应用程序旨在向交叉点参与者实时广播物体的位置和速度。

图1:具有摄像头和边缘云节点的 COSMOS 试点站点。

1.1隐私

2022 年之前的智慧城市实施表明,隐私和数据安全是阻碍大规模部署成功的关键问题。当视频录制成为数据采集和处理的一部分时,隐私问题会进一步放大。COSMOS研究计划具有强大的社区外展组件。这体现在运行NSF REM和RET计划的多年活动中,来自哈莱姆和其他纽约市学校的教师接受培训并参与为贫困学校的学生开发STEM教材(https://www.cosmos-lab.org/outreach/,[4])。我们的隐私方法是将当地社区整合到数据治理流程中。我们将开发技术,使社区能够定义和控制由边缘计算和临时数据存储范式支持的数据采集和处理。

1.2实时交互

智慧城市部署的最重要目标是提高行人和其他参与者的安全性。即使在最拥挤的城市,也希望用更安全的自动驾驶汽车取代人类司机。这激发了与城市基础设施交互的云连接车辆的概念,以提高其导航能力,并且需要与安全关键型实时操作相关的极低闭环延迟。

实时适用于安全关键型应用

提取指示潜在碰撞的智能并向车辆或行人提供反馈会带来计算和延迟挑战。城市街道动态由以每小时 0 至 100 公里(km/h)的速度行驶的车辆决定。如果我们考虑以 10km/h 行驶的车辆,这是拥挤十字路口车辆的典型速度,车辆以大约每秒 3 米的速度行驶(m/s).如果我们将 3 ms 除以传统视频的标准帧速率(每秒 30 帧),则结果是10 cm的移动,或车辆在 33.3 毫秒内行驶的距离。如果车辆的制动可以在这段时间内激活,可以想象最终可以避免许多危及生命的交通事故。这种近似计算使我们的目标延迟低于 33 毫秒。

传感器延迟

智能城市传感器将具有广泛的工作频率和数据采集带宽。CO2 传感器每小时可以收集几个字节,而高分辨率相机可以以每秒数十兆比特的速度以压缩形式流式传输数据,或者以每秒几千兆字节的速度以未压缩形式流式传输数据。低成本CMOS成像传感器的延迟为几毫秒,其低到不会阻碍1/30秒的闭环目标。IP 摄像机使用视频编码和流协议,由于帧间编码,可能需要数百毫秒才能解码的缓冲区;此过程严重阻碍了提供延迟小于 33.3 毫秒的闭环服务的能力。

通信延迟

通信和网络延迟由物理介质的速度决定,因为它们由应用层的协议驱动。COSMOS 光网络可以提供高达 100 Gb/s 的速度,提供几乎无限的原始速度。另一方面,高分辨率视频的传统流媒体可能会产生数百毫秒的延迟。这表明视频处理和推理最好在“极端”边缘完成 - 就在视频传感器旁边。更有趣的是,这激发了对集成编码和视频传输协议的研究,这些协议针对高带宽边缘通信基础设施上的视频超低延迟传输进行了优化。

推理和决策延迟

推理延迟来自视频预处理和深度学习算法,用于多个对象检测和跟踪。DL 模型的训练是离线完成的,不会影响实时交互的延迟。已发表的工作和我们自己的研究表明,NVIDIA TensorRT 和 DeepStream 等专用管道中的当代 GPU 可以提供高于30 fps 用于对象检测和跟踪。我们之前已经证明,推理速度随输入分辨率和实际设备能力而变化,但我们评估推理计算不会成为实现实时延迟目标的瓶颈。

决策过程被定义为建立在对象检测和跟踪之上的更高水平的智能。例如,此过程将推断行人在与快速车辆相交的轨迹上的含义,并为行人或车辆创建警告(甚至命令)。此类过程的计算需求正在进行研究,但预计延迟将小于 1 毫秒。

1.3COSMOS实验试验台

纽约市是繁忙大都市的一个很好的例子,它为智能城市技术的部署提供了巨大的挑战。繁忙的城市交通交叉路口有大量车辆和行人以不同的速度向多个方向移动,通常表现出混乱或不可预测的行为。此外,建筑物拐角、停放的车辆和建筑设备等障碍物给自动驾驶汽车传感器带来了困难,需要进一步推进基于交通交叉口的监控、测量、学习和反馈自动化。

COSMOS测试平台是NSF资助的用于城市规模部署的云增强型开放软件定义移动无线测试平台[5],为应用程序和架构提供了一个实验平台,以支持未来大都市的智能节点。对于我们的研究,我们使用位于纽约市哥伦比亚大学的COSMOS试点站点,位于第120街和阿姆斯特丹大道的交汇处。试点节点包括两个街面摄像头和两个鸟瞰摄像机,如图 1 所示。COSMOS 边缘云服务器可以运行实时算法来检测和跟踪十字路口中的物体,以监控和管理交通流量和行人安全。该节点配备了一个光学x-haul传输系统,用于连接支持 AI 的边缘计算集群。这允许使用具有FPGA辅助功能的可大规模扩展的CPU和GPU资源进行基带处理,这也可以支持软件定义的无线电。为实验提供了四个技术层:用户设备层、无线电硬件和前传网络资源、无线电云和通用云。

2 智能节点的构建模块

截至 2022 年,用于实现智慧城市愿景的单个技术模块以低功耗芯片、高带宽调制解调器、有线和无线网络以及用于机器学习(ML)和深度学习(DL)的 GPU 的形式存在。然而,在隐私保护、安全、智能决策、系统集成以及技术与社会公益之间的相互作用方面存在重大挑战。

2.1传感器

传感器的范围从数十个基于物联网的低速率设备收集有关污染的数据到几个高分辨率激光雷达和提供实时馈送的摄像头。多模态数据聚合和协同智能是智能交叉口节点具有重要意义的研究课题[6]。

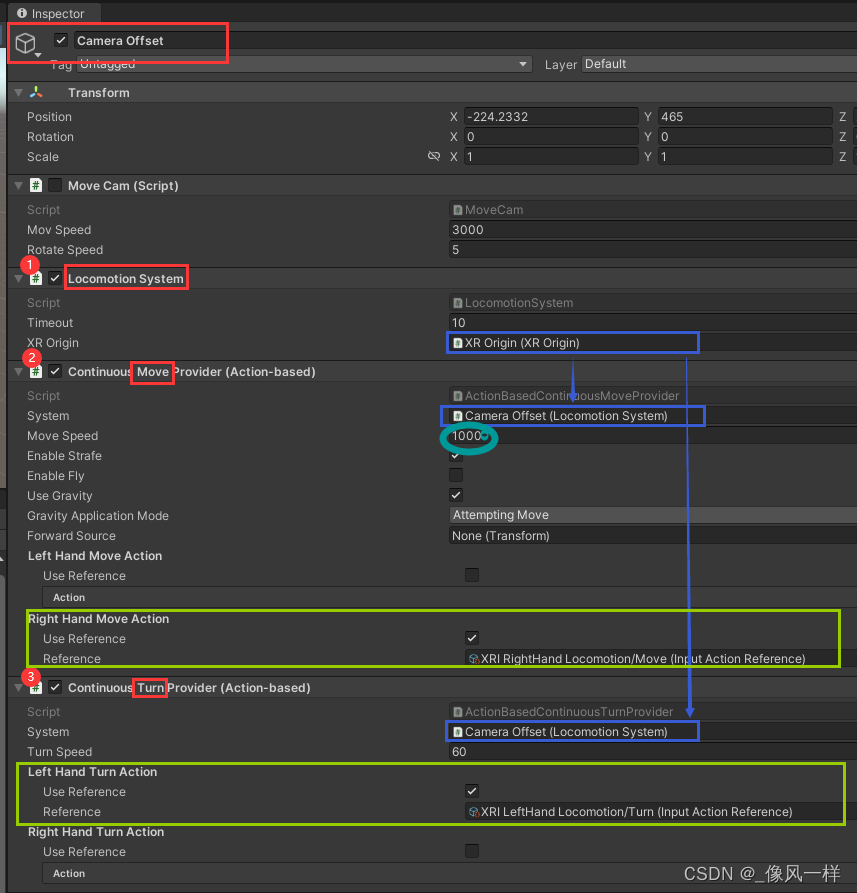

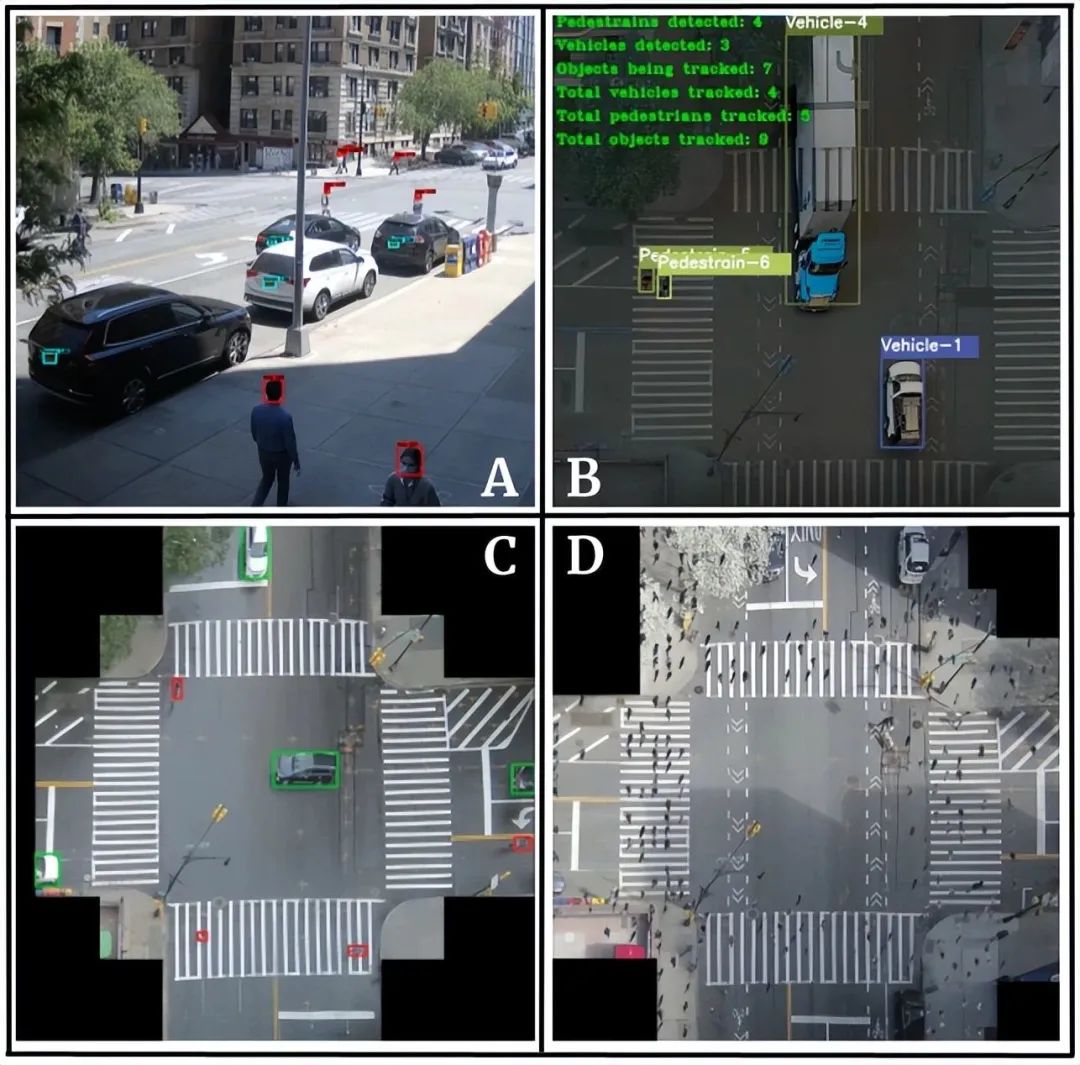

图2:COSMOS 测试台摄像机视图:(A) 1 楼摄像机,第 120 街;(B) 阿姆斯特丹大道二楼摄像头;(C) 阿姆斯特丹大道12楼摄像头;(D) 校准的 12 楼摄像机。

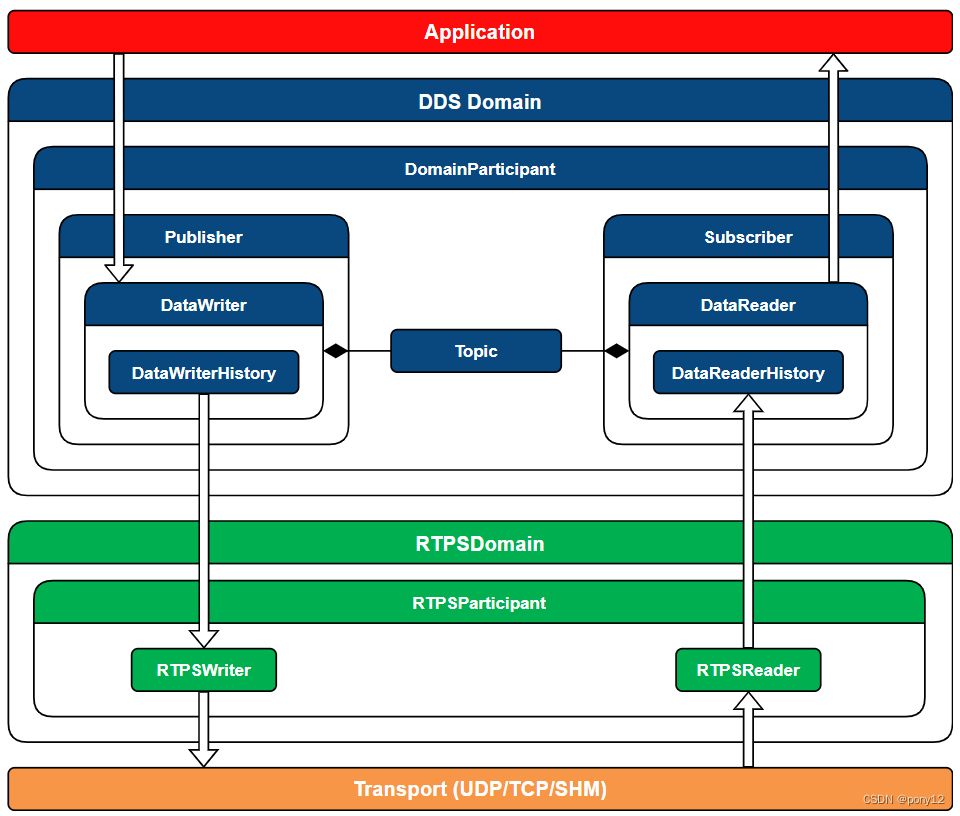

2.2联网

对于高带宽应用,一个十字路口的网络必须支持来自六个基础设施安装的摄像机的无线和有线连接。虽然来自传统 IP 摄像机的编码视频可能需要低于 100 Mb/秒的速度,但超低延迟的实验提供了以每台摄像机几 Gb/秒的速度发送原始视频的动力。对云连接车辆的支持可能需要以原始或元格式无线方式从每辆车收集视频和其他数据。传统的视频流协议可能不足以实现非常低的延迟,因此对边缘流协议的研究是一个吸引人的话题。

2.3边缘计算

智慧城市交叉路口应用需要大量的计算资源,需要最小的延迟,并且其功能可以限制在有限的地理区域内。此外,数据隐私、安全性和本地数据治理至关重要。这强烈暗示边缘计算是正确的模式。可以使用两种形式的边缘计算。在极端情况下,基于AI的计算可以在位于传感器上的设备上完成,例如Nvidia Jetson Nanos或集成到物联网芯片中的支持ML的ARM M1-M4处理器。另一方面,更强大的计算节点可以位于十字路口建筑物的设备室中。然后,节点通过高速无线、有线或光学基础设施连接到传感器。为了通过AI计算支持从传感器到执行器的低延迟,边缘计算节点必须与网络通信基础设施紧密集成。

2.4支持 AI 的数据处理

支持智慧城市交叉口的智能任务复杂程度各不相同:CO2 传感器每小时生成一个字节,而我们研究中的高分辨率相机每秒产生兆比特通过可视化深度学习模型进行分析,用于执行器的对象检测、跟踪和智能决策。自动化和人工智能对于为高度拥挤的交通交叉路口扩展系统至关重要。现成的人工智能模型必须经过修改和重新训练,以适应智慧城市十字路口应用的特殊性——一个例子是从鸟瞰摄像头观看时检测微小的行人。

数据预处理

可视化深度学习工具需要数据准备、标记和扩充。COSMOS 试点节点包含低仰角摄像机和高高仰角鸟瞰摄像机,每个摄像机都需要不同类型的预处理(图 2)。到交叉点的角度和距离的变化、对象的比例和重叠的视野允许对给定应用程序的最佳视图进行试验。例如,一楼摄像头更靠近交通对象。因此,它们为多相机对象重新识别等应用提供了更多的视觉细节,但由于与相机不同距离的物体之间的比例失真,它们不太适合分析大规模交通模式——鸟瞰相机为此类应用提供了更好的视角。

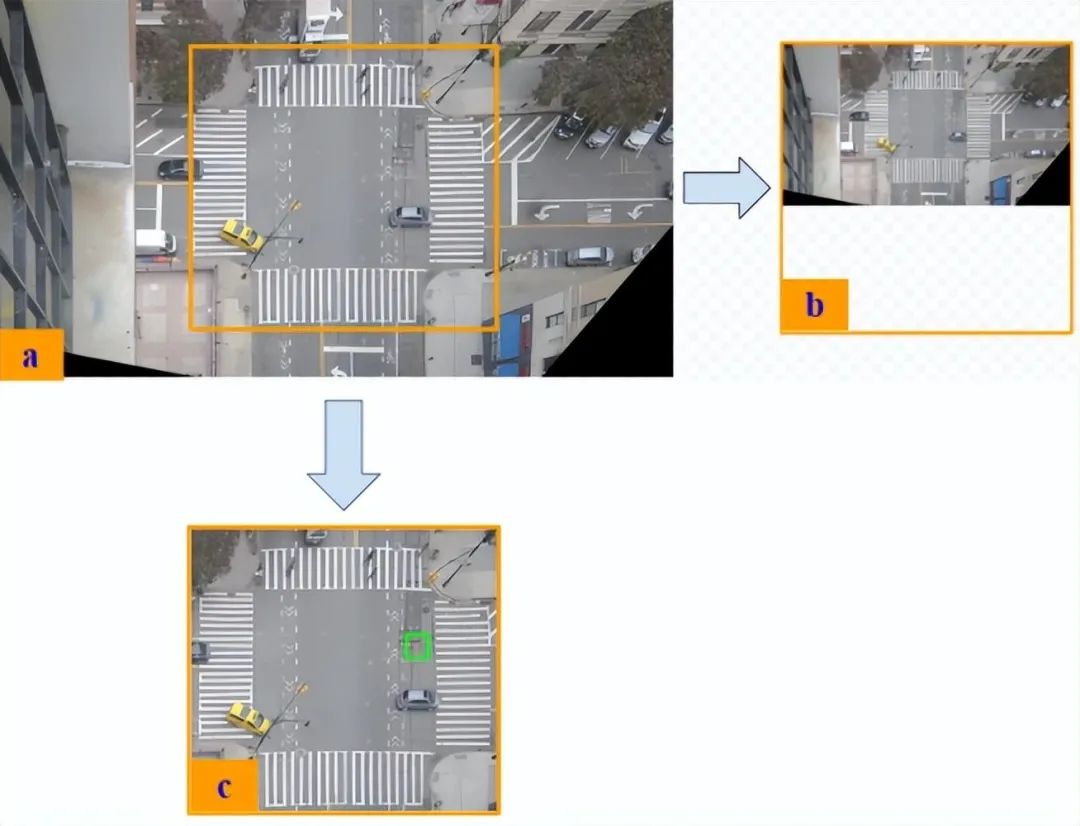

高仰角相机允许我们执行校准转换,以提高深度学习模型的有效性。见图2和图5,通过应用单应性变换,可以高仰角相机视图以垂直于道路,然后调整帧的大小和裁剪创建许多DL模型所需的方形纵横比。在我们的交通交叉口用例中,框架中有一些位置没有出现相关物体(即建筑物墙壁上没有汽车或在空中飞行的行人)。这激发了在框架顶部叠加的(黑色)蒙版的创建,如图 3 和图 5。

监督对象检测和跟踪模型需要大量精确注释的地面实况标签来“通过示例”训练算法。制作准确且一致的标记视频集很困难,因为需要领域知识和大量时间。为了支持我们的实验,我们注释了数千帧,以捕捉各种天气、照明和拥堵条件下的十字路口。

图 3:(A) YOLOv4 检测底层视频中的人脸和车牌;(B)在鸟瞰视频中对车辆和行人进行SORT跟踪;(C)交叉物体的鸟瞰地面实况边界框标注;(D)行人复制粘贴数据增强,以提高对小物体的检测

目标检测模型通常难以进行小目标检测。鸟瞰摄像头视图中的小行人以及底层摄像头视图中的远处车牌传达的信息很少。这导致检测和跟踪精度相对较差。为了提高性能,我们部署了使用小对象数据集[7]预训练DL模型的技术,并应用了数据增强技术,例如图3(D)所示的复制/粘贴方法。

表 1: 目标检测性能

模型 | 行人AP(%) | 车辆应付账款(%) | mAP(%) | 推理速度* |

YOLOv4 | 66.31 | 97.58 | 81.95 | 34.99 |

SSD | 57.04 | 94.81 | 75.93 | 11.31 |

RetinaNet | 20.83 | 95.59 | 58.21 | 22.97 |

注:*NVIDIA T4 GPU上的推理速度(FPS)。

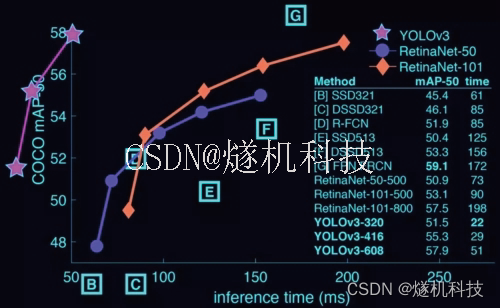

对象检测和跟踪

在智能交通交叉路口,检测行人和车辆并且跟踪其轨迹是所有下游应用的先决条件,如图 4。这涉及两个计算机视觉任务:对象检测和多对象跟踪(Multiple Object Tracking,MOT)。对象检测的目的是对框架内的对象进行定位和分类。MOT 旨在跨连续帧关联对象标识。最先进的方法依赖于深度学习模块,如卷积神经网络(CNN)[8] 和视觉变换器 [9]。这些方法带来了沉重的计算成本, 准确性-速度权衡 - 计算复杂性和推理速度之间的预算 - 对于智能城市应用的成功至关重要。考虑到这一点,我们尝试了一系列用于检测和跟踪物体的算法,以根据我们定制的鸟瞰视频注释数据集找到最佳方法 [10]。

我们选择 YOLOv4 [11] 作为所有下游应用的基础检测器,因为它能够实时提供准确的结果。目标检测性能如表1所示,其中平均精度(AP)和平均平均精度(mAP)为用作评估指标。在我们的鸟瞰交叉点数据中,YOLOv4 的性能优于两个 RetinaNet[12] 和 SSD [13] 在 AP 和推理速度方面,其中推理速度被测量为批量大小等于 1 的模型向前传递的平均时间。对于 MOT,需要分别考虑不同的场景。对于鸟瞰相机,物体遮挡几乎不会发生,因此重新识别(reID)计算不像地面摄像机那样必要。reID计算通常是MOT算法中的计算瓶颈。“简单的在线和实时跟踪”(Simple Online and Realtime Tracking,SORT)和“具有深度关联指标的简单在线和实时跟踪”(DeepSORT)足以满足鸟瞰相机的需求。检测图示如图3所示。

图4:第 120 街和阿姆斯特丹大道上的行人和车辆检测。

图像分辨率和对象密度

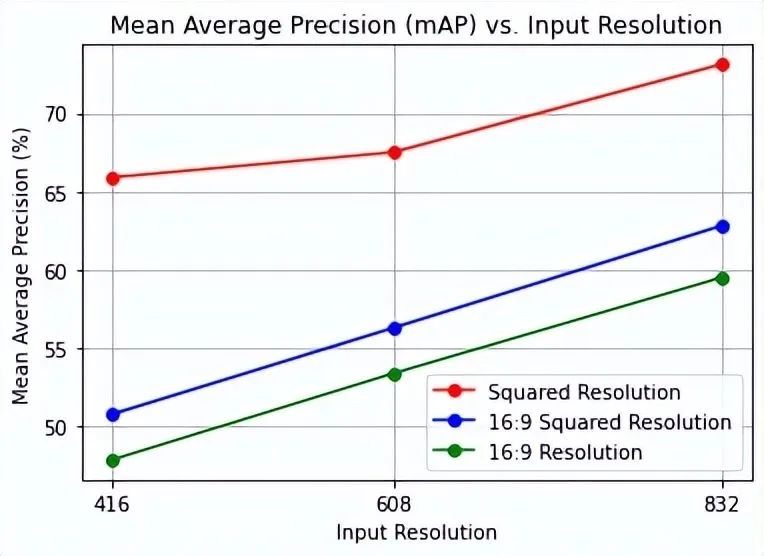

升高的鸟瞰摄像机可以很好地看到整个场景,如图 2. 看起来很小的行人,成为对象检测和跟踪的问题。直观地说,输入图像的分辨率越高,可以保留的对象特征就越多。但是,更高的分辨率会导致更大的计算成本,从而使推理变慢。我们测试了十几种图像输入分辨率和纵横比的组合,以找到精度和速度之间的最佳平衡,其中三种如图5所示。

图5:(a) 16:9校准的原始框架;(b) 使用零填充的 16:9 帧平方;(c) 方形裁剪框架。

一些深度学习模型,如 YOLOv4 [11],在具有固定大小的方形纵横比的输入图像上表现更好。为了最大限度地保留交叉路口场景的重要特征并最小化不相关的分量,实验表明,“平方裁剪”832×832输入产生最佳结果[14]。

图 6:行人和车辆的 mAP,9 种图像分辨率与纵横比

对象密度是指场景中的对象数量,随着街道的繁忙程度在一天中发生变化,它可能会影响推理速度。我们探索了十个 90 秒视频的推理时间,其中对象的数量从 4,000 到 26,000 不等。结果显示,从最低密度到最高密度的情况,计算负载增加了大约 40%。这很重要,因为它表明对象密度可用于在计算资源之间切换,以获得最佳的功耗/精度平衡。

3 应用

基于视频的物体检测和跟踪的进步使许多交通十字路口应用程序的部署成为可能,人们可以识别十字路口中物体的位置,并按车辆、行人、自行车等类型对其进行分类。它们可以作为唯一实体进行跟踪,这些实体在交通周期的持续时间、不同的摄像机视图以及一天、一周、一个月和一年中的时间中持续存在。丰富的空间、时间和视觉数据使得执行数据匿名化、交通趋势量化、人群行为监控、实时交叉口雷达测绘等成为可能。

3.1隐私保护 - 人脸和车牌匿名化

图7:人脸和车牌模糊管道的输入(左)和输出(右)。

从街道层面收集公共空间的实时图像和视频无意中涉及捕获敏感信息,例如面部和车牌。为了避免我们的数据集泄露私人信息,我们生成了一个管道来自动模糊这些敏感区域。我们在自定义标记数据集上训练了几个对象检测模型,以检测人脸和许可证,以便进行后续匿名化。使用顺序视频数据集进行训练时,请务必将整个视频排除在训练过程之外以用于验证。静止物体——停放的汽车、坐着的行人、链式自行车等——在许多帧中出现相同,对这些静止物体的模型评估会产生有偏差的结果。这会导致模型过度拟合和对新交叉路口场景的泛化不佳,这是必须解决的问题。

图 7 显示了匿名化管道的示例输入和输出帧。对于我们的人脸和许可证检测模型,我们选择了 YOLOv4 [11],因为它在检测准确性和推理速度之间取得了折衷。对于隐私关键型应用程序,最相关的性能度量是召回率,即在通过框架的总数中检测到的相关人脸和许可证的数量。误报比漏报问题更少,因为它们会导致帧的额外模糊区域,但不会导致隐私泄露。在我们的案例中,并非所有人脸和许可证都是“相关的”——有些距离太远,分辨率太低,无法识别。我们通过定义像素区域阈值将这些实例从召回评估中排除,低于该阈值的对象将被忽略。我们发现,在某些阈值以下,面部特征和车牌字符无法可靠地识别。虽然存在可能恢复这些功能的信息重建技术,但这超出了本项目考虑它们的范围。此外,我们需要重新考虑我们对匿名化的选择,因为任何形式的模糊都变得无效。在可见对象评估中,我们的管道模糊了超过 99% 的可见人脸和许可证,在总体评估中,它模糊了超过 96% 大于 100 像素的对象。

为了增加我们对匿名化管道的信心,我们通过检查匿名输出视频来执行手动评估,其中遗漏的定义是一个对象暴露了超过四分之一的脸或车牌。人工评估的结果证实了程序化评估的结果,并揭示了我们的模型始终遗漏的边缘情况,图 8.大多数边缘情况是由于车牌边界遮挡、行人身体遮挡和树枝遮挡等遮挡造成的,导致一致的假阴性。需要更多的数据收集和培训来纠正这些边缘情况。

图8:正常的模糊管道检测(顶部)与边缘情况(底部)。

3.2对对象进行计数

智能交叉路口的一个重要目标是实时分析交通流量。为此,我们使用检测和跟踪来对车辆和行人进行分类和计数,并跟踪他们通过交叉路口的路径。轨道的累积为交通趋势分析提供了足够的数据,可用于优化交通流量并提高十字路口的行人安全性。

为了执行对象跟踪,我们使用基于检测(MOT)的算法DeepSORT。DeepSORT 需要一个对象检测模型来提供要跟踪的对象的位置和特征。在检测车辆和行人的情况下,DeepSORT使用卡尔曼滤波器在视频帧之间映射具有相似大小和运动的检测。通过这种方式,我们可以为检测到的对象分配 ID,这些对象在多个视频帧中持续存在。此外,DeepSORT使用对象的视觉特征来提高跟踪的可靠性。即使无法在连续帧中检测到对象,也可以通过重新识别模型(reID)根据其视觉特征将其分配给正确的轨迹。

虽然DeepSORT是一个强大的跟踪系统,但它仍然依赖于高质量的物体检测。如果一个物体在多个连续帧中没有被检测到或错误分类,它将被算法视为“新轨迹”——旧轨迹消失,重新检测时创建一个新轨迹。对于车辆,我们实现了一致的高精度检测,以及相应的高精度跟踪,但对于横截面小4-5倍的行人来说,高精度检测是一项更艰巨的任务。由于行人检测精度较低,行人跟踪精度会受到影响。数据增强技术,如图3(D)所示的复制粘贴行人方法和小目标数据集上的预训练对象检测器,显示出小目标检测的改进,但行人检测和跟踪精度仍低于车辆,车辆和行人的多目标跟踪精度(MOTA)分别为75.16%和18.23%。

车辆跟踪性能足以满足量化交通流量的应用。例如,在自动计数任务中,我们将通过十字路口的车辆记录为右转、左转或从所有四个方向直行,在 21 分钟的视频录制中评估的准确率为 95%。

3.3大流行病中的社交距离

智慧城市通过提供监测、分析和潜在控制社交距离行为的手段,可以帮助抗击COVID-19等全球流行病。我们提出了几种技术,并将其应用于在COSMOS试点交叉路口收集的视频数据集。

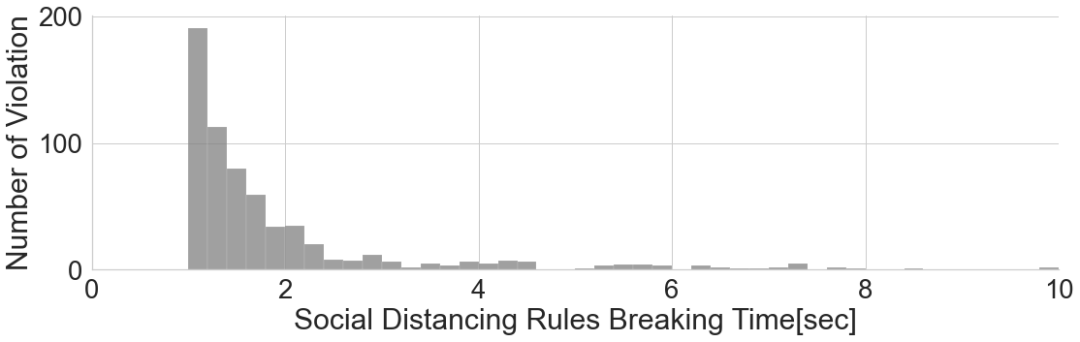

基本思想是估计行人之间的距离,并将其与建议的最小距离阈值进行比较。第一步是检测行人。然后通过计算一帧内行人之间的像素距离来估计实际距离。在框架之间跟踪行人有助于计算与安全社交距离组相关的高阶统计数据,这比个人对个人的社会距离违规率更有意义。当熟人作为“安全群体”一起走在街上时,群体内的距离通常小于社交距离阈值,这会触发违规的指示。为了解决这个问题,我们利用行人轨迹相似性和稳定性,可以评估每对行人之间的运动动力学。这种组验证方法能够显著减少误报违规的数量,实现 F1 分值0.92。基于这种方法,我们为鸟瞰摄像机构建了社交距离分析系统 B-SDA [15],以及与地面摄像机的补充方法 Auto-SDA [16、17]。

图 9:B-SDA:违反社交距离持续时间的分布。

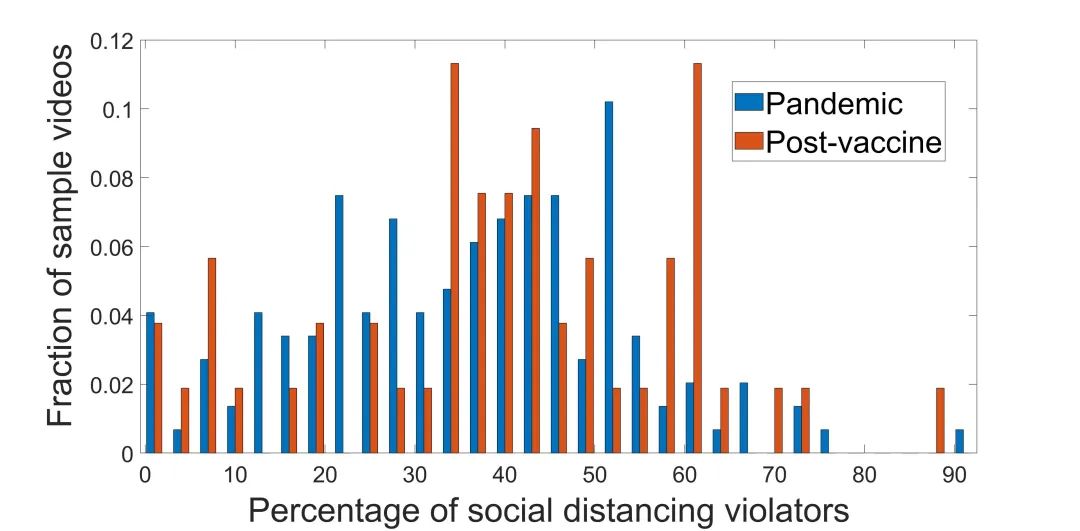

图9所示的鸟瞰视频数据集获得的结果示例显示了Covid-19大流行期间违反社交距离的持续时间分布。图 10 显示了底层摄像头数据集(i)在大流行期间和 (ii) 疫苗广泛可用后的社交距离违规率。对大流行之前和大流行期间的多项统计数据进行的详细分析和比较表明,所提出的系统可以可靠地识别违反社交距离的行为。

图 10:自动 SDA:违反社交距离百分比的标准化直方图。

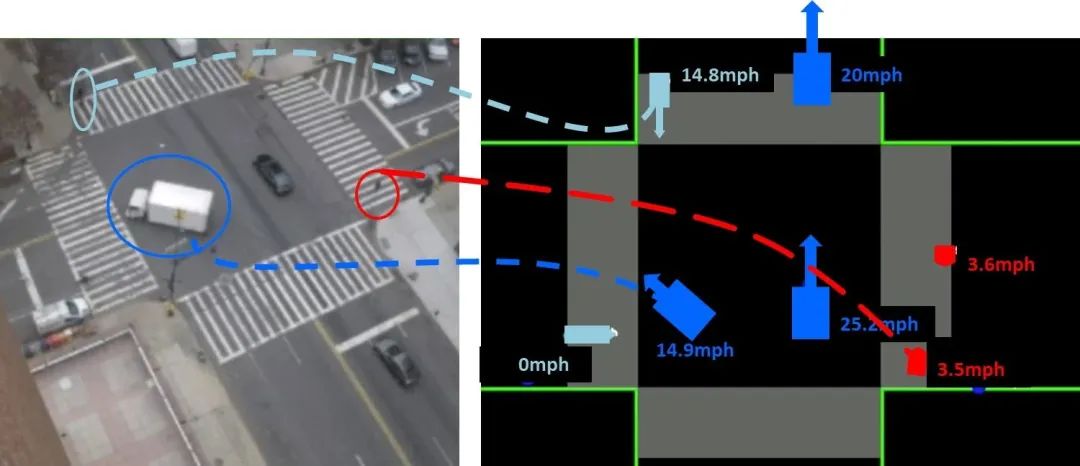

3.4实时“雷达屏幕”

“雷达屏幕”应用程序旨在推断交通交叉路口内物体的位置和速度,并将其广播给十字路口的参与者,如图 11 所示。信息可以以原始或编码/元格式分发。该应用程序旨在提供实时服务,在观察物体和无线广播传输之间延迟为1/30秒。如前所述,这是由近似 10 厘米的车辆运动以 10 公里/小时的速度驱动的。该应用程序包括从周围建筑物采集视频,从车辆内的摄像头收集视频(或编码数据),收集物联网传感器数据,通过高速网络传输到推理计算机,数据聚合和预处理,基于深度学习的对象检测和跟踪,在更高抽象级别提取信息,以及(在更高级的版本中)在优化交通流后可能向单个车辆发出的命令。最后一步是信息广播。

图 11:“雷达屏幕”:视频的一帧,其中包含交叉点内物体的位置和速度。

这是一个理想的应用,因为实现 33.3 毫秒的累积延迟在技术上具有挑战性。在极端边缘计算单元或边缘计算中心的计算能力、功耗和延迟最小化之间取得平衡,需要快速的传感器数据采集以及动态网络和资源控制。此应用程序激发了研究,以优化本文前面部分中描述的每个构建块以及以延迟为中心的跨模块系统集成。

3.5交通管理

位于各个交叉点的智能节点提供强大的数据采集和智能边缘计算。在更大的范围内,智慧城市需要来自多个交叉点的数据聚合和相互协调。在这方面,我们已经开始与交通工程专家合作研究关键参数的定义,例如信号灯配时、传感器位置以及智能智能交叉口节点和交通优化系统之间数据交换的 API[18]。我们正在构建模拟器并定义数字孪生,这些数字孪生将在单个交通参与者的行为和交通管理的全局优化中发挥预测作用。

4 结论和未来挑战

提出了智慧城市交叉口作为未来大都市智能节点的愿景。所提议的架构是由保护隐私的社会需求驱动的,这强烈暗示边缘计算和智能是数据管理和处理的关键范式。介绍了传感器、网络、边缘人工智能计算等关键技术。研究了未来安全关键系统的实时需求,总结了“雷达屏幕”应用程序的设计考虑因素,该应用实现了从传感器到执行器的闭环。本文探讨了基于33.3 ms目标的低延迟需求。系统集成的挑战已通过在纽约市COSMOS试验台的试点节点上进行的实验实例加以说明。

我们的研究指出了以下探索主题:

(i)最先进的基于 DL 的对象检测模型由超过 6000 万个参数组成,需要传递 100 多个卷积层,其中每个卷积都有 O(n4) 复杂性。模型优化技术,如权重修剪、推理调度和神经算法搜索策略 [19] 需要纳入实际系统;

(ii)由于标签成本和质量问题,依赖监督数据集进行视频处理是不可扩展的。这就需要研究基于连续学习或主动学习的无监督学习方法,并充分利用交通交叉口内固定场景的特殊性[20];

(iii)来自多个摄像机的数据融合有望显著提高检测和跟踪精度;

(iv)通过在“极端边缘”使用处理,可以实现低速率小数据应用程序的低延迟,但满足高分辨率视频 1/30 秒延迟的要求是一项挑战。应探索新的视频编码方法和流协议,重点是本地化的低延迟性能。

参考文献

[1] L. Sánchez, L. Muñoz, J. A. Galache, P. Sotres, J. R. Santana, V. Gutiérrez, R. Ramdhany, A. D. Gluhak, S. Krco, E. Theodoridis, and D. Pfisterer, “Smartsantander: Iot experimentation over a smart city testbed,” Comput. Networks, vol. 61, pp. 217–238, 2014.

[2] L. Belli, A. Cilfone, L. Davoli, G. Ferrari, P. Adorni, F. Di Nocera, A. Dall’Olio, C. Pellegrini, M. Mordacci, and E. Bertolotti, “Iot-enabled smart sustainable cities: Challenges and approaches,” Smart Cities, vol. 3, no. 3, pp. 1039–1071, 2020.

[3] A. Y. Ding, E. Peltonen, T. Meuser, A. Aral, C. Becker, S. Dustdar, T. Hiessl, D. Kranzlmüller, M. Liyanage, S. Maghsudi, N. Mohan, J. Ott, J. S. Rellermeyer, S. Schulte, H. Schulzrinne, G. Solmaz, S. Tarkoma, B. Varghese, and L. Wolf, “Roadmap for edge ai: A dagstuhl perspective,” SIGCOMM Comput. Commun. Rev., vol. 52, p. 28–33, mar 2022.

[4] P. Skrimponis, N. Makris, S. B. Rajguru, K. Cheng, J. Ostrometzky, E. Ford, Z. Kostic, G. Zussman, and T. Korakis, “Cosmos educational toolkit: Using experimental wireless networking to enhance middle/high school stem education,” SIGCOMM Comput. Commun. Rev., vol. 50, p. 58–65, oct 2020.

[5] D. Raychaudhuri, I. Seskar, G. Zussman, T. Korakis, D. Kilper, T. Chen, J. Kolodziejski, M. Sherman, Z. Kostic, X. Gu, et al., “Challenge: Cosmos: A city-scale programmable testbed for experimentation with advanced wireless,” in Proc. ACM MobiCom, 2020.

[6] X. Xu, Q. Huang, X. Yin, M. Abbasi, M. R. Khosravi, and L. Qi, “Intelligent offloading for collaborative smart city services in edge computing,” IEEE Internet Things J., vol. 7, no. 9, pp. 7919–7927, 2020.

[7] P. Zhu, L. Wen, D. Du, X. Bian, H. Ling, Q. Hu, Q. Nie, H. Cheng, C. Liu, X. Liu, et al., “Visdrone-det2018: The vision meets drone object detection in image challenge results,” in Proc. ECCV Workshops, 2018.

[8] L. Liu, W. Ouyang, X. Wang, P. Fieguth, J. Chen, X. Liu, and M. Pietikäinen, “Deep learning for generic object detection: A survey,” Int. J. Comput. Vis., vol. 128, no. 2, pp. 261–318, 2020.

[9] A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. Zhai, T. Unterthiner, M. Dehghani, M. Minderer, G. Heigold, S. Gelly, et al., “An image is worth 16x16 words: Transformers for image recognition at scale,” arXiv preprint:2010.11929, 2020.

[10] S. Yang, E. Bailey, Z. Yang, J. Ostrometzky, G. Zussman, I. Seskar, and Z. Kostic, “COSMOS smart intersection: Edge compute and communications for bird’s eye object tracking,” in Proc. SmartEdge, 2020.

[11] A. Bochkovskiy, C.-Y. Wang, and H.-Y. M. Liao, “YOLOv4: Optimal speed and accuracy of object detection,” arXiv preprint:2004.10934, 2020.

[12] T.-Y. Lin, P. Goyal, R. Girshick, K. He, and P. Dollár, “Focal loss for dense object detection,” in Proc.ICCV, 2017.

[13] W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C.-Y. Fu, and A. C. Berg, “SSD: Single shot multibox detector,” in Proc. ECCV, 2016.

[14] Z. Duan, Z. Yang, R. Samoilenko, D. S. Oza, A. Jagadeesan, M. Sun, H. Ye, Z. Xiong, G. Zussman, and Z. Kostic, “Smart city traffic intersection: Impact of video quality and scene complexity on precision and inference,” in Proc. IEEE Smart City’21, 2021.

[15] Z. Yang, M. Sun, H. Ye, Z. Xiong, G. Zussman, and Z. Kostic, “Birds eye view social distancing analysis system,” arXiv preprint:2112.07159, 2021.

[16] M. Ghasemi, Z. Yang, M. Sun, H. Ye, Z. Xiong, Z. Kostic, and G. Zussman, “Demo: Video-based social distancing evaluation in the COSMOS testbed pilot site,” in Proc. ACM MOBICOM’21, 2021.

[17] M. Ghasemi, Z. Kostic, J. Ghaderi, and G. Zussman, “Auto-SDA: Automated video-based social distancing analyzer,” in Proc. ACM HotEdgeVideo, 2021.

[18] G. Karagiannis, O. Altintas, E. Ekici, G. Heijenk, B. Jarupan, K. Lin, and T. Weil, “Vehicular networking: A survey and tutorial on requirements, architectures, challenges, standards and solutions,” IEEE Commun. Surveys Tuts., vol. 13, no. 4, pp. 584–616, 2011.

[19] C. R. Banbury, V. J. Reddi, M. Lam, W. Fu, A. Fazel, J. Holleman, X. Huang, R. Hurtado, D. Kanter, A. Lokhmotov, et al., “Benchmarking tinyml systems: Challenges and direction,” arXiv preprint:2003.04821, 2020.

[20] Z. Dai, G. Wang, S. Zhu, W. Yuan, and P. Tan, “Cluster contrast for unsupervised person re-identification.,” arXiv preprint:2103.11568, 2021.

扫描加入免费的「智慧城市之智慧交通」知识星球可了解更多行业资讯和资料。

欢迎加入智能交通技术群!

联系方式:微信号18515441838