回归预测 | MATLAB实现BO-LSTM贝叶斯优化长短期神经网络多输入单输出回归预测

目录

- 回归预测 | MATLAB实现BO-LSTM贝叶斯优化长短期神经网络多输入单输出回归预测

- 效果一览

- 基本介绍

- 模型搭建

- 程序设计

- 参考资料

效果一览

基本介绍

MATLAB实现BO-LSTM贝叶斯优化长短期神经网络多输入单输出回归预测。基于贝叶斯(bayes)优化长短期神经网络的回归预测,BO-LSTM/Bayes-LSTM回归预测预测模型。

1.优化参数为:学习率,隐含层节点,正则化参数。

2.评价指标包括:R2、MAE、MSE、RMSE和MAPE等。

3.运行环境matlab2020b及以上。

模型搭建

BO-LSTM(贝叶斯优化LSTM)是一种结合了贝叶斯优化和长短期神经网络(LSTM)的方法。

长短期神经网络(LSTM)是循环神经网络(RNN)的一种变体,具有比传统循环神经网络更强大的建模能力。

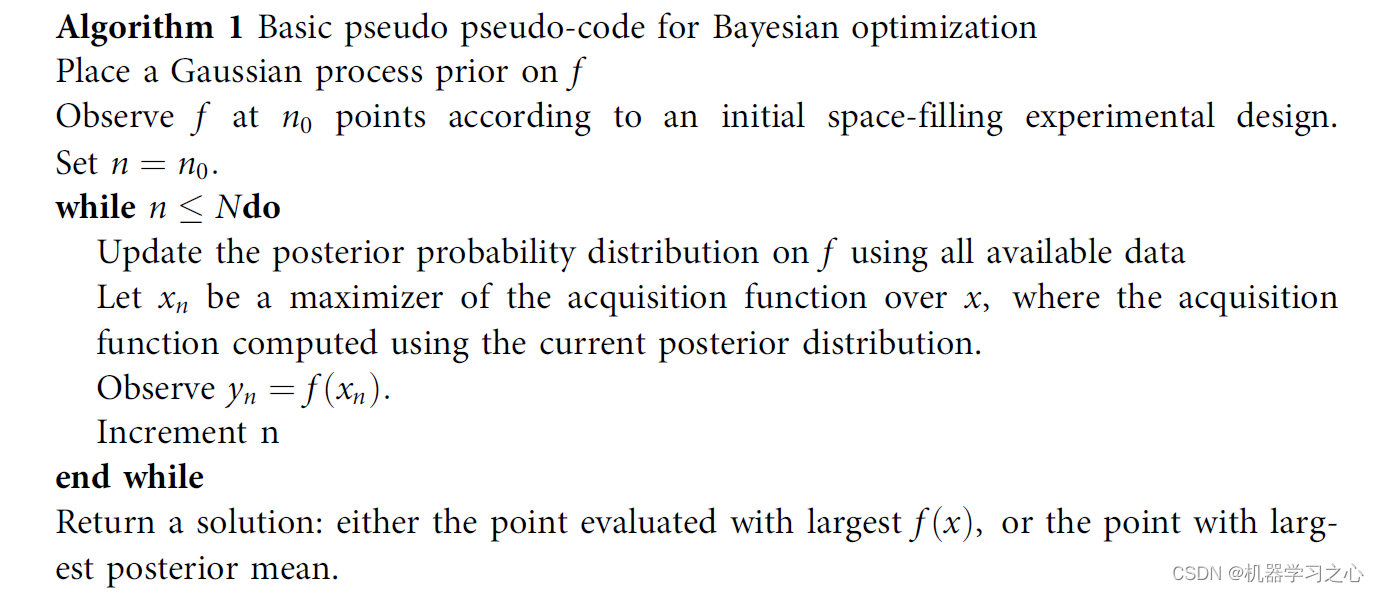

贝叶斯优化是一种用于优化问题的方法,它能够在未知的目标函数上进行采样,并根据已有的样本调整采样的位置。这种方法可以帮助我们在搜索空间中高效地找到最优解。

BO-LSTM的基本思想是使用贝叶斯优化来自动调整GRU模型的超参数,以获得更好的预测性能。贝叶斯优化算法根据已有的模型性能样本,选择下一个超参数配置进行评估,逐步搜索超参数空间,并利用贝叶斯推断方法更新超参数的概率分布。通过这种方式,BO-LSTM可以在相对较少的模型训练迭代次数内找到更好的超参数配置,从而提高预测的准确性。

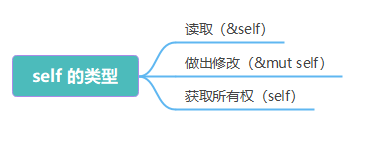

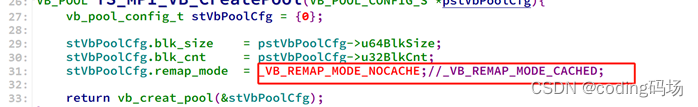

- 伪代码

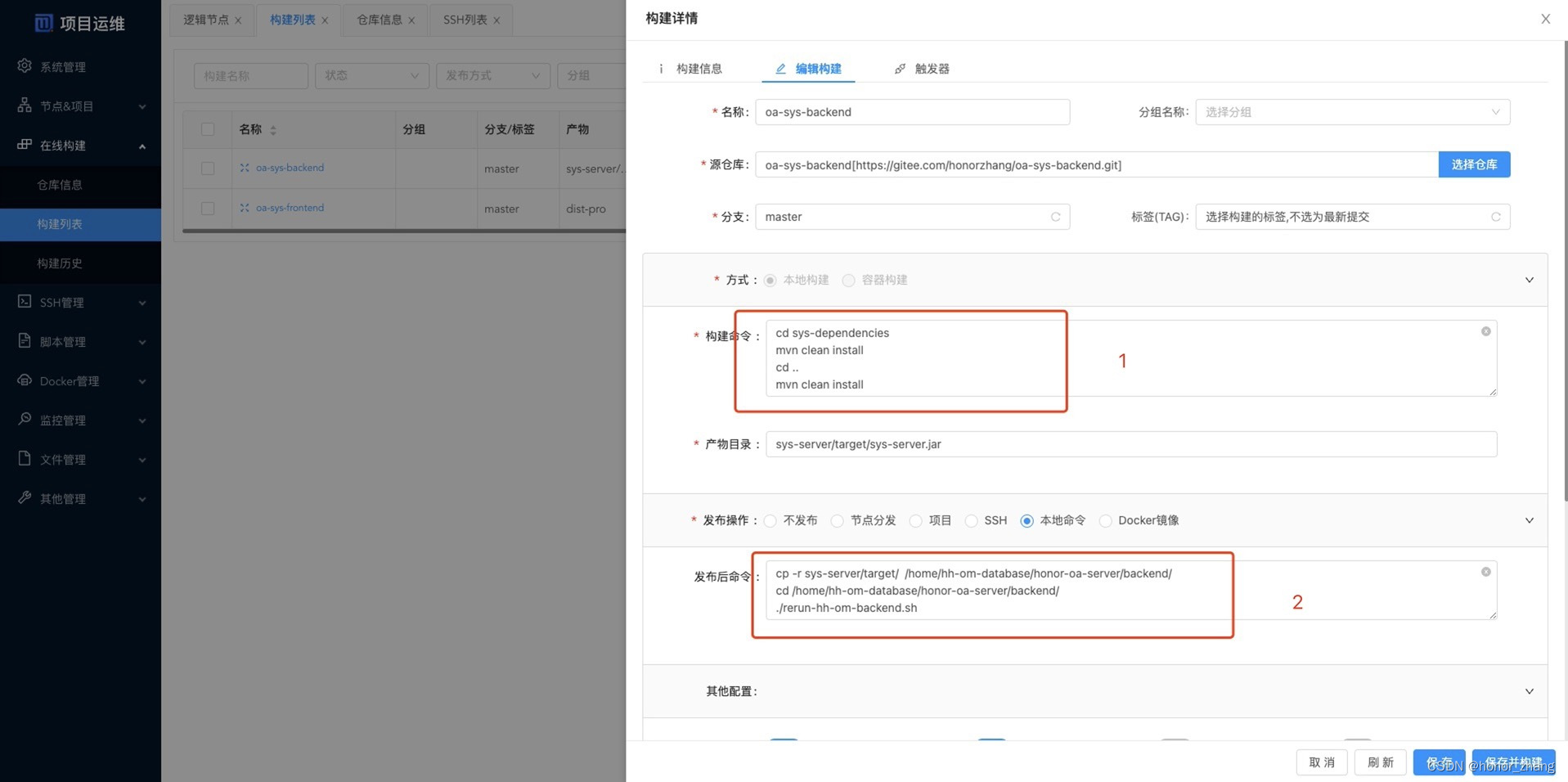

程序设计

- 完整程序和数据获取方式1:私信博主回复MATLAB实现BO-LSTM贝叶斯优化长短期神经网络多输入单输出回归预测;

- 完整程序和数据下载方式2(资源处直接下载):MATLAB实现BO-LSTM贝叶斯优化长短期神经网络多输入单输出回归预测。

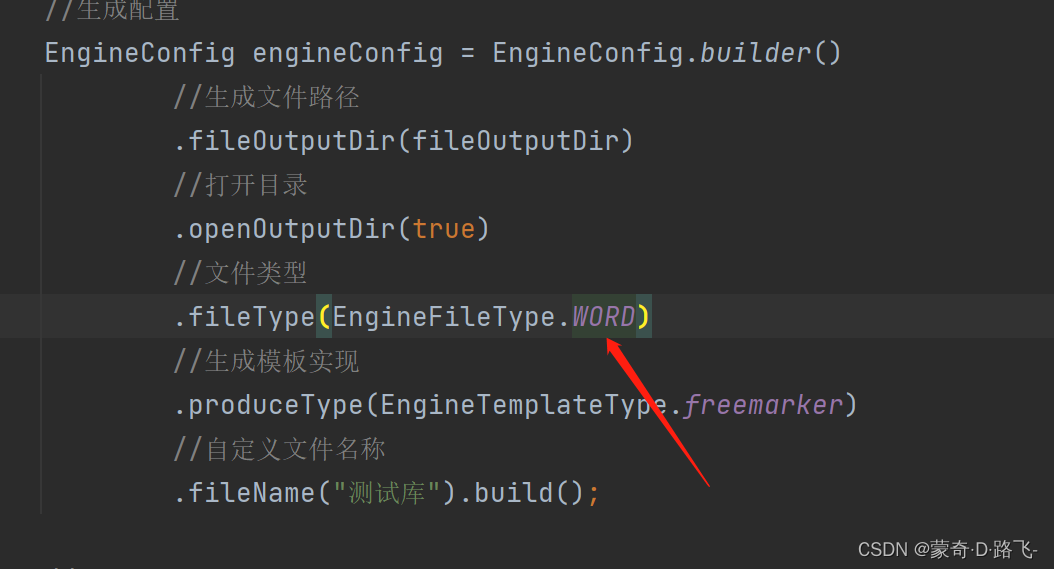

%% 优化算法参数设置

%参数取值上界(学习率,隐藏层节点,正则化系数)

%% 贝叶斯优化参数范围

optimVars = [

optimizableVariable('NumOfUnits', [10, 50], 'Type', 'integer')

optimizableVariable('InitialLearnRate', [1e-3, 1], 'Transform', 'log')

optimizableVariable('L2Regularization', [1e-10, 1e-2], 'Transform', 'log')];

%% 创建网络架构

% 输入特征维度

numFeatures = f_;

% 输出特征维度

numResponses = 1;

FiltZise = 10;

% 创建"LSTM"模型

layers = [...

% 输入特征

sequenceInputLayer([numFeatures 1 1],'Name','input')

sequenceFoldingLayer('Name','fold')

% 特征学习

dropoutLayer(0.25,'Name','drop3')

% 全连接层

fullyConnectedLayer(numResponses,'Name','fc')

regressionLayer('Name','output') ];

layers = layerGraph(layers);

layers = connectLayers(layers,'fold/miniBatchSize','unfold/miniBatchSize');

% 批处理样本

MiniBatchSize =128;

% 最大迭代次数

MaxEpochs = 500;

options = trainingOptions( 'adam', ...

'MaxEpochs',500, ...

'GradientThreshold',1, ...

'InitialLearnRate',optVars.InitialLearnRate, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropPeriod',400, ...

'LearnRateDropFactor',0.2, ...

'L2Regularization',optVars.L2Regularization,...

'Verbose',false, ...

'Plots','none');

%% 训练混合网络

net = trainNetwork(XrTrain,YrTrain,layers,options);

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129036772?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128690229