1. HashMap概述

-

定义:HashMap根据键的hash值来存储数据

-

底层:

- JDK1.7底层:数组+链表

- JDK1.8底层:数组+链表+红黑树

- 当链表长度达到8且数组长度长于64时,就会转换成红黑树(红黑树阈值)

- 如果数组长度小于64,就扩容数组

-

其他相关:

- HashMap中最多允许一个key为null,但可以多个value为null

- HashMap是线程不安全的

- 解决hash冲突的方式是链址法

- 数组:称为桶

- 链表:哈希值相同的数据组成一个单链表,单链表的头指针存放在哈希表中的第i个单元中

- 扩容数组:初始capacity数组容量为16,阈值threshold是12(阈值的计算方式为 capacity * loadFactor,在HashMap中loadFactory是0.75)

2. HashMap的发展历程

- 最开始是数组存储,但这样效率低

- 引入了hash值后又导致桶数组范围过大

- 因此又引入了定位取模操作,这样又导致hash碰撞

- 所以又引入了 二次哈希(扰动处理)以及链表和红黑树来解决这个问题。

- 结论:

数组 → hash值 → 定位取模 → 二次哈希、链表、红黑树

3. Hash值的运算和定位取模

- Hash值运算:先计算出Hash值

3.1 Hash值运算(HashMap.hash())

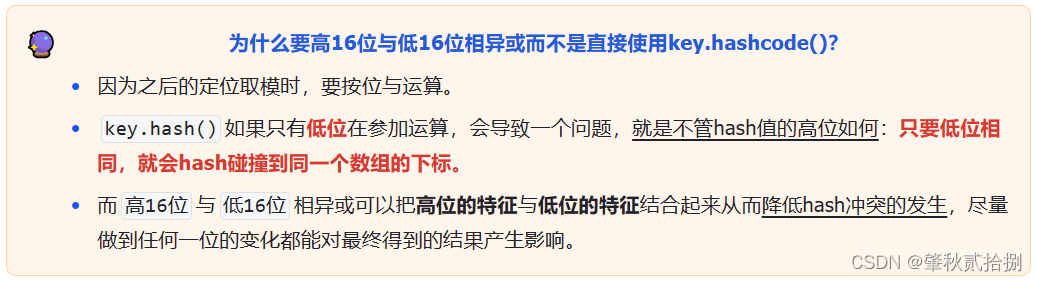

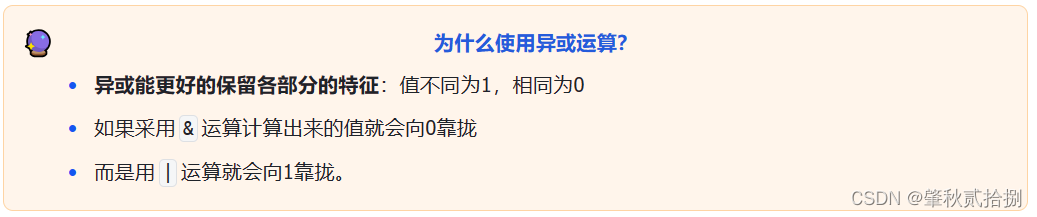

- 为了避免哈希碰撞,HashMap.hash()中有两次hash处理。

- 第一次hash就是直接key.hashcode方法

- 第二次hash不同版本JDK有区别:

- 在JDK1.7时,二次哈希是通过5次异或和4次位运算来实现的。

- 在JDK1.8中,是通过高16位与低16位相异或实现的。(^)

JDK1.8:该方法主要是将Object转换成一个整型。

static final int hash(Object key) {

int h;

//先将key转换成哈希值,然后进行1次位运算+1次异或运算进行了2次扰动处理尽量避免hash冲突。

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

index =(table.length - 1) & key.hash();

//回忆前文中的内容,table.length是一个2的正整数次幂,类似于000100000,

//这样的值减一就成了000011111,通过这样的位运算来快速寻址定址。

//计算出索引值index,如果index位置没有元素(没有哈希碰撞),直接在该索引插入数据

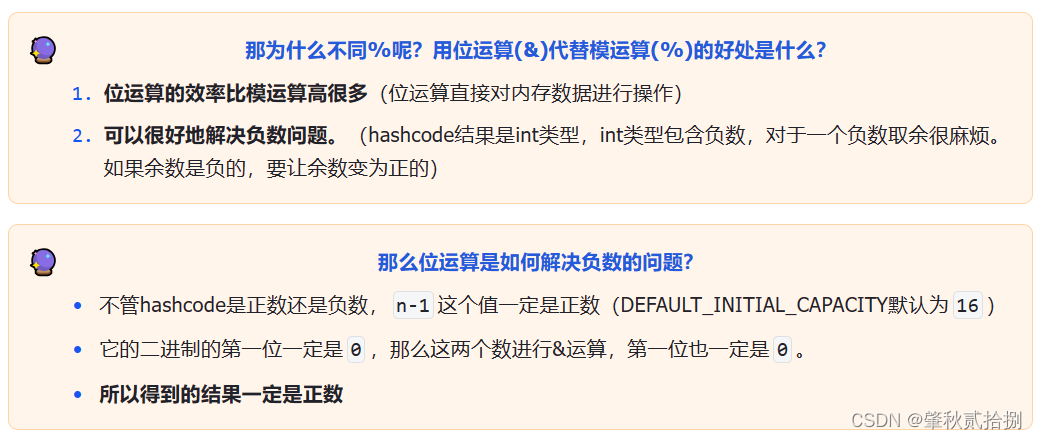

3.2 定位取模(按位与运算)

- 定位取模是通过hash值和数组长度-1 按位&运算得出的。得到该对象在数组中的下标(保存位)

- 目的:将哈希值映射到数组的一个下标,从而实现快速的查找和索引。

在HashMap中,默认创建的数组长度是16,存储的数据哈希值都会大于16。因此,通过取模或位运算可以将哈希值映射到0到15的这个范围内,这样就可以直接在数组中进行查找和索引,大大提高了查找速度。

- put和get的时候都会用到

key.hash() & (table.length-1)

- table.length是桶数组的长度,长度总是2的n次方

- 所以上面的方法就等价于对hash值对数组长度取模

hash值可能是负数

4. HashMap常用的方法

4.1 put()

//下标是hash()计算后的

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

//3.resize懒加载创建table数组

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

if ((p = tab[i = (n - 1) & hash]) == null) //3.通过扰动后的哈希值计算出对应在table中的索引

//4.如果索引处为空,则直接newNode()新建节点并覆盖原值。

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

if (p.hash == hash &&

//5.索引不为空

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

else if (p instanceof TreeNode)

//5.a.红黑树的节点

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

//5.b.链表的话就for遍历

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

- 流程:

- (Hash值运算)先高16位和低16位异或扰动出一个新的hash值:(key == null) ? 0 : (h = key.hashcode()) ^ (h >>> 16)

- 判断是否存在

table数组,没有的话通过resize懒加载创建扩容出table数组。 - (定位取模)通过扰动后的哈希值计算出对应在table中的索引:tab[i = (n - 1) & hash])

- 如果索引处为空,则直接newNode()新建节点并插入数据

- 如果索引不为空

1.如果tab[i]是红黑树的节点,那么就执行红黑树中添加节点的操作

2.如果是链表,则遍历。- 如果遍历到尾,则newNode创建节点放到链末尾。

- 如果链表长度大于等于8,就调用treeifyBin(tab, hash);:判断数组长度是否大于64( MIN_TREEIFY_CAPACITY),大于就会转换为树,小于64就扩容数组。

- 如果找到了hash和key都相同的节点,break。

- 如果key值相同,就覆盖原值(在一个链表中如果key值相同,首先它们Hash值相同,同时原数的key相同,那么基于HashMap的规则,会用新的Value覆盖原数)

- 最后比较size(当前数组已经有的链表条数)是否大于threshold阈值,大于则resize方法扩容。

- 细节:HashMap允许put key为null的键值对,这种键值对都放到了桶数组的第0个桶中。

- 源码中的Node<K,V>,K是个泛型。

4.2 get()

public V get(Object key) {

Node<K,V> e;

return (e = getNode(key)) == null ? null : e.value;

}

final Node<K,V> getNode(Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n, hash; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & (hash = hash(key))]) != null) {

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

return first;

if ((e = first.next) != null) {

if (first instanceof TreeNode)

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

- 流程:

- 还是通过(n - 1) & hash 算出在数组中的位置

- 看数组的索引处的链表或者树的头的key是不是我们要找到,是则直接返回

- 不是则遍历红黑树/遍历链表

4.3 resize()

- 使用场景:

- 初始化哈希表

- 当前数组容量过小,需要扩容

- 大致流程:

- 计算出扩容后数组的容量(capacity)和阈值(threshold)是否超过最大值,不超则变为原来的2倍,并创建新数组。

- 如果旧数组没有初始化,直接返回创建的新数组,其长度为16(DEFAULT_INITIAL_CAPACITY)、负载因子为0.75。

- 扩容流程:

- JDK1.7:没有红黑树,所以只存在链表扩容。(先遍历原HashMap,对每个元素重新计算索引,然后再放到对应链表的头部(等价于一次链表反转,先插入的会被放在链表的尾部))

- JDK1.8:首先遍历旧table数组

- 如果只是一个节点,不是链表不是树,则直接取模运算后放入到新数组中。(位运算 e.hash & (newCap-1))

- 如果是链表,由于扩容是直接乘以2。元素的位置要么低位在之前的位置,要么高位在之前的位置加上扩容大小的位置。(通过分出一个高低位来实现)

- 分位:通过hash值与原数组容量oldCap进行&运算,判断是否为0。将原链表分为高低两个链表,通过尾插法放入新数组对应的位置,链表整体顺序不变。

- 如果是红黑树。将其分为两棵树放在新数组上。

每次扩容的下标 e.hash & (newCap - 1),保证了下标范围不超过newCap。

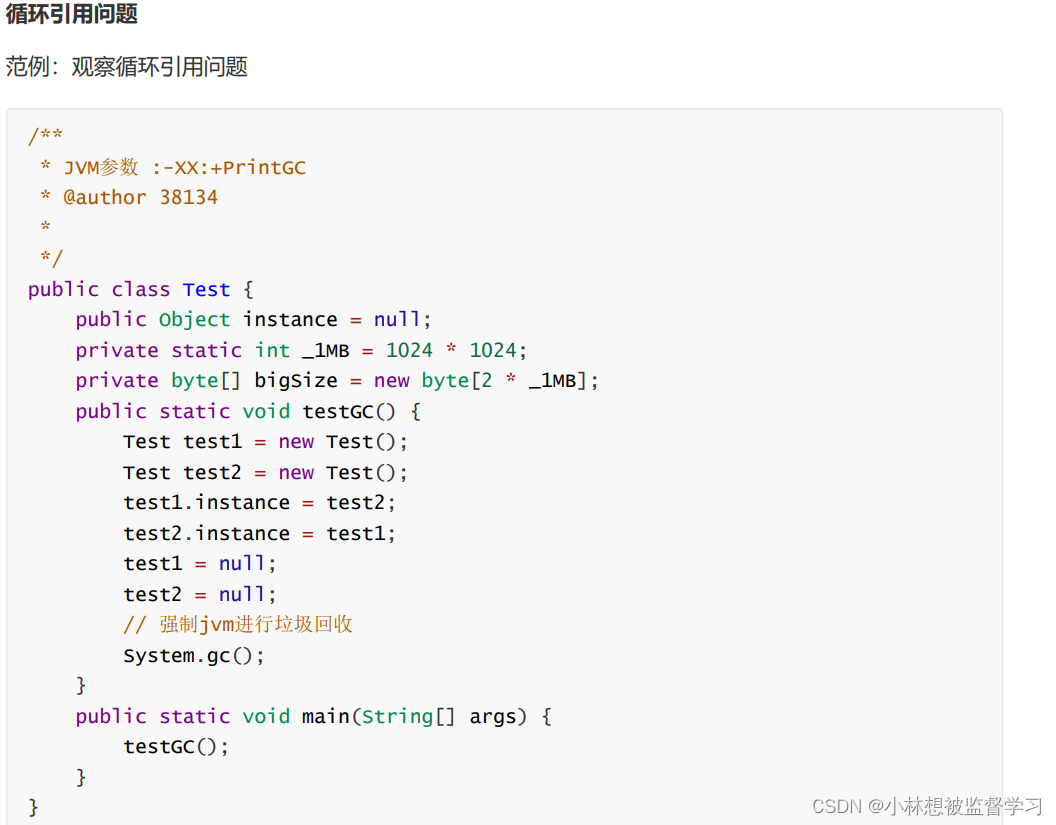

5. HashMap的线程安全

- HashMap如何实现线程安全

- 用HashTable

- 用同步包装器Collections的synchronizedMap方法使HashMap具有线程安全的能力

static Map<String, String> results = Collections.synchronizedMap(new HashMap<String, String>());

- 使用ConcurentHashMap

6. 相关问题

6.1 为什么哈希桶的长度总是2的n次方?

6.2 扩容的具体条件是什么?

6.3 树化的具体条件是什么?

6.4 HashMap在JDK1.7和JDK1.8的区别?

6.5 HashMap在1.7版本由于头插法而产生死循环的原因是什么?

//e代表当前遍历到的节点(也就是要插入的节点)

//1.保存原链表的下一个节点

//2.将要插入的节点指向新的链表头(头插法)

//3.更改新的链表的头部(新头部为我们插入的新结点)

//4.将之前保存的下一个节点给e

Entry<K,V> next = e.next;

e.next = newTable[i];

newTable[i] = e;

e = next;

6.6 HashMap的初始容量为什么是16?

6.7 HashMap的负载因子loadFactory为什么是0.75?(有关桶的阈值)

6.8 如何解决初始化时输入的值不是2的n次幂

6.9 桶中的元素链表何时转换为红黑树?什么时候转回?为什么要这么设计?

6.10 Java 8中为什么要引入红黑树,是为了解决什么场景的问题?

6.11 HashMap如何处理Key为null的键值对?

6.12 为什么HashMap中的String、Integer这样的包装类适合作为Key键?

6.13 为什么初始容量是16?

6.14 JDK1.8死循环

6.15 Hash冲突是什么?

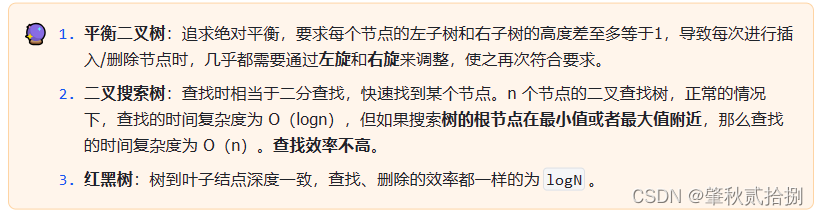

6.16 为什么用红黑树而不是二叉搜索树,平衡二叉树等?

6.17 为什么1.8HashMap是先插入后扩容?

6.18 既然红黑树的效率高,为什么一开始不使用红黑树?

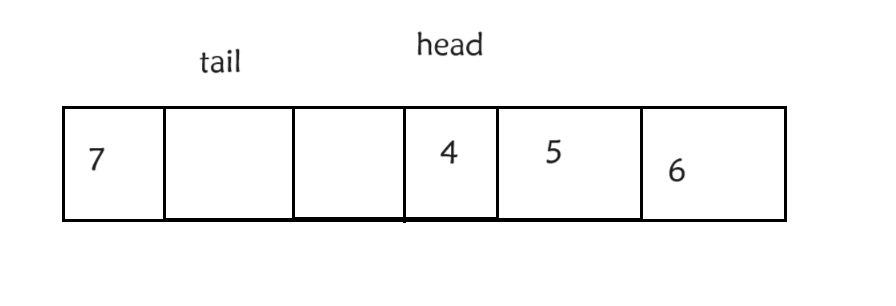

7. LinkedHashMap概述

- LinkedHashMap继承了HashMap,是基于数组和双向链表实现的。

- HashMap中的数据是无序的,也就是说访问的顺序不是存储的顺序。

- LinkedHashMap中的数据是有序的,并且我们可以自己决定使用哪种顺序

8. LinkedHashMap的原理

- 有序:LinkedHashMap可以实现有序,就是因为它的Node类中,比HashMap多了一个before和after引用,并且创建一个为null的Header(Node)作为遍历双向循环链表的入口。

- LinkedHashMap的头部:头部存的是最久前访问的节点或最先插入的节点。尾部存的是最近访问的和最近插入的节点。

- header的before和after指向双向链表的头部和尾部。

/**

* LinkedHashMap中的node直接继承自HashMap中的Node。并且增加了双向的指针

*/

static class Entry<K,V> extends HashMap.Node<K,V> {

Entry<K,V> before, after;

Entry(int hash, K key, V value, Node<K,V> next) {

super(hash, key, value, next);

}

}

9. put

- LinkedHashMap没有重写HashMap的put()方法,而是重写了put()方法需要调用的内部方法newNode()。

newNode:在定位取模后对应的索引处为空时,会创建结点,并覆盖原值- 插入顺序和访问顺序都是 简单的插入到集合队尾中。

HashMap.Node<K,V> newNode(int hash, K key, V value, HashMap.Node<K,V> e) {

LinkedHashMap.Entry<K,V> p =

new LinkedHashMap.Entry<>(hash, key, value, e);

linkNodeLast(p);

return p;

}

private void linkNodeLast(LinkedHashMap.Entry<K,V> p) {

LinkedHashMap.Entry<K,V> last = tail;

tail = p;

if (last == null)

head = p; //只有一个节点?

else {

p.before = last; //last是尾前一个节点

last.after = p;

}

}

10. get

- 插入顺序:直接取出

- 访问顺序:先取出,之后还要调用aferNodeAccess()方法把元素从原链表移除并放到队尾。

// LinkedHashMap 中覆写

public V get(Object key) {

Node<K,V> e;

if ((e = getNode(hash(key), key)) == null)

return null;

// 如果 accessOrder 为 true,则调用 afterNodeAccess 将被访问节点移动到链表最后

if (accessOrder)

//把元素从原链表移除并放到队尾。

afterNodeAccess(e);

return e.value;

}

// LinkedHashMap 中覆写

void afterNodeAccess(Node<K,V> e) { // move node to last

LinkedHashMap.Entry<K,V> last;

if (accessOrder && (last = tail) != e) {//accessOrder为true代表访问顺序

LinkedHashMap.Entry<K,V> p =

(LinkedHashMap.Entry<K,V>)e, b = p.before, a = p.after;

p.after = null;

// 如果 b 为 null,表明 p 为头节点

if (b == null)

head = a;

else

b.after = a;

if (a != null)

a.before = b;

/*

* 这里存疑,父条件分支已经确保节点 e 不会是尾节点,

* 那么 e.after 必然不会为 null,不知道 else 分支有什么作用

*/

else

last = b;

if (last == null)

head = p;

else {

// 将 p 接在链表的最后

p.before = last;

last.after = p;

}

tail = p;

++modCount;

}

}

11. 相关问题

11.1 LinkedHashMap为什么使用双向链表,而不是单链表

11.2 LinkedHashMap如何保证访问顺序?

插入顺序都是直接put和get,访问顺序的话put也是直接,但是在get方法后,因为变成最近刚访问,所以还要移动到双向链表的尾部。

void afterNodeAccess(Node<K,V> p) { }

void afterNodeInsertion(boolean evict) { }

void afterNodeRemoval(Node<K,V> p) { }

afterNodeAccess:在putVal和get中调用,根据accessOrder判断是否需要调整链表顺序,将被操作的元素维护到LinkedHashMap的尾部。afterNodeInsertion:移出最老插入的节点,在putVal中使用,可以用来写出一个LRU。(重写removeEldestEntry())- LRU:它的核心思想是当缓存满时,会优先淘汰那些近期最少使用的缓存对象。

- removeEldestEntry()默认返回false,所以正常情况下不会溢出最老插入的节点(LRU下重写该方法)

void afterNodeInsertion(boolean evict) { // possibly remove eldest

LinkedHashMap.Entry<K,V> first;

//removeEldestEntry(first)默认返回false,所以afterNodeInsertion这个方法其实并不会执行

if (evict && (first = head) != null && removeEldestEntry(first)) {

K key = first.key;

removeNode(hash(key), key, null, false, true);

}

}

protected boolean removeEldestEntry(Map.Entry<K,V> eldest) {

return false;

}

afterNodeRemoval:在remove()的removeNode()中调用,作用是删除一个节点,也在双向链表中删掉这个节点的after和before指针,并把这个节点的前驱结点和后继节点连接起来。

11.3 put时调用的afterNodeAccess方法,调用的会是子类的afterNodeAccess方法吗?

map.put(key,value)->HashMap#putVal(key,value)->afterNodeAccess

11.4 为什么LinkedHashMap能实现LRU缓存,把最不经常访问的那个元素淘汰。

- put()方法中有一个afterNodeInsertion方法,会判断第一个元素是否超出了可容纳的最大范围,如果超出了,接会调用removeNode方法删除最不经常访问的那个元素。

- 前提要重写removeEldestEntry()

void afterNodeInsertion(boolean evict) { // possibly remove eldest

LinkedHashMap.Entry<K,V> first;

if (evict && (first = head) != null && removeEldestEntry(first)) {

K key = first.key;

removeNode(hash(key), key, null, false, true);

}

}

12. LinkedHashMap实现LRU

- 重写

LinkedHashMap,传入true表示访问顺序,重写方法

public class LRUCache extends LinkedHashMap<Integer , Integer> {

private int capacity;

public LRUCache(int capacity){

//当accessOrder的参数为true时,就会按照访问顺序排序

super(capacity , 0.75F , true);

this.capacity = capacity;

}

public int get(int key){

return super.getOrDefault(key , -1);

}

public void put(int key , int value){

super.put(key , value);

}

//重写当前方法,当内存超出的时候返回true

@Override

protected boolean removeEldestEntry(Map.Entry<Integer, Integer> eldest) {

return size() > capacity;

}

}

- 内部封装

LinkedHashMap

//2,使用LinkedHashMap的方式

//添加顺序

public class LRUTest{

int capacity;

LinkedHashMap<Integer, Integer> cache;

LRUTest(int capacity){

cache = new LinkedHashMap<>();

this.capacity = capacity;

}

//访问元素

public int get(int key){

if(!cache.containsKey(key)){

return -1;

}

//存在,先从链表头部删除删除,在插入到链表尾部

int val = cache.get(key);

cache.remove(key);

cache.put(key, val);

return val;

}

//添加元素

public void put(int key, int val){

if(cache.containsKey(key)){

cache.remove(key);

}

//如果链表已经满了,则删除头部节点

if(cache.size() == capacity){

Set<Integer> keySet = cache.keySet();

Iterator<Integer> iterator = keySet.iterator();

cache.remove(iterator.next());

}

cache.put(key, val);

}

}

public LinkedHashMap() {

super();

accessOrder = false;

}

public LinkedHashMap(int initialCapacity) {

super(initialCapacity);

accessOrder = false;

}

public LinkedHashMap(int initialCapacity, float loadFactor) {

super(initialCapacity, loadFactor);

accessOrder = false;

}

public LinkedHashMap(int initialCapacity,float loadFactor,boolean accessOrder) {

super(initialCapacity, loadFactor);

this.accessOrder = accessOrder;

}

public LinkedHashMap(Map<? extends K, ? extends V> m) {

super();

accessOrder = false;

putMapEntries(m, false);

}