提示:免费获取本文涉及的完整代码与数据集,请联系助理老师peaeci122

使用最新“KerasCV YOLOv8”模型进行红绿灯检测的综合指南

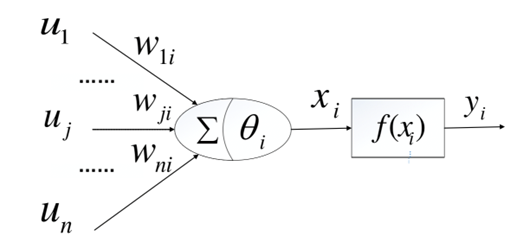

YOLO目标检测模型已经进入了无数的应用领域,从监控系统到自动驾驶汽车。那么,如果在KerasCV框架下配对YOLOv8的这种功能时会发生什么呢?

【接上一篇】

目录

· 红绿灯检测数据集

· 使用 KerasCV YOLOv8 进行物体检测

· 验证图像的推理

· 使用经过训练的 KerasCV YOLOv8 模型进行视频推理

· 总结与结论

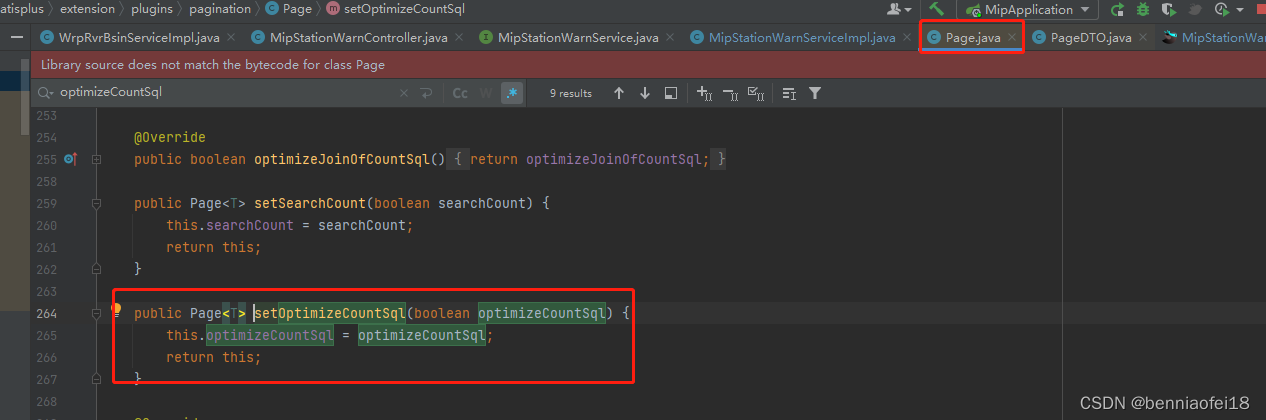

KerasCV YOLOv8模型

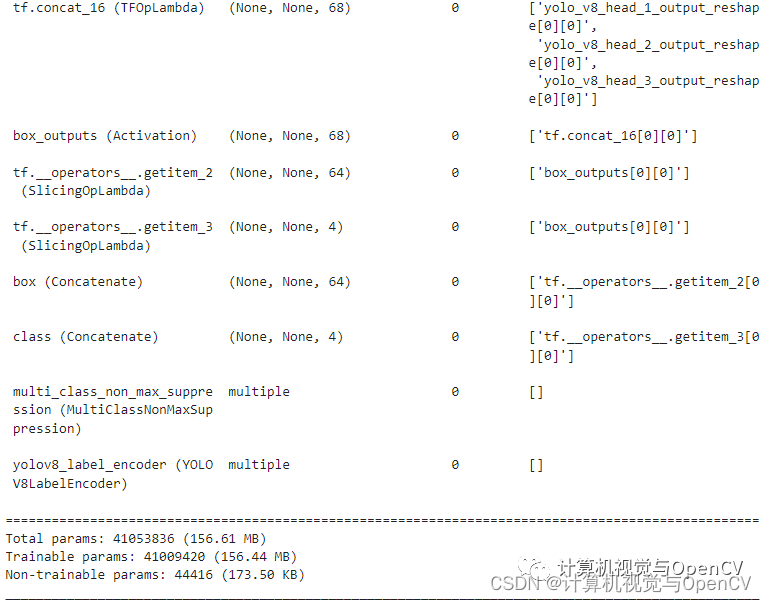

使用 COCO 预训练主干创建 KerasCV YOLOv8 模型,主干是YOLOv8 Large,整个预训练模型中,先用 COCO 预训练权重加载主干网,然后使用随机初始化的头部权重创建整个 YOLOv8 模型。

backbone = keras_cv.models.YOLOV8Backbone.from_preset(

"yolo_v8_l_backbone_coco",

load_weights=True

)

yolo = keras_cv.models.YOLOV8Detector(

num_classes=len(class_mapping),

bounding_box_format="xyxy",

backbone=backbone,

fpn_depth=3,

)

yolo.summary()

设置 load_weights = True 很重要,否则 COCO 预训练的权重将无法加载到主干网中。

由于数据集注释文件是 XML 格式,所有的边界框都是 XYXY 格式,因此上述代码块中的 bounding_box_format 为 “xyxy”。此外,根据 KerasCV YOLOv8 官方文档,fpn_depth 为 3。

下一步:定义优化器并编译模型

optimizer = tf.keras.optimizers.Adam(

learning_rate=LEARNING_RATE,

global_clipnorm=GLOBAL_CLIPNORM,

)

yolo.compile(

optimizer=optimizer, classification_loss=“binary_crossentropy”, box_loss=“ciou”

)

学习率按照之前的定义进行设置,梯度剪切则使用 global_clipnorm 参数,这确保了影响模型参数更新的梯度不会变得太大而破坏训练的稳定性。

优化器准备就绪后,继续编译 YOLOv8 模型,这样模型就可以使用下面定义的损失函数进行训练了:

· Classification_loss:选择“binary_crossentropy”作为分类损失;

· box_loss:“ciou”或“Complete Intersection over Union”是一种先进的边界框损失函数,它可以解释预测框和真实框之间的大小和形状差异。

最终建立的模型包含 4100 万个参数,下面是模型摘要的片段,以及可训练参数的数量。

评估指标

我们选择平均值 (mAP) 作为评估指标,KerasCV 已经为他所有目标检测模型提供了 mAP 的优化实现。

class EvaluateCOCOMetricsCallback(keras.callbacks.Callback):

def __init__(self, data, save_path):

super().__init__()

self.data = data

self.metrics = keras_cv.metrics.BoxCOCOMetrics(

bounding_box_format="xyxy",

evaluate_freq=1e9,

)

self.save_path = save_path

self.best_map = -1.0

def on_epoch_end(self, epoch, logs):

self.metrics.reset_state()

for batch in self.data:

images, y_true = batch[0], batch[1]

y_pred = self.model.predict(images, verbose=0)

self.metrics.update_state(y_true, y_pred)

metrics = self.metrics.result(force=True)

logs.update(metrics)

current_map = metrics["MaP"]

if current_map > self.best_map:

self.best_map = current_map

self.model.save(self.save_path) # Save the model when mAP improves

return logs

使用自定义 Keras 回调来定义 EvaluateCOCOMetricsCallback,在每次验证循环后执行,如果当前的 mAP 大于之前的最佳 mAP,那么模型权重将被保存到磁盘中。

Tensorboard回调日志

我们还要定义一个 Tensorboard 回调,用于自动记录所有 mAP 和损失图。

tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir="logs_yolov8large")

所有 Tensorboard 日志都将存储在 logs_yolov8large 目录中。

对KerasCV YOLO8模型进行红绿灯检测的训练

现在可以开始训练过程了,所有组件都已准备就绪,只需调用 yolo.fit() 方法就可以开始训练。

history = yolo.fit(

train_ds,

validation_data=val_ds,

epochs=EPOCH,

callbacks=[

EvaluateCOCOMetricsCallback(val_ds, "model_yolov8large.h5"),

tensorboard_callback

],

)

train_ds 和 val_ds 分别用作训练数据集和验证数据集,而且我们还提供了上一节中定义的回调,mAP 和 loss 的值将存储在历史变量中。由于所有数据都会记录到 Tensorboard 中,所以并不需要这些数据。

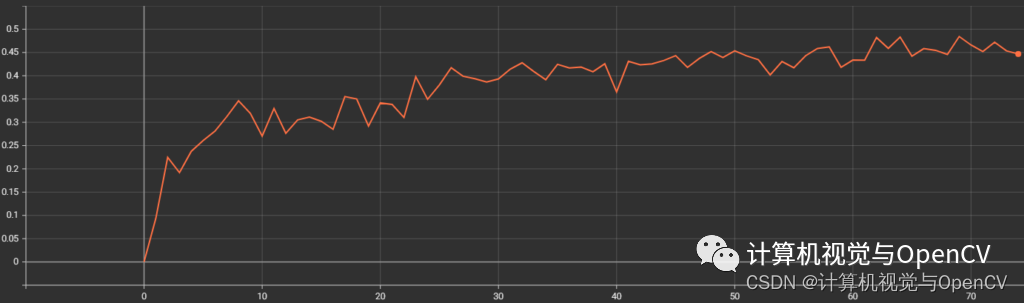

YOLOv8 模型的最佳 mAP 超过 48%,这也是保存最佳模型权重的地方。

验证图像的推理

由于我们现在已经有了训练好的模型,因此可以用它来对验证集的图像进行推理。

def visualize_detections(model, dataset, bounding_box_format):

for i in range(10):

images, y_true = next(iter(dataset.take(i+1)))

y_pred = model.predict(images)

y_pred = bounding_box.to_ragged(y_pred)

visualization.plot_bounding_box_gallery(

images,

value_range=(0, 255),

bounding_box_format=bounding_box_format,

# y_true=y_true,

y_pred=y_pred,

scale=4,

rows=2,

cols=2,

show=True,

font_scale=0.7,

class_mapping=class_mapping,

)

visualize_detections(yolo, dataset=val_ds, bounding_box_format="xyxy")

上述函数对数据循环 10 次进行推理,每次推理后,会使用 KerasCV 内置的 plot_bounding_box_gallery 函数绘制结果。

下图显示了一些预测正确的结果

模型对所有红绿灯的预测都是正确的。

尽管模型准确度非常高了,但还不够完美,以下是一些预测结果不正确的图片。

上图显示了一个图像实例,模型将建筑物的窗户预测为红绿灯,在另一个例子中,它缺少对绿色和红色红绿灯的预测。

为了缓解上述情况,除了水平翻转之外,还可以对图像进行更多增强。KerasCV 有许多增强功能,可用于减少过度拟合并提高不同情况下的准确性。

使用模型进行视频推理

使用经过训练的 KerasCV YOLOv8 模型进行视频推理,在可下载内容中找到视频推理脚本,并在自己的视频上运行推理,下面是运行视频推理的示例命令。

python infer_video.py --input inference_data/video.mov

输入(–input)标记会获取运行推理的视频文件的路径,下面是一个视频推理实验的输出示例。

结果看起来不错,几乎在所有帧中,模型都能正确检测到红绿灯,当然也有一点闪烁,但很有可能在经过更多的训练和增强后就会消失。

使用训练有素的 KerasCV YOLOv8 模型进行红绿灯

总结与结论

本文到此结束,从 KerasCV 的初始设置开始,然后进入红绿灯检测数据集,详细介绍了 YOLOv8 检测模型的准备工作,随后进行了训练和验证。