近先进的无监督学习方法使用类似连体的框架来比较来自同一图像的两个“视图”以进行学习表示。使这两种观点与众不同的是保证无监督方法可以学习有意义信息核心。但是,如果用于生成两个视图的增强不够强,则此类框架有时会在过度拟合方面变得脆弱,从而导致训练数据出现过度自信的问题。这个缺点阻碍了模型学习细微的方差和细粒度的信息。

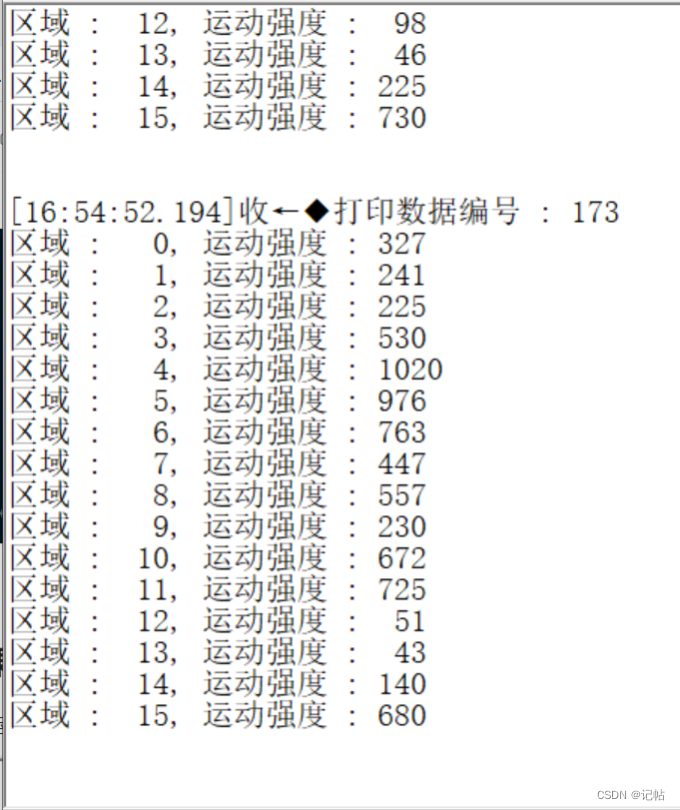

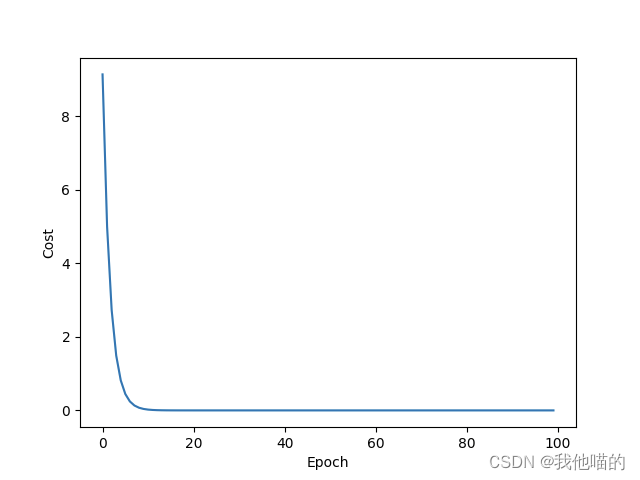

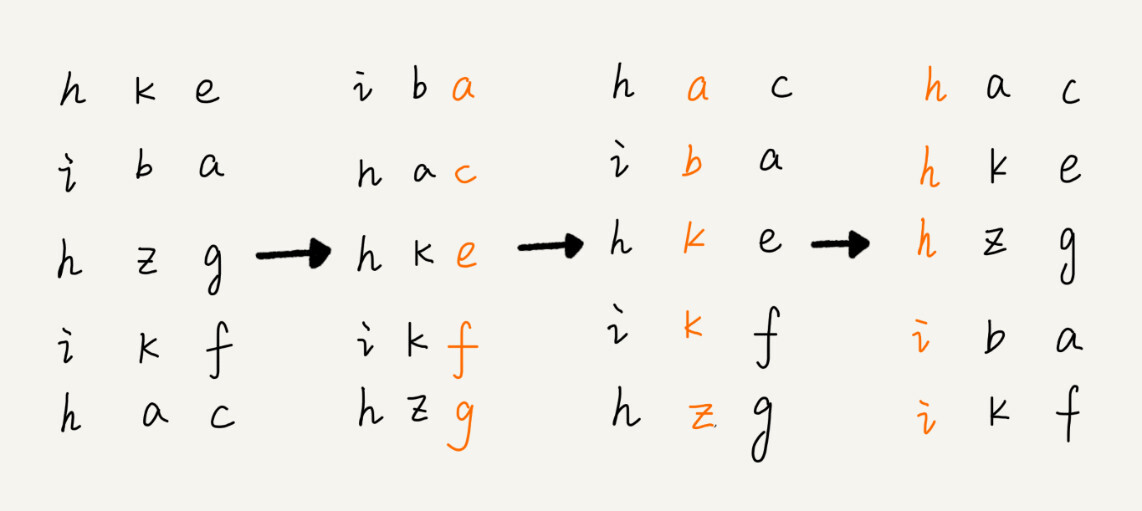

为了解决这个问题,本工作探究了在自监督学习常用的双子结构网络中,通过在输入空间做图像融合来学习更加细粒度的特征表示。文章的核心内容讨论了如何来设计数据采样,融合策略和构建对应的损失函数,从而去匹配图像融合之后新的输入空间。具体而言,本文通过在对比学习模型的单个分支上做图像融合,使得最后两个分支的距离度量变为一个0~1之间的软化系数的倍数,从而使两个分支之间的距离变得更加细微和敏感(该工作首次在自监督双子模型中引入了软距离的概念),进而让模型学习到更加细粒度的输入信息的隐空间表达。

论文名称:

Un-Mix: Rethinking Image Mixtures for Unsupervised Visual Representation Learning

论文链接:

https://arxiv.org/abs/2003.05438

https://arxiv.org/pdf/2003.05438.pdf;

code :

本次分享的具体内容有:

1. 研究背景和动机

1.1

1.2

1.3

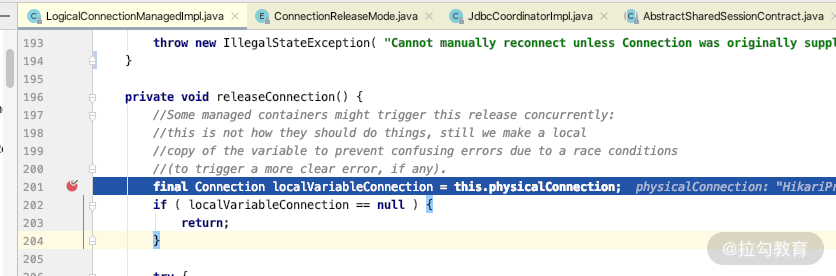

2. 研究方法介绍

2.1

2.2

2.3

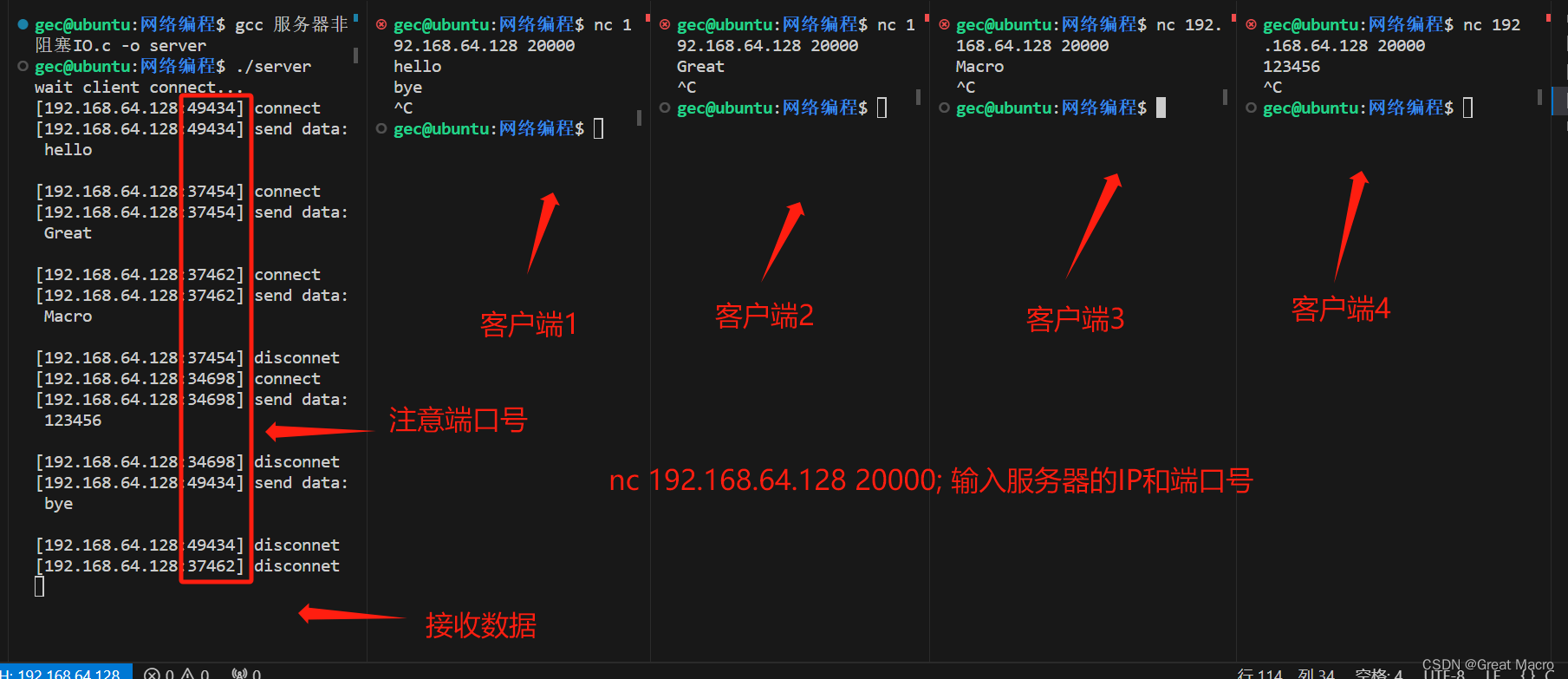

3. 结果分析和代码实现

https://github.com/szq0214/Un-Mix

理论及可视化分析

3.1

3.2

3.3

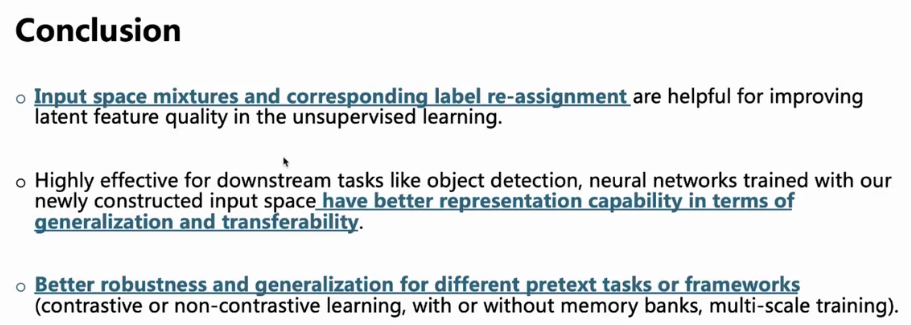

结论