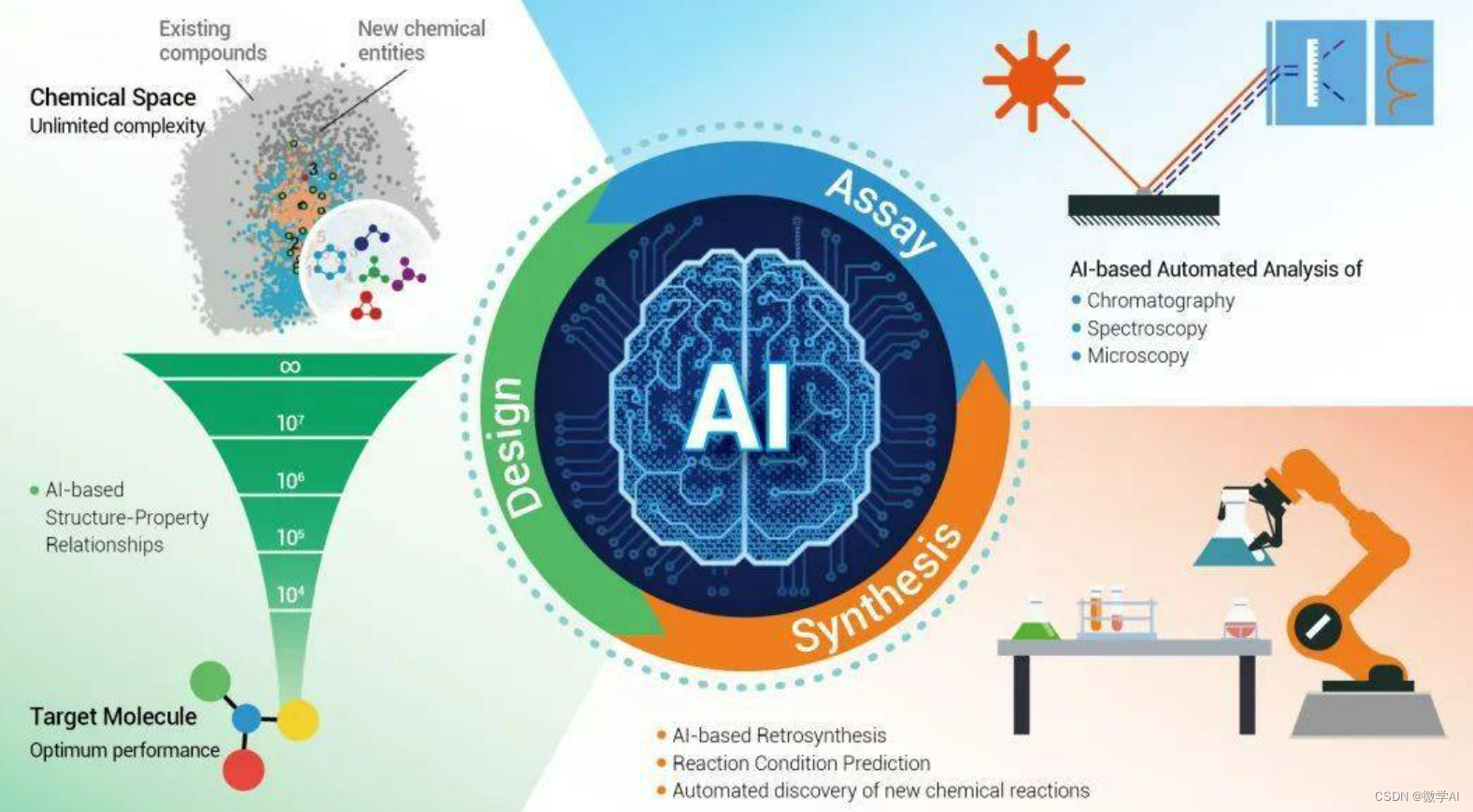

大家好,我是微学AI ,今天给大家介绍一下人工智能在教育上的应用2-基于大模型的未来数学教育的情况与实际应用,随着人工智能(AI)和深度学习技术的发展,大模型已经开始渗透到各个领域,包括数学教育。本文将详细介绍基于大模型在数学教育中的实际应用,随着AI技术的不断发展和进步,我们已经看到AI可以在诸如图像识别、自然语言处理等多个领域内提供强大的支持。其中一个最具潜力和前景广阔的领域就是教育。特别是,在复杂且抽象性高的数学教育领域,AI技术尤其显示出其独特优势。

一、背景

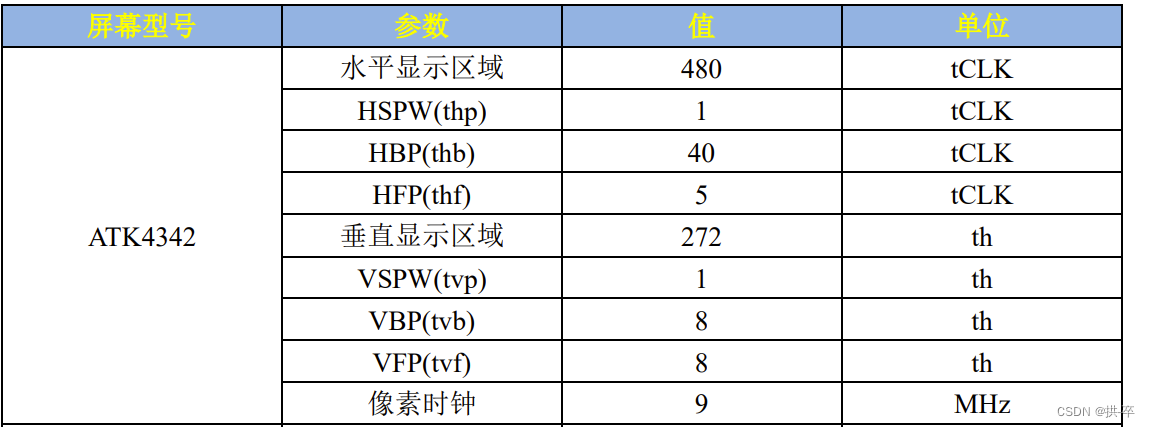

传统上,数学被认为是一门需要通过刻苦钻研和长时间实践才能掌握好的科目。然而,在过去几年里,我们已经看到了AI如何改变这种现状。基于大模型如ChatGPT,ChatGLM2,LLaMA,百川,通义千问等在数学教育上得以应用,并且取得了显著成效。

二、原理与方法

1. 人工智能数学原理

利用深度神经网络进行机器学习主要涉及以下几个核心概念:

1.向量空间:

对于任何输入(例如文本),机器都会将其转化为高维向量空间中的一个点。在数学上,我们可以将向量空间定义为一组具有加法和标量乘法两种运算的对象集合。这个定义可以表示为:

设 V V V是一个非空集合,如果对于所有 x , y ∈ V x, y \in V x,y∈V和所有标量 c ∈ R c \in \mathbb{R} c∈R或 C \mathbb{C} C,下列公理成立:

- x + y = y + x x + y = y + x x+y=y+x (交换律)

- ( x + y ) + z = x + ( y + z ) (x + y) + z = x + (y + z) (x+y)+z=x+(y+z) (结合律)

- 存在元素 0 ∈ V 0 \in V 0∈V使得 x + 0 = x x+0=x x+0=x

- 对每个 x ∈ V x\in V x∈V, 存在元素 − x ∈ V -x\in V −x∈V, 使得 x + ( − x ) = 0 x+(-x)=0 x+(−x)=0

- c ( x + y ) = c x + c y c(x+y)=cx+cy c(x+y)=cx+cy

- ( c + d ) x = c x + d x (c+d)x=cx+dx (c+d)x=cx+dx

- ( c d ) x = c ( d x ) (cd)x=c(dx) (cd)x=c(dx)

- 1 ∗ x = x 1*x=x 1∗x=x

则称 ( V , + , . ) (V,+,.) (V,+,.)是一个向量空间。

2.激活函数:

每一个神经元都有一个激活函数来决定它是否被“激活”。常见的激活函数有ReLU, Sigmoid, Tanh等。下面是这些函数的数学形式:

ReLU:

f

(

x

)

=

m

a

x

(

0

,

x

)

f(x) = max(0,x)

f(x)=max(0,x)

Sigmoid:

f

(

x

)

=

1

1

+

e

−

x

f(x) = \frac{1}{1+e^{-x}}

f(x)=1+e−x1

Tanh:

f

(

x

)

=

t

a

n

h

(

x

)

=

e

x

−

e

−

x

e

x

+

e

−

x

f(x) = tanh(x) = \frac{e^{x} - e^{-x}}{e^{x} + e^{-x}}

f(x)=tanh(x)=ex+e−xex−e−x

3.损失函数

损失函数衡量预测值与真实值之间的差异。例如均方误差(Mean Squared Error),交叉熵(Cross Entropy),Hinge Loss等。

均方误差(MSE):

L

(

y

,

y

^

)

=

1

n

∑

i

=

1

n

(

y

i

−

y

i

^

)

2

L(y,\hat{y})=\frac{1}{n}\sum_{i=1}^n(y_i-\hat{y_i})^2

L(y,y^)=n1i=1∑n(yi−yi^)2

交叉熵(Cross Entropy):

对于二分类问题:

L

(

y

,

y

^

)

=

−

[

y

l

o

g

(

y

^

)

+

(

1

−

y

)

l

o

g

(

1

−

y

^

)

]

L(y,\hat{y})=-[ylog(\hat{y})+(1-y)log(1-\hat{y})]

L(y,y^)=−[ylog(y^)+(1−y)log(1−y^)]

多分类问题:

L

(

y

,

y

^

)

=

−

∑

i

=

1

n

y

i

l

o

g

(

y

i

^

)

L(y,\hat{y})=-\sum_{i=1}^ny_ilog(\hat{y_i})

L(y,y^)=−i=1∑nyilog(yi^)

4.反向传播算法:

反向传播算法用于计算神经网络中权重的梯度。在一个多层神经网络中,对于每一层 l l l和每个神经元 j j j,我们都可以计算出一个“误差项” δ j ( l ) \delta^{(l)}_j δj(l)来表示该神经元对最终输出误差的贡献程度。具体来说,我们有:

δ j ( L ) = ∂ ∂ z j ( L ) 1 2 ∣ ∣ y − h W , b ( x ) ∣ ∣ 2 = − ( y j − a j ( L ) ) ⋅ f ′ ( z j ( L ) ) \delta^{(L)}_j = \frac{\partial}{\partial z^{(L)}_j} \frac{1}{2} ||y - h_{W,b}(x)||^2 = -(y_j - a^{(L)}_j) \cdot f'(z^{(L)}_j) δj(L)=∂zj(L)∂21∣∣y−hW,b(x)∣∣2=−(yj−aj(L))⋅f′(zj(L))

其中 L L L是网络的输出层, h W , b ( x ) h_{W,b}(x) hW,b(x)是网络关于输入 x x x的输出,而 f ′ f' f′是激活函数的导数。然后我们再通过以下公式反向传播这些误差项:

δ i ( l ) = ( ∑ j = 1 s l + 1 W j i ( l + 1 ) δ j ( l + 1 ) ) f ′ ( z i ( l ) ) \delta^{(l)}_i = (\sum_{j=1}^{s_{l+1}} W_{ji}^{(l+1)} \delta_j^{(l+1)}) f'(z_i^{(l)}) δi(l)=(j=1∑sl+1Wji(l+1)δj(l+1))f′(zi(l))

其中 s l s_l sl表示第 l l l层的单元数(不包括偏置单元),并且这个等式必须对所有 l < L , i ∈ 1 , . . . , s l l< L, i \in { 1, ..., s_l } l<L,i∈1,...,sl成立。

最后,使用这些误差项计算权重和偏置项梯度:

∇ W j k J ( W , b ; x , y ) = a k l δ j ( l + 1 ) \nabla_{W_jk} J(W,b;x,y) = a_k^l \delta_j ^{(l+1)} ∇WjkJ(W,b;x,y)=aklδj(l+1)

∇ b i l J ( W , b ; x , y ) = δ i ( l ) \nabla_{b_i^l} J(W,b;x,y) = \delta_i ^{(l)} ∇bilJ(W,b;x,y)=δi(l)

在得到所有样本上损失函数关于权重和偏置的梯度之后,我们就可以用随机梯度下降(或其他优化算法)来更新权重和偏置了。

2. 模型训练框架

我们使用PyTorch框架来训练模型。这是一种基于Python的开源机器学习库,可以提供强大的GPU加速计算能力。

import torch

import torch.nn as nn

from torch.utils.data import DataLoader, Dataset

from transformers import AutoModel, AutoTokenizer

import gradio as gr

import mdtex2html

import torch

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm2-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm2-6b", trust_remote_code=True).half().cuda()

model = model.eval()

class MathDataset(Dataset):

def __init__(self, csv_file):

self.data = pd.read_csv(csv_file)

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

question = self.data.iloc[idx, 0]

answer = self.data.iloc[idx, 1]

return question, answer

dataset = MathDataset('sample_data.csv')

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

num_epochs =5

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(num_epochs):

for i, (questions, answers) in enumerate(dataloader):

output = model(questions)

loss = criterion(output.view(-1), answers.view(-1))

optimizer.zero_grad()

loss.backward()

optimizer.step()

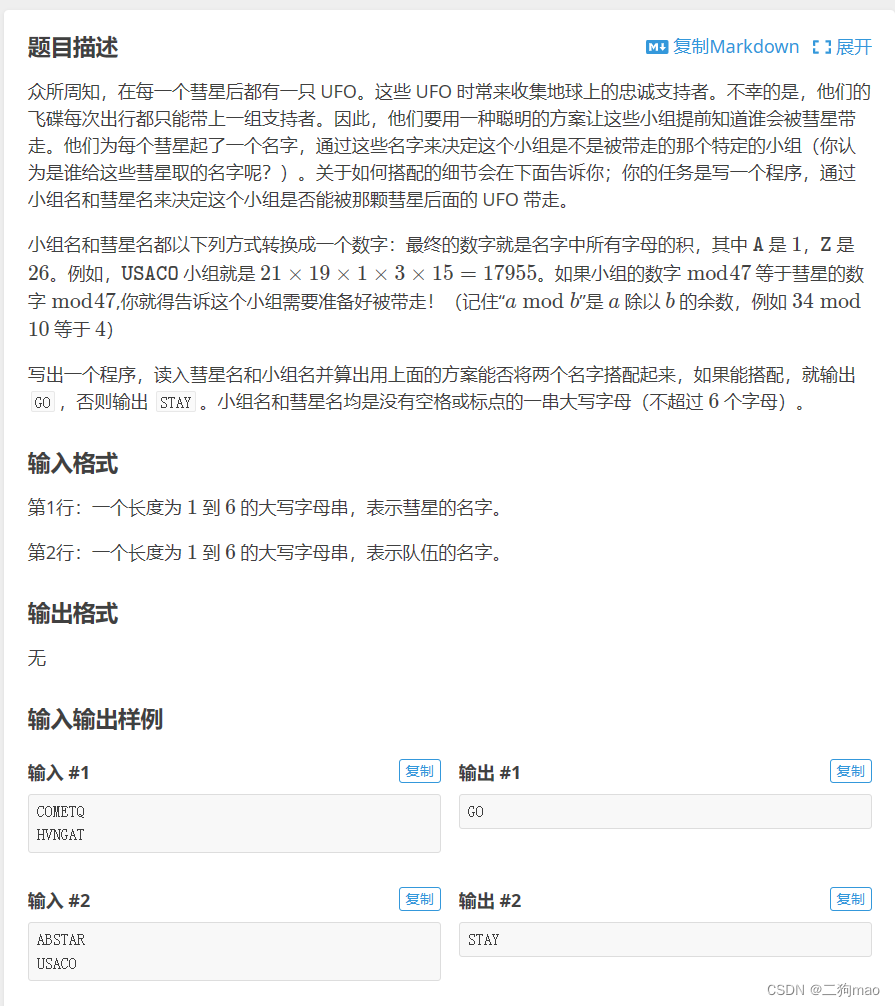

三、创新点

基于大模型在数学教育上的应用系统主要体现以下五个创新点:

1.个性化教学:每位学生的理解能力、进度和偏好都是独特的。传统的课堂教育模式往往难以满足每个人的需求。然而,利用AI技术,我们可以为每位学生提供定制化的数学教程。例如,对于那些在几何方面表现出色但在代数方面有困难的学生,系统可以调整其课程内容,以强化他们在代数方面的理解和技能。

2.自适应反馈:传统上,老师需要花费大量时间批改作业并提供反馈。然而,在AI驱动下,我们可以根据每位学生答题情况实时调整题目难易程度和内容,并立即提供反馈。例如,如果一个学生连续回答正确几道高级微积分问题,则系统可能会推送更具挑战性的问题;相反地,如果他们在某一主题上表现得不够好,则系统可能会降低问题难度并给出更详细地步骤说明。

3.实时互动:与传统课堂教育相比,在线AI教师可以24小时全天候在线回答问题,并给出即时反馈。例如,在处理复杂数字计算或者解决复杂几何证明过程中遇到困惑时, 学生可以立即向AI询问并获取解答, 而无需等待下一次课程或寻找额外辅导。

4.无限扩展性:随着越来越多数据被输入到系统中, AI模型将会不断地进行自我更新和优化, 从而使得其理解深度和广度都得到增强。这意味着无论是初级算术还是高级微积分知识点, AI都能提供支持.

5.普适性:无论是在城市还是偏远地区, 只要有网络连接就可享受到这种服务。这对于那些因为各种原因(如地理位置、经济条件等)无法获得高质量教育的人来说,尤其重要。例如, 在偏远地区的学生也能通过这种方式接触到优秀的教学资源,从而提升他们的数学能力。

以上创新点将大模型应用于数学教育,使得个性化和高效的教育成为可能,并有望在全球范围内提升数学教育质量。

四、结论

本文是主要讲述了基于大模型在数学教育上的应用系统通过结合深度神经网络和大数据技术,在提高数学教育质量方面发挥了巨大作用。随着技术进步和更多资源投入,在未来可能会看到更多此类应用出现,为全球数学教育带来革命性的改变。