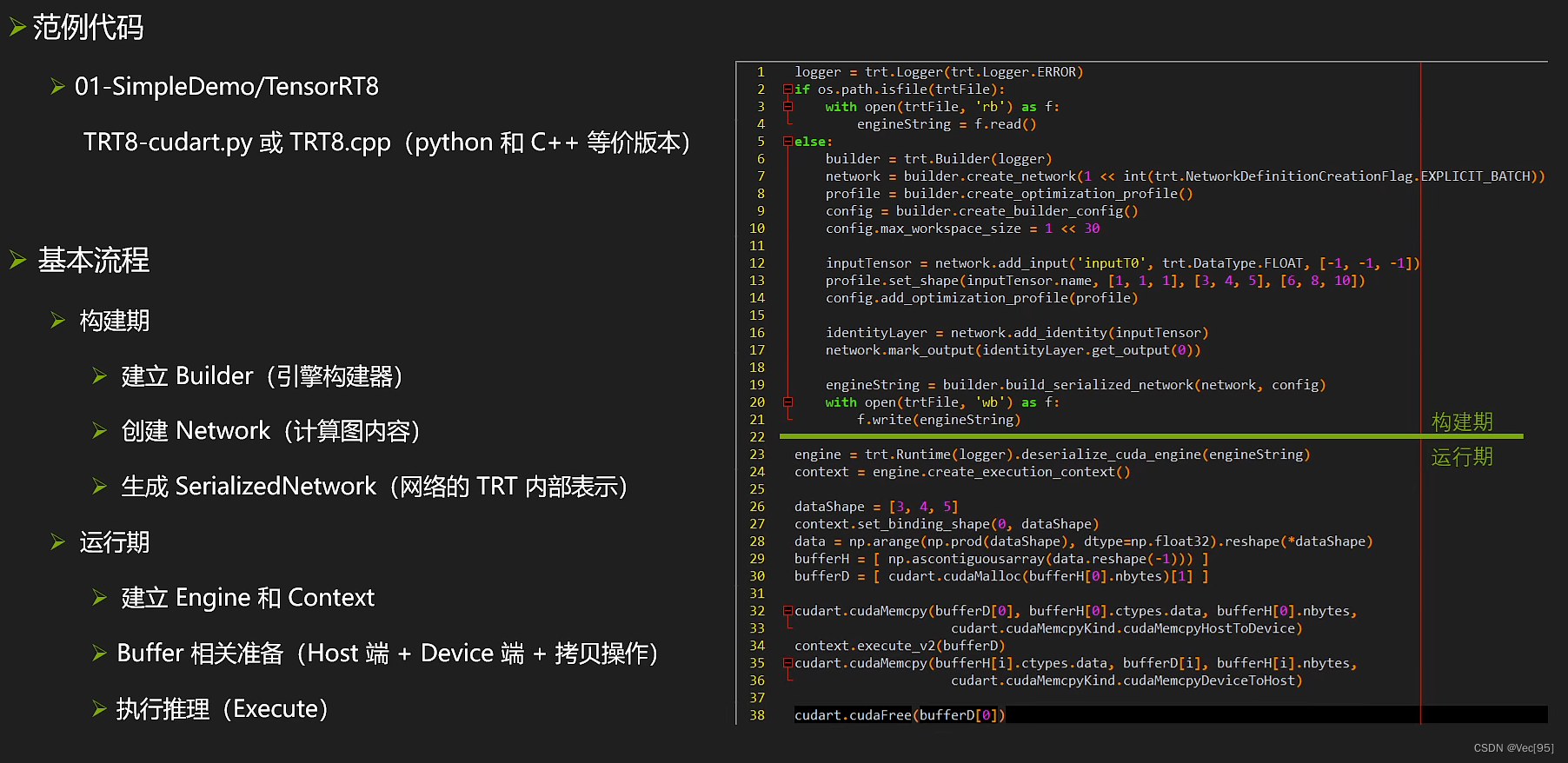

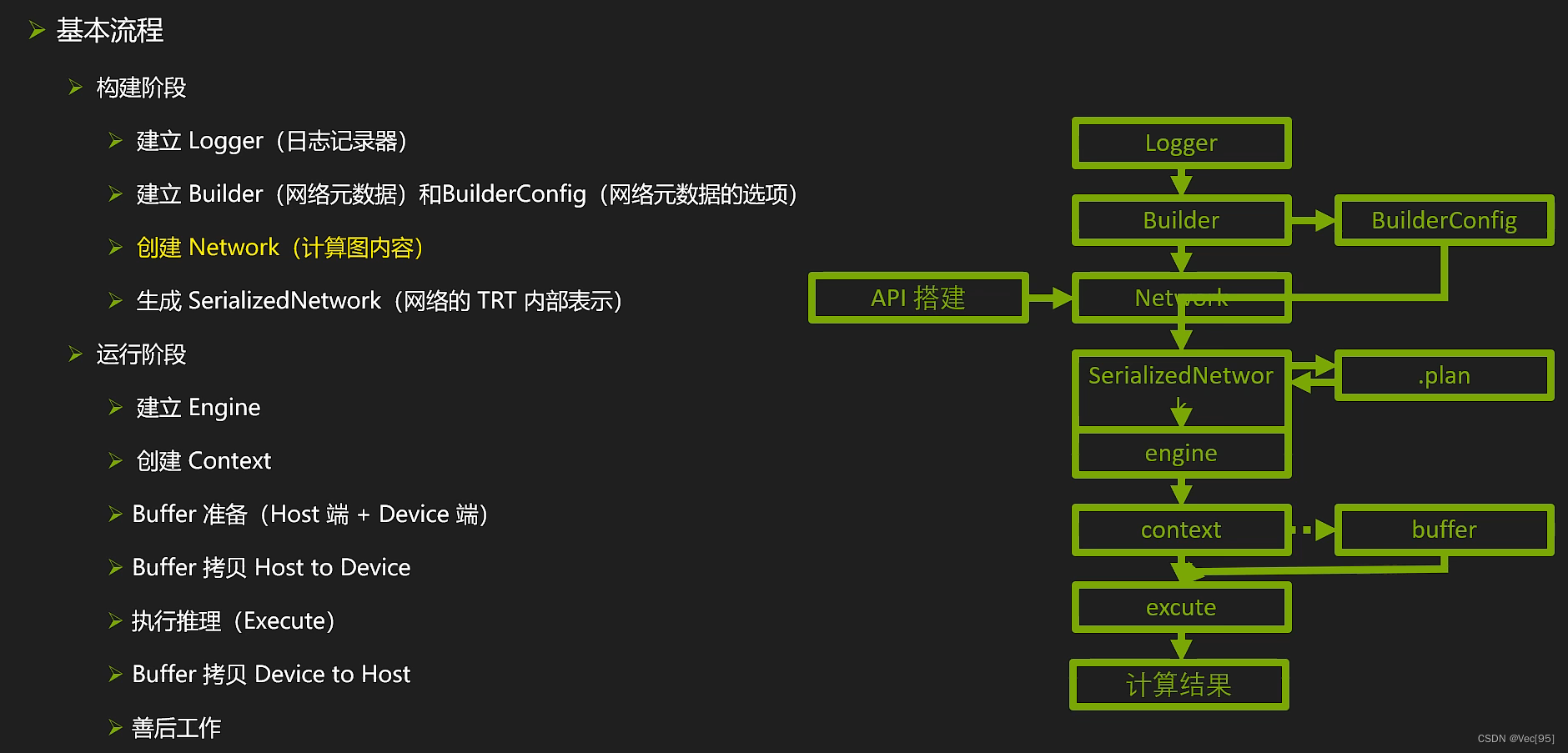

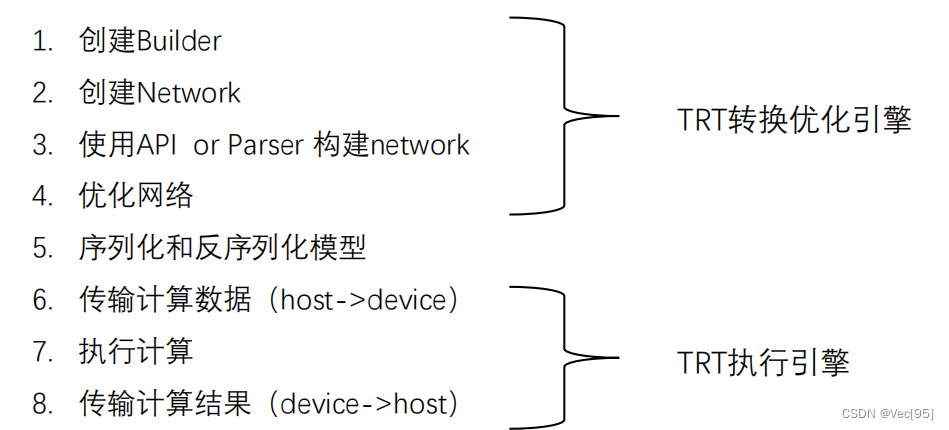

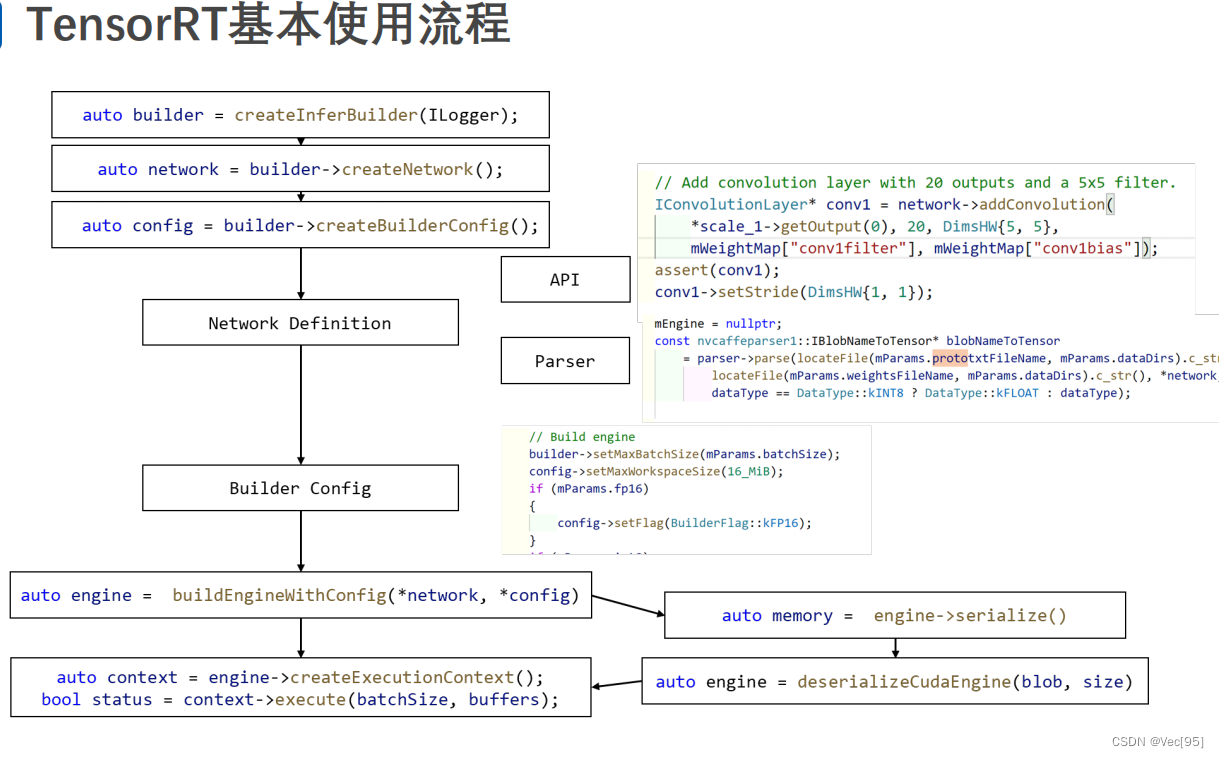

Builder(网络原数据):模型搭建的入口,网络的tensorRT内部表示以及可执行程序引擎都是由该对象的成员方法生成的

BuiderConfig(网络原数据的选项):负责设置模型的一些参数,如是否开始fp16模式,in8模式等等

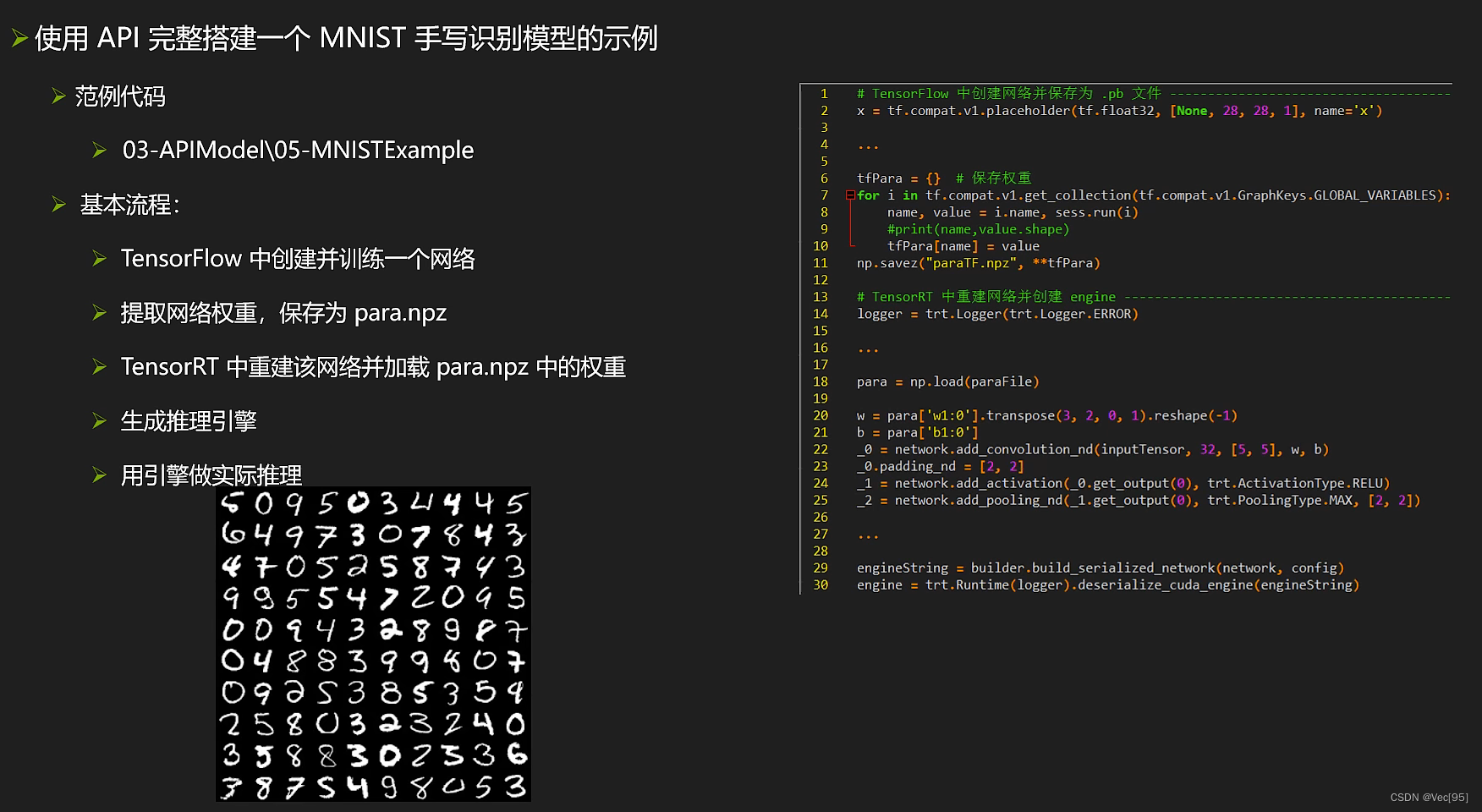

Network(计算图内容):网络的主体,在使用api搭建网络的过程当中,将不断地向其中添加一些层,并标记网络的输入输出节点,在其他两种workflow中,则使用Parser来加载来自Onnx文件中的网络,就无需一层一层手工添加

SerializedNetwork:模型网络在TRT中的内部表示,可用它生成可执行的推理引擎或者把它序列化保存为文件,方便以后读取和使用

Engine:推理引擎,是模型计算的核心,可理解为可执行程序的代码段

context:用于计算GPU的上下文。类比于cpu上的进程概念进程,是执行推理引擎的主体

buffer相关(数据的内存、显存相关):我们将需要把数据从cpu端搬到gpu端,执行推理计算后,再把数据由gpu端搬回cpu端。这些步骤涉及内存的申请、拷贝和释放,需要借助CUDA库或者扩大python库才能完成

excute:调用计算核心执行推理计算的具体过程

善后工作:还有一些外围的工作需要手工去完成