Denoising Score Matching——DSM

有没有谁通俗的讲一下Denoising score matching?

Denoising Score Matching (DSM)

论文 << A Connection Between Score Matching and Denoising Autoencoders>>

作者是将denoising autoencoder和score mathching 联系在了一起,提出了 Denoising Score Matchine (DSM), 并且这个工作启发了后来的很多工作。

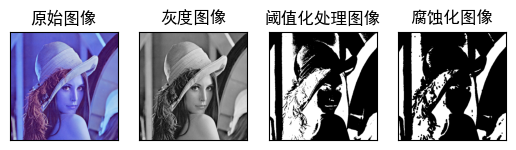

简单的说这个工作和score matching的区别是, score matching 中拟合的是原始数据的log 梯度,而 DSM中拟合的是加了噪声的数据的log 梯度, 从加噪声这点来看,和denoising autoencoder的做法很相似的。

这里我觉得这里重点是他为什么要在数据里加噪声,这里一个motivation 是和denoising autoencoder 里提的差不多,第二个是说原始score matching 里面如果数据不多的话,梯度估计的不准,那你后期在采样的时候,可能样本的质量就不太高,在数据上做点扰动,可以起到一定数据增广的效果,再一个这个噪声是你加的,你可以控制这个噪声的力度,也就是说你可以通过加噪声来控制生成的新数据和原数据的相似程度,这一点我觉得和DDPM里面的思想有些相似, 再一个我觉得很奇妙的是作者通过添加高斯噪声最后推导出一个新的公式,这个新的公式比原来的score matching的要好,后面会说明。

Score Matching——SM

得分匹配 Score Matching

最近,以宋博士为代表的研究者提出基于得分的概率生成模型在图像生成等领域取得佳绩,打破了一些主流生成模型(如,对抗生成模型-GAN,变分自编码器 -VAE,基于流的生成模型-Flow-based Genarative Model等)在生成领域的制霸权,引领了一波生成模型的研究热潮 (详情请参考宋博士博客Generative Modeling by Estimating Gradients of the Data Distribution)。

Yang Song (宋飏)

Solving Inverse Problems in Medical Imaging with Score-Based Generative Models

基于得分的概率生成模型最主要的思想是估计得分,而估计得分的主流方法得分匹配 (Score Matching) 早在2005年已经有研究者提出。因此,了解得分匹配的原理能够帮助理解和学习主流的生成模型。

变分推理

变分推理(variational inference)

变分推理是一种确定式的(deterministic)近似推理(approximate inference)方法。近似推理简单地说就是一种用来近似一个计算复杂(intractable)的分布或者至少获得目标分布的一些统计量(statistics)的方法。在深度学习应用,中比较有名的变分自编码器(VAE)的底层就基于变分推理。

变分推理的核心想法是,用一个更简单的,容易得到的分布 q(Z)来近似P(Z|X),存在两个问题

1、q(Z)的形式是什么?

2、如何调整q(Z)的参数使其近似目标后验?

对于问题1,通常采用(几乎)可以近似任意分布的神经网络来表达 q(Z)

对于问题2,借鉴了物理学中的free-energy概念,在机器学习领域发展为证据下界(ELBO, evidence lower bound)。

退火郎之万动力学:

Diffusion Model | (三)Langevin dynamics

估计数据分布梯度:如何克服现有生成式模型的缺陷

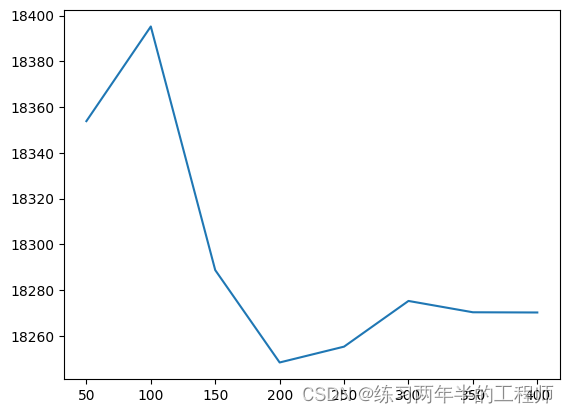

将噪声大小作为输入的一部分,并估计数据被不同噪声扰动之后的目标函数,这就是条件计分函数模型。训练条件计分模型时,每个σ对应着一个单独的计分匹配目标函数。采样时先从噪声最大的分布开始,逐渐过渡到噪声小的部分。最终获得的最小样本就是条件计分函数模型的采样,这种采样方法被称为Annealed Langevin dynamics。