Summary

- 对于分布式学习,特别是相关之前共享梯度的学习,提出了一种攻击方式(DLG)。通过窃取client之间传递的梯度反推出(也是使用机器学习迭代的方式)原始的输入。并在图像分类、Masked Language Model方面取得的不错的成绩。

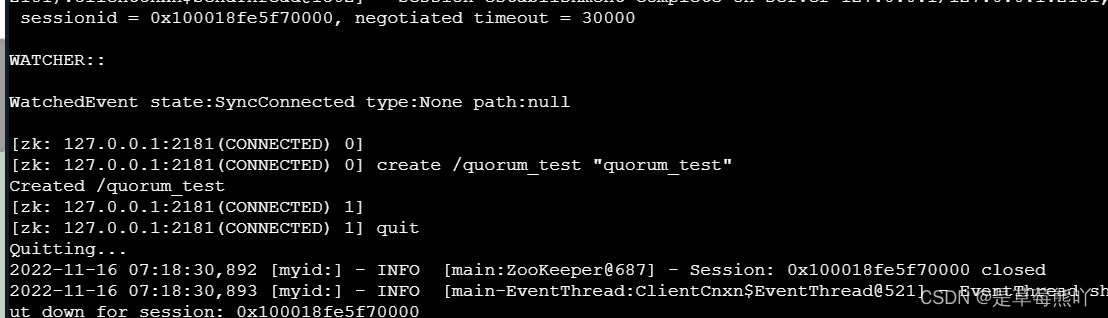

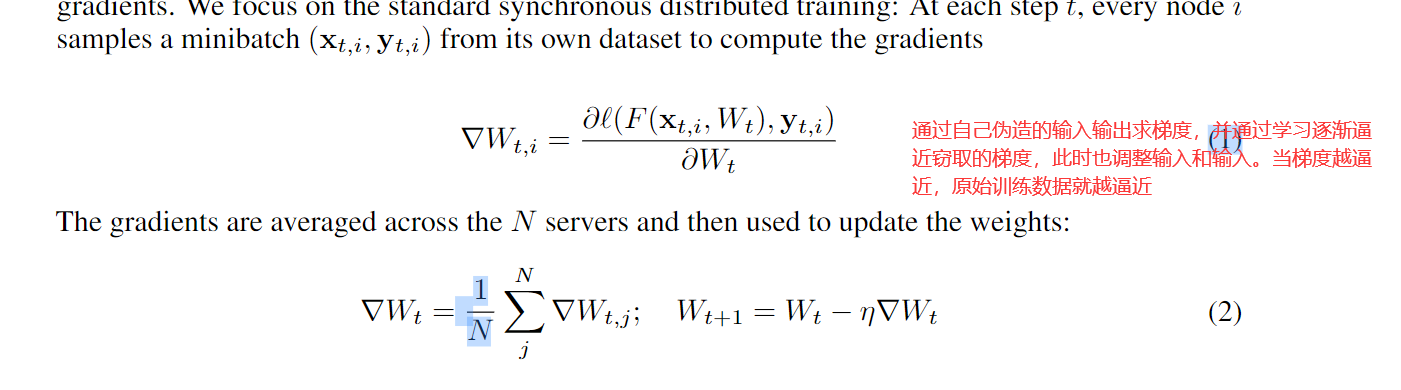

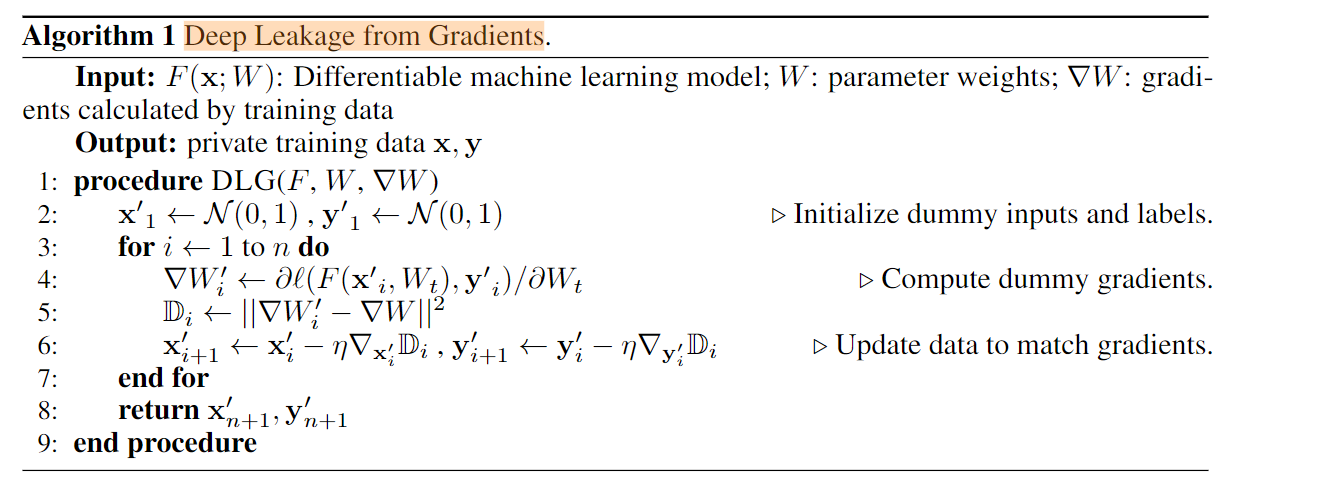

Method

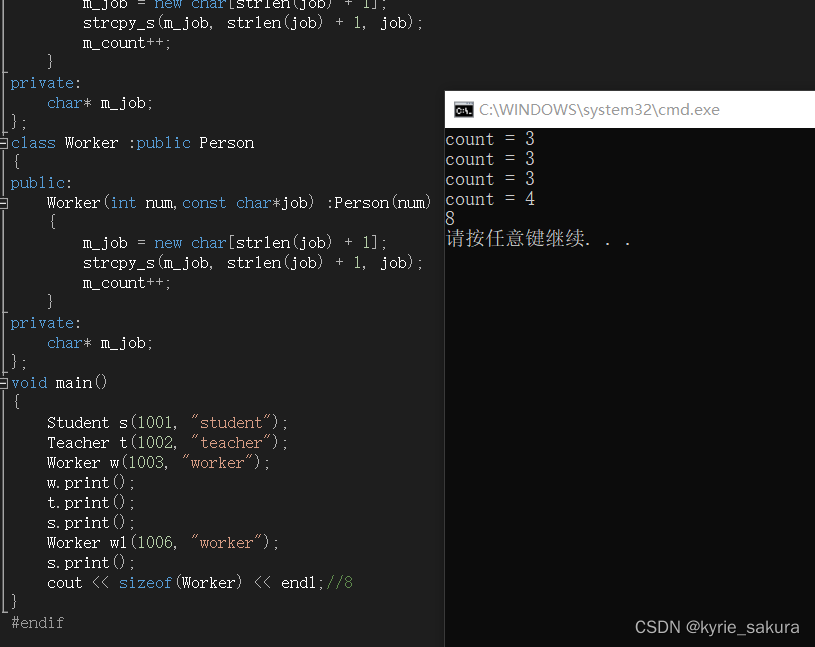

- 初始化一个(x,y)。

- 上述可能只对输入和标签只有一对的时候,当训练有N和小批次的数据时,修改一下algorithm 1.

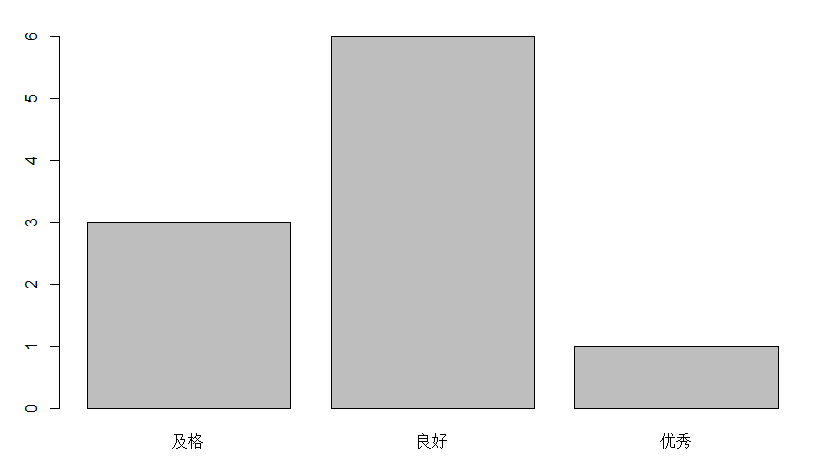

Experiment

-

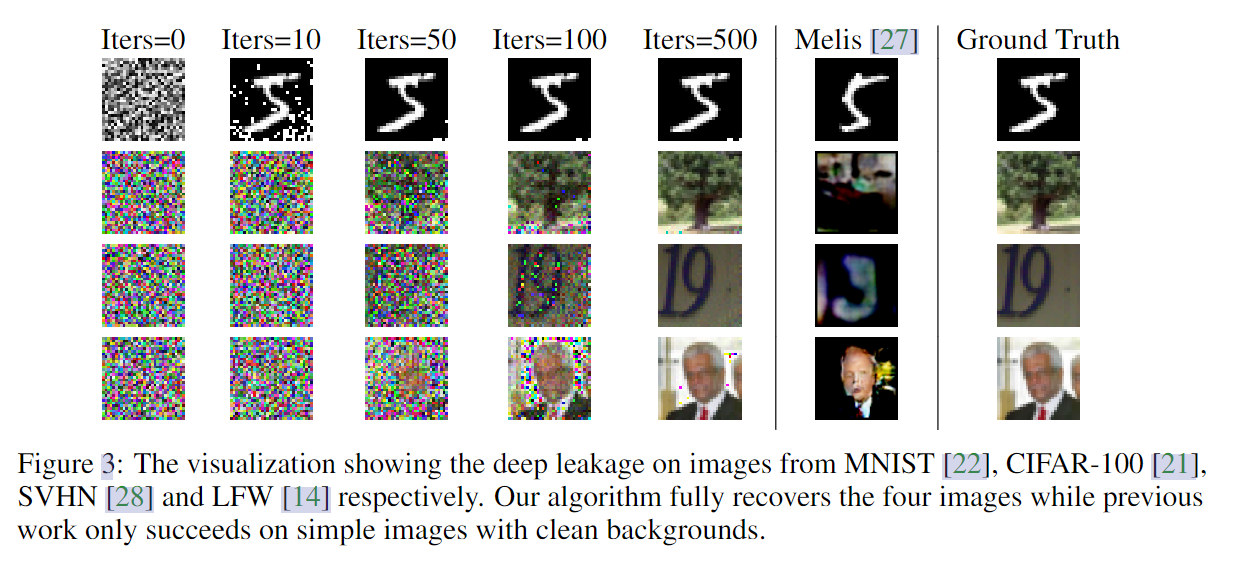

Deep Leakage on Image Classification

-

对于图像标签,我们没有直接优化离散类别值,而是随机初始化一个形状为N × C的向量,其中N为批大小,C为类数,然后将其softmax输出作为单热标签进行优化。(不太理解)

-

效果,而且比之前GAN的Melis要好些。不同类型的数据集效果也不同。

-

-

Deep Leakage on Masked Language Model

- 与视觉任务(RGB输入是连续的值)不同,语言模型需要将离散的单词预处理为嵌入(不太理解)

- 效果

虽然不能完全复现原句,但是大意是完全可以得出的。

Defense

- 添加噪声,噪声的种类不太重要,重要的是加多少

- 梯度压缩,压缩超过百分之20有一点效果。、

- 增大训练数据的Batch

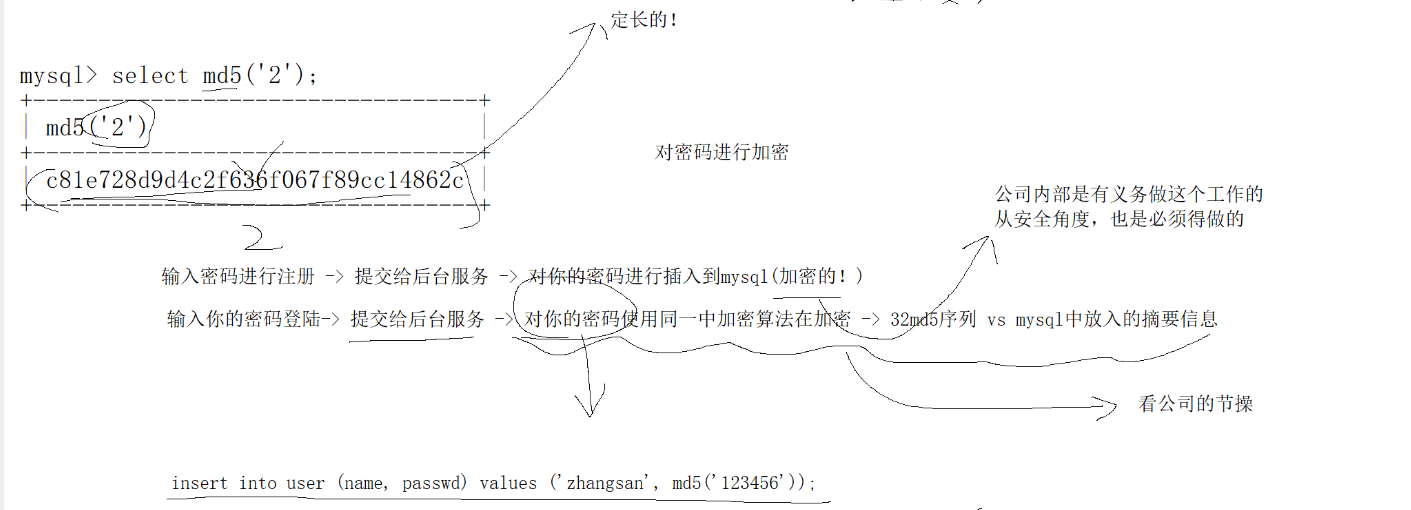

Related Knowledge

- Masked Language Model

- GAN Model

- BERT模型