网络爬虫是一种用于自动化获取互联网信息的工具,在数据采集和处理方面具有重要的作用。Python语言和Scrapy框架是构建强大网络爬虫的理想选择。本文将分享使用Python和Scrapy构建强大的网络爬虫的方法和技巧,帮助您快速入门并实现实际操作价值。

一、Python语言与Scrapy框架简介

1、Python语言:Python是一种简洁而高效的编程语言,具有丰富的第三方库和强大的数据处理能力,适合用于网络爬虫的开发。

2、Scrapy框架:Scrapy是一个开源的Python框架,专门设计用于构建和运行网络爬虫。它提供了许多强大的功能,如异步IO、自动化请求管理和数据处理。

二、构建强大网络爬虫的步骤及技巧

1、安装和配置Python与Scrapy:

-

安装Python:从Python官网下载并安装最新版本的Python解释器。

-

安装Scrapy:使用包管理工具pip,在命令行中运行"pip install scrapy"即可安装Scrapy。

-

配置Scrapy:根据需求进行Scrapy的配置,如设置下载延迟、并发数和User-Agent等。

以下是一则代码示例:

# 使用 pip 安装Scrapy

pip install scrapy

# 创建一个新的Scrapy项目

scrapy startproject myproject

# 在settings.py文件中进行配置,例如设置下载延迟

DOWNLOAD_DELAY = 2

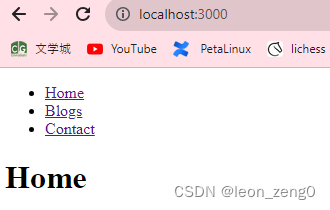

2、创建Scrapy项目和爬虫:

-

创建Scrapy项目:在命令行中运行"scrapy startproject project_name"命令即可创建一个Scrapy项目。

-

创建爬虫:通过运行"scrapy genspider spider_name domain"命令,可以在项目中创建一个新的爬虫。

以下是一则代码示例:

import scrapy

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://www.example.com']

def parse(self, response):

# 提取页面的内容

title = response.css('h1::text').get()

yield {'title': title}

3、编写爬虫逻辑和数据处理:

-

爬虫逻辑:在爬虫文件中,使用Scrapy提供的选择器和请求方法来定义爬取页面的逻辑。

-

数据处理:通过使用Scrapy提供的Item和Pipeline,可以对爬取到的数据进行处理、清洗和持久化。

以下是一则代码示例:

import scrapy

from scrapy.item import Item, Field

class MyItem(Item):

title = Field()

content = Field()

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://www.example.com']

def parse(self, response):

item = MyItem()

item['title'] = response.css('h1::text').get()

item['content'] = response.css('p::text').getall()

yield item

# 在配置文件settings.py中启用Pipeline

ITEM_PIPELINES = {

'myproject.pipelines.MyPipeline': 300,

}

4、调试和测试:

-

调试:使用Scrapy提供的调试工具,如登录中间件和Shell命令行,来辅助调试和测试爬虫。

-

测试:编写单元测试和集成测试,验证爬虫的正确性和稳定性。

以下是一则代码示例:

# 在命令行中运行

scrapy shell 'http://www.example.com'

这将打开Scrapy的Shell,您可以在其中执行和调试Scrapy的相关命令和代码。

5、反爬策略和扩展:

-

反爬策略:了解和应对常见的反爬机制,如IP封禁和验证码识别,并通过合理的爬取策略来规避反爬限制。

-

扩展功能:Scrapy提供了丰富的扩展机制,如中间件和信号,可以根据需求自定义功能并拓展爬虫的能力。

三、实际操作价值

1、使用Python与Scrapy构建强大的网络爬虫可以快速获取大量的有价值数据,满足数据采集和分析的需求。

2、Python语言和Scrapy框架在爬虫开发上具有丰富的工具和库,能够提高开发效率和代码质量。

3、掌握网络爬虫的基本原理和技巧,能够更好地理解和分析互联网上的数据,并应对各种复杂的爬取场景。

4、了解反爬策略和扩展功能能够提高爬虫的稳定性和可靠性,降低被目标网站检测和封禁的风险。

Python语言与Scrapy框架提供了强大的工具和库,帮助您构建强大、高效的网络爬虫。通过掌握构建步骤和技巧,您将能够快速入门并实现实际操作价值。希望本文对您在使用Python和Scrapy构建网络爬虫的过程中提供了启发和帮助。