本周写两篇关于 chatgpt 的随感,我不善于写文档,所以我的文字多是输出直感和观点,而不是知识,没有关于 chatgpt 的原理和应用,甚至术语也不匹配,反正就是想到哪算哪吧。

都说 chatgpt 没有内在逻辑,只会死记硬背,但中国的中小学生又能好到哪去呢?拼命做题,遍历各种题型,熟读成诵,背会唐诗三百首,不会写来也会偷,这种信仰本身就是对量大出奇迹,力大砖飞的天然依赖,填鸭式应试教育背景下的学生之于 chatgpt,五十步笑百步而已。

chatgpt 没有内在逻辑,学生就懂吗?但问题就在于,量大还真就出奇迹,拼命刷题的还真就比那些埋头于逻辑求真的人考试成绩要好,甚至好很多。

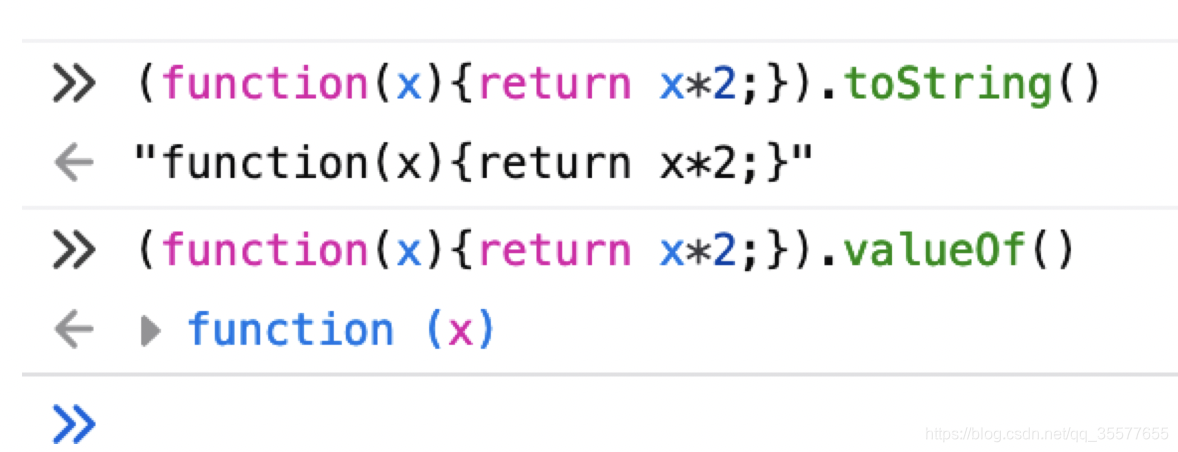

chatgpt 将看到的文字信息编码在一个拥有千亿级参数的神经网络中,chatgpt 本质上就是根据已有的文字描述信息不断获取概率最高的下一个字,所依据的就是这张神经网络本身。

仔细想想,chatgpt 和小孩子学说话很像,不断学着大人说,却不懂什么意思,更不管什么逻辑,他只在乎自己看起来像那么回事,别的什么都不用理解。可当小孩子慢慢长大,当他说的话绝大多数都符合大人们的预期时,他是依然在有样学样地模仿大人还是真的理解了语言的本质,谁又在乎呢?交流没有问题,这就够了,语言就是这么一回事,没人会去实证每一句话的含义和它的逻辑严谨性之间的关系。

当 chatgpt 一本正经地介绍曹雪芹写的 《三国演义》时,它只是中了你的圈套(几个月以前的事了,现在它已经不会轻易上当了),但作为人类的我们自己却经常胡搅蛮缠。当我说 “我们要按时下班,把更多的时间留给自己和家庭,毕竟工作赚钱不是唯一重要的。” 很多人从这句话里得到 “赚钱不重要” 的结论,这符合逻辑吗?所以,逻辑到底是什么?

谈到逻辑就不能不谈数学,从集合的交并补讲起相当于起了一门新课,这些概念对于 chatgpt 很快就能记住并 “理解”。我们每个人都是这么开始学习的,当然,这种学习方法,我们干不过 chatgpt。

不管多么复杂,多么饶舌烧脑的信息,chatgpt 都能很快记住并理解,内化成它自身神经网络的一部分,这张网络越滚越大,直到囊括宇宙所有的知识,包括数学(它是懂阿贝尔群的,甚至可以教别人),物理,艺术。

但根据 chatgpt(甚至其它 AI) 的生成原理来看,有个结界,它无法 “代入” 和 “类比”,也就无法产生直觉。不过并不值得骄傲的是,绝大多数人(如果不是所有的话)也一样拥有这个结界,无法 “代入” 和 “类比” 而产生直觉。

直觉比逻辑对于创造而言更重要。逻辑可以被学会,但直觉不能。记住并内化一套规则,学会集合和分类方法,这就是逻辑的步骤,但遇到从没见过的事物关联两个毫不相干的场景,却是反逻辑的,但恰恰是这种类似瞎猜的毫无逻辑的行为能力创造了人类文明,反逻辑反而创造了逻辑本身。

当人们问 chatgpt 一道自己编造的数学题时,它可以结合它见过的其它题目举一反三,就像人遇到不会的题一般也能够通过看其他类似题解法通过数据代换、类比举一反三一样,代数规则,几何证明,数理逻辑,这些问题对于 chatgpt 而言只需要执行搜索任务,就跟我们大多数刷过很多题的人一样。这是令人称道的,试图用一道数学题难住 chatgpt 的机会将越来越渺茫,就像外国人试图在数学竞赛战胜中国人的机会越来越渺茫一样。

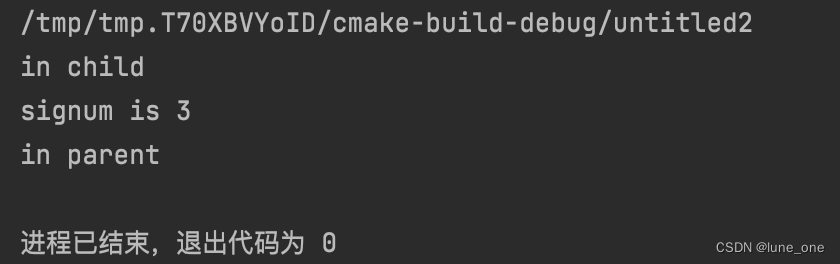

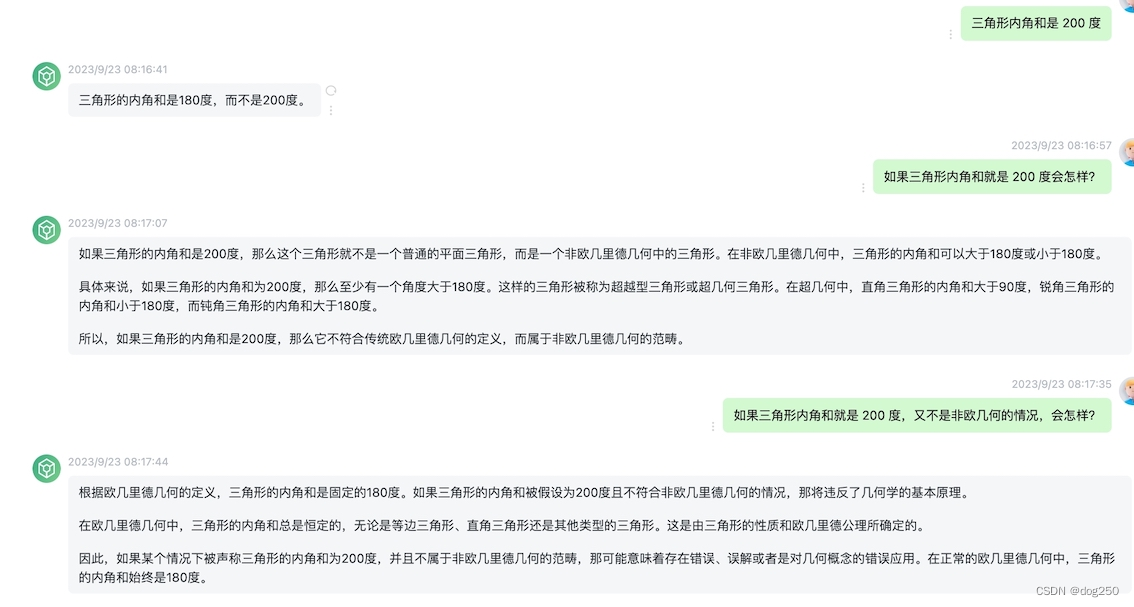

让 chatgpt 试一下情景代入。它懂别人的故事:

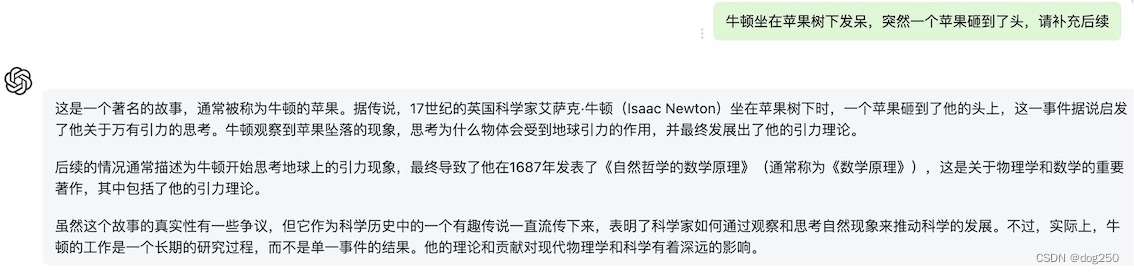

但它无法把自己代入:

虽比不上牛顿,但还是比大多数人考虑得周全。可 chatgpt 没有编出那个著名的故事,也没有对故事表示质疑,甚至抖个机灵都没有。一个普通人可能会说 “我不会思考苹果为什么掉到天上或者横着飞,因为那样的话,它就不会砸到我了”,换句话说,chatgpt 只会就事论事。

几乎可以肯定,三大定律不是苹果砸出来的,但必然有直觉助力,任何从零到零点一的过程几乎都是直觉触发,后面才轮到逻辑入场。

四则混合运算,数学证明,普通人理解的逻辑,这些对 chatgpt 都不是问题,推而广之对 AI 都不是问题,但 AI 很难发现 “飞机就是一只蜻蜓”,“潜艇就是一条鱼”,也不会从茶壶盖被顶起想到蒸汽动力,归纳起来就是 AI 没有能力求出 x 和 y 的交集,同时又得出 “x 就是 y” 的结论,这是不符合逻辑的,x 和 y 明明就不是一个东西。

听起来有些奇怪,但事实就是这样。

当你抬头仰望,看见一架飞机和一只蜻蜓经过,你会瞬间捕捉到两者之间的相似特征,甚至可以自行 “推导” 出空气动力学。但对于从没有见过飞机的人来讲,当他看见一只蜻蜓飞过的时候,有多少人会说 “蜻蜓是一台会飞的机器” 呢?毕竟蜻蜓只是一只昆虫,它并不是一台机器,x 和 y 明明就不是一个东西,所以 x 不可能是 y。

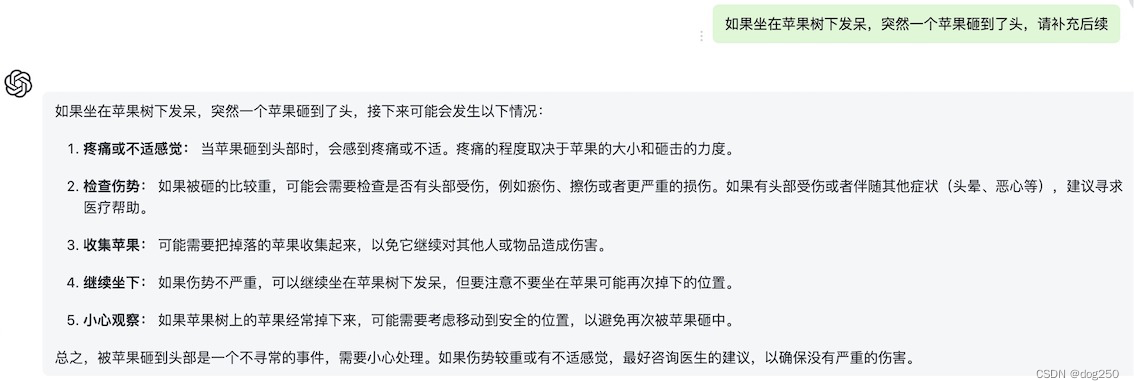

如果你跟同学说三角形内角和等于 200 度,可能只是你记错了,也可能你只想知道 “如果三角形内角和真等于 200 度,看看会发生什么”,无论哪种情况,你的同学和老师会不厌其烦地纠正你错误的认知,告诉你三角形内角和不可能是 200 度,而是 180 度,这是一个结论,chatgpt 也会这样做:

无论你怎么引导它,它都不肯陪你玩一会儿。它只是不厌其烦告诉你它学过的东西。

AI 擅长小心求证,大胆假设却不行,现阶段的 AI 过于一本正经,它有意避免犯错,让自己越来越正确,但人类文明的推进往往始于错误和毫不搭界的直觉,在此前提下才可能有大胆的假设。

代入和直觉需要第一人称,需要 “自指的边界”,这对于自由意志或许是必不可少的,一个人可以拥有自己最亲密的人几乎所有的记忆,但当这个人离开后却还是会思念。

…

最后推荐一本书,侯世达的《我是个怪圈》,如果你只是为了考试,相信大力出奇迹,chatgpt 就是榜样。

皮鞋没有蹬上,露着白袜子。

浙江温州皮鞋湿,下雨进水不会胖。