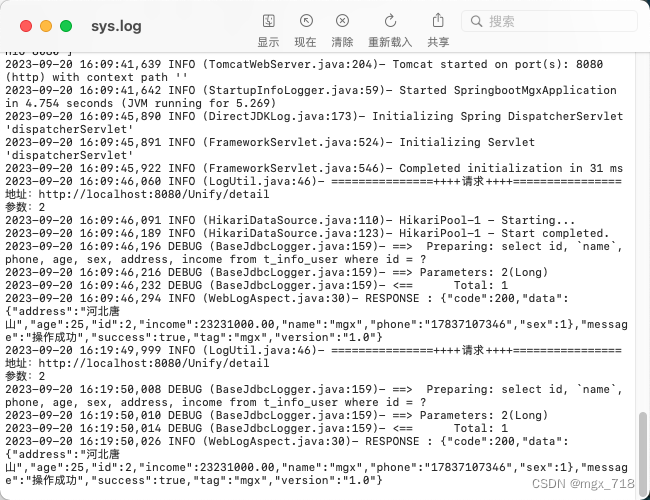

数据

数据整体的信息

我们整个数据就可以表示成这样

- 上图中的数据整体叫数据集(data set)

- 图中每一行数据称为一个样本(sample)。

- 除最后一列,每一列表达样本的一个特征(feature)

- 最后一列称为标记(label)

除了第一行和最后一列以外的信息就是我们所需要的数据, 通常数据我们用矩阵X来表示, 最后一列的标记我们用y像两个来表示

X矩阵中第i个样本行写作 X ( i ) X^{(i)} X(i), 第i个样本第j个特征值 X j ( i ) X_{j}^{(i)} Xj(i)。y向量中第i个样本的标记写作 y ( i ) y^{(i)} y(i)

每个样本的特征所组成的向量称为特征向量

我们通常表示向量都是用列向量的形式表示

在这里我们选择数据集中前两个特征的数据, 并用可视化图表的形式表示出来, 这两个特征所组成的是一个二维空间, 样本中每个特征的值所组成的向量就代表该空间中的每个点, 那么这个空间我们就称之为特征空间(feature space)

分类的本质就是在特征空间切分。当我们输入一个数据的时候, 我们把它在特征空间中进行表示,然后根据新输入数据的落点区域去判断去花的种类

特别强掉的是, 由于可视化的需要, 所以很多时候我们把数据降到两维, 因为通常对于一个数据而言都是具有非常多的特征的, 比如上面的鸢尾花数据集中, 其中就有四个特征, 那么我们其实是在四维的空间中进行切分, 那么这是无法可视化的, 所以我们通常会采用降维的方式进行数据分类, 最后我们再把低维空间得到的结论推广到高维空间, 这在高维空间中都同理。

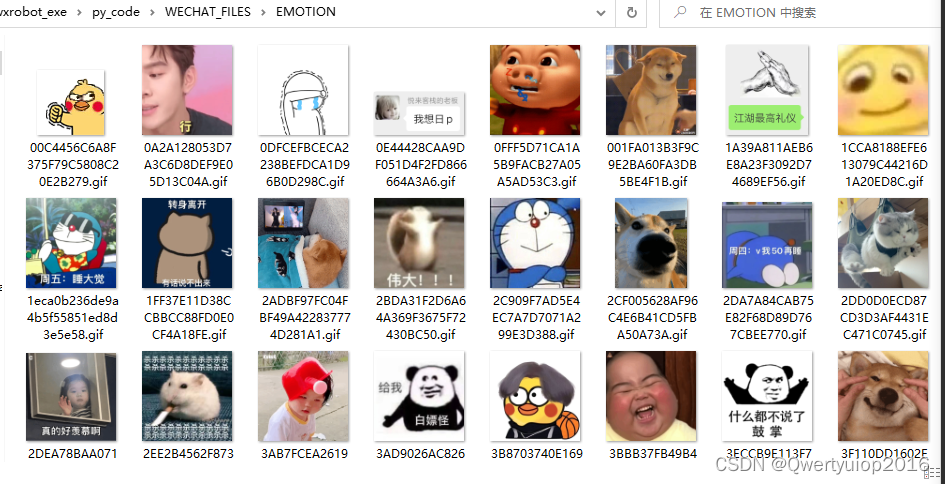

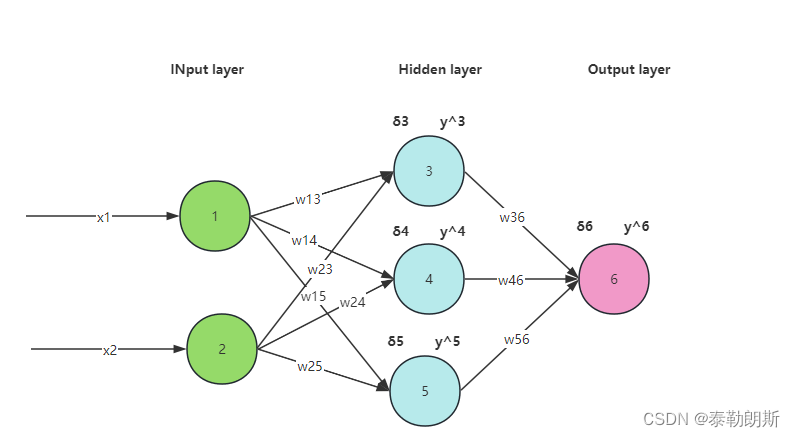

在机器学习的领域中特征可以是一个非常抽象的一个事物, 比如下面这个图象识别数据集中的一个样本5, 它是一个灰度图像, 它的特征值相比于彩色图像特征少一点

在这里:

- 图象, 每一个像素点都是特征

- 一个图像的特征的数目:比如28*28的图像有28*28=784个特征

- 如果是彩色图像则特征更多

在机器学习领域中, 特征不都是有语义的, 也有可能是非常抽象的。