激活函数总结(三十四):激活函数补充

- 1 引言

- 2 激活函数

- 2.1 FReLU激活函数

- 2.2 CReLU激活函数

- 3. 总结

1 引言

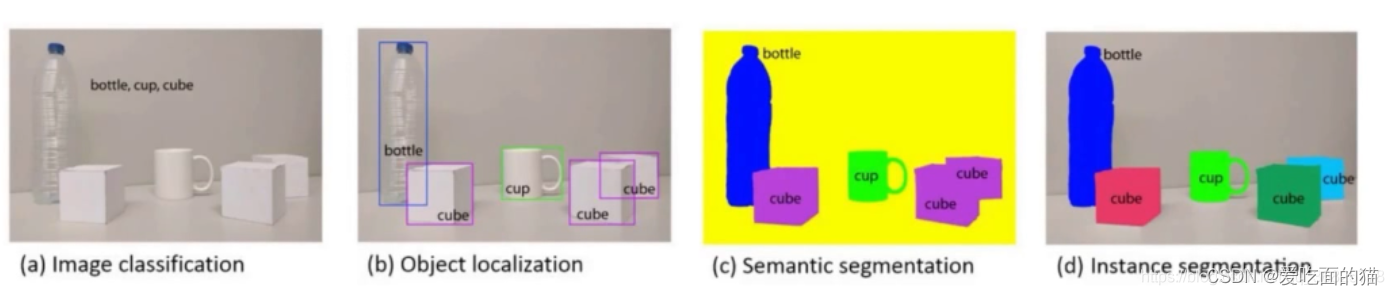

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softplus、Mish、Maxout、HardSigmoid、HardTanh、Hardswish、HardShrink、SoftShrink、TanhShrink、RReLU、CELU、ReLU6、GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU、Softmin、Softmax2d、Logsoftmax、Identity、LogSigmoid、Bent Identity、Absolute、Bipolar、Bipolar Sigmoid、Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh、LeCun Tanh、TanhExp、Gaussian 、GCU、ASU、SQU、NCU、DSU、SSU、SReLU、BReLU、PELU、Phish、RBF、SQ-RBF、ISRU、ISRLU、SQNL、PLU、APL、Inverse Cubic、Soft Exponential、ParametricLinear、Piecewise Linear Unit、CLL、SquaredReLU、ModReLU、CosReLU、SinReLU、Probit、Smish、Multiquadratic、InvMultiquadratic、PSmish、ESwish、CoLU、ShiftedSoftPlus、Logit、Softsign、ELiSH、Hard ELiSH、Serf、FReLU、QReLU、m-QReLU)。在这篇文章中,会接着上文提到的众多激活函数继续进行介绍,给大家带来更多不常见的激活函数的介绍。这里放一张激活函数的机理图:

2 激活函数

2.1 FReLU激活函数

论文链接:Funnel Activation for Visual Recognition

FReLU(Funnel activation)是一种概念简单但有效的漏斗激活函数。它通过添加可忽略不计的空间条件开销将ReLU和PReLU扩展到2D激活。其数学表达式和数学图像分别如下所示:

F

R

e

L

U

=

m

a

x

(

x

,

T

(

x

)

)

FReLU = max(x,T(x))

FReLU=max(x,T(x))

其中,

T

(

x

)

T(x)

T(x) 是 2D 空间条件,代表简单高效的空间上下文特征提取器。

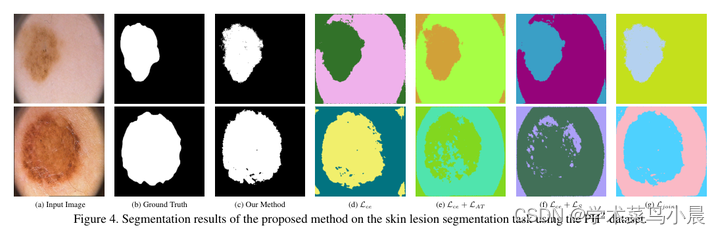

FReLU是专门为视觉任务而设计的,概念上很简单:ReLU的条件是一个手工设计的零值,PReLU的条件是一个参数化的px,对此FReLU将其修改为一个依赖于空间上下文的二维漏斗状条件,视觉条件有助于提取物体的精细空间布局。

特点:

- 漏斗条件funnel condition:FReLU函数采用与简单非线性函数相同的max(·)。对于

条件部分,FReLU将其扩展为二维条件,具体取决于每个像素的空间上下文。这与其他最近的方法不同,其他方法的条件通常取决于像素本身或通道上下文。然后,使用max(·)获得x和条件之间的最大值。作者将funnel condition定义为T(x)。为了实现空间条件spatial condition,使用参数化池窗口(Parametric Pooling Window)来创建空间依赖性(使用高度优化的深度可分离卷积算符和BN层来实现) - 像素化建模能力:

funnel条件的定义使得网络可以在每个像素的非线性激活中产生空间条件。该网络同时进行非线性变换并产生空间依赖性,而通常的做法是在卷积层创建空间依赖性,并分别进行非线性变换。在通常做法下,激活过程不明确地依赖于空间条件;而在funnel条件的情况下,它们依赖于空间条件。因此,pixel-wise condition使得网络具有像素化的建模能力,函数max(·)给每个像素提供了一个看空间背景或不看空间背景的选择。

在图像方面具有极好的效果,在图像方面广泛使用。甚至,当前较多的Yolo系列的更新算法都使用的是该激活函数。。。

2.2 CReLU激活函数

论文链接:Understanding and Improving Convolutional Neural Networks via Concatenated Rectified Linear Units

CReLU(Concatenated Rectified Linear Units)是Shang et al. 在2016年提出的一种激活函数,可保留正相位和负相位信息,同时强制执行非饱和非线性。其数学表达式和数学图像分别如下所示:

C

R

e

L

U

(

x

)

=

[

ReLU

(

x

)

,

ReLU

(

−

x

)

]

CReLU(x) = \left[\text{ReLU}\left(x\right), \text{ReLU}\left(-x\right)\right]

CReLU(x)=[ReLU(x),ReLU(−x)]

特点:

- 减少CNN中的冗余:CNN 中

底层的卷积层的一些滤波器之间存在着负相关, 也就是说滤波器存在冗余。为了减少这种冗余,提出了使用CReLU激活函数。

CReLU激活函数在PVANET中有所应用,别的地方几乎没有出现。。。。

3. 总结

到此,使用 激活函数总结(三十四) 已经介绍完毕了!!! 如果有什么疑问欢迎在评论区提出,对于共性问题可能会后续添加到文章介绍中。如果存在没有提及的激活函数也可以在评论区提出,后续会对其进行添加!!!!

如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。

![[管理与领导-93]:IT基层管理者 - 扩展技能 - 5 - 职场丛林法则 -7- 复杂问题分析能力与复杂问题的解决能力:系统化思维](https://img-blog.csdnimg.cn/78ef0dd73c2d44768520b063eb8fd142.png)