本文重点

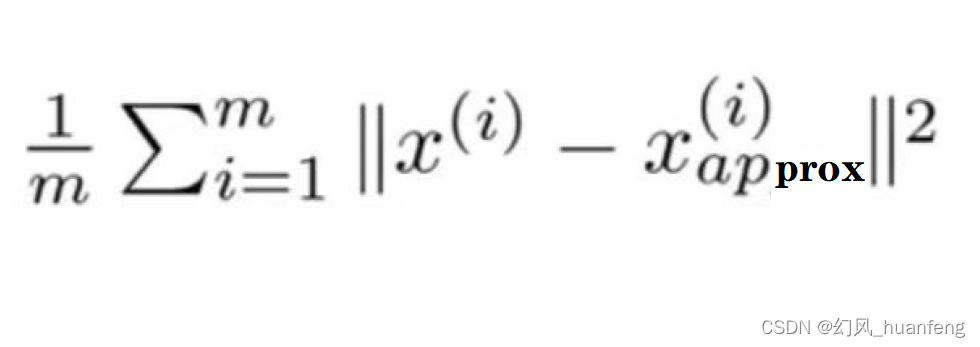

上节课程中我们已经学习了pca算法,已经知道了如何将n维特征变量降到k维,k是PCA算法的一个参数,也被称为主成分的数量。那么现在就产生了一个问题,这个问题就是如何选择K,因为PCA要做的就是要尽量减少投射的平均均方误差,所以K的选择很关键。

平均均方误差

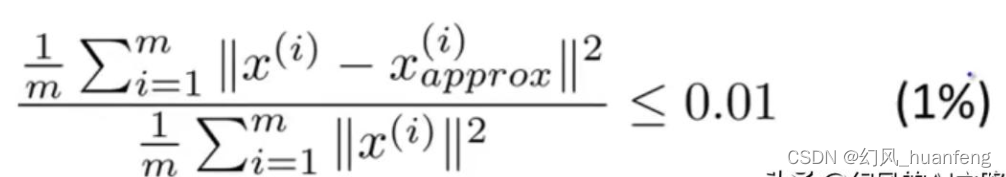

其中x(i)表示原始样本的特征向量,Xapprox(i)表示映射的样本

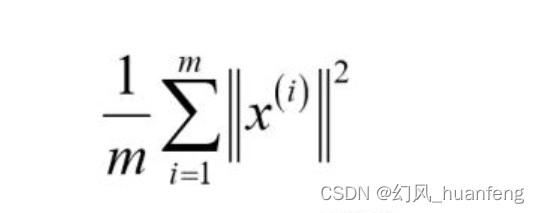

数据的总变差

数据的总变差就是数据集中每个训练样本长度的平均值,它表示平均来看我们训练集样本距离0向量有多远。

k值的经验得法则

k值的经验得法则就是,选择能够使得它们之间得比例小于0.01的最小的K值。

这个0.01用PCA语言就是说我们选择的参数K,原本数据的偏差有 99%都保留下来了,也就是说使得99%的差异性得以保留。大部分人选择k的时候,并不是直接的选择k值是多少,而是≤0.01还是0.05(95%的差异性被保留),0.10,0.15。然后选择符合这些要求的最小的k值。

<