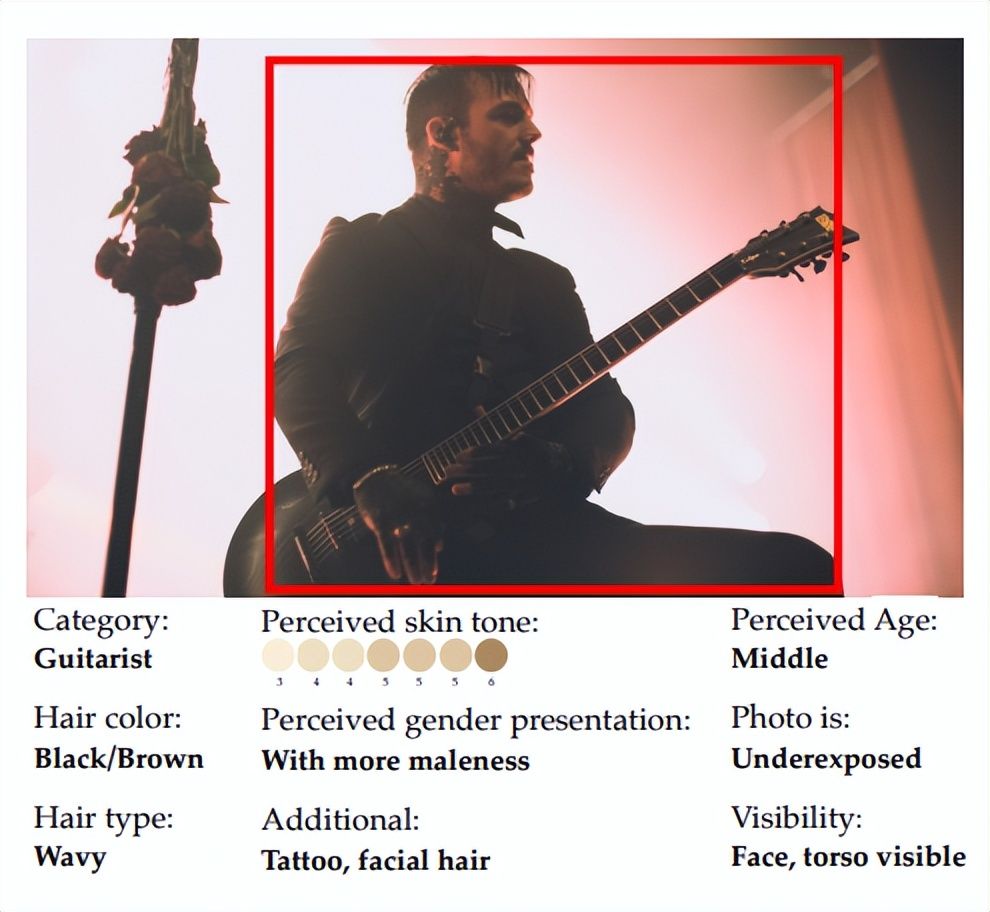

Meta 公司最新推出的 FACET 工具是为了解决计算机视觉模型中存在的种族和性别偏见问题。该工具经过三万张图片的训练,并含有五万人的图像,特别强调了性别和肤色方面的感知能力。

通过评估计算机视觉模型在不同特征上的表现,FACET 工具可以回答复杂的问题,并识别出对象的性别以及其他细节信息,如滑板运动员和肤色。这意味着计算机视觉系统可以更准确地辨别人物特征,消除对女性和有色人种的系统性偏见。

Meta公司利用 FACET 工具对自家开发的 DINOv2 模型与 SEERv2 模型,以及 OpenAI 的 OpenCLIP 模型进行评测。整体而言,OpenCLIP 在性别方面的表现优于其他模型,而 DINOv2 在年龄和肤色方面的判断力更为出色。

这说明不同的计算机视觉模型在处理性别和肤色方面可能存在差异,而 FACET 工具可以帮助研究人员进行类似的标准测试,以了解自己模型中存在的偏见,并监测采取的公平解决措施所带来的影响。

FACET 工具的开源将为研究人员提供一个重要的资源,使他们能够执行类似的测试,以深入理解和解决计算机视觉模型中的偏见问题。此外,这也将有助于监控实施的公平化措施对模型性能的影响。

这项工具的推出可见 Meta 公司对解决计算机视觉的公平性问题的承诺,同时也为业界提供了一个重要的工具来改善计算机视觉系统的偏见问题。通过 Meta 的努力,计算机视觉技术能够更全面地识别和理解不同人群的特征,从而消除偏见并确保公平性。

这一举措对于推动AI技术的公平化和包容性发展具有重要意义。在未来,我们可以期待看到更多的技术进步来解决计算机视觉系统中的偏见问题,为全球社会打造一个更加公正和包容的环境。