一、安装es和kibana

1、创建一个网络,网络内的框架(es+kibana)互联

docker network create es-net2、下载es和kibana

docker pull elasticsearch:7.12.1

docker pull kibana:7.12.13、运行docker命令部署单点es+kibana(用来操作es)

docker run -d \

--name es \

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

-e "discovery.type=single-node" \

--privileged \

--network es-net \

-p 9200:9200 \

-p 9300:9300 \

elasticsearch:7.12.1

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=es-net \

-p 5601:5601 \

kibana:7.12.1说明

docker run -d \

--name es \ --容器名字

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \ -- e为环境变量

-e "discovery.type=single-node" \

-v es-data:/usr/share/elasticsearch/data \ --这里是指定容器内的地址

-v es-plugins:/usr/share/elasticsearch/plugins \ --这里是指定容器内的地址

--privileged \

--network es-net \ --让es容器加入到这个网络中

-p 9200:9200 \ --9200为暴露的http协议端口,供用户访问

-p 9300:9300 \ --9300为es容器各个节点之间互联的端口

elasticsearch:7.12.1 --镜像名称4、访问

es: http://localhost:9200/

kibana: http://localhost:5601/5、查看日志

docker logs -f kibana

docker logs -f es二、使用:写DSL语句

访问http://localhost:5601/

点击这个,在里面写就行了

三、安装分词器

1、默认分词器(analyzer)

可选的有standard、english、chinese但是他们的中文都是一个字分一个词

POST /_analyze

{

"text":"胖胖and笨笨都是可爱的小猫猫",

"analyzer":"chinese"

}2、安装IK分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases/tag/v7.12.1

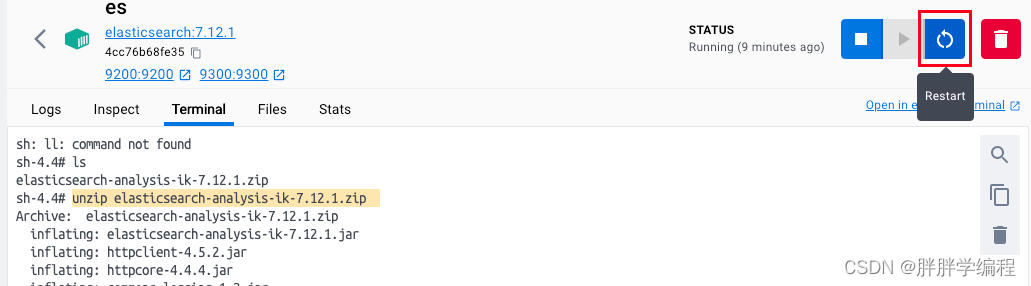

1)打开命令行界面

2)在/usr/share/elasticsearch/plugins下创建ik目录(必须创建,直接解压到plugins目录下会报错)

/usr/share/elasticsearch/plugins

mkdir ik3)将安装包拉取到es容器中,直接往里拖就行

4)解压

cd ik

unzip elasticsearch-analysis-ik-7.12.1.zip

rm elasticsearch-analysis-ik-7.12.1.zip5)重启容器