ShuffleAttention注意力机制简介

关于ShuffleAttention注意力机制的原理这里不再详细解释.论文参考如下链接here

yolov5中添加注意力机制

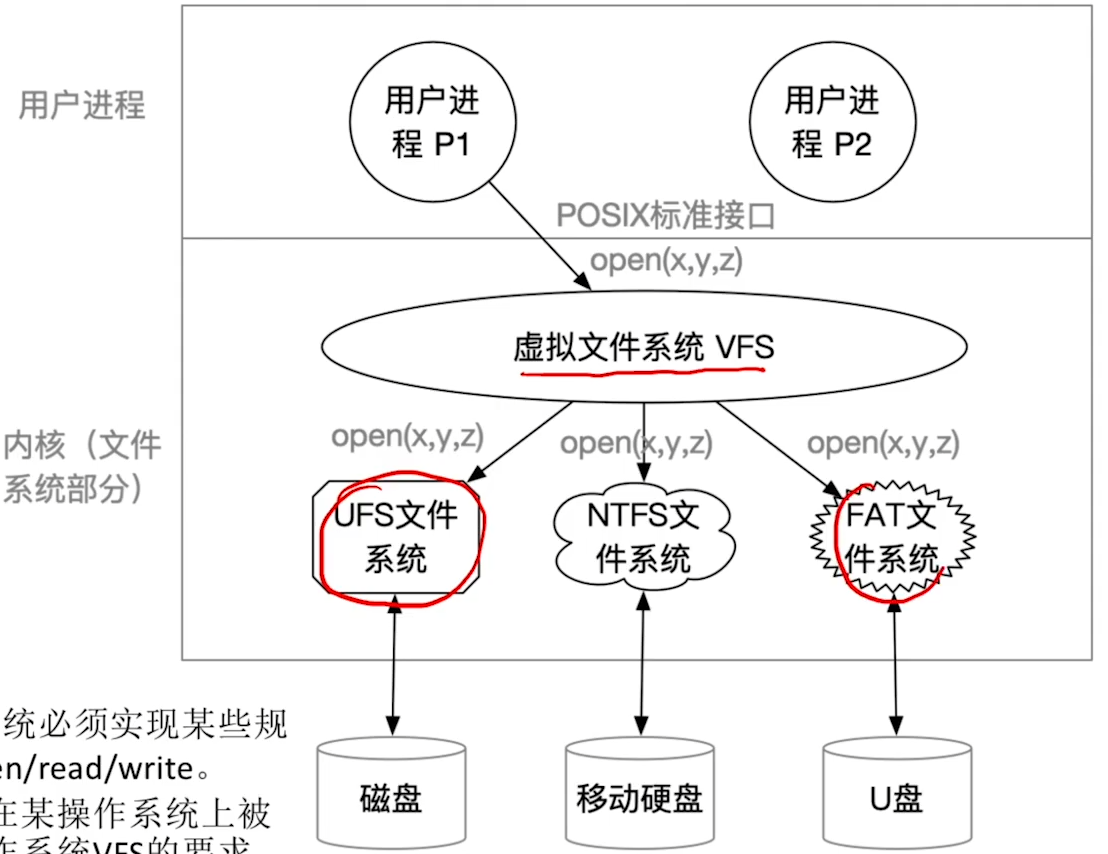

注意力机制分为接收通道数和不接受通道数两种。这次属于接受通道数注意力机制,这种注意力机制由于有通道数要求,所示我们添加的时候需要注意一下子。

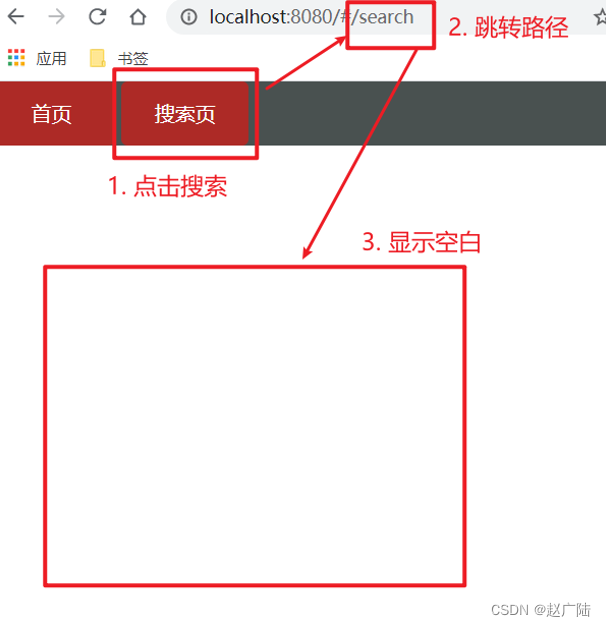

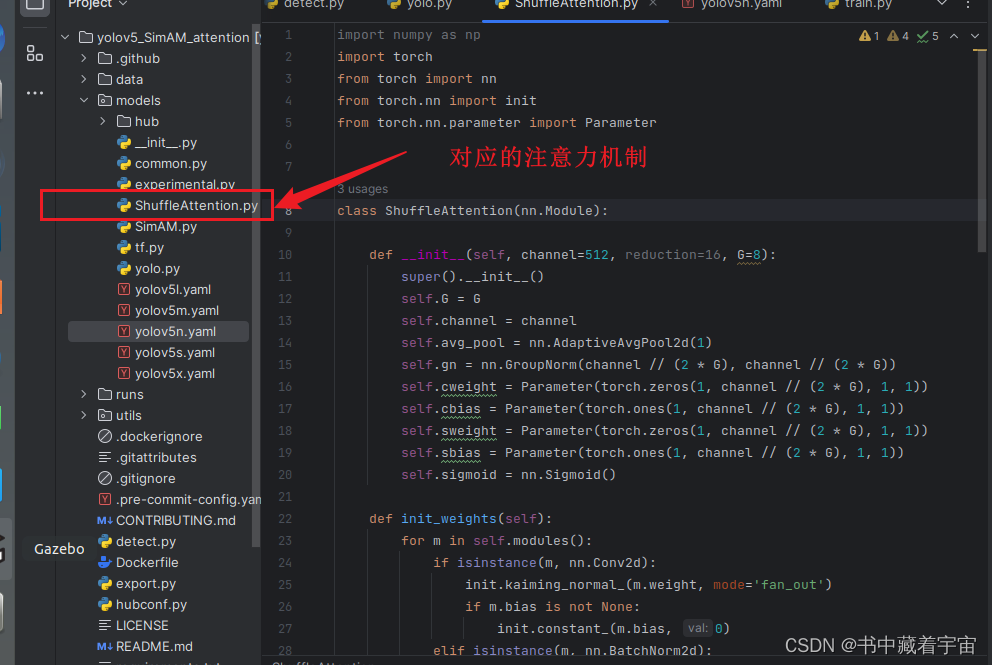

✨ 第一步:在models的文件夹下新建一个.py文件,格式为我们(注意力机制名字.py),如下图所示

✨ 第二步:添加官方提供的注意力机制代码,这里我提供给大家

ShuffleAttention.py

# author@mawei szu

import numpy as np

import torch

from torch import nn

from<