原始文章地址

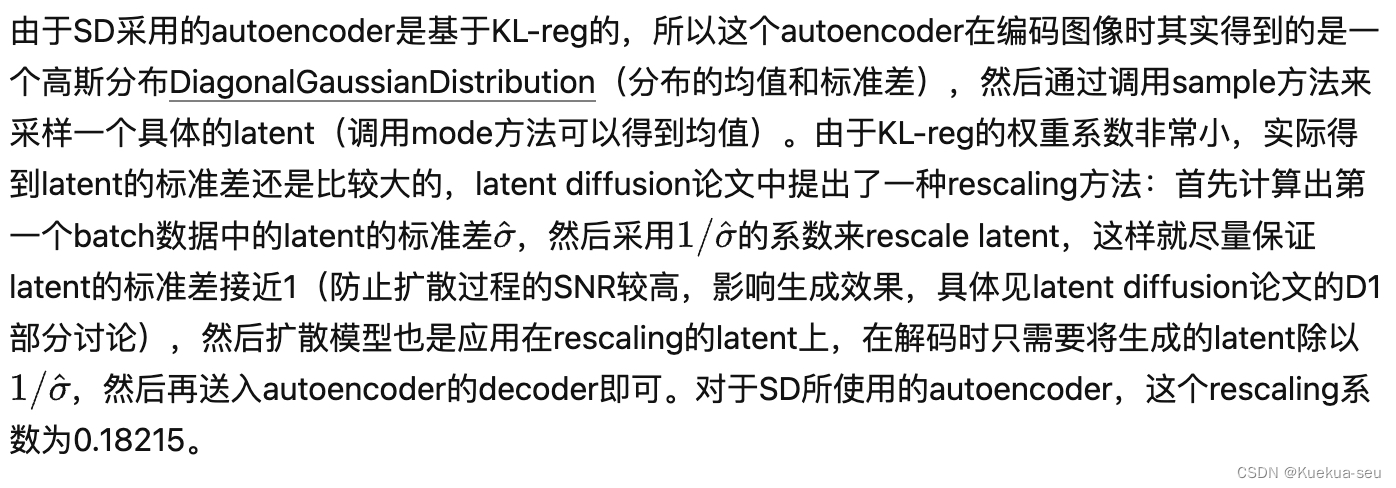

autoencoder

CLIP text encoder

tokenizer最大长度为77(CLIP训练时所采用的设置),当输入text的tokens数量超过77后,将进行截断,如果不足则进行paddings,这样将保证无论输入任何长度的文本(甚至是空文本)都得到77x768大小的特征

问题:当输出超长prompt会分段处理?每段的权重如何处理?

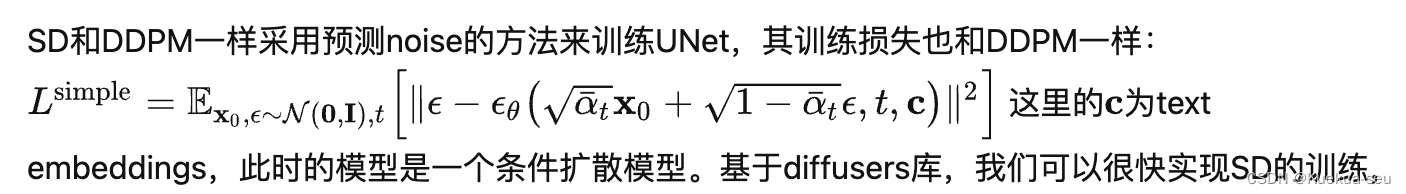

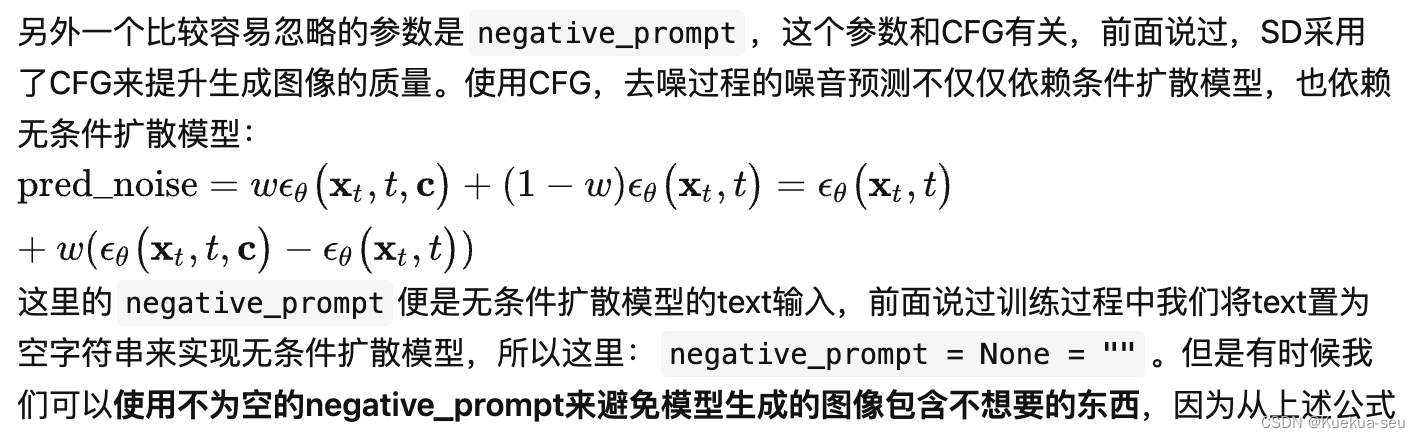

UNet

text condition将通过CrossAttention模块嵌入进来,此时Attention的query是UNet的中间特征,而key和value则是text embeddings。

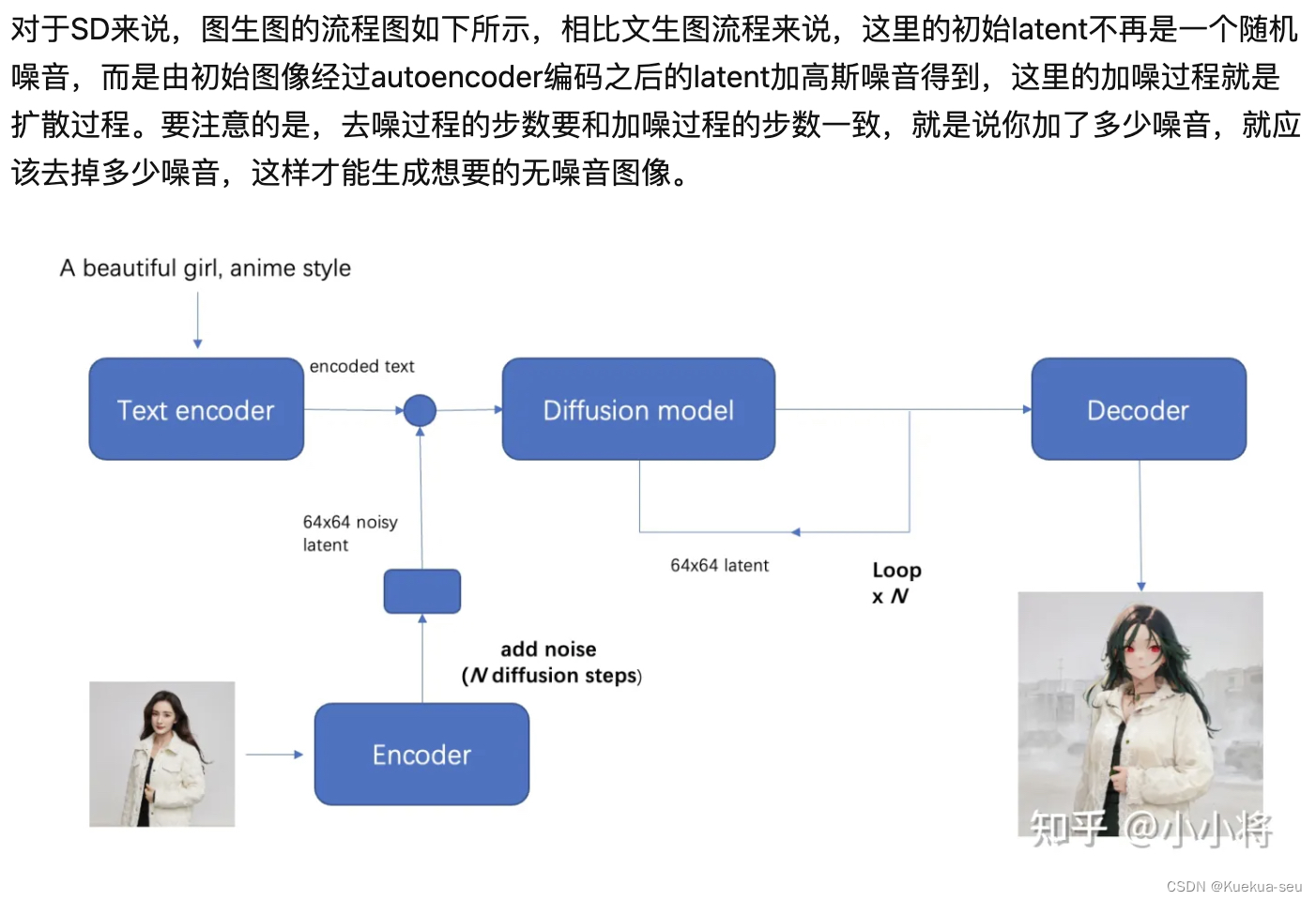

SD图生图

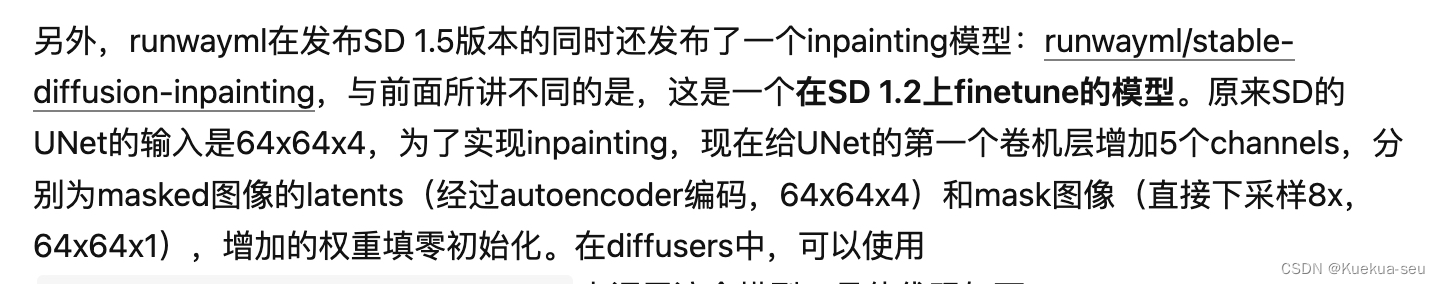

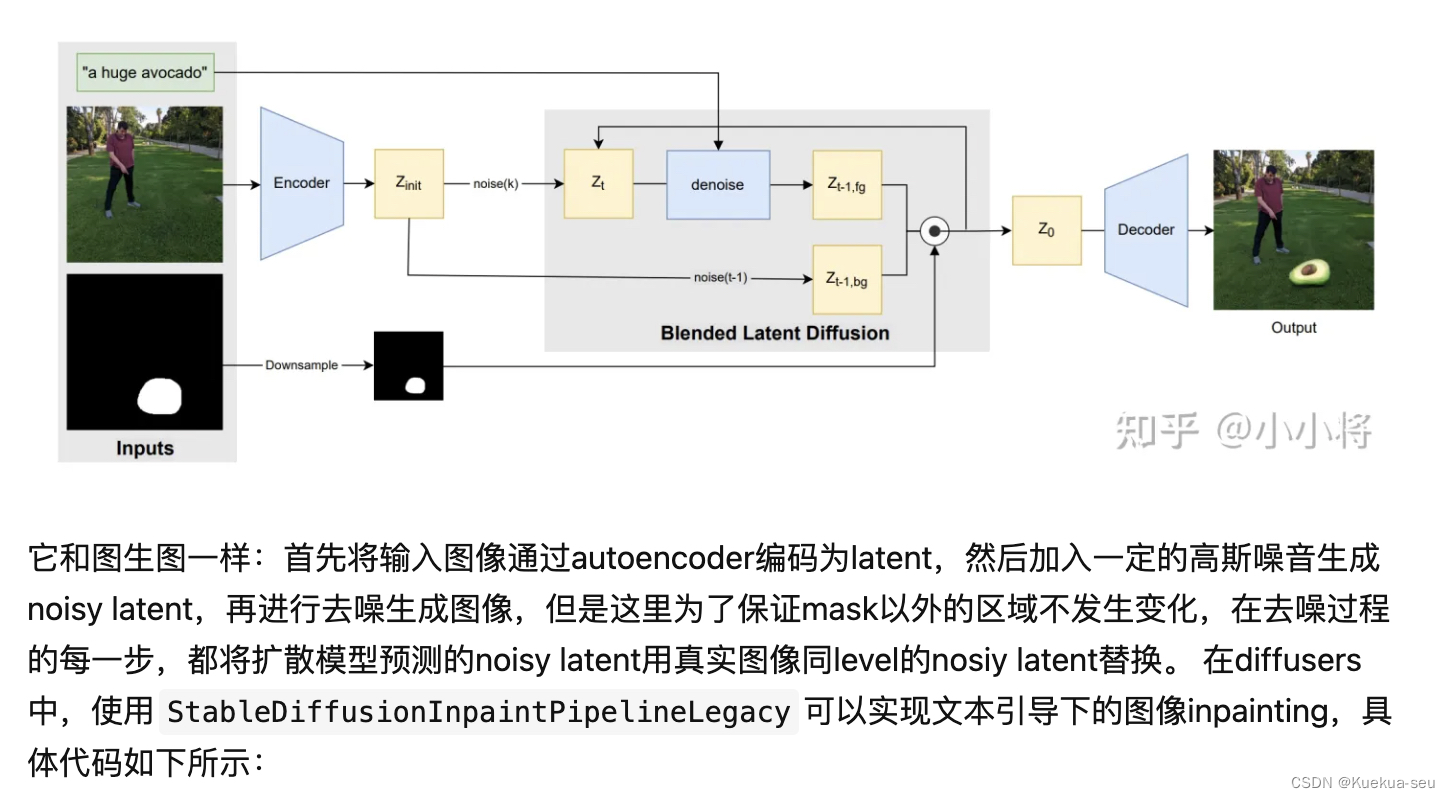

SD Inpainting

第一种形式:

第二种形式: