SimAM注意力机制简介

关于SIMAM注意力机制的原理这里不再详细解释,这篇发在Proceeddings of the 38th Internation Conference on Machine Learning.论文参考如下论文链接here

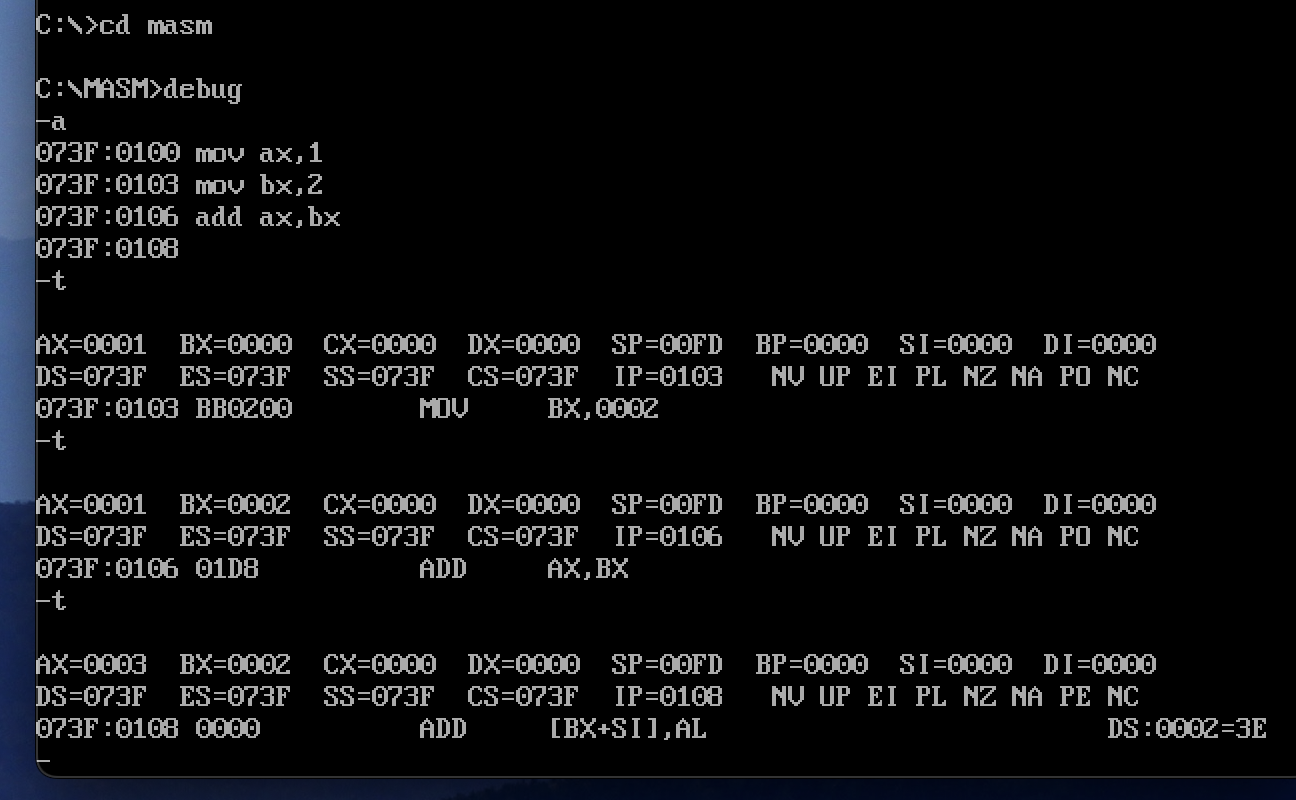

yolov5中添加SimAM注意力机制

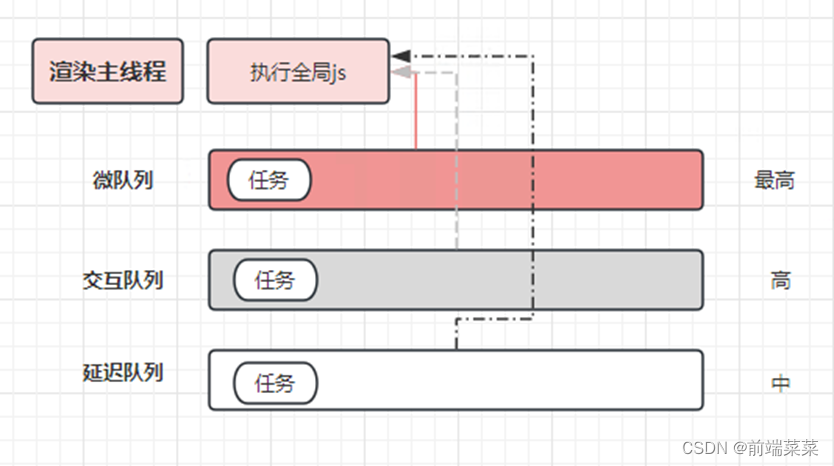

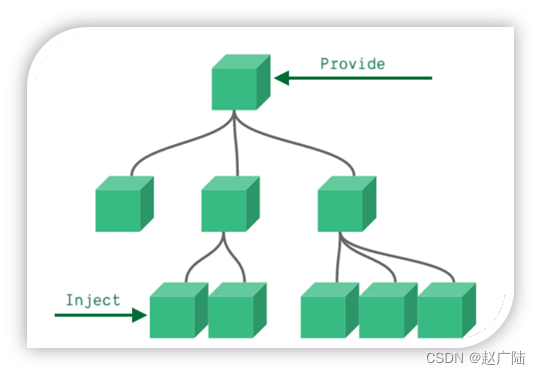

注意力机制分为接收通道数和不接受通道数两种。这次属于不接受通道数注意力机制,这种注意力机制由于没有任何的通道数要求,所以我们可以随便添加到那一层就可以,不用考虑上一层的通道数情况。

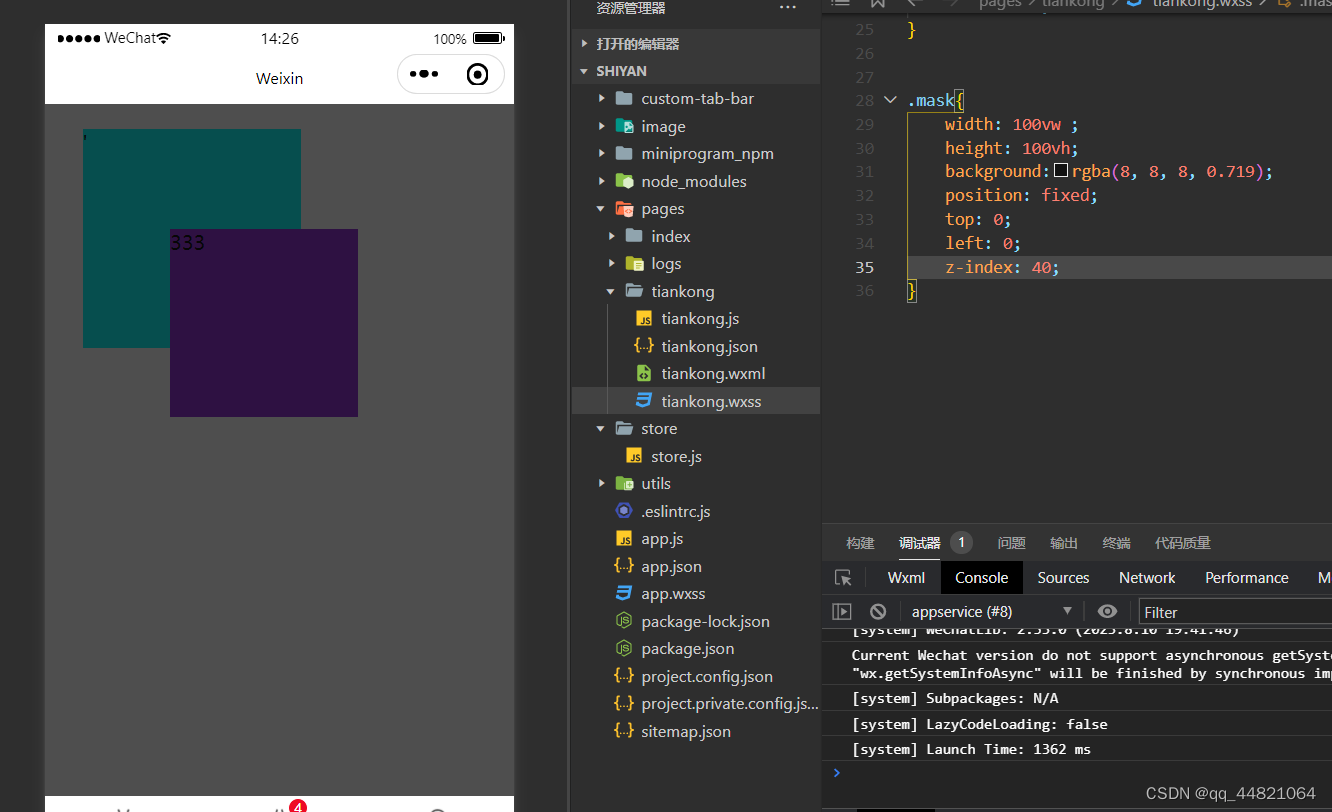

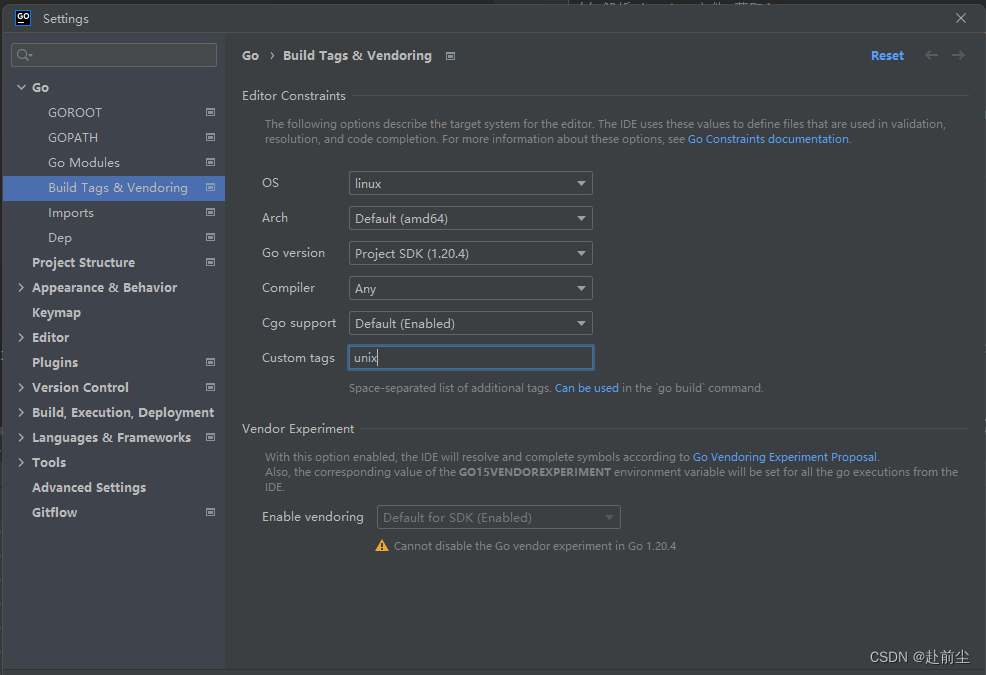

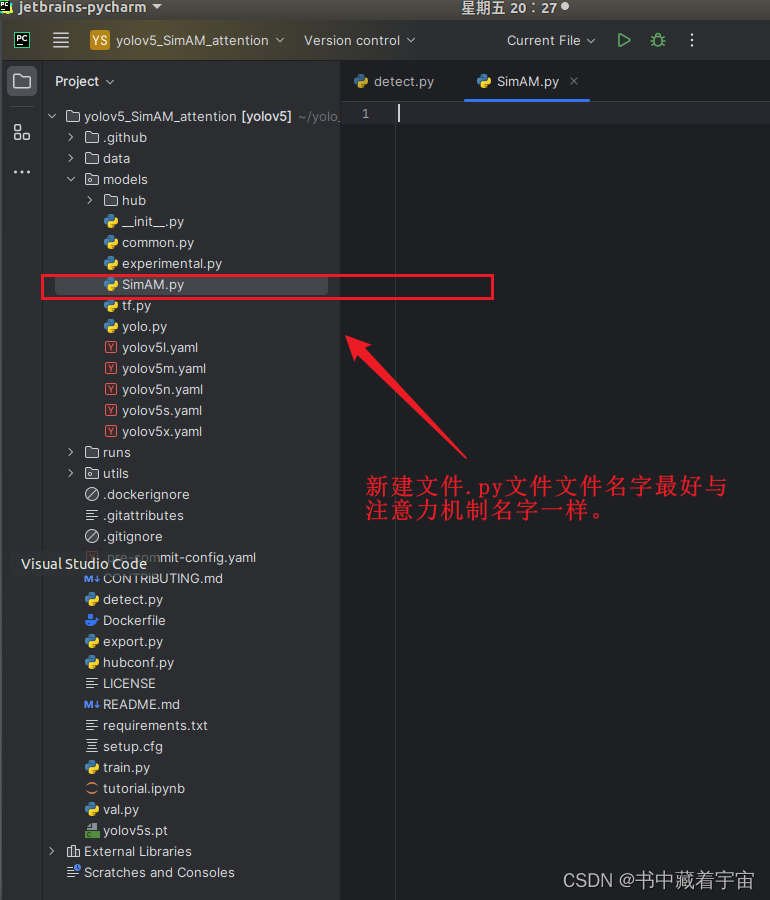

✨ 第一步:在models的文件夹下新建一个.py文件,格式为我们(注意力机制名字.py),如下图所示

✨ 第二步:添加官方提供的注意力机制代码,这里我提供给大家

SimAM.py

import torch

import torch.nn as nn

# autho